Flume与Spark集成:实时数据分析与处理的实战攻略

发布时间: 2024-10-26 00:22:15 阅读量: 40 订阅数: 27

Spark大数据分析与实战.zip

# 1. Flume与Spark集成概述

在当今大数据时代,如何高效地处理和分析实时数据流成为了一个挑战。Flume与Spark的集成提供了一种强大的解决方案,通过结合两者的优点,企业可以实现从数据收集到实时计算的无缝处理。Flume,作为一款分布式、可靠且可用的系统,专门用于高效地收集、聚合和移动大量日志数据。而Apache Spark,则是一个快速的分布式计算系统,它通过提供强大的数据处理能力,成为了处理大数据的首选工具。本章将概述Flume与Spark集成的基本概念、优势以及应用场景,为后续章节的深入讨论打下基础。

# 2. Flume基础与实时数据流处理

## 2.1 Flume的工作原理与架构

### 2.1.1 Flume的组件模型

Apache Flume是一个分布式、可靠且可用的系统,用于有效地收集、聚合和移动大量日志数据。它由三个核心组件构成:Source、Channel和Sink。这些组件的交互形成了一个数据流的管道,允许数据从源头流向目的地。

- **Source**:它是数据的输入点。Source负责从外部系统收集数据,并将其放入一个或多个Channel中。多种Source类型可供选择,比如Avro Source、Thrift Source等,每种类型的Source都有特定的配置参数以适应不同的数据收集需求。

- **Channel**:Channel是Source和Sink之间的短暂存储。Channel提供事务支持,确保数据的可靠传输。它类似于数据库中的事务日志,数据在被最终传递给Sink之前,会暂存在Channel中。Channel的类型包括Memory Channel、JDBC Channel等,它们对于性能和持久性有不同的影响。

- **Sink**:Sink接收Channel中的数据,并将其发送到下一个目的地。这个目的地可以是另一个Flume Agent,也可以是HDFS、logger、Avro等。Sink组件需要确保数据能够被正确地路由和存储。

### 2.1.2 事件的流动机制

Flume中的数据单元称为事件(Event),它可以包含任意二进制数据,如日志文件的一行。一个事件包含数据以及可选的头部信息,头部信息可以用于路由决策。Flume的数据流动机制遵循“逐跳”原则,即数据流经Source,暂存于Channel,然后由Sink逐个传输。

- 每个事件在Source处生成,然后被传送到Channel。

- Source和Channel之间的交互是非阻塞的,并且使用事务保证数据传输的可靠性。只有当事件成功地放入Channel后,事务才会提交。

- Sink从Channel中取出事件,并将它们发送到下一个目的地。如果发送过程中发生故障,Sink会将事件重新放入Channel中,等待后续传输。

- 事件在Channel中的存储可以是持久化的也可以是非持久化的,持久化存储可以防止数据丢失,但会增加读写延迟。

## 2.2 Flume的配置与数据收集

### 2.2.1 Agent的配置和维护

一个Flume Agent是一个独立的数据流处理和转发单元。每个Agent包含一个或多个Source、Channel和Sink组件。配置一个Agent涉及确定组件的类型、数量、配置参数和它们之间的连接方式。

- Agent的基本配置需要在配置文件中定义,通常该文件名为`flume-conf.properties`。

- 配置文件中指定组件及其属性,如Source的类型、Channel的类型和容量、Sink的目标地址等。

- 维护Agent包括监控其健康状态、调整参数以优化性能、升级和重启。

### 2.2.2 数据源的集成与管道定制

为了处理不同类型的数据源和目标系统,Flume提供了灵活的配置选项。数据源可以包括文件系统、网络服务、数据库等。

- 集成新的数据源通常需要编写或配置一个合适的Source。

- Flume支持自定义Source,可以通过Java编写来满足特定需求。

- 管道定制是指根据数据流的需求来配置Source、Channel和Sink。例如,一个使用文件作为数据源的管道可能包括一个exec Source(执行命令以读取文件),一个Memory Channel以及一个HDFS Sink(用于将数据写入Hadoop的分布式文件系统)。

## 2.3 Flume与流处理框架的集成

### 2.3.1 Flume与Kafka的集成案例

Apache Kafka是一个高吞吐量的分布式消息系统,适用于构建实时数据管道和流应用。将Flume与Kafka集成,可以利用Kafka强大的发布-订阅消息模式来扩展数据流的处理能力。

- 首先需要配置Flume的Kafka Source,指定要连接的Kafka Broker地址和消费的主题。

- 配置Flume的Channel,通常选择高可靠性的Channel,如File Channel或JDBC Channel。

- 最后配置一个Kafka Sink,把数据从Channel中取出并放入指定的Kafka Topic中。

集成的实现涉及配置文件中的相关组件配置以及启动和测试管道流程。

### 2.3.2 Flume在多数据源场景下的应用

在多个数据源的情况下,Flume可以同时消费来自不同源头的数据,并将这些数据统一处理后传送到下游系统。

- 配置多个Source,每个Source连接一个数据源。例如,可以使用exec Source从文件系统读取数据,同时使用Spooling Directory Source从目录监控新文件。

- 所有数据通过统一的Channel,这样可以保证不同来源的数据在同一个地方进行管理和路由。

- 配置一个或多个Sink将数据流导向同一或不同的目的地,例如将数据写入HDFS、发送到消息队列或推送到搜索引擎。

Flume的这种灵活架构允许开发者构建复杂的数据流处理系统,以应对大规模、多来源数据的实时处理需求。

在下一章节中,我们将深入探讨Spark的基础知识和实时计算能力。

# 3. ```

# 第三章:Spark基础与实时计算

## 3.1 Spark的生态系统概览

### 3.1.1 Spark的核心概念

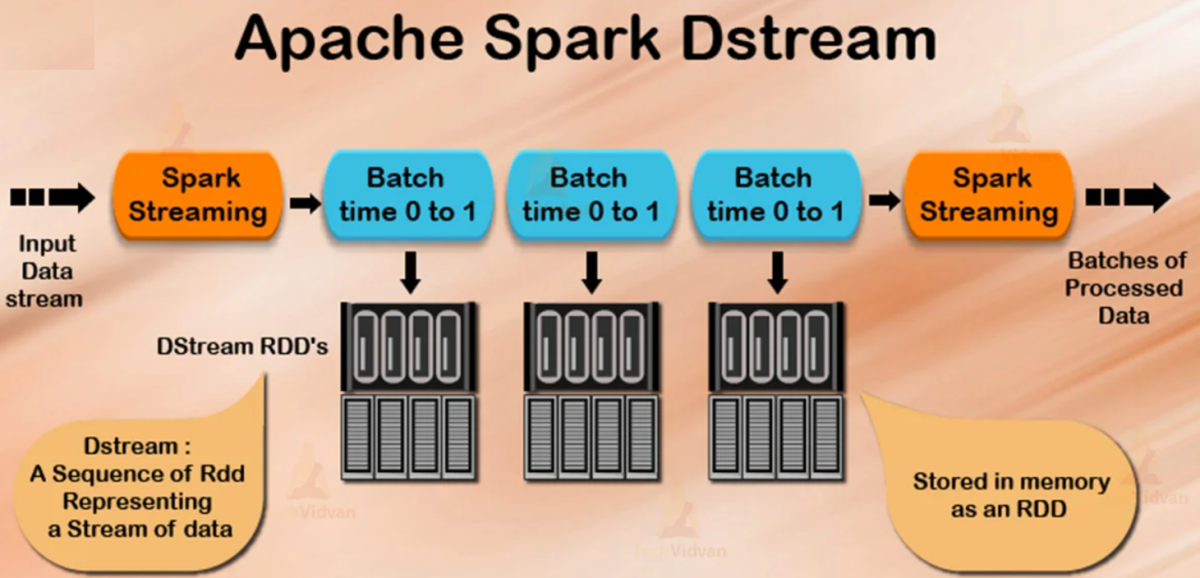

Apache Spark是一个用于大规模数据处理的快速、通用、可扩展的分布式计算系统。其核心概念包括弹性分布式数据集(RDD)、窄依赖和宽依赖等。RDD是分布式内存中的一个不可变对象集合,它们被分区,并

```

0

0