企业级Flume数据流管道搭建:案例分析与高效构建指南

发布时间: 2024-10-25 23:22:39 阅读量: 39 订阅数: 27

网站流量日志数据分析系统的构建及可视化:Hadoop环境搭建、Flume数据采集、MapReduce预处理及FineBI可视化

# 1. 企业级Flume数据流管道概述

随着数据量的急剧增长,企业对于高效数据收集与传输工具的需求日益迫切。Flume作为一款分布式、可靠且可用的系统,专门用于有效地收集、聚合和移动大量日志数据,已经成为了业界构建数据流管道的首选。它凭借其高度可定制的架构,允许开发者根据特定需求构建出复杂的数据流模型,同时保证了数据在传输过程中的高可用性和可靠性。本章将对Flume的诞生背景、核心功能以及它在企业级数据处理中的重要性进行概述。

# 2. Flume基础架构与组件解析

## 2.1 Flume核心组件介绍

### 2.1.1 Source的类型和配置

Flume的Source组件是数据管道的起点,负责从外部源收集数据。它的灵活性在于支持多种类型的数据源,包括但不限于日志文件、网络套接字或自定义数据源。Source类型的选择依赖于数据源的特性,例如,对于日志文件,可以使用Exec Source来运行外部命令收集日志,或者使用Spooling Directory Source监控新文件的添加。

下面是一个配置文件中的Spooling Directory Source的示例:

```properties

agent.sources = logSource

agent.sources.logSource.type = spooldir

agent.sources.logSource.spoolDir = /var/log/spoolDir

agent.sources.logSource.basename = log

```

在这个示例中,`type` 指定了Source的类型为`spooldir`,表示监控一个目录(`/var/log/spoolDir`)中的新文件。`basename` 指定了添加到文件名前的前缀,用于过滤掉非目标日志文件。Spooling Directory Source的工作原理是监听指定目录的文件变动,当新文件出现时,它会开始读取文件中的数据并将其传递给Channel。

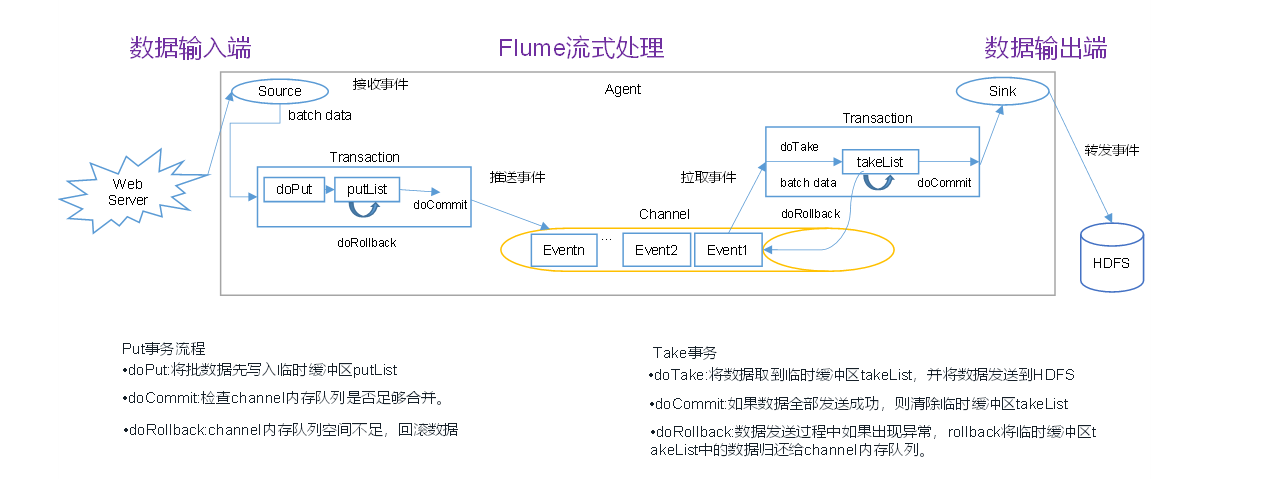

### 2.1.2 Channel的作用与机制

Channel作为Source和Sink之间的队列,是Flume可靠性的关键组件。它的作用是在Source和Sink之间可靠地传输事件,并保证即使在系统崩溃的情况下,数据也不会丢失。Flume提供了多种类型的Channel,包括Memory Channel和File Channel。Memory Channel提供高吞吐量,但是可靠性较低;相反,File Channel牺牲了吞吐量以保证数据不会在任何情况下丢失。

接下来,我们来看看File Channel的配置示例:

```properties

agent.channels = fileChannel

agent.channels.fileChannel.type = file

agent.channels.fileChannel.checkpointDir = /var/flume/checkpoint

agent.channels.fileChannel.dataDirs = /var/flume/data

```

在这个配置中,`type` 设置为`file` 表示使用File Channel。`checkpointDir` 指定检查点文件的存储目录,而`dataDirs` 指定事件数据存储的目录。File Channel使用检查点和事务日志来确保数据的一致性和可靠性。

### 2.1.3 Sink的选择与优化

Sink组件负责将事件从Channel中发送到目的地,可以是HDFS、数据库或其他数据接收器。选择合适的Sink对于性能和可靠性都至关重要。例如,当需要高可靠性和顺序保证时,可以使用HDFS Sink;如果目标是速度和高效传输,Kafka Sink会是一个更好的选择。

下面是一个配置HDFS Sink的例子:

```properties

agent.sinks = hdfsSink

agent.sinks.hdfsSink.type = hdfs

agent.sinks.hdfsSink.hdfs.path = hdfs://namenode/path

agent.sinks.hdfsSink.hdfs.fileType = DataStream

```

这个例子中配置了一个HDFS Sink,它将数据写入HDFS路径`hdfs://namenode/path`。`hdfs.fileType` 设置为`DataStream` 表示写入的是实时数据流,适合日志文件。

Sink的选择和优化可以根据目标数据存储的特性和业务需求进行调整,例如,可以通过批量写入和压缩来提升性能。

## 2.2 Flume配置详解

### 2.2.1 配置文件的结构和语法

Flume的配置文件通常使用.properties文件格式,分为三个主要部分:Agent、Sources、Channels和Sinks。每个部分都以唯一的标识符命名,并通过点来分隔。

```properties

agent.sources = r1

agent.channels = c1

agent.sinks = k1

# Define source, sink, channel

agent.sources.r1.type = netcat

agent.channels.c1.type = file

agent.sinks.k1.type = logger

# Link the source, sink, channel together

agent.sources.r1.channels = c1

agent.sinks.k1.channel = c1

```

在这个例子中,定义了一个名为`agent`的Flume代理,它包含一个名为`r1`的Source,一个名为`c1`的Channel和一个名为`k1`的Sink。Source通过`channels`属性与Channel连接,Sink通过`channel`属性与Channel连接。这是构建Flume数据管道的基本语法。

### 2.2.2 高级配置选项和最佳实践

高级配置选项包括事务批处理大小、事务超时、Channel容量以及事件失败重试机制等。合理地调整这些参数可以帮助改善Flume的性能和稳定性。

例如,可以设置事务批处理大小来控制Channel每次与Sink交互时传输的事件数量:

```properties

agent.sinks.k1.batchSize = 500

```

在最佳实践中,通常建议将Flume部署在与数据源不同的机器上,以避免资源竞争。同时,应保证足够的内存和磁盘空间以应对数据高峰。

### 2.2.3 环境变量和动态配置技巧

Flume支持使用环境变量来动态配置属性值,这在多环境部署时非常有用。例如:

```properties

agent.channels = ${FLUME_CHANNEL_NAME}

```

在上面的配置中,`${FLUME_CHANNEL_NAME}` 会被环境变量`FLUME_CHANNEL_NAME`的值所替换。

动态配置技巧包括运行时重新加载配置文件,无需重启服务即可应用配置变更。可以使用命令行工具`flume-ng admin`来动态加载配置:

```bash

flume-ng admin --conf /path/to/conf --conf-file /path/to/flume-conf.properties --reload-agents

```

## 2.3 Flume拓扑设计原则

### 2.3.1 单点故障与负载均衡

在设计Flume拓扑时,避免单点故障至关重要。可以通过配置多个Sink来实现负载均衡和故障转移。Flume 1.8版本后支持Sink Group来实现Sink级别的故障转移和负载均衡。

```properties

agent.sinkgroups = sg1

agent.sinkgroups.sg1.sinks = k1 k2

agent.sinkgroups.sg1.capacity = 2

agent.sinkgroups.sg1.maxpenalty = 10000

```

在这里,`sinkgroups` 定义了一个名为`sg1`的Sink组,它包含两个Sink(`k1`和`k2`)。`capacity` 表示组中可以使用的Sink数量,而`maxpenalty`定义了一个Sink在被认为是不可用前,可以承受的最大惩罚值。

### 2.3.2 数据安全与完整性保证

数据的安全性和完整性可以通过配置事务来保证。确保Source和Sink使用相同的事务ID,当数据从Source成功传输到Sink时,事务ID会被正确地应用。Flume还提供了一种机制,可以保证即使在多个Sink配置的情况下,每个事件也只会被处理一次。

### 2.3.3 性能考虑与瓶颈分析

在设计Flume拓扑时,考虑性能瓶颈同样重要。性能瓶颈通常发生在Sink,因为数据在此被最终处理或转发。可以使用批处理和压缩来提高效率。同时,使用内存Channel可以提高吞吐量,但要考虑内存容量的限制。

在实际部署中,监控和日志记录至关重要,它们可以帮助识别瓶颈所在。一些关键的性能指标包括事务处理时间、事件排队时间和错误率。通过这些指标,可以对系统进行调整和优化。

至此,第二章的主要内容已经介绍完毕。通过以上章节的深入解析,我们了解了Flume的核心组件以及如何配置和优化Flume以应对不同的数据流管道需求。在下一章中,我们将深入探讨Flume与其他系统集成的方式以及如何构建高效的数据管道。

# 3. Flume集成与数据管道构建

在这一章,我们将深入探讨如何将Flume集成到不同的系统中,并构建高效的数据管道。数据流处理是大数据应用的核心,而Flume作为一个稳定、可靠的流数据处理工具,其与其他系统的集成能力是构建复杂数据处理管道不可或缺的部分。

## 3.1 Flume与其他系统的集成

Flume通过其丰富的插件和灵活的配置,可以与多种系统进行集成。这一小节将详细介绍Flume如何与Hadoop生态、消息队列以及第三方系统进行集成。

### 3.1.1 与Hadoop生态的集成

Flume与Hadoop生态的集成是许多大数据处理场景中的常见需求。由于Flume可以将数据高效地传输到HDFS(Hadoop Distributed File System)中,这为后续的批处理分析或实时处理提供了数据源。

#### *.*.*.* HDFS的集成

Flume与HDFS集成的关键在于Sink组件。常见的配置方法是使用HDFS Sink来直接向HDFS写入数据流。一个典型的配置可能包含如下元素:

```properties

# hdfs-sink.properties

agent1.sinks = k1

agent1.sinks.k1.type = hdfs

agent1.sinks.k1.hdfs.path = /flume-data/

agent1.sinks.k1.hdfs.fileType

```

0

0