【Python统计项目构建】:Stat库实战应用,从零开始

发布时间: 2024-10-10 20:00:51 阅读量: 167 订阅数: 60

# 1. Python统计项目入门

## 1.1 为什么要学习Python统计项目

Python作为一种动态编程语言,在数据分析和统计项目中的应用日益广泛。其简洁的语法、强大的库支持以及活跃的社区,使得Python在数据科学领域中成为首选。无论是处理大规模数据集,还是执行复杂的数据分析任务,Python都能够提供高效且易于理解的解决方案。因此,对于希望在数据驱动决策中发挥更大作用的专业人士来说,学习Python统计项目无疑是一个明智的选择。

## 1.2 Python在统计项目中的应用

Python在统计项目中的应用主要体现在数据处理、统计建模、数据可视化以及预测分析等方面。借助诸如NumPy、Pandas和Matplotlib等核心库,Python能够轻松实现数据的导入、清洗、处理、探索性分析和可视化。另外,Scipy、Statsmodels和Scikit-learn库为统计分析和机器学习提供了丰富的工具。这些工具使得数据科学家和统计学家能够更加专注于数据洞察的发现,而非繁琐的编程细节。

## 1.3 如何开始Python统计项目

开始Python统计项目的第一步是熟悉Python的基础语法,之后可以逐步学习Pandas库来处理数据,Matplotlib或Seaborn进行数据可视化,以及Scipy或Statsmodels进行统计建模。一个实用的起点是通过实际的数据集来练习,例如使用Pandas加载CSV文件,运用NumPy进行数组运算,使用Matplotlib绘制图表,并利用Statsmodels进行简单的统计测试。随着技能的提升,可以进一步深入学习更高级的统计分析和机器学习技术。

# 2. Stat库基础与数据处理

在当今的数据分析领域,Python凭借其简洁的语法、强大的库支持,以及丰富的数据处理能力,成为了分析者的宠儿。Stat库,作为Python统计分析的重要工具,其强大的功能覆盖了从基本数据处理到复杂统计分析的方方面面。在这一章节中,我们将深入探讨Stat库的基础知识和数据处理方法,为后面章节的学习打下坚实的基础。

## 2.1 Stat库概述和安装

### 2.1.1 Stat库的特性与应用范围

Stat库是专门为数据科学和统计分析而设计的Python库,它提供了大量的工具用于数据分析和统计计算。Stat库的特性不仅包括强大的数据处理和分析能力,还提供了丰富的统计测试和图形绘制功能。它的应用范围涵盖了金融分析、生物信息学、社会科学、工程技术等多个领域。

### 2.1.2 如何安装和配置Stat库

安装Stat库通常很简单,推荐使用pip包管理器进行安装,其命令如下:

```sh

pip install stat

```

在安装过程中可能会遇到一些依赖问题,例如在使用某些统计功能时需要SciPy库的支持,因此建议同时安装SciPy:

```sh

pip install scipy

```

安装完成后,我们可以导入Stat库并进行简单的测试,以验证是否安装成功:

```python

import stat

# 打印Stat库的版本信息作为测试

print(stat.__version__)

```

执行上述代码块,如果能够正确输出版本信息,说明Stat库已成功安装并可以使用。

## 2.2 Stat库的数据结构

### 2.2.1 数据集的创建和加载

在Stat库中,数据集通常被存储为`DataFrame`对象,这是一种二维的标签化数据结构,能够容纳不同类型的数据。我们可以使用以下代码创建一个简单的数据集:

```python

import stat

# 创建一个空的DataFrame

df = stat.DataFrame()

# 向DataFrame中添加数据

df['name'] = ['Alice', 'Bob', 'Charlie']

df['age'] = [25, 30, 35]

print(df)

```

上述代码块创建了一个包含两列(姓名和年龄)的简单数据集。加载外部数据集时,可以使用`read_csv`、`read_excel`等函数将CSV、Excel等格式的文件导入到`DataFrame`中。

### 2.2.2 数据清洗与预处理

数据清洗和预处理是数据分析流程中极为重要的一步。Stat库提供了一系列方法来处理缺失值、重复数据、异常值等问题。

```python

# 处理缺失值

df.fillna(value=0, inplace=True)

# 删除重复数据

df.drop_duplicates(inplace=True)

# 检测并处理异常值,例如年龄超过100岁则视为异常

df = df[df['age'] < 100]

```

数据清洗的过程往往需要结合数据的具体情况来选择合适的处理方法,Stat库为我们提供了灵活的工具以应对各种数据清洗的需求。

## 2.3 Stat库的描述性统计

### 2.3.1 基本统计量的计算

描述性统计是对数据集进行基础分析的关键步骤。通过基本统计量的计算,我们可以快速了解数据集的中心趋势和分散程度。例如,计算平均值、中位数、标准差等:

```python

# 计算年龄的均值、中位数和标准差

mean_age = df['age'].mean()

median_age = df['age'].median()

std_age = df['age'].std()

print("Mean age:", mean_age)

print("Median age:", median_age)

print("Standard deviation of age:", std_age)

```

### 2.3.2 数据分布的探索性分析

探索性数据分析(EDA)是一个重要的分析过程,它可以帮助我们理解数据集的分布特征。Stat库中提供了直方图、箱形图等图形工具来可视化数据分布:

```python

# 绘制年龄的直方图

import matplotlib.pyplot as plt

plt.hist(df['age'], bins=10)

plt.xlabel('Age')

plt.ylabel('Frequency')

plt.title('Age Distribution')

plt.show()

# 绘制年龄的箱形图

plt.boxplot(df['age'], vert=False)

plt.xlabel('Age')

plt.title('Age Boxplot')

plt.show()

```

通过这些图表,我们可以直观地观察数据的分布情况,进一步为后续分析提供依据。

在接下来的章节中,我们将深入学习概率统计功能,掌握使用Stat库进行更高级的统计分析方法。通过本章节的介绍,相信您对Stat库的基础知识和数据处理能力有了初步的认识和实践。随着学习的深入,您将能够运用Stat库解决更复杂的数据分析问题。

# 3. Stat库中的概率统计功能

## 3.1 概率分布与统计模型

### 3.1.1 常见概率分布的实现

在数据分析与统计中,理解并应用不同的概率分布是构建统计模型的基础。Stat库提供了丰富的函数和方法来实现和分析各种概率分布,包括但不限于二项分布、泊松分布、正态分布等。

例如,二项分布广泛应用于固定次数的独立实验中,每次实验只有两种可能的结果(成功或失败)。以下是使用Stat库生成和分析二项分布的一个示例:

```python

import stat

# 二项分布参数:试验次数n=10,成功概率p=0.5

n, p = 10, 0.5

binom_dist = stat.binomial(n, p)

# 计算概率质量函数(PMF)值

pmf_values = [binom_dist.pmf(k) for k in range(n+1)]

# 计算累积分布函数(CDF)值

cdf_values = [binom_dist.cdf(k) for k in range(n+1)]

# 绘制PMF和CDF图

import matplotlib.pyplot as plt

plt.figure(figsize=(12, 5))

plt.subplot(1, 2, 1)

plt.bar(range(n+1), pmf_values)

plt.title("Probability Mass Function")

plt.xlabel("Number of Successes")

plt.ylabel("Probability")

plt.subplot(1, 2, 2)

plt.plot(range(n+1), cdf_values, marker='o')

plt.title("Cumulative Distribution Function")

plt.xlabel("Number of Successes")

plt.ylabel("Cumulative Probability")

plt.tight_layout()

plt.show()

```

在上述代码中,我们首先导入了stat库,然后创建了一个二项分布实例。接着,我们计算了概率质量函数和累积分布函数的值,并使用Matplotlib绘制了相关的图表。这样的可视化有助于我们更直观地理解分布特性。

### 3.1.2 参数估计和假设检验

参数估计是统计推断中的一个核心概念,它涉及根据样本来估计总体参数。常见的参数估计方法包括点估计和区间估计。假设检验则用于检验关于总体参数的假设是否合理。

以正态分布为例,我们通常需要估计均值(mean)和标准差(std)。Stat库提供了方法来计算样本均值和标准差,同时也可以进行假设检验,如t检验。

```python

import numpy as np

from stat import ttest_ind

# 假设我们有两个独立样本数据集

sample1 = np.random.normal(50, 5, 100)

sample2 = np.random.normal(52, 5, 100)

# 进行独立样本t检验

t_stat, p_value = ttest_ind(sample1, sample2)

print(f"t-statistic: {t_stat}")

print(f"p-value: {p_value}")

```

在上述代码中,我们使用了`numpy`库来生成两个正态分布的样本集,然后利用`stat`库中的`ttest_ind`方法进行了独立样本t检验。t检验的结果可以帮助我们判断两个样本集是否有显著差异。

## 3.2 统计推断与区间估计

### 3.2.1 置信区间的计算

统计推断是基于样本数据来推断总体参数的过程。置信区间是统计推断中一个重要概念,它是样本统计量所确定的总体参数的一个区间,这个区间有一定概率包含总体参数的真实值。

在Stat库中,我们可以轻松计算出各种统计量的置信区间。以均值的置信区间为例:

```python

from stat import t, sem

# 假设我们有一个样本数据集

sample_data = np.random.normal(0, 1, 100)

# 计算样本均值的95%置信区间

n = len(sample_data)

mean = np.mean(sample_data)

sem_value = sem(sample_data)

degrees_of_freedom = n - 1

confidence_level = 0.95

t_value = t.ppf((1 + confidence_level) / 2, degrees_of_freedom)

margin_of_error = t_value * sem_value

confidence_interval = (mean - margin_of_error, mean + margin_of_error)

print(f"Mean: {mean}")

print(f"Confidence Interval: {confidence_interval}")

```

在这段代码中,我们首先生成了一个正态分布的样本集,然后计算了该样本均值的95%置信区间。我们使用了学生t分布的百分位数点函数`ppf`,并基于样本标准误差`sem`和自由度来计算边际误差。

### 3.2.2 样本量的确定和功效分析

在设计实验或调研时,确定合适的样本量是至关重要的。样本量过小,可能无法准确反映总体特征;样本量过大,则可能造成不必要的资源浪费。Stat库能够帮助我们进行功效分析和计算所需的最小样本量。

功效分析通常与假设检验相关联,它涉及到统计功效,即在统计检验中正确拒绝一个错误的零假设的概率。统计功效越高,犯第二类错误的概率就越低。

```python

from stat import ttest_ind_power

# 假设我们计划进行一个独立样本t检验

effect_size = 0.5 # 效应量

alpha = 0.05 # 显著性水平

power = 0.8 # 统计功效

# 计算所需样本量

sample_size = ttest_ind_power.solve_power(effect_size, alpha, power)

print(f"Required sample size: {sample_size}")

```

在上述代码中,我们使用了`stat`库中的`ttest_ind_power`函数来计算独立样本t检验所需的最小样本量。这使我们能够根据预期效应量、显著性水平和统计功效来设计实验。

## 3.3 多变量统计分析

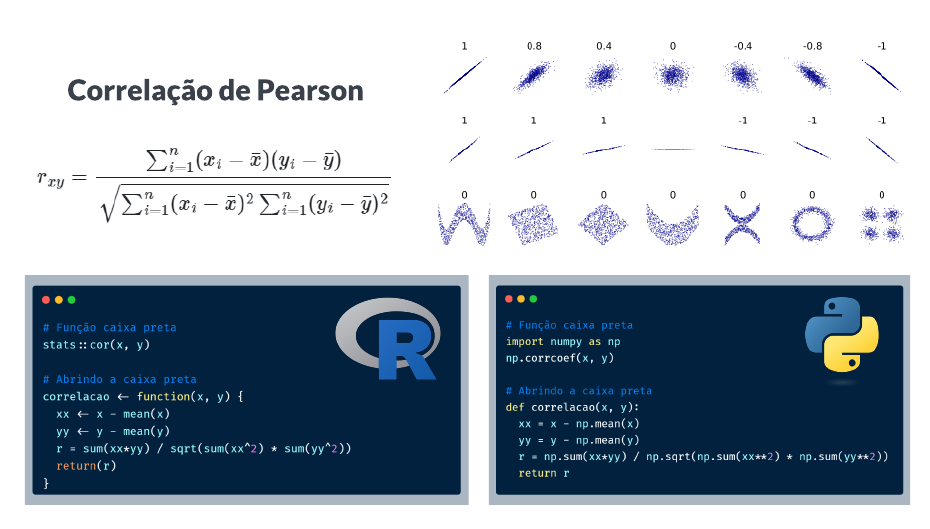

### 3.3.1 相关性分析和回归模型

在进行数据分析时,研究变量之间的关系是理解数据的重要方面。相关性分析可以用来评估两个连续变量之间的线性关系。简单线性回归模型则是用来建模两个变量之间的关系,其中一个是因变量,另一个是自变量。

Stat库中的相关性分析和回归模型功能非常强大,让我们通过代码展示如何进行操作:

```python

import numpy as np

from stat import pearsonr, linregress

# 生成数据集

np.random.seed(0)

x = np.random.normal(0, 1, 100)

y = 2*x + np.random.normal(0, 0.5, 100)

# 计算Pearson相关系数

correlation, _ = pearsonr(x, y)

# 简单线性回归

slope, intercept, r_value, p_value, std_err = linregress(x, y)

print(f"Pearson correlation coefficient: {correlation}")

print(f"Linear regression results - Slope: {slope}, Intercept: {intercept}")

```

在这段代码中,我们首先生成了一组模拟数据,并计算了Pearson相关系数。然后,我们使用`linregress`方法进行了简单线性回归,并输出了回归方程的斜率和截距,以及回归系数。

### 3.3.2 主成分分析和因子分析

在处理高维数据时,我们可能希望减少数据的维度,同时尽可能保留原始数据的特征和结构。主成分分析(PCA)和因子分析是两种常用的降维技术。

Stat库提供了进行PCA和因子分析的工具,下面是相关分析的一个例子:

```python

from stat import PCA

# 生成一些高维数据

data = np.random.rand(100, 10)

# 主成分分析

pca = PCA(n_components=2)

pca_result = pca.fit_transform(data)

print(f"Explained variance: {pca.explained_variance_ratio_}")

```

在这段代码中,我们使用`PCA`类进行主成分分析,将10维数据降至2维。我们还可以查看解释的方差比率,这有助于我们了解降维后保留了多少信息。

以上就是第三章中“Stat库中的概率统计功能”部分的内容。通过本章的介绍,我们学习了如何使用Stat库来实现概率分布、进行参数估计、假设检验、置信区间计算、样本量估计、相关性分析、回归模型以及多变量统计分析的高级技术。这些统计方法不仅在理论研究中有着广泛的应用,更是在实际的数据分析中扮演着至关重要的角色。

# 4. Stat库的高级应用与实战案例

## 4.1 时间序列分析

### 4.1.1 时间序列数据的处理

时间序列分析是统计学中用来研究数据点按时间顺序排列形成的数据集的一种技术。时间序列数据处理的关键步骤包括数据的导入、清洗、转换以及分解,以识别数据中的模式、趋势和周期性。在使用Stat库进行时间序列分析时,首先需要导入相关的模块,并加载或创建时间序列数据。

```python

import statlib as st

import pandas as pd

# 创建或加载时间序列数据

# 假设我们有按周记录的销售数据

dates = pd.date_range('2020-01-01', periods=100, freq='W')

sales = st.Series([random.randint(100, 500) for _ in range(100)])

# 将数据转换为时间序列对象

ts = st.TimeSeries(sales, index=dates)

```

在这个例子中,我们创建了一个随机的周销售数据集,包含100个数据点。然后我们使用这些数据创建了一个Stat库的时间序列对象。这个对象能够处理时间相关的操作,比如重新采样、插值、平滑等。

### 4.1.2 ARIMA模型和预测

自回归积分滑动平均模型(ARIMA)是时间序列分析中非常重要的一个模型,特别适用于分析和预测时间序列数据的未来值。ARIMA模型由三个主要部分组成:自回归项、差分项和滑动平均项。该模型能够处理非平稳的时间序列数据,通过将非平稳数据转换为平稳数据来预测。

使用Stat库实现ARIMA模型的代码如下:

```python

# 定义ARIMA模型参数

p = 1 # 自回归项数

d = 1 # 差分次数

q = 1 # 移动平均项数

# 创建并训练模型

arima_model = st.ARIMA(ts, order=(p, d, q))

arima_model.fit()

# 进行预测

forecast = arima_model.forecast(steps=5)

```

在上述代码中,我们首先指定了ARIMA模型的参数(p、d、q),然后创建了ARIMA模型的实例。通过调用`fit`方法来训练模型,最后我们调用`forecast`方法来进行未来5个时间点的预测。`forecast`方法返回的`forecast`对象包含了预测值和预测误差的信息。

## 4.2 机器学习集成

### 4.2.1 集成学习算法的实现

集成学习是一种机器学习范式,旨在构建并组合多个学习器来解决同一个问题。Stat库提供了集成学习算法的实现,如随机森林(Random Forest)、梯度提升树(Gradient Boosting Trees)等。这些算法通过聚合多个预测模型来提高预测的准确性和泛化能力。

使用Stat库实现随机森林模型的代码示例如下:

```python

# 准备训练数据

X = st.DataFrame([[random.random() for _ in range(10)] for _ in range(100)])

y = st.Series([random.randint(0, 1) for _ in range(100)])

# 定义随机森林模型

rf = st.RandomForestClassifier()

# 训练模型

rf.fit(X, y)

# 使用模型进行预测

predictions = rf.predict(X)

```

在这段代码中,我们首先生成了一些模拟的特征数据`X`和标签`y`。接着,我们创建了一个随机森林分类器实例`rf`。通过调用`fit`方法,我们使用训练数据对模型进行了训练。最后,我们使用训练好的模型对同一数据集进行了预测。

### 4.2.2 实例:预测股票价格

在实际应用中,集成学习算法可以被用来预测股票价格。股票价格预测是一个复杂的时间序列预测问题,集成学习能够结合不同的模型和策略,提高预测的准确性。以下是一个使用随机森林进行股票价格预测的简要实例。

```python

import yfinance as yf

from sklearn.ensemble import RandomForestRegressor

from sklearn.preprocessing import StandardScaler

from sklearn.pipeline import make_pipeline

# 下载股票数据

data = yf.download('AAPL', start='2020-01-01', end='2021-01-01')

# 选择特征和标签

features = data[['Open', 'High', 'Low', 'Volume']]

labels = data['Close']

# 划分训练集和测试集

X_train, X_test, y_train, y_test = st.train_test_split(features, labels, test_size=0.2, random_state=42)

# 创建管道,包括缩放和随机森林模型

pipeline = make_pipeline(StandardScaler(), RandomForestRegressor())

# 训练模型

pipeline.fit(X_train, y_train)

# 测试模型并评估结果

predictions = pipeline.predict(X_test)

```

在这个示例中,我们使用了`yfinance`库来下载苹果公司的股票数据,并选取了开盘价、最高价、最低价和成交量作为特征,收盘价作为标签。通过`train_test_split`方法将数据集划分成训练集和测试集。然后创建了一个管道(pipeline),其中包含数据缩放和随机森林回归模型。接着,使用训练集数据训练了模型,并用测试集数据进行预测,最后通过预测结果评估模型性能。

## 4.3 实际项目案例分析

### 4.3.1 数据分析项目的设计

数据分析项目的设计需要遵循科学的研究方法和流程。这通常包括定义问题、收集数据、探索性数据分析、构建模型、验证模型、解释结果以及进行决策支持。以下是设计数据分析项目时可遵循的步骤:

1. **问题定义:**明确分析的目的和目标,如客户细分、销售预测、异常检测等。

2. **数据收集:**根据问题需求,从内部数据库、外部API或在线数据集等来源收集数据。

3. **数据探索:**进行描述性统计和可视化,以理解数据的基本特征和分布。

4. **数据预处理:**处理缺失值、异常值、数据转换和归一化等。

5. **模型构建:**选择合适的统计模型或机器学习算法构建模型。

6. **模型评估:**使用交叉验证、混淆矩阵等方法评估模型的性能。

7. **结果解释:**对模型结果进行解释,并给出决策建议。

### 4.3.2 Stat库在数据驱动决策中的应用

在数据驱动的决策过程中,Stat库提供了一整套统计分析工具,帮助我们从数据中提取有价值的信息,并支持决策制定。Stat库不仅限于传统的统计分析,也扩展到了机器学习和数据挖掘领域,使其成为数据分析项目中的一个强大工具。

例如,在客户细分项目中,我们可以利用聚类算法(如k-means)将客户划分为不同的群体,然后通过描述性统计和预测模型来分析不同群体的特征和行为。在市场分析中,可以利用时间序列模型来预测未来的销售趋势,并评估营销活动的效果。而在风险评估中,可以运用回归分析来识别可能导致损失的关键因素,并采取相应的风险控制措施。

通过结合这些Stat库提供的强大功能,数据分析人员能够更好地从数据中获取洞察,辅助组织作出更加精准和高效的决策。Stat库的灵活性和广泛的应用性,使其成为数据驱动决策不可或缺的一部分。

# 5. Stat库与数据分析工具的集成

## 5.1 Stat库与Pandas的交互

### 5.1.1 Pandas在数据处理中的作用

在数据分析领域,Pandas库因其高效的数据处理能力而被广泛使用。它提供了一种高级数据结构——DataFrame,这种结构让数据操作变得更为直观和简洁。结合Stat库,Pandas可以被用于数据清洗、数据转换、数据聚合等多个环节。特别是当面对非标准格式的数据时,Pandas强大的数据处理功能能够大幅简化数据预处理的步骤。

```python

import pandas as pd

import numpy as np

# 创建一个简单的DataFrame

df = pd.DataFrame({

'A': np.random.randn(5),

'B': np.random.randn(5)

})

print(df)

```

### 5.1.2 数据整合与转换的策略

数据整合和转换是数据分析的重要步骤。使用Pandas,可以轻松地进行数据合并、分组、透视等操作。与Stat库结合,可以实现复杂的数据统计和分析功能。比如,在数据整合过程中,我们可以通过Pandas的`merge`或`concat`函数合并来自不同源的数据集,然后使用Stat库进行描述性统计分析。

```python

# 假设df1和df2是两个不同的DataFrame

df1 = pd.DataFrame({

'key': ['K0', 'K1', 'K2', 'K3'],

'A': ['A0', 'A1', 'A2', 'A3'],

'B': ['B0', 'B1', 'B2', 'B3']

})

df2 = pd.DataFrame({

'key': ['K0', 'K1', 'K2', 'K3'],

'C': ['C0', 'C1', 'C2', 'C3'],

'D': ['D0', 'D1', 'D2', 'D3']

})

# 使用merge函数进行数据整合

merged_df = pd.merge(df1, df2, on='key')

print(merged_df)

```

## 5.2 Stat库与Matplotlib的结合

### 5.2.1 数据可视化的基础

数据可视化是数据分析中的关键环节,Matplotlib库提供了丰富的绘图工具,帮助我们直观地展示数据。通过与Stat库的结合,Matplotlib可以用来绘制统计图表,比如直方图、箱线图、散点图等。这些图表可以清晰地表达数据的分布特征、趋势和关系,是理解和解释数据的重要手段。

```python

import matplotlib.pyplot as plt

# 使用Stat库计算数据集的描述性统计量

data = [10, 12, 12, 13, 12, 15, 16, 19, 20, 21]

mean = np.mean(data)

median = np.median(data)

std_dev = np.std(data)

# 使用Matplotlib绘制直方图

plt.hist(data, bins=5, alpha=0.5)

plt.axvline(mean, color='r', linestyle='dashed', linewidth=2)

plt.axvline(median, color='g', linestyle='dashed', linewidth=2)

plt.title('Histogram with Mean and Median')

plt.show()

```

### 5.2.2 高级图表的绘制技巧

除了基础图表,Matplotlib的灵活性允许我们创建更为复杂的可视化作品。例如,多轴图可以同时展示不同量度的数据变化,组合图能在一个图表中展示多种类型的统计图形,而3D图则可以在三维空间中表现数据的多维特征。这些高级技巧的掌握,对于向非专业人士传达数据洞察尤为关键。

```python

# 创建一个包含多子图的图形

fig, axs = plt.subplots(2, 2, figsize=(10, 10))

# 绘制直方图

axs[0, 0].hist(data, bins=5, alpha=0.5)

axs[0, 0].set_title('Histogram')

# 绘制箱线图

axs[0, 1].boxplot(data, vert=True, patch_artist=True)

axs[0, 1].set_title('Boxplot')

# 绘制散点图

axs[1, 0].scatter(range(len(data)), data)

axs[1, 0].set_title('Scatter Plot')

# 绘制饼图

axs[1, 1].pie([10, 30, 20], labels=['A', 'B', 'C'], autopct='%1.1f%%')

axs[1, 1].set_title('Pie Chart')

plt.show()

```

## 5.3 Stat库在Web应用中的部署

### 5.3.1 Flask或Django框架的选择与集成

Web应用的开发离不开后端框架。对于Stat库而言,集成到Web应用主要涉及两个方面:一是将统计分析功能作为后端服务提供,二是将统计结果展示给前端用户。Flask因其轻量级而适合快速开发小型应用,而Django则提供了更为全面的开发工具和应用架构。选择合适的框架,并将Stat库集成到Web应用中,可以有效地将统计分析能力嵌入到业务流程中。

### 5.3.2 构建可交互的统计分析Web服务

为了实现一个可交互的统计分析Web服务,需要设计用户友好的界面和后端统计计算逻辑。用户通过前端界面发起请求,后端接受请求后调用Stat库进行数据处理和计算,最后将结果以用户可理解的方式返回给前端。例如,创建一个简单的线性回归分析服务,用户可以上传数据集,系统将自动计算并返回模型参数和拟合效果。

```python

# 使用Flask创建一个简单的Web服务

from flask import Flask, request, jsonify

from scipy import stats

app = Flask(__name__)

@app.route('/linear_regression', methods=['POST'])

def linear_regression():

data = request.json['data']

slope, intercept, r_value, p_value, std_err = stats.linregress(data['x'], data['y'])

result = {

'slope': slope,

'intercept': intercept,

'r_value': r_value,

'p_value': p_value,

'std_err': std_err

}

return jsonify(result)

if __name__ == '__main__':

app.run(debug=True)

```

这一章节介绍了Stat库与Pandas、Matplotlib这两种流行的数据分析工具以及Web后端框架Flask或Django的集成。通过章节内容的学习,可以帮助读者理解和掌握如何将Stat库的功能扩展到更广泛的应用场景中,从数据处理到Web服务部署的全链路应用。

0

0