揭秘OpenVINO YOLO单图像推理:模型部署与调优秘籍

发布时间: 2024-08-18 05:01:38 阅读量: 43 订阅数: 39

ysoserial-master.zip

# 1. OpenVINO简介**

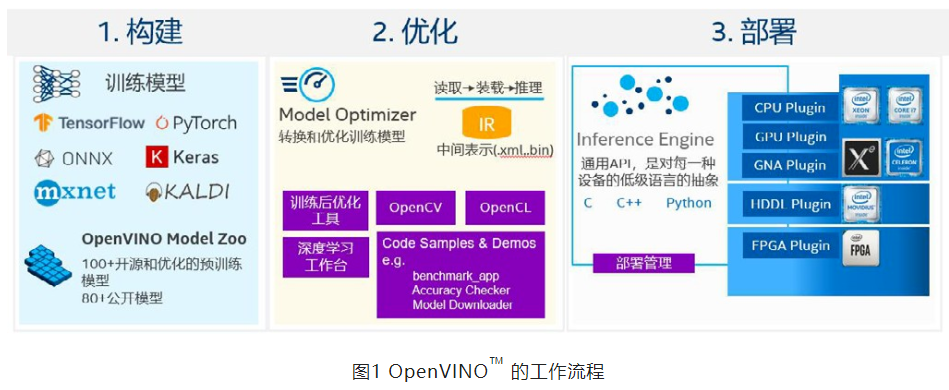

OpenVINO™ 工具套件是一个开源的计算机视觉、机器学习和深度学习推理框架,用于加速各种平台上的深度学习模型的部署和推理。它由英特尔开发,旨在优化模型性能,同时提供跨不同硬件架构的可移植性。

OpenVINO™ 工具套件包含一系列组件,包括:

* **Model Optimizer:**将深度学习模型转换为 OpenVINO™ IR(中间表示)格式,以便在各种硬件平台上进行优化推理。

* **Inference Engine:**一个 C++ 库,提供用于在 CPU、GPU 和 VPU(视觉处理单元)等不同硬件平台上执行模型推理的 API。

* **OpenVINO™ 开发工具包:**一组用于开发和部署 OpenVINO™ 应用程序的工具,包括 Python API、示例和教程。

# 2. YOLO模型部署**

**2.1 模型转换和优化**

**2.1.1 Model Optimizer工具介绍**

Model Optimizer是OpenVINO工具包中用于将预训练模型转换为OpenVINO IR格式的工具。它支持各种深度学习框架,包括TensorFlow、Caffe和PyTorch。Model Optimizer通过以下步骤转换模型:

- **冻结图(Freeze Graph)**:将训练模型中的所有变量转换为常量,使其不再依赖于训练数据。

- **图优化(Graph Optimization)**:应用各种优化技术,例如常量折叠、子图合并和冗余消除,以减小模型大小和提高推理速度。

- **IR生成(IR Generation)**:将优化后的模型转换为OpenVINO IR格式,该格式由Inference Engine用于推理。

**2.1.2 模型转换参数详解**

Model Optimizer提供了一系列参数来控制转换过程,包括:

| 参数 | 描述 |

|---|---|

| `--input` | 输入节点名称 |

| `--output` | 输出节点名称 |

| `--data_type` | 模型数据类型(FP32、FP16、INT8) |

| `--layout` | 模型布局(NCHW、NHWC) |

| `--model_name` | 输出IR模型的名称 |

| `--scale` | 输入图像的预处理比例 |

| `--mean_values` | 输入图像的预处理均值 |

**2.2 模型推理引擎集成**

**2.2.1 Inference Engine API介绍**

Inference Engine是OpenVINO工具包中的推理引擎,用于执行模型推理。它提供了一个跨平台的API,允许开发者在各种设备(CPU、GPU、VPU)上部署和运行模型。

Inference Engine API主要包括以下功能:

- **模型加载和编译**:加载IR模型并将其编译为设备特定的可执行代码。

- **输入数据预处理**:将输入数据预处理为模型所需的格式。

- **模型推理**:执行模型推理并生成预测结果。

- **输出数据后处理**:将预测结果后处理为最终输出。

**2.2.2 模型推理流程分析**

模型推理流程通常包括以下步骤:

1. **模型加载**:使用Inference Engine加载IR模型。

2. **输入预处理**:将输入数据预处理为模型所需的格式,包括调整大小、归一化和转换布局。

3. **模型推理**:使用Inference Engine执行模型推理,生成预测结果。

4. **输出后处理**:将预测结果后处理为最终输出,例如应用非极大值抑制(NMS)以过滤冗余检测。

**代码示例:**

```python

import openvino.inference_engine as ie

# 加载模型

model = ie.IECore().read_network("model.xml", "model.bin")

# 输入预处理

input_blob = model.inputs["input"]

input_data = preprocess_input(input_blob)

# 模型推理

exec_net = ie.IECore().load_network(model, "CPU")

result = exec_net.infer(inputs={input_blob: input_data})

# 输出后处理

output_blob = model.outputs["output"]

output_data = postprocess_output(result[output_blob])

`

```

0

0