OpenVINO YOLO单图像推理:性能分析与瓶颈优化,提升效率

发布时间: 2024-08-18 05:03:51 阅读量: 31 订阅数: 39

CSharp+OpenVINO部署YOLO模型与同步推理实现

# 1. OpenVINO YOLO单图像推理简介**

OpenVINO YOLO单图像推理是一种高效且准确的目标检测技术,它利用OpenVINO推理引擎和YOLO算法的强大功能。YOLO(You Only Look Once)算法是一种单次卷积神经网络,可以快速检测图像中的多个对象。OpenVINO推理引擎是一个高性能推理库,可优化模型执行并将其部署到各种硬件平台上。通过将YOLO算法与OpenVINO推理引擎相结合,我们可以实现快速、准确且高效的单图像目标检测。

# 2. OpenVINO YOLO单图像推理理论基础

### 2.1 YOLO算法原理

#### 2.1.1 目标检测的基本概念

目标检测是一项计算机视觉任务,旨在从图像或视频中识别和定位感兴趣的对象。与传统的目标检测方法不同,YOLO(You Only Look Once)算法是一种单次检测方法,可以实时处理图像。

#### 2.1.2 YOLO算法的架构和流程

YOLO算法的架构主要包括:

- **主干网络:**提取图像特征,通常使用预训练的卷积神经网络(如ResNet或Darknet)。

- **区域建议网络(RPN):**生成候选目标区域,并对每个区域进行分类。

- **全连接层:**对每个候选区域进行边界框回归和类别预测。

YOLO算法的流程如下:

1. 将图像输入主干网络,提取特征图。

2. 将特征图输入RPN,生成候选目标区域。

3. 对每个候选区域进行分类和边界框回归。

4. 根据置信度阈值和非极大值抑制(NMS)算法,输出最终的检测结果。

### 2.2 OpenVINO推理引擎

#### 2.2.1 OpenVINO简介

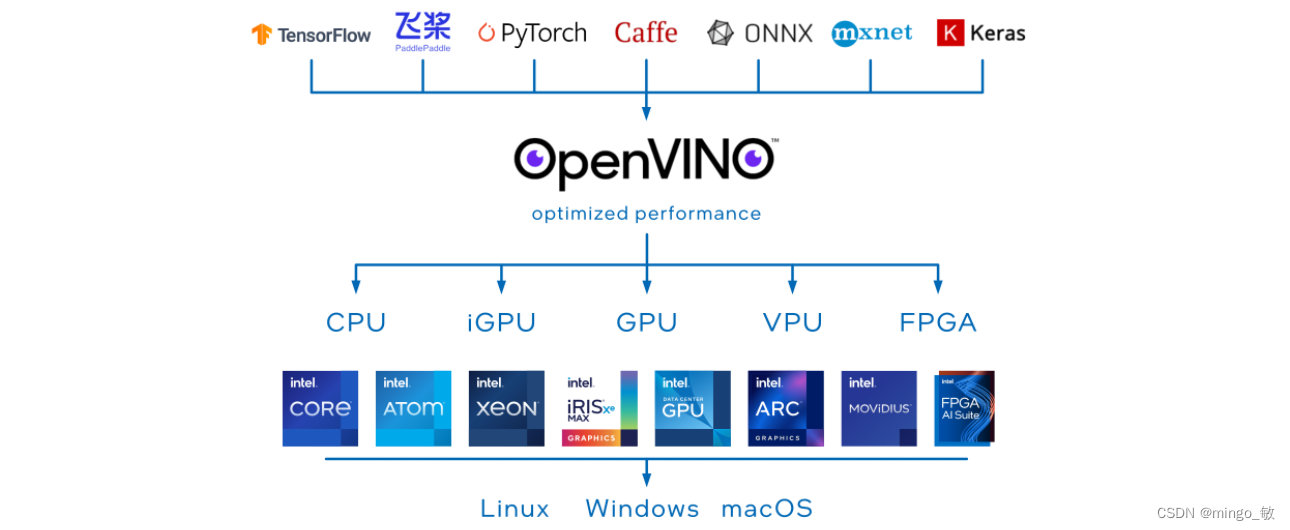

OpenVINO™ 工具套件是一个开放、可扩展的计算机视觉和机器学习推理框架,旨在优化英特尔® 硬件上的模型性能。它提供了用于模型优化、推理和部署的工具和库。

#### 2.2.2 推理引擎的工作原理

OpenVINO推理引擎负责执行训练好的模型。它的工作原理如下:

1. **模型加载:**将训练好的模型加载到推理引擎中。

2. **输入预处理:**将输入图像预处理为模型所需的格式。

3. **推理:**使用模型对输入图像进行推理,生成输出结果。

4. **输出后处理:**对输出结果进行后处理,例如边界框解码和类别预测。

推理引擎支持多种硬件后端,包括CPU、GPU和VPU,并提供了优化性能的工具和技术,例如模型量化和加速。

# 3. OpenVINO YOLO单图像推理实践

### 3.1 模型准备和推理流程

#### 3.1.1 模型下载和预处理

**步骤 1:下载预训练模型**

从 OpenVINO 模型库下载预训练的 YOLOv3 模型,例如 `intel/object_detection_yolo_v3`。

**步骤 2:模型转换**

使用 OpenVINO 模型优化器将下载的模型转换为 OpenVINO 格式:

```bash

mo --input_model yolov3.xml --output_model yolov3.bin

```

#### 3.1.2 推理流程的详细步骤

**步骤 1:加载模型和推理引擎**

```cpp

// 加载模型

Core ie;

CNNNetwork network = ie.ReadNetwork("yolov3.xml", "yolov3.bin");

// 创建推理引擎

InferenceEngine ie;

ExecutableNetwork executableNetwork = ie.LoadNetwork(network, "CPU");

```

**步骤 2:预处理图像**

将输入图像调整为模型输入大小,并将其转换为 OpenVINO 格式:

```cpp

// 预处理图像

Mat image = imread("image.jpg");

Mat blob = blobFromImage(image, 1.0, Size(416, 416), Scalar(0, 0, 0), true, false);

```

**步骤 3:执行推理**

将预处理后的图像输入推理引擎并执行推理:

```cpp

// 执行推理

InferRequest inferRequest = executableNetwork.CreateInferRequest();

inferRequest.SetBlob("input", blob);

inferRequest.Infer();

```

**步骤 4:后处理结果**

从推理结果中提取检测到的目标框和置信度:

```cpp

// 后处理结果

Mat detectionOut = inferRequest.GetBlob("detection_out").buffer().as<float*>();

```

### 3.2 性能分析和瓶颈识别

#### 3.2.1 性能指标的定义和测量

**推理时间:**从图像预处理到推理完成所需的时间。

**吞吐量:**单位时间内处理的图像数量。

**准确率:**检测到的目标框与真实目标框之间的重叠率。

**测量方法:**使用计时器测量推理时间,使用图像集计算吞吐量,使用标准数据集计算准确率。

#### 3.2.2 瓶颈识别的常用方法

**性能分析工具:**使用 OpenVINO Profiler 或 Intel VTune Amplifier 等工具分析推理流程中的瓶颈。

**代码分析:**检查代码并识别可能导致性能下降的瓶颈,例如不必要的内存分配或冗余计算。

**硬件分析:**检查硬件资源的使用情况,例如 CPU 利用率、内存带宽和 GPU 利用率。

# 4. OpenVINO YOLO 单图

0

0