OpenVINO YOLO单图像推理:自定义模型与训练,打造专属AI解决方案

发布时间: 2024-08-18 05:22:33 阅读量: 16 订阅数: 25

# 1. OpenVINO YOLO简介**

### 1.1 YOLO模型概述

YOLO(You Only Look Once)是一种实时目标检测算法,因其速度快、准确度高而闻名。它使用单次卷积神经网络(CNN)同时预测图像中的所有对象及其边界框。YOLO算法的独特之处在于它将目标检测问题转化为回归问题,从而避免了传统的滑动窗口方法的计算密集型过程。

### 1.2 OpenVINO YOLO工具链

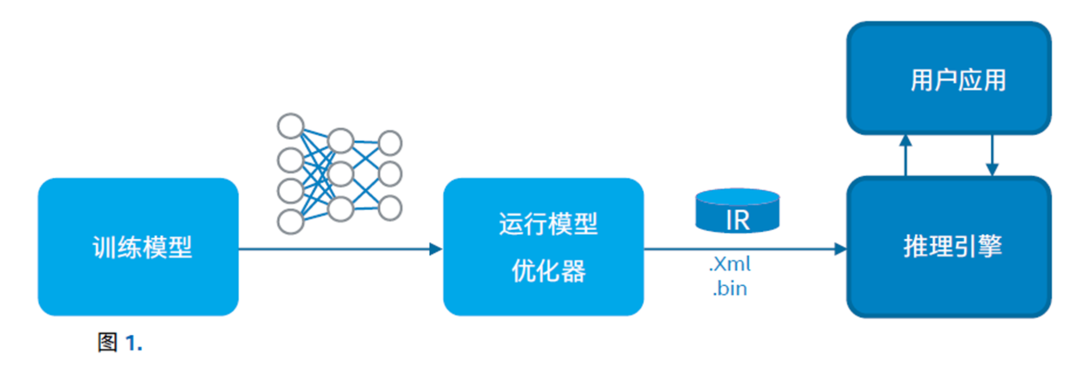

OpenVINO YOLO工具链是一个由英特尔开发的软件包,用于在英特尔处理器上部署和推理YOLO模型。它包括以下组件:

* **模型转换器:**将YOLO模型从其原始框架(如TensorFlow或PyTorch)转换为OpenVINO中间表示(IR)。

* **推理引擎:**一个高性能库,用于在各种英特尔处理器上执行IR模型。

* **示例应用程序:**演示如何使用OpenVINO YOLO工具链进行目标检测的示例代码。

# 2. 自定义模型训练

### 2.1 数据集准备

#### 数据集收集与标注

自定义模型训练的第一步是准备高质量的训练数据集。数据集应包含各种场景、对象和视角,以确保模型具有泛化能力。

#### 数据预处理

收集到的原始数据通常需要进行预处理,以使其适合模型训练。预处理步骤可能包括:

* **图像调整:**调整图像大小、裁剪、翻转和旋转,以增加数据集的多样性。

* **数据增强:**应用随机变换,如颜色抖动、亮度调整和几何变换,以进一步增强数据集。

* **数据清理:**删除损坏或不相关的图像,并过滤掉质量差的数据。

### 2.2 模型架构设计

#### 模型选择

选择合适的模型架构对于自定义模型训练至关重要。对于目标检测任务,流行的模型包括:

* **YOLOv3:**一种实时目标检测模型,以其速度和准确性而闻名。

* **YOLOv5:**YOLOv3 的改进版本,具有更好的性能和更快的推理速度。

* **EfficientDet:**一种轻量级目标检测模型,适用于资源受限的设备。

#### 模型定制

选择模型架构后,可以根据特定需求对其进行定制。定制选项包括:

* **骨干网络:**更换模型的骨干网络(例如 ResNet、DarkNet),以提高准确性或推理速度。

* **检测头:**修改模型的检测头,以调整锚框大小、分类器数量和损失函数。

* **超参数调整:**调整模型的超参数,如学习率、批大小和训练轮数,以优化性能。

### 2.3 模型训练和评估

#### 训练过程

模型训练涉及将训练数据集输入模型并更新模型参数,以最小化损失函数。训练过程通常使用以下步骤:

1. **前向传播:**将训练图像输入模型,并获得预测结果。

2. **计算损失:**比较预测结果和真实标签,计算损失函数的值。

3. **反向传播:**计算损失函数对模型参数的梯度。

4. **参数更新:**使用优化器(例如 Adam、SGD)更新模型参数,以减小损失函数。

#### 训练监控和评估

在训练过程中,需要监控模型的性能,以确保其朝着正确的方向发展。常见的监控指标包括:

* **训练损失:**衡量模型在训练集上的预测准确性。

* **验证损失:**衡量模型在验证集上的预测准确性,以避免过拟合。

* **mAP(平均精度):**衡量模型在不同类别和阈值下的检测准确性。

#### 模型评估

训练完成后,需要对模型进行评估,以确定其性能。评估通常使用测试集进行,并计算以下指标:

* **mAP:**衡量模型在不同类别和阈值下的检测准确性。

* **推理速度:**衡量模型在特定硬件上的推理速度,以每秒帧数 (FPS) 为单位。

* **模型大小:**衡量模型的大小,以兆字节 (MB) 为单位,以评估其在部署时的可行性。

# 3.1 模型转换和优化

模型转换是将训练好的模型转换为 OpenVINO 模型格式的过程。OpenVINO 提供了多种工具和 API 来实现模型转换,包括:

- **Model Optimizer**:这是一个命令行工具,用于将 Caffe、TensorFlow、MXNet 等流行深度学习框架中的模型转换为 OpenVINO 模型格式。

- **Python API**:OpenVINO 提供了 Python API,允许开发者使用 Python 脚本将模型转换为 OpenVINO 格式。

模型优化是提高推理性能和减少模型大小的关键步骤。OpenVINO 提供了以下优化技术:

- **网络裁剪**:移除模型中不必要的层或节点,以减少模型大小和推理时间。

- **量化**:将浮点权重和激活转换为低精度整数格式,以减少内存占用和推理时间。

- **融合**:将多个操作合并为单个操作,以提高推理速度。

### 3.2 推理引擎集成

推理引擎是 OpenVINO 的核心组

0

0