【Transformer模型的技术生态系统与工具介绍】: 介绍Transformer模型的技术生态系统及相关工具

发布时间: 2024-04-20 11:37:44 阅读量: 89 订阅数: 105

# 1. Transformer模型概述

Transformer模型是自注意力机制的一个示例,已被证明在许多自然语言处理任务中非常成功。相比之前的循环神经网络(RNN)和长短期记忆网络(LSTM),Transformer模型不涉及序列的顺序,通过将所有输入的token同时传递给模型来计算输入序列中各部分之间的依赖关系。它的并行计算使其非常适合GPU加速,因此非常适合处理大型数据集。Transformer模型的成功表明,为了提高自然语言处理任务的性能,注意力机制是一个非常有前景的方向。

# 2. Transformer模型的基本原理

### 2.1 机器学习中的Transformer

Transformer模型作为一种基于注意力机制的深度学习网络,在机器学习领域取得了巨大成功。其核心在于一种新颖而高效的自注意力机制。让我们一起深入了解Transformer模型的基本原理。

#### 2.1.1 自注意力机制

自注意力机制是Transformer模型的核心组成部分之一。它允许模型在计算某个位置的表示时,能够同时关注输入序列中的所有其他位置。这种全局性的关注机制使得Transformer在捕捉长距离依赖关系方面表现出色。

下面是自注意力机制的简化实现代码:

```python

def self_attention(Q, K, V):

"""自注意力计算"""

attention_scores = softmax(Q @ K.T / sqrt(d_model))

output = attention_scores @ V

return output

```

#### 2.1.2 多头注意力机制

为了增强模型的表达能力,Transformer引入了多头注意力机制。通过同时使用多组不同的查询、键、值权重矩阵,模型可以并行地学习不同子空间的表征,有效地捕捉不同特征之间的关系。

#### 2.1.3 残差连接和层归一化

在Transformer的每个子层结构中,都包含了残差连接和层归一化。残差连接有助于缓解梯度消失问题,而层归一化则有助于加速模型收敛速度,保证每层输入的均值和方差稳定。

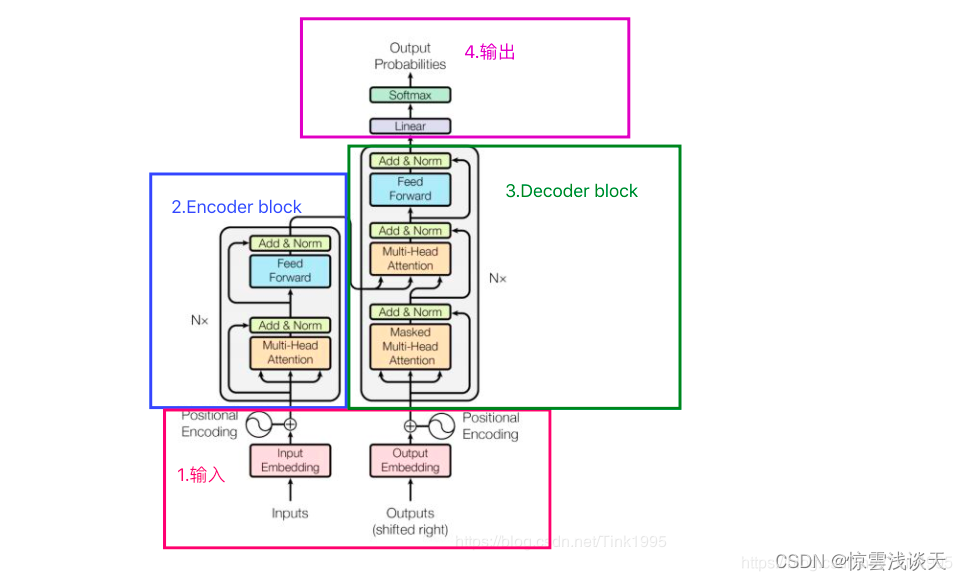

### 2.2 Transformer编码器-解码器结构

除了自注意力机制,Transformer还引入了编码器-解码器结构,用于处理序列到序列的任务,如机器翻译。

#### 2.2.1 编码器结构

编码器由多层相同结构的子层构成,每个子层包含了一个自注意力机制和一个前馈神经网络。编码器负责将输入序列编码为上下文相关的表示。

下表为Transformer编码器结构示意图:

| Layer | Sub-layer 1 | Sub-layer 2 |

|-----------------|--------------------|--------------------|

| Self-Attention | | |

| Feed Forward | | |

#### 2.2.2 解码器结构

解码器也类似于编码器,但在自注意力机制上引入了一个额外的编码器-解码器注意力机制,以便解码器能够对编码器的输出进行关注。

#### 2.2.3 编码器-解码器注意力

编码器-解码器注意力机制允许解码器在生成目标序列时,根据源语言句子进行对应位置的关注,从而实现翻译等任务。

下面是编码器-解码器注意力机制的代码示例:

```python

def encoder_decoder_attention(Q, K_enc, V_enc):

"""编码器-解码器注意力计算"""

attention_scores = softmax(Q @ K_enc.T / sqrt(d_model))

output = attention_scores @ V_enc

return output

```

### 2.3 Transformer模型位置编码

在Transformer模型中,并没有循环神经网络或卷积神经网络中的位置信息。为了使模型能够区分序列中不同位置的词语,Transformer模型引入了位置编码。位置编码是将词的位置信息编码成向量形式,然后与词向量相加作为模型输入。

通过这种方式,Transformer模型既保留了词语的语义信息,又能够区分不同位置上的词语,从而更好地处理序列数据。

以上是Transformer模型基本原理的详细介绍,理解这些基本原理有助于我们更深入地应用和优化Transformer模型。

# 3. Transformer模型的技术生态系统

Transformer 模型的出现引领了自然语言处理领域的革命,其技术生态系统也在不断丰富和发展。本章将深入探讨 Transformer 模型的技术生态系统,重点介绍 BERT 和 GPT 两大知名模型,并展望 Transformer 技术的未来发展趋势。

## 3.1 BERT(Bidirectional Encoder Representations from Transformers)

在自然语言处理领域,BERT 是一种颇受欢迎的预训练模型,它的全称是 Bidirectional Encoder Representations from Transformers。下面我们将深入了解 BERT 的应用领域以及其训练和推理机制。

### 3.1.1 BERT的应用领域

BERT 模型在自然语言处理领域有着广泛的应用,主要包括:

- 文本分类

- 问答系统

- 命名实体识别

- 语义理解

- 摘要生成

- 对话系统

通过预训练和微调的方式,BERT 在上述各个领域都

0

0