【Layer Normalization解析】: Transformer模型层归一化解析

发布时间: 2024-04-20 10:56:36 阅读量: 269 订阅数: 105

机器学习之数据归一化

# 1. Layer Normalization简介

Layer Normalization(层归一化)是一种神经网络中常用的归一化技术,旨在解决神经网络训练中的梯度消失、梯度爆炸等问题。与Batch Normalization相比,Layer Normalization更适用于深度模型的训练,因为它不依赖于batch的样本数量,而是对每一层的输出进行独立归一化处理。这种独特的处理方式使得Layer Normalization在循环神经网络(RNN)等需要处理序列数据的模型中表现更加出色。

文章将深入探讨Layer Normalization的原理、计算过程、优缺点以及在Transformer模型中的应用等内容,希望能为读者带来全面且实用的了解。

# 2. 深入理解Layer Normalization

Layer Normalization是深度学习领域中一种重要的归一化技术,它在一定程度上改善了模型训练的效果。在本章节中,我们将深入理解Layer Normalization的概念、原理以及计算过程,并分析其优缺点。

### 2.1 Layer Normalization的概念和原理

#### 2.1.1 为什么需要Layer Normalization

在深度神经网络中,随着网络层数的增加,梯度消失和梯度爆炸问题很容易发生。Batch Normalization虽然在解决这些问题上有显著效果,但是其对batch size的依赖性导致在小批量数据训练时效果不佳。因此,Layer Normalization作为一种替代方案应运而生。

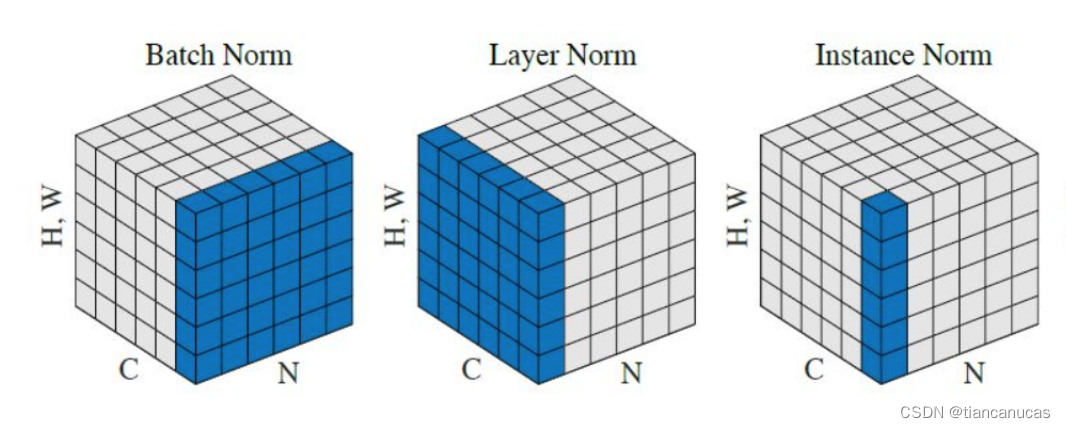

#### 2.1.2 Layer Normalization与Batch Normalization的区别

Layer Normalization与Batch Normalization最大的不同在于归一化的对象不同。Batch Normalization是对每个特征维度在batch上进行归一化,而Layer Normalization是在每个样本的所有特征维度上进行归一化。这使得Layer Normalization更适合用于小批量数据训练,同时也降低了对batch size的依赖性。

### 2.2 Layer Normalization的计算过程

#### 2.2.1 归一化处理

Layer Normalization的第一步是对每个样本的特征维度进行归一化处理,即计算特征的均值和方差,然后使用这些统计值对特征进行归一化操作。

```python

# 归一化处理示例代码

mean = np.mean(features, axis=-1, keepdims=True)

variance = np.var(features, axis=-1, keepdims=True)

normalized_features = (features - mean) / np.sqrt(variance + epsilon)

```

#### 2.2.2 缩放和平移操作

归一化后的特征需要经过缩放和平移操作,以增加模型的表达能力。这一步操作可以增加模型对特征间关系的学习能力,提高模型性能。

```python

# 缩放和平移操作示例代码

gamma = np.random.randn(features.shape[-1]) # 初始化缩放参数

beta = np.random.randn(features.shape[-1]) # 初始化平移参数

output = gamma * normalized_features + beta

```

### 2.3 Layer Normalization的优缺点分析

#### 2.3.1 优点:适用性和效果

Layer Normalization相比于Batch Normalization更适用于小批量数据训练,具有更好的泛化能力。它能够加速模型训练过程,使得模型更容易收敛。

#### 2.3.2 缺点:训练速度和计算复杂度

然而,Layer Normalization也存在一些缺点,例如在计算上的复杂度相对较高,同时在特征维度较高时会带来一定的训练速度问题。

在下一章节中,我们将学习Layer Normalization在Transformer模型中的应用,进一步加深对Layer Normalization的理解。

# 3. Transformer模型简介

Transformer 模型是近年来在自然语言处理领域取得巨大成功的一个重要模型,其较传统的 RNN 和 LSTM 等模型具有更好的并行计算能力和更长距离的依赖性捕捉能力。在本节中,我们将深入介绍 Transformer 模型的基本概

0

0