MATLAB特征向量与奇异值分解:探索数据降维的奥秘(4大应用)

发布时间: 2024-06-16 16:35:50 阅读量: 114 订阅数: 42

# 1. MATLAB特征向量与奇异值分解(SVD)基础

奇异值分解(SVD)是一种强大的数学工具,用于分析和处理矩阵。在MATLAB中,SVD可以通过`svd`函数实现。

SVD将一个矩阵分解为三个矩阵的乘积:一个左奇异向量矩阵`U`,一个奇异值矩阵`S`和一个右奇异向量矩阵`V`。奇异值矩阵`S`是一个对角矩阵,其对角线元素是矩阵的奇异值,按降序排列。奇异向量矩阵`U`和`V`是正交矩阵,它们的列是矩阵的左奇异向量和右奇异向量。

# 2. SVD在数据降维中的理论原理

### 2.1 特征向量与特征值

**特征向量**

特征向量是线性代数中一个重要的概念。对于一个矩阵 **A**,它的特征向量 **v** 是一个非零向量,当乘以 **A** 时,只会改变其长度,而不会改变其方向。即:

```

Av = λv

```

其中,λ 是一个标量,称为特征值。

**特征值**

特征值表示特征向量在变换下的缩放因子。它度量了矩阵 **A** 对特征向量方向的影响。特征值可以是实数或复数。

### 2.2 奇异值分解的数学推导

奇异值分解(SVD)是一种将矩阵分解为特征向量和特征值的矩阵分解技术。对于一个 **m x n** 矩阵 **A**,其 SVD 形式为:

```

A = UΣV^T

```

其中:

* **U** 是一个 **m x m** 的酉矩阵,其列向量是 **A** 的左奇异向量。

* **Σ** 是一个 **m x n** 的对角矩阵,其对角线元素是 **A** 的奇异值。

* **V** 是一个 **n x n** 的酉矩阵,其列向量是 **A** 的右奇异向量。

**奇异值**

奇异值是矩阵 **A** 的非负平方根。它们表示矩阵 **A** 沿其奇异向量的伸缩程度。

**奇异向量**

奇异向量是 **A** 的特征向量。左奇异向量 **U** 的列向量是 **A** 的左奇异空间的正交基,而右奇异向量 **V** 的列向量是 **A** 的右奇异空间的正交基。

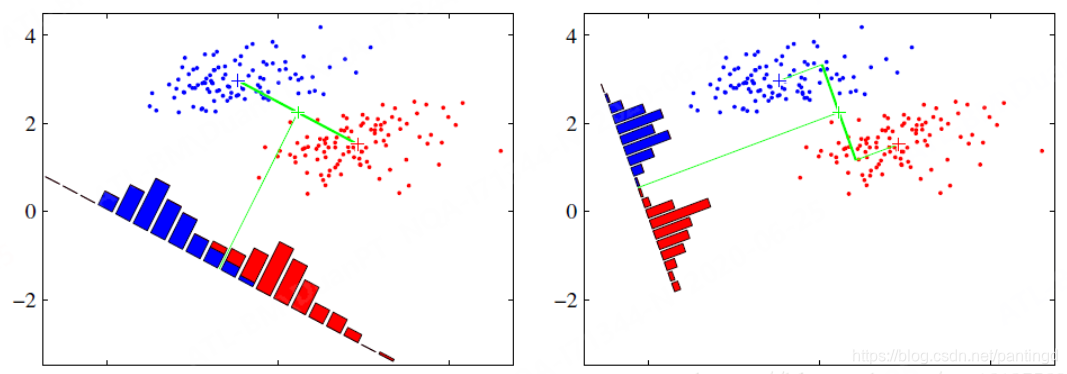

### 2.3 SVD在降维中的几何解释

SVD 可以用于将高维数据降维到低维空间。几何上,SVD 将数据点投影到其奇异向量的子空间上。

* **左奇异向量** 定义了投影方向。

* **奇异值** 决定了投影的长度。

* **右奇异向量** 确定了投影后的数据点在低维空间中的坐标。

通过截断较小的奇异值,我们可以丢弃不重要的信息,从而实现降维。

# 3. SVD在数据降维中的实践应用

### 3.1 主成分分析(PCA)

#### 3.1.1 PCA的原理和算法

主成分分析(PCA)是一种经典的数据降维技术,其基本思想是将原始数据投影到一个新的正交基上,使得投影后的数据具有最大的方差。PCA的算法步骤如下:

1. 对原始数据进行中心化处理,即减去每一列的均值。

2. 计算协方差矩阵。

3. 对协方差矩阵进行特征值分解,得到特征值和特征向量。

4. 选择前k个最大的特征值对应的特征向量作为新的正交基。

5. 将原始数据投影到新的正交基上,得到降维后的数据。

#### 3.1.2 PCA在数据可视化中的应用

PCA在数据可视化中可以用于降维,从而将高维数据可视化在低维空间中。例如,对于一个三维数据,我们可以使用PCA将其降维到二维,然后在二维平面上绘制散点图,从而直观地观察数据的分布。

```matlab

% 导入数据

data = csvread('data.csv');

% 中心化数据

data = data - mean(data);

% 计算协方差矩阵

cov_matrix = cov(data);

% 特征值分解

[eigenvectors, eigenvalues] = eig(cov_matrix);

% 降维到二维

pca_data = data * eigenvectors(:, 1:2);

% 绘制散点图

scatter(pca_data(:, 1), pca_data(:, 2));

```

### 3.2 奇异值截断(SVD截断)

#### 3.2.1 SVD截断的原理和方法

奇异值截断是一种基于SVD的数据降维技术。其原理是将SVD分解中的奇异值进行截断,从而降低数据的维数。SVD截断的方法如下:

1. 对原始数据进行SVD分解,得到奇异值、左奇异向量和右奇异向量。

2. 选择前k个最大的奇异值,并保留对应的奇异向量。

3. 将原始数据投影到截断后的奇异向量上,得到降维后的数据。

#### 3.2.2 SVD截断在图像压缩中的应用

SVD截断在图像压缩中可以用于减少图像的存储空间。其原理是将图像数据进行SVD分解,然后截断部分奇异值,从而降低图像的维数。截断后的图像虽然会损失部分信息,但可以有效地减少图像的大小。

```matlab

% 导入图像

image = imread('image.jpg');

% 转换为灰度图像

image = rgb2gray(image);

% SVD分解

[U, S, V] = svd(image);

% 截断奇异值

S_trunc = S(1:100, 1:100);

% 重构图像

image_reconstructed = U(:, 1:100) * S_trunc * V(:, 1:100)';

% 计算压缩率

compression_ratio = 100 * (1 - size(image_reconstructed, 1) * size(image_reconstructed, 2) / size(image, 1) * size(image, 2));

% 显示压缩后的图像

imshow(image_reconstructed);

```

# 4. SVD在其他领域的应用

### 4.1 自然语言处理(NLP)

#### 4.1.1 SVD在文本相似度计算中的应用

在NLP中,文本相似度计算是衡量两段文本相似程度的重要任务。SVD可以用于将文本表示为低维向量,从而简化文本相似度计算。

具体来说,我们可以对文本进行词袋模型或TF-IDF加权,得到一个文本-词项矩阵。然后,对文本-词项矩阵进行SVD分解,得到文本的奇异值向量。文本的相似度可以通过计算其奇异值向量的余弦相似度来衡量。

```python

import numpy as np

from sklearn.feature_extraction.text import TfidfVectorizer

from sklearn.metrics.pairwise import cosine_similarity

# 文本数据

texts = ["文本1", "文本2", "文本3"]

# TF-IDF加权

vectorizer = TfidfVectorizer()

X = vectorizer.fit_transform(texts)

# SVD分解

U, s, Vh = np.linalg.svd(X, full_matrices=False)

# 计算文本相似度

similarities = cosine_similarity(U)

```

#### 4.1.2 SVD在主题建模中的应用

主题建模是NLP中一项重要的任务,其目标是发现文本中的潜在主题。SVD可以用于将文本表示为低维向量,从而简化主题建模。

具体来说,我们可以对文本进行词袋模型或TF-IDF加权,得到一个文本-词项矩阵。然后,对文本-词项矩阵进行SVD分解,得到文本的奇异值向量。文本的主题可以通过对奇异值向量进行聚类来发现。

```python

import numpy as np

from sklearn.feature_extraction.text import TfidfVectorizer

from sklearn.cluster import KMeans

# 文本数据

texts = ["文本1", "文本2", "文本3"]

# TF-IDF加权

vectorizer = TfidfVectorizer()

X = vectorizer.fit_transform(texts)

# SVD分解

U, s, Vh = np.linalg.svd(X, full_matrices=False)

# 聚类发现主题

kmeans = KMeans(n_clusters=2)

kmeans.fit(U)

```

### 4.2 推荐系统

#### 4.2.1 SVD在协同过滤中的应用

协同过滤是推荐系统中常用的技术,其原理是利用用户对物品的评分来预测用户对其他物品的偏好。SVD可以用于将用户-物品评分矩阵分解为低维矩阵,从而简化协同过滤。

具体来说,我们可以对用户-物品评分矩阵进行SVD分解,得到用户和物品的奇异值向量。用户的偏好可以通过其奇异值向量来预测,物品的相似度可以通过其奇异值向量的余弦相似度来衡量。

```python

import numpy as np

from sklearn.decomposition import TruncatedSVD

# 用户-物品评分矩阵

R = np.array([[5, 3, 0],

[4, 0, 2],

[1, 1, 5]])

# SVD分解

svd = TruncatedSVD(n_components=2)

U, s, Vh = svd.fit_transform(R)

# 预测用户偏好

user_preferences = U.dot(Vh.T)

# 计算物品相似度

item_similarities = cosine_similarity(Vh)

```

#### 4.2.2 SVD在个性化推荐中的应用

个性化推荐是推荐系统中的一项重要任务,其目标是根据用户的历史行为和偏好为用户推荐个性化的物品。SVD可以用于将用户-物品评分矩阵分解为低维矩阵,从而简化个性化推荐。

具体来说,我们可以对用户-物品评分矩阵进行SVD分解,得到用户和物品的奇异值向量。用户的偏好可以通过其奇异值向量来预测,物品的相似度可以通过其奇异值向量的余弦相似度来衡量。然后,我们可以根据用户的偏好和物品的相似度为用户推荐个性化的物品。

```python

import numpy as np

from sklearn.decomposition import TruncatedSVD

# 用户-物品评分矩阵

R = np.array([[5, 3, 0],

[4, 0, 2],

[1, 1, 5]])

# SVD分解

svd = TruncatedSVD(n_components=2)

U, s, Vh = svd.fit_transform(R)

# 预测用户偏好

user_preferences = U.dot(Vh.T)

# 计算物品相似度

item_similarities = cosine_similarity(Vh)

# 推荐个性化物品

recommended_items = []

for user_id in range(len(U)):

# 获取用户偏好

user_preference = user_preferences[user_id]

# 计算用户偏好与物品相似度的乘积

scores = user_preference.dot(item_similarities)

# 排序物品,推荐得分最高的物品

recommended_items.append(np.argsort(scores)[::-1])

```

# 5. SVD的扩展与变体

### 5.1 加权SVD

**5.1.1 加权SVD的原理和算法**

加权SVD是一种对原始SVD进行扩展的变体,它通过引入权重矩阵来赋予不同的数据点不同的重要性。权重矩阵是一个对角矩阵,其对角线元素表示每个数据点的权重。

加权SVD的数学推导与标准SVD类似,但需要引入权重矩阵**W**:

```

A = UΣV^T

WA = (UW)ΣV^T

```

其中,**W**是权重矩阵,**U**、**Σ**和**V**是加权SVD的左奇异向量、奇异值和右奇异向量。

加权SVD的算法与标准SVD类似,但需要对数据矩阵**A**进行加权处理:

1. 计算加权数据矩阵**WA**。

2. 对**WA**进行SVD分解,得到**U**、**Σ**和**V**。

3. 计算原始数据矩阵**A**的奇异值分解:**A = UΣV^T**。

**5.1.2 加权SVD在异常值检测中的应用**

加权SVD在异常值检测中具有重要应用。通过赋予异常值较低的权重,加权SVD可以有效地将异常值从数据中分离出来。

具体来说,在异常值检测中,权重矩阵**W**的元素可以根据数据点的距离度量或其他指标进行设置。例如,对于距离平均值较远的点,可以赋予较低的权重。

通过加权SVD,异常值将被映射到奇异值较小的奇异向量中,从而可以将其与正常数据区分开来。

### 5.2 随机SVD

**5.2.1 随机SVD的原理和算法**

随机SVD是一种近似SVD的算法,它通过使用随机投影矩阵来降低计算复杂度。随机投影矩阵是一个随机生成的矩阵,其行数远小于原始数据矩阵的行数。

随机SVD的数学推导如下:

```

A = UΣV^T

PA = (PU)ΣV^T

```

其中,**P**是随机投影矩阵,**PU**是近似左奇异向量。

随机SVD的算法如下:

1. 生成一个随机投影矩阵**P**。

2. 计算**PA**。

3. 对**PA**进行SVD分解,得到**PU**、**Σ**和**V**。

4. 计算近似左奇异向量**U = PU**。

**5.2.2 随机SVD在大数据降维中的应用**

随机SVD在大数据降维中具有重要应用。由于其计算复杂度较低,随机SVD可以有效地处理海量数据集的降维任务。

在实际应用中,随机SVD可以用于以下场景:

* **大规模文本数据降维:**随机SVD可以用于将大规模文本数据降维到较低维度的语义空间,从而提高文本处理效率。

* **图像数据降维:**随机SVD可以用于将高维图像数据降维到较低维度的特征空间,从而减少图像处理的计算成本。

* **基因表达数据降维:**随机SVD可以用于将高维基因表达数据降维到较低维度的生物学特征空间,从而促进基因表达模式的分析。

# 6. SVD在MATLAB中的实现与案例分析

### 6.1 SVD函数的使用

MATLAB提供了`svd`函数来计算矩阵的奇异值分解。其语法如下:

```

[U, S, V] = svd(A)

```

其中:

* `A`:输入矩阵

* `U`:左奇异向量矩阵

* `S`:奇异值矩阵,对角元素为矩阵`A`的奇异值

* `V`:右奇异向量矩阵

### 6.2 数据降维的MATLAB案例

**主成分分析(PCA)**

```

% 导入数据

data = importdata('data.csv');

% 中心化数据

data = data - mean(data);

% 计算协方差矩阵

covariance_matrix = cov(data);

% 计算奇异值分解

[U, S, V] = svd(covariance_matrix);

% 获取主成分

principal_components = U(:, 1:2);

% 将数据投影到主成分空间

projected_data = data * principal_components;

```

**奇异值截断(SVD截断)**

```

% 导入图像

image = imread('image.jpg');

% 将图像转换为灰度图

gray_image = rgb2gray(image);

% 计算奇异值分解

[U, S, V] = svd(gray_image);

% 截断奇异值

S_truncated = S;

S_truncated(3:end, 3:end) = 0;

% 重构图像

reconstructed_image = U * S_truncated * V';

% 显示原始图像和重构图像

subplot(1, 2, 1);

imshow(image);

title('原始图像');

subplot(1, 2, 2);

imshow(reconstructed_image);

title('重构图像');

```

### 6.3 SVD在其他领域应用的MATLAB案例

**自然语言处理(NLP)**

**文本相似度计算**

```

% 导入文本数据

documents = {'document1.txt', 'document2.txt', 'document3.txt'};

% 创建词袋模型

bag_of_words = createBagOfWordsModel(documents);

% 计算词频-逆向文档频率(TF-IDF)

tfidf_matrix = tfidf(bag_of_words);

% 计算奇异值分解

[U, S, V] = svd(tfidf_matrix);

% 计算文本相似度

similarity_matrix = U * U';

```

**主题建模**

```

% 导入文本数据

documents = {'document1.txt', 'document2.txt', 'document3.txt'};

% 创建文档-主题矩阵

document_topic_matrix = createDocumentTopicMatrix(documents);

% 计算奇异值分解

[U, S, V] = svd(document_topic_matrix);

% 获取主题

topics = U(:, 1:2);

```

0

0