PyTorch卷积神经网络:CNN内部工作原理详解

发布时间: 2024-09-30 12:04:09 阅读量: 31 订阅数: 40

# 1. PyTorch卷积神经网络概述

## 简介

随着深度学习的不断进步,卷积神经网络(CNN)已成为图像识别和处理领域的核心技术。PyTorch作为目前流行的一种深度学习框架,为研究者和开发者提供了灵活而强大的工具来构建和部署CNN模型。本章旨在对PyTorch中的CNN进行概述,为读者打下坚实的基础,理解其背后的原理和应用。

## CNN的应用领域

CNN在多个领域展示出了卓越的性能,包括但不限于图像识别、视频分析、自然语言处理和医疗影像分析。通过利用其强大的特征提取能力,CNN能够自动学习数据的层次性结构,极大地减少了对手工特征工程的依赖。

## PyTorch与CNN

PyTorch具备动态计算图的优势,使其在设计和实验新型CNN架构时更加直观和高效。我们将在后续章节中逐步深入学习PyTorch如何简化CNN的构建和训练过程,以及如何利用这些模型在实际问题中取得突破。

# 2. 卷积神经网络的理论基础

## 2.1 神经网络的基本概念

神经网络作为深度学习的核心,是理解和实现卷积神经网络的基础。本节将详细介绍神经元和激活函数、前馈神经网络与反向传播算法。

### 2.1.1 神经元和激活函数

神经元是神经网络的基本单元,可以类比于人脑的神经细胞。一个简单的神经元接收输入信号,进行加权求和处理,随后应用一个非线性激活函数来产生输出。激活函数的选择对模型的性能至关重要,它能够引入非线性,使得网络能够学习复杂的函数映射。

常见的激活函数包括:

- Sigmoid函数,其输出范围是(0, 1),但存在梯度消失问题,不常用于深层网络。

- Tanh函数,输出范围是(-1, 1),性能优于Sigmoid函数,但同样存在梯度消失问题。

- ReLU(Rectified Linear Unit)函数,输出为max(0, x),是目前最常用的一种激活函数,因为其计算简单且在许多情况下效果良好。

```python

import torch

import torch.nn as nn

# 定义一个使用ReLU激活函数的神经元

class Neuron(nn.Module):

def __init__(self):

super(Neuron, self).__init__()

self.linear = nn.Linear(in_features=2, out_features=1) # 输入特征数为2,输出特征数为1

self.relu = nn.ReLU() # 使用ReLU作为激活函数

def forward(self, x):

x = self.linear(x)

x = self.relu(x)

return x

```

### 2.1.2 前馈神经网络与反向传播算法

前馈神经网络是多层神经元按照分层的方式连接,信息从前向后单向流动,没有反馈或回路。前馈神经网络中,每层的神经元只与上一层的神经元相连,最底层为输入层,顶层为输出层。

反向传播算法是训练神经网络的核心算法之一。通过计算损失函数相对于网络参数的梯度,反向传播算法能够有效地调整网络权重以最小化损失。其主要步骤包括前向传播、计算损失、反向传播梯度以及权重更新。

```python

def forward_pass(x, model):

# 前向传播

outputs = model(x)

return outputs

def backward_pass(loss, model):

# 计算损失函数相对于模型参数的梯度

loss.backward()

# 更新权重参数

with torch.no_grad():

for param in model.parameters():

param -= learning_rate * param.grad

```

## 2.2 卷积层的工作原理

### 2.2.1 卷积运算与卷积核

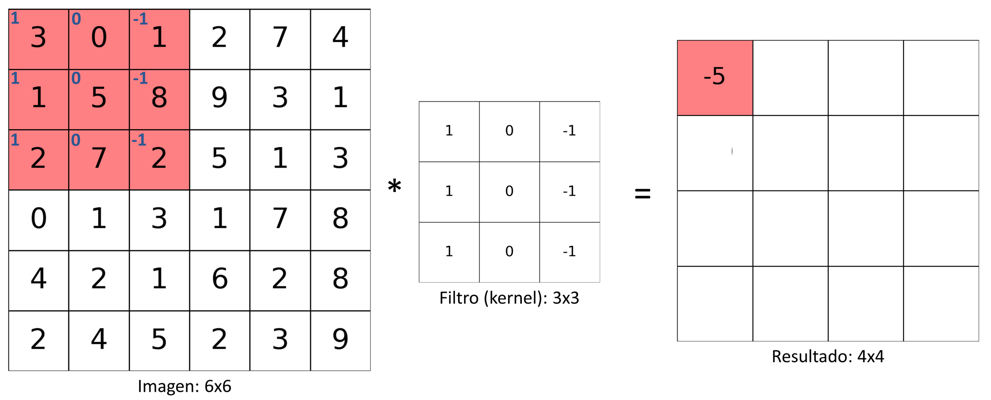

卷积层是卷积神经网络的核心组件之一,负责提取输入数据(如图像)的特征。卷积操作通过将卷积核(滤波器)滑动覆盖输入数据的每个局部区域,执行逐元素乘法和求和操作,从而得到输出特征图。

卷积核的大小、步长和填充方式直接影响输出特征图的尺寸和网络的感受野。常用的小卷积核能够捕获图像中的局部模式,如边缘和角点,更大的卷积核则能够捕获更为复杂的特征。

```python

# 一维卷积操作

import torch.nn.functional as F

x = torch.tensor([1.0, 2.0, 3.0, 4.0], dtype=torch.float32).view(1, 1, 4, 1)

conv_filter = torch.tensor([1.0, -1.0], dtype=torch.float32).view(1, 1, 2, 1)

# 应用一维卷积

output = F.conv1d(x, conv_filter, stride=1, padding=0)

```

### 2.2.2 特征图和感受野的概念

特征图是卷积操作的输出,它捕捉到了输入数据在空间维度上的特征。在图像处理中,特征图代表了图像的不同抽象层次,低层特征图可能代表了边缘和纹理,高层特征图则代表了更复杂的形状和对象部分。

感受野描述了卷积核能够看到的输入数据的空间区域大小,是评估卷积网络性能和感受力的一个重要指标。一个较大的感受野能够捕捉更大的图像区域,有利于提取全局信息。

```mermaid

graph LR

A[输入图像] -->|卷积核1| B[特征图1]

A -->|卷积核2| C[特征图2]

B -->|卷积核3| D[特征图3]

C -->|卷积核4| D

D -->|卷积核5| E[最终特征图]

style E fill:#f9f,stroke:#333,stroke-width:4px

```

## 2.3 池化层与全连接层的作用

### 2.3.1 池化层的目的和类型

池化层( pooling layer)的主要目的是降低特征图的维度,减少参数数量和计算量,同时保持特征图的抽象层次。池化层通过在特征图上应用局部聚合函数(如最大池化或平均池化)实现下采样。

最大池化选取给定窗口内的最大值作为输出,保留了最显著的特征,而平均池化则计算窗口内所有值的平均,能够降低特征图的方差,使模型对输入的微小变化更加稳定。

```python

# 最大池化操作

max_pooling = nn.MaxPool2d(kernel_size=2, stride=2, padding=0)

x = torch.rand(1, 1, 4, 4) # 随机生成的特征图

output = max_pooling(x)

```

### 2.3.2 全连接层的结构与功能

全连接层(fully connected layer,简称FC层)位于卷积神经网络的末端,负责将提取到的特征转换为最终的输出,例如分类任务中的类别预测或回归任务中的数值预测。全连接层对输入的每个特征都进行加权求和,并通过激活函数产生输出。

全连接层的权重矩阵与偏置项在模型训练过程中不断更新,以确保网络能够学习到有效的特征表示和决策边界。

```python

# 全连接层操作

fc_layer = nn.Linear(in_features=10, out_features=2) # 输入10个特征,输出2个预测结果

x = torch.rand(1, 10) # 随机生成的输入特征向量

output = fc_layer(x)

```

## 2.3.2 全连接层的结构与功能

全连接层(fully connected layer,简称FC层)位于卷积神经网络的末端,负责将提取到的特征转换为最终的输出,例如分类任务中的类别预测或回归任务中的数值预测。全连接层对输入的每个特征都进行加权求和,并通过激活函数产生输出。

全连接层的权重矩阵与偏置项在模型训练过程中不断更新,以确保网络能够学习到有效的特征表示和决策边界。

```python

import torch

import torch.nn as nn

class FullyConnectedLayer(nn.Module):

def __init__(self, input_size, output_size):

super(FullyConnectedLayer, self).__init__()

self.fc = nn.Linear(input_size, output_size)

def forward(self, x):

x = self.fc(x)

return x

# 假设我们的输入数据有10个特征,输出我们想预测的类别有2个

input_size = 10

output_size = 2

# 创建全连接层实例

model = FullyConnectedLayer(input_size, output_size)

# 假设我们有一批数据

batch_size = 5

x = torch.randn(batch_size, input_size) # 随机生成一个batch的数据

# 前向传播得到输出

output = model(x)

```

以上代码定义了一个简单的全连接层,其中`input_size`为输入数据的特征数量,`output_size`为输出数量。在实际应用中,输入数据会通过`forward`方法来进行前向传播,最终得到网络的预测输出。

# 3. PyTorch中的CNN实现

PyTorch是一个强大的深度学习框架,它提供了一种简单易用的方式去构建和训练复杂的神经网络。本章节深入介绍了如何使用PyTorch实现卷积神经网络(CNN),包括网络的基本构建、训练以及优化等。

## 3.1 PyTorch基础和张量操作

### 3.1.1 PyTorch简介与安装

PyTorch是由Facebook的人工智能研究小组开发的开源机器学习库。它广泛应用于计算机视觉、自然语言处理等众多深度学习领域。其动态计算图的设计让构建复杂网络模型变得灵活方便,特别适合研究人员和开发人员进行实验和原型设计。

安装PyTorch非常简单,可以通过命令行直接安装。例如,在Linux系统中,可以使用如下命令安装PyTorch:

```bash

pip3 install torch torchvision

```

### 3.1.2 张量的创建和基本操作

在PyTorch中,张量是多维数组的实现,是进行数值计算的基础。张量的操作与NumPy数组类似,但张量可以利用GPU进行加速。

创建一个张量的示例代码如下:

```python

import torch

# 创建一个未初始化的张量

x = torch.empty(5, 3)

print(x)

# 创建一个初始化为0的张量

x = torch.zeros(5, 3)

print(x)

# 创建一个随机初始化的张量

x = torch.randn(5, 3)

print(x)

```

除了创建张量,PyTorch还提供了丰富的操作来处理张量,如索引、切片、数学运算等。例如:

```python

import torch

x = torch.tensor([5.5, 3])

y = torch.tensor([2.2, 1])

# 张量的加法

z = x + y

print(z)

# 张量的乘法

z = x * y

print(z)

```

## 3.2 构建卷积神经网络模型

### 3.2.1 定义CNN层和模型结构

在PyTorch中,构建一个CNN模型通常涉及定义一系列的层。典型的CNN包含卷

0

0