PyTorch正则化技术:防止过拟合的有效策略

发布时间: 2024-09-30 11:57:16 阅读量: 39 订阅数: 33

# 1. PyTorch正则化技术简介

正则化技术是机器学习中防止过拟合的重要手段,在深度学习领域尤其是PyTorch框架中,正则化技术的应用尤为广泛。本章将对PyTorch中的正则化技术进行简介,并为后续章节的深入讨论提供一个基础概念。我们将从正则化技术的基本概念开始,探究它们在PyTorch中的实现,并尝试理解这些技术如何帮助改善模型的泛化能力。

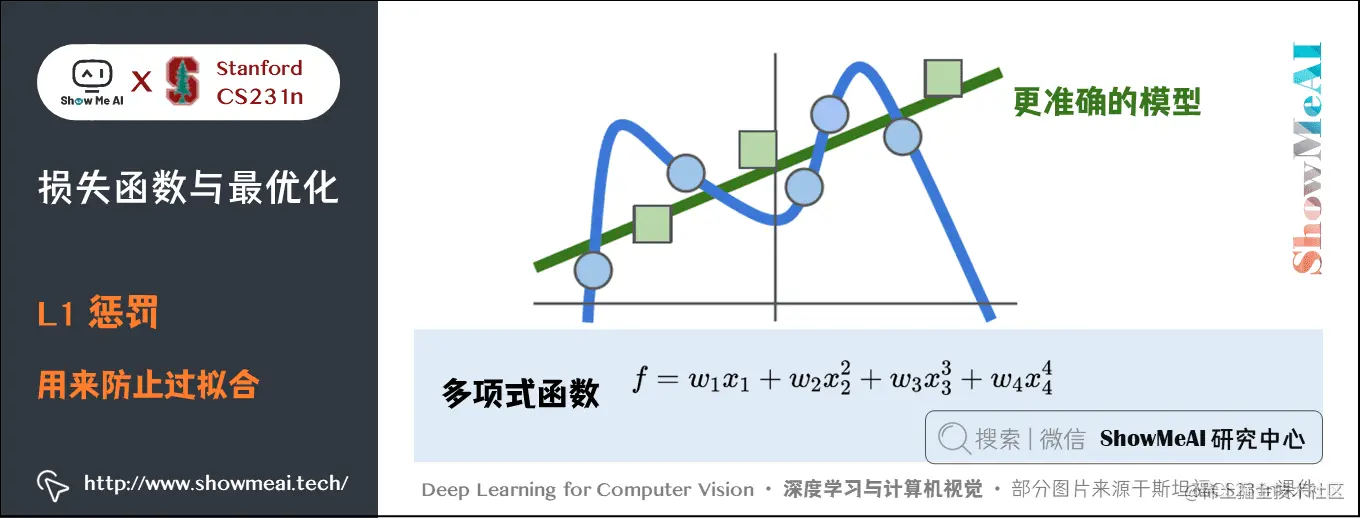

## 1.1 正则化技术的必要性

在训练深度神经网络时,模型往往会过度依赖于训练数据,导致在新的、未见过的数据上性能下降,这就是过拟合现象。为了克服过拟合,引入了正则化技术,这些技术通过惩罚模型复杂度,促使模型学习更简洁的特征,提高模型在实际应用中的泛化能力。

```python

# 示例:在PyTorch中添加L2正则化项

import torch

import torch.nn as nn

# 假设有一个简单的线性模型

model = nn.Linear(in_features=10, out_features=1, bias=True)

# 定义损失函数和优化器

criterion = nn.MSELoss()

optimizer = torch.optim.SGD(model.parameters(), lr=0.01)

# 在训练循环中添加L2正则化项

def train(model, criterion, optimizer, inputs, targets):

optimizer.zero_grad()

outputs = model(inputs)

loss = criterion(outputs, targets)

# 添加L2正则化项,alpha为正则化强度

loss += alpha * torch.sum(torch.square(model.weight))

loss.backward()

optimizer.step()

```

## 1.2 PyTorch中的正则化支持

PyTorch提供了一系列工具和机制来支持正则化技术。通过内置的优化器参数控制,比如`weight_decay`来施加L2正则化,或在模型定义时手动添加正则化层如`nn.Dropout`。这些方法使得开发者可以方便地应用正则化策略,优化模型的训练效果。

## 1.3 正则化技术的应用场景

正则化技术的应用非常广泛,从基础的线性模型到复杂的深度学习模型,都可以看到正则化的身影。在不同领域,如图像识别、自然语言处理等,正则化技术都在帮助模型抵御过拟合,提高模型的稳定性和准确性。

本文档接下来的章节将详细展开讨论正则化技术的理论基础、实践应用、以及与其他技术结合时的深入探索,并最终总结正则化技术在PyTorch中的作用,展望其未来的发展。

# 2. 理论基础与正则化方法

### 过拟合现象与原因分析

#### 过拟合定义

在机器学习中,过拟合(Overfitting)是指模型过于复杂,以至于它捕捉到了训练数据中的噪声和细节,从而失去了泛化能力。一个过拟合的模型可能在训练集上表现得非常好,但在新的、未见过的数据上表现较差。这主要是因为模型学习了训练数据中的特定特征,而不是背后的潜在规律。

#### 过拟合的影响

过拟合的影响是多方面的。首先,它导致模型不能有效地推广到新的数据上,即在测试集或实际应用中的表现远不如训练时的表现。其次,过拟合的模型复杂度高,计算成本也相对较高。最后,过拟合还会增加模型的调试难度,因为模型的预测结果往往波动较大,难以解释和优化。

### 正则化技术的分类

#### L1和L2正则化

L1正则化(也称为Lasso正则化)和L2正则化(也称为Ridge正则化)是两种最常见的正则化技术。它们通过在损失函数中添加一个惩罚项来防止过拟合。L1正则化倾向于生成稀疏的模型权重,而L2正则化则倾向于使权重值平滑,限制它们的大小。

- L1正则化的目标是最小化以下目标函数:

$$ J(w) = \frac{1}{2n} \sum_{i=1}^{n} (w \cdot x^{(i)} - y^{(i)})^2 + \lambda \sum_{j=1}^{m} |w_j| $$

其中,$w$ 是权重向量,$x^{(i)}$ 和 $y^{(i)}$ 分别是第 $i$ 个训练样本的特征和标签,$n$ 是样本数量,$m$ 是特征数量,$\lambda$ 是正则化系数。

- L2正则化的目标是最小化以下目标函数:

$$ J(w) = \frac{1}{2n} \sum_{i=1}^{n} (w \cdot x^{(i)} - y^{(i)})^2 + \frac{\lambda}{2} \sum_{j=1}^{m} w_j^2 $$

#### Dropout正则化

Dropout是一种在训练过程中随机“丢弃”网络中的一些节点的方法,以防止节点之间的共适应性,即网络的某些部分过分依赖于其他部分。在每次训练迭代中,网络中的一组节点将被随机选择并临时移除,这意味着模型需要在没有这些节点的情况下学习。

#### 数据增强

数据增强是一种通过人为地扩展训练数据集来提高模型泛化能力的技术。它通过对原始数据进行各种变换(如旋转、缩放、裁剪等)来生成新的数据样本。数据增强可以显著提高模型的鲁棒性,尤其是在数据集较小的情况下。

### 正则化背后的数学原理

#### 最优性理论

最优性理论关注的是找到一个模型,使得在训练数据上损失函数的值最小化的同时,也具有良好的泛化性能。在数学上,这通常转化为一个优化问题,即在寻找参数的最优解时,需要平衡模型的复杂度和拟合训练数据的能力。

#### 泛化误差界限

泛化误差界限给出了模型在未见数据上的预测误差的上限。这个界限可以帮助我们理解模型的

0

0