掌握Reduce端数据合并:MapReduce中的WordCount技巧解析

mapreduce的wordCount案例

1. MapReduce框架基础与WordCount原理

MapReduce是一个分布式计算框架,由Google提出,用于简化大规模数据集的并行运算。它通过两个关键的操作—Map和Reduce,使得开发者能够将复杂的数据处理任务转化为相对简单的处理逻辑。MapReduce框架隐藏了许多底层的复杂性,比如任务调度、容错处理和数据分布等,让开发者只需关注业务逻辑。

WordCount应用的原理

WordCount是MapReduce框架的一个经典入门案例,其核心目的是统计文本文件中每个单词出现的次数。WordCount程序主要分为两个阶段:Map阶段和Reduce阶段。Map阶段的任务是读取输入的文本文件,对文件中的单词进行分割,并输出形如(word, 1)的键值对。Reduce阶段则负责汇总相同键(word)的值(出现次数),最终得到每个单词的总数。

- // MapReduce的伪代码结构

- map(String key, String value):

- // key: document name

- // value: document contents

- for each word w in value:

- EmitIntermediate(w, "1")

- reduce(String key, Iterator values):

- // key: a word

- // values: a list of counts

- int result = 0

- for each v in values:

- result += ParseInt(v)

- Emit(AsString(result))

通过以上流程,MapReduce不仅实现文本单词的计数功能,而且还展示了如何在大数据环境下进行有效的并行计算,从而提供高效率的计算结果。接下来的章节将详细介绍Map阶段和Reduce阶段的深入工作原理和优化技巧。

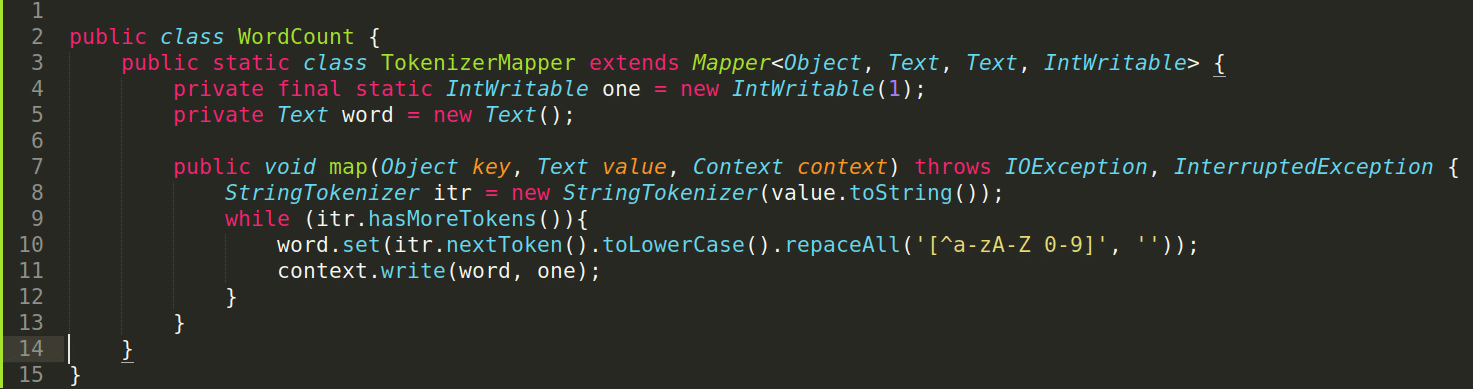

2. 深入理解WordCount的Map阶段处理

2.1 Map函数的原理与作用

2.1.1 Map任务的数据处理流程

在MapReduce编程模型中,Map阶段是数据处理的起始环节,它的主要职责是读取输入数据,并对这些数据进行预处理,然后输出一系列的键值对(Key-Value Pairs)。在WordCount案例中,Map任务的主要工作是处理文本数据,识别其中的单词,并将每个单词映射为键值对,其中键(Key)是单词本身,值(Value)是数字1,表示该单词在文本中出现了一次。

Map任务的数据处理流程可以分解为以下几个步骤:

-

读取输入数据:Map任务开始时,会从指定的输入格式化器读取数据。对于文本文件,输入格式化器通常是

TextInputFormat,它将文件切分成一行行的文本。 -

解析文本:Map函数针对每行文本进行解析,通常将文本按空白字符(如空格、制表符等)分割成单词。

-

输出键值对:对于分割出的每个单词,Map函数输出一个键值对,键是单词,值是数字1,表示该单词的一个实例。

-

中间文件:Map任务完成后,生成的键值对会被写入到中间文件中。这些中间文件包含了需要传递给Reduce阶段的数据。

2.1.2 关键概念:键值对(Key-Value Pairs)

键值对是MapReduce处理数据时的基础概念。在Map阶段,键值对的生成至关重要,因为它定义了后续操作的基础数据结构。在WordCount中,键是单词本身,值是计数,即1。

MapReduce框架使用键值对作为数据交换的媒介,它允许Map任务生成的中间数据被组织成可被Reduce任务高效处理的形式。Map函数输出的每个键值对通常遵循以下规则:

- 键(Key):在WordCount中,键是单词。键是一个可排序的结构,它将数据划分为不同的组,以便Reduce阶段进行归并操作。

- 值(Value):在WordCount中,值是1。值代表了与键相关的某个计数或数据,表示某种数量或者度量。

在Hadoop中,键值对对象通常是由WritableComparable接口实现的,这允许键值对在MapReduce作业中被序列化和反序列化,以便在集群中传输和存储。

2.2 自定义Map函数实战

2.2.1 编写Map函数的步骤和要点

自定义Map函数是MapReduce编程中的关键部分,它需要遵循特定的接口规范,并实现特定的方法。在Java中,Map函数通常实现自Mapper类。下面是一些编写Map函数的步骤和要点:

- 继承Mapper类:定义一个继承自

org.apache.hadoop.mapreduce.Mapper的类,并指定泛型参数,这些参数分别对应于输入的键值类型和输出的键值类型。

- public class MyMapper extends Mapper<LongWritable, Text, Text, IntWritable> {

- // 方法实现...

- }

- 实现map方法:在自定义的Mapper类中,重写

map方法,该方法是Map函数的核心。map方法会接收输入的键值对,然后进行处理,输出新的键值对。

- @Override

- public void map(LongWritable key, Text value, Context context) throws IOException, InterruptedException {

- // 处理逻辑...

- context.write(new Text(word), new IntWritable(1));

- }

-

配置Mapper类:在MapReduce作业配置中,需要指定Mapper类,以便框架知道哪个类包含了Map函数。

-

键值对输出:

context.write()是输出键值对的标准方式,它会将键值对写入到输出收集器中,这些键值对是中间输出数据。

2.2.2 对输入数据的格式化与初步处理

在Map阶段,对输入数据的格式化和初步处理是至关重要的。这通常涉及到以下步骤:

-

读取原始数据:从输入格式化器读取原始数据块。

-

解析数据块:将读取的数据块转换成可操作的数据格式,这可能涉及到解析文本数据、解码二进制数据等。

-

数据清洗:如果输入数据包含不需要的元素,如噪音数据或者非目标数据,需要进行清洗。

-

数据转换:将数据转换成适合后续处理的形式,例如将字符串转换成小写,以便单词统计不区分大小写。

下面是一个简单的Map任务实现示例代码,包括了对输入数据的初步处理:

- @Override

- public void map(LongWritable key, Text value, Context context) throws IOException, InterruptedException {

- // 分割文本为单词数组

- String[] words = value.toString().split("\\s+");

- // 遍历单词数组

- for (String word : words) {

- // 输出键值对,键是单词,值是1

- context.write(new Text(word.toLowerCase()), new IntWritable(1));

- }

- }

在这个例子中,我们假设输入数据是按行分隔的文本文件。代码中使用了split()函数来分割每行文本为单词数组,并通过toLowerCase()方法将单词转换为小写,以便统计时忽略大小写的差异。最后,每个单词都以键值对的形式输出到MapReduce框架中。

2.3 Map阶段的数据合并技巧

2.3.1 数据去重与聚合方法

在处理大量数据时,Map阶段往往会产生大量重复的键值对。为了减少网络传输的数据量和提高Reduce阶段处理的效率,需要在Map阶段就开始进行数据去重与聚合。

一个常用的数据去重与聚合方法是使用Combiner,它在Map阶段后、Shuffle之前进行局部合并。Combiner可以看作是Reduce任务的轻量版本,它对Map任务输出的中间结果进行局部合并,从而减少传输到Reduce任务的数据量。

下面是一个简单的Combiner函数实现示例代码: