性能调优专家:针对WordCount案例的MapReduce参数优化策略

发布时间: 2024-11-01 06:25:51 阅读量: 13 订阅数: 17

# 1. MapReduce与WordCount基础

MapReduce是一个编程模型,用于处理大规模数据集的并行运算,它在大规模数据处理中扮演着关键角色。在这一章中,我们将揭开MapReduce的神秘面纱,并通过一个经典的例子——WordCount来介绍其基础使用。

## 1.1 MapReduce简介

MapReduce模型由Google提出,Hadoop将其开源实现,广泛用于大数据处理。MapReduce把任务分解成两个主要阶段:Map阶段和Reduce阶段。Map阶段处理输入数据并产生中间键值对,而Reduce阶段则将具有相同键的中间值合并。

## 1.2 WordCount案例

WordCount是MapReduce最常见的入门案例,它计算文本文件中每个单词出现的频率。这个过程展示了MapReduce如何将一个复杂任务分解成可并行处理的多个子任务,然后汇总结果。

## 1.3 WordCount实现概述

在WordCount的实现中,Map函数将每行文本分割成单词,并输出中间键值对,其中键是单词,值是1。Reduce函数则对所有相同的键值进行汇总,累加值来计算每个单词的总出现次数。

以下是一个WordCount MapReduce任务的简单伪代码示例:

```java

// Map阶段

map(String key, String value):

// key: document name

// value: document contents

for each word w in value:

EmitIntermediate(w, "1");

// Reduce阶段

reduce(String key, Iterator values):

// key: a word

// values: a list of counts

int result = 0;

for each v in values:

result += ParseInt(v);

Emit(key, result);

```

以上代码展示了WordCount的核心逻辑,通过Map和Reduce两个函数的组合,实现了对大规模文本数据的处理。在后续章节中,我们将深入探讨MapReduce的工作原理和性能优化。

# 2. ```

# 第二章:深入理解MapReduce性能瓶颈

## 2.1 MapReduce的工作原理

### 2.1.1 MapReduce作业流程

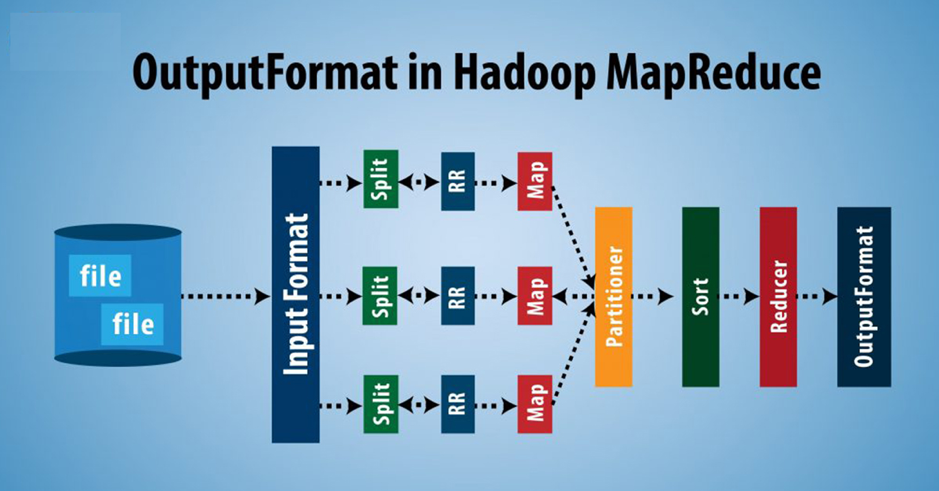

MapReduce框架允许开发者通过编写Map和Reduce函数来处理大量数据。作业流程包括几个阶段:输入数据被切分成多个分片(splits),每个分片由一个Map任务处理。Map任务的输出是键值对(key-value pairs),这些键值对通过shuffle过程被分发到对应的Reduce任务。Reduce任务接收到的键值对按键排序后进行归并操作,最终输出结果存储在HDFS或其他存储系统中。

```mermaid

graph LR

A[开始] --> B[输入数据切片]

B --> C[Map阶段]

C --> D[Shuffle]

D --> E[Reduce阶段]

E --> F[输出结果]

F --> G[结束]

```

### 2.1.2 Map和Reduce阶段的性能因素

Map阶段性能主要受限于单个Map任务处理数据的速度,它受到CPU计算能力、内存使用效率和本地磁盘I/O速度的影响。Reduce阶段的性能瓶颈主要来自于数据倾斜(data skew),也就是数据在各个Reduce任务间分布不均,造成某些任务处理时间远超其他任务。

## 2.2 WordCount案例分析

### 2.2.1 WordCount的实现逻辑

WordCount程序的主要逻辑是在Map阶段对输入的文本文件中的单词进行计数,在Reduce阶段则对所有Map任务的输出进行合并。具体来说,Map函数将每个单词转换成一个键值对(word, 1),然后根据单词进行分组。Reduce函数负责将相同的单词对应的所有值求和,得到单词的最终计数。

```java

public static class TokenizerMapper

extends Mapper<Object, Text, Text, IntWritable>{

private final static IntWritable one = new IntWritable(1);

private Text word = new Text();

public void map(Object key, Text value, Context context

) throws IOException, InterruptedException {

StringTokenizer itr = new StringTokenizer(value.toString());

while (itr.hasMoreTokens()) {

word.set(itr.nextToken());

context.write(word, one);

}

}

}

public static class IntSumReducer

extends Reducer<Text,IntWritable,Text,IntWritable> {

private IntWritable result = new IntWritable();

public void reduce(Text key, Iterable<IntWritable> values,

Context context

) throws IOException, InterruptedException {

int sum = 0;

for (IntWritable val : values) {

sum += val.get();

}

result.set(sum);

context.write(key, result);

}

}

```

### 2.2.2 WordCount性能评估

评估WordCount程序性能,一般通过执行时间、CPU和内存使用情况来进行。可以通过Hadoop自带的计时器获得执行时间,使用操作系统工具如top或jstack进行资源监控。性能调优的目标是减少Map和Reduce的执行时间,降低资源消耗,提高集群资源利用率。

## 总结

在本章中,我们深入探讨了MapReduce的工作原理以及WordCount案例的实现和性能评估方法。这些知识为我们后续的性能调优打下了坚实的基础。

```

注意:以上内容应视为第2章“深入理解MapRedu

0

0