【进阶篇】高效爬虫调度与任务队列:使用Celery实现定时任务调度

Celery实现异步任务、定时任务、异常告警通知的CeleryTask完整项目.zip

1. 爬虫调度概述**

爬虫调度是管理和协调爬虫任务的重要环节,它负责任务的分配、执行和监控。一个高效的爬虫调度器可以显著提高爬虫的效率和可靠性。

爬虫调度器通常采用任务队列的方式实现。任务队列是一种数据结构,用于存储待处理的任务。爬虫调度器将爬虫任务分解成一个个独立的任务,并将其放入任务队列中。任务队列负责管理任务的顺序和优先级,并将其分配给爬虫进程执行。

2. Celery任务队列

2.1 Celery基本原理

2.1.1 任务队列的概念和作用

任务队列是一种分布式系统,用于管理和执行异步任务。它允许应用程序将耗时的任务从主进程中卸载,从而提高应用程序的响应能力和吞吐量。Celery是一个流行的Python任务队列,它提供了强大的功能和可扩展性,使其非常适合于爬虫调度。

2.1.2 Celery的架构和组件

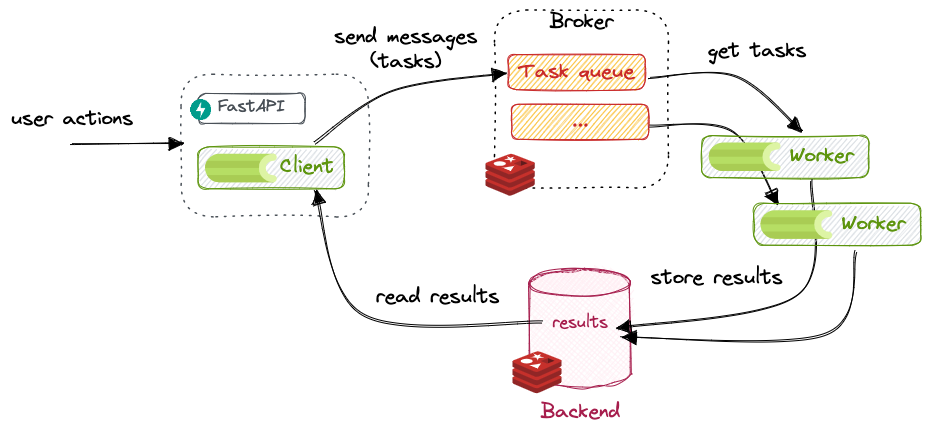

Celery的架构由以下组件组成:

- **Broker:**负责接收和存储任务消息。

- **Worker:**负责执行任务。

- **Backend:**负责持久化任务状态和结果。

Celery使用消息传递机制在Broker和Worker之间进行通信。当一个任务被创建时,它会被发送到Broker。Worker从Broker获取任务并执行它们。任务的状态和结果会被存储在Backend中。

2.2 Celery任务调度

2.2.1 任务创建和执行

在Celery中,任务被定义为Python函数或类。要创建任务,可以使用@task装饰器。例如:

- @task

- def crawl_page(url):

- # 爬取页面并解析内容

- pass

要执行任务,可以使用apply_async()方法。该方法接受任务名称和参数作为参数。例如:

- crawl_page.apply_async(args=[url])

2.2.2 定时任务调度

Celery支持定时任务调度。可以使用schedule_recurring()方法安排任务在指定时间间隔内重复执行。例如:

- crawl_page.schedule_recurring(interval=600) # 每10分钟爬取一次页面

2.2.3 任务监控和管理

Celery提供了强大的任务监控和管理功能。可以使用celery inspect命令查看任务状态、重试次数和执行时间等信息。还可以使用celery control命令停止、启动或终止Worker。

代码示例

以下代码示例演示了如何使用Celery创建一个爬虫任务:

- from celery import Celery

- # 创建Celery实例

- app = Celery('crawler')

- # 定义爬虫任务

- @app.task

- def crawl_page(url):

- # 爬取页面并解析内容

- pass

- # 执行爬虫任务

- crawl_page.apply_async(args=[url])

代码逻辑分析

Celery('crawler'):创建Celery实例,指定名称为’crawler’。@app.task:将crawl_page函数装饰为Celery任务。crawl_page.apply_async(args=[url]):执行爬虫任务,并将url作为参数传递。