【进阶篇】高级爬虫数据处理与清洗技术:使用Spark进行大数据清洗和处理

发布时间: 2024-06-25 01:37:49 阅读量: 90 订阅数: 171

# 1. 高级爬虫数据处理概述**

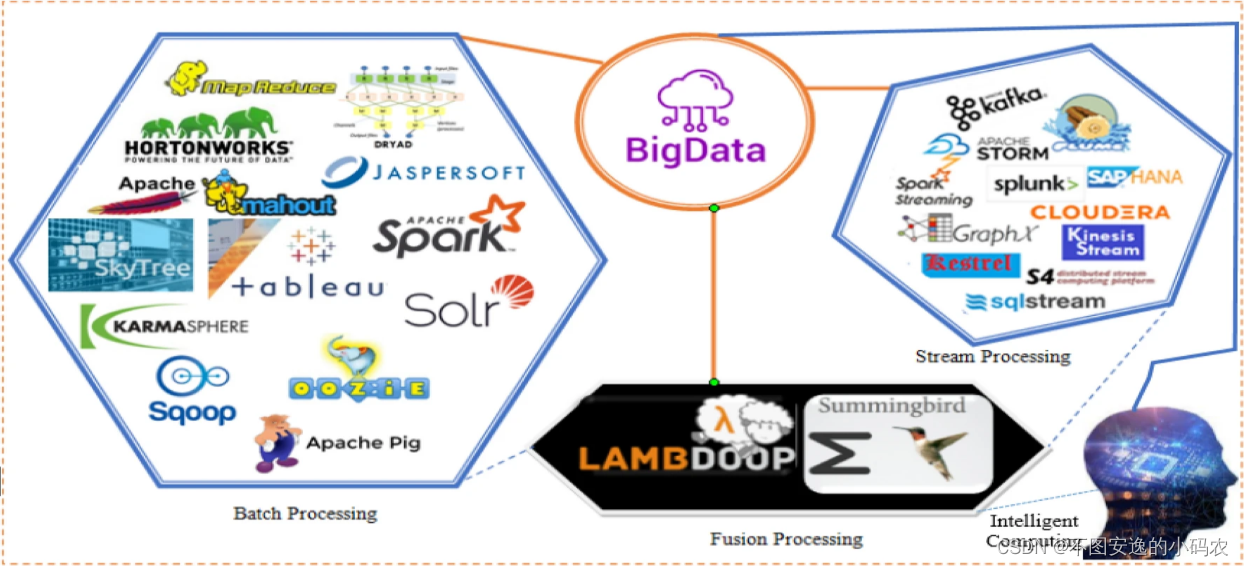

爬虫数据处理是IT行业中一项至关重要的任务,涉及从各种来源收集、清理和分析数据。随着数据量的不断增长,传统的数据处理方法已无法满足需求,高级爬虫数据处理技术应运而生。

高级爬虫数据处理利用大数据技术,如Spark和Hadoop,来处理海量数据。这些技术提供分布式计算和存储能力,使数据处理任务可以并行执行,从而显著提高效率。此外,高级爬虫数据处理还涉及机器学习和人工智能技术,用于自动化数据清洗、特征工程和模型训练,进一步提升数据处理的准确性和效率。

# 2. 使用Spark进行大数据清洗**

**2.1 Spark简介及优势**

Apache Spark是一个开源的分布式计算框架,专为处理大规模数据集而设计。与传统的数据处理工具相比,Spark具有以下优势:

- **高性能:**Spark采用内存计算和分布式处理,可以并行处理海量数据,实现高吞吐量和低延迟。

- **容错性:**Spark使用弹性分布式数据集(RDD),即使在节点故障的情况下,也可以保证数据完整性和计算可靠性。

- **易于使用:**Spark提供了丰富的API(如DataFrame和SQL),使开发人员可以轻松地编写和执行数据处理任务。

- **可扩展性:**Spark可以轻松地扩展到数百或数千个节点,以处理不断增长的数据量。

**2.2 Spark RDD和DataFrame数据结构**

**RDD(弹性分布式数据集)**是Spark的基本数据结构,它表示分布在集群节点上的不可变数据集。RDD支持各种转换和操作,例如映射、过滤和聚合。

**DataFrame**是RDD的结构化视图,它将数据组织成行和列,类似于关系数据库中的表。DataFrame提供了一个更直观和用户友好的界面来处理结构化数据。

**2.3 数据清洗操作(去重、过滤、转换)**

数据清洗是将原始数据转换为可用于分析和建模的干净和一致的数据的过程。Spark提供了丰富的操作来执行以下数据清洗任务:

- **去重:**使用`distinct()`操作删除重复记录。

- **过滤:**使用`filter()`操作根据条件过滤数据。

- **转换:**使用`map()`或`flatMap()`操作将数据转换为新的格式或结构。

```python

# 去除重复记录

df = df.distinct()

# 根据条件过滤数据

df = df.filter(df['age'] > 18)

# 将数据转换为新的格式

df = df.map(lambda row: (row['name'], row['age']))

```

**代码逻辑分析:**

- `distinct()`操作返回一个新的DataFrame,其中只包含原始DataFrame中唯一的记录。

- `filter()`操作返回一个新的DataFrame,其中只包含满足指定条件的记录。

- `map()`操作返回一个新的RDD,其中每个元素是原始RDD中元素经过指定函数转换后的结果。

# 3.1 爬虫数据的清洗流程

爬虫数据清洗流程一般包括以下步骤:

1. **数据获取:**从各种来源(如网站、API)抓取原始数据。

2. **数据预处理:**将原始数据转换为适合清洗的格式,包括去除重复、转换数据类型和处理缺失值。

3. **数据清洗:**应用清洗规则和算法来识别和删除不

0

0