机器翻译新纪元:神经网络如何打破语言界限

发布时间: 2024-09-06 04:20:17 阅读量: 133 订阅数: 49

元宇宙:网络空间新纪元

# 1. 神经网络与机器翻译概述

## 1.1 神经网络简史与机器翻译的发展

神经网络的历史可以追溯到20世纪50年代的感知机模型。经过半个多世纪的发展,尤其是深度学习的兴起,神经网络在机器翻译领域取得了革命性的进步。机器翻译的演变也经历了从基于规则的翻译,到统计机器翻译,再到现在的神经机器翻译(NMT)的全过程。

## 1.2 神经网络与机器翻译的融合

NMT的出现标志着神经网络与机器翻译技术的融合。与传统统计机器翻译系统相比,NMT系统通过端到端的方式学习源语言到目标语言的映射,从而提升了翻译的质量和流畅度。NMT系统通过使用深度神经网络模型,能够更好地捕捉和理解语言之间的复杂关联,使得翻译结果更加自然。

## 1.3 机器翻译的现状与挑战

尽管NMT带来了显著的进步,但机器翻译仍面临诸多挑战。包括但不限于:对领域特定术语的准确翻译、对不同语言组合的覆盖以及如何处理稀有语言。为了应对这些挑战,研究人员正在不断优化现有技术,并探索新的研究方向,以期达到更高质量的翻译输出。

# 2. 神经网络基础理论

## 2.1 神经网络的基本概念

### 2.1.1 神经元与激活函数

神经网络中的基本单元是神经元,也被称作节点或单元。一个神经元通常由输入、权重、求和函数和激活函数构成。输入是信号或数据点,权重是信号的重要性标记,求和函数则是对所有加权输入进行累加的步骤,最后通过激活函数决定是否以及如何传递信号到下一个神经元。

激活函数是引入非线性的关键,它决定神经元是否被激活。非线性激活函数使得网络能够学习和模拟复杂的函数。常见的激活函数包括:

- Sigmoid:输出范围为(0, 1),主要用于二分类问题的输出层。

- Tanh:输出范围为(-1, 1),类似于Sigmoid,但输出的中心是0。

- ReLU(Rectified Linear Unit):如果输入小于0,则输出0;否则输出输入值。其计算效率较高,已成为当前深度网络中最流行的激活函数。

- Softmax:通常用于多分类问题的输出层,可以将输出转化为概率分布。

代码示例:

```python

import numpy as np

# ReLU激活函数

def relu(x):

return np.maximum(0, x)

# 模拟一个简单的神经元

def simple_neuron(input, weights, bias):

total = np.dot(input, weights) + bias

return relu(total)

# 输入数据

input_data = np.array([1, 2, 3])

# 权重

weights = np.array([0.5, -0.3, 0.2])

# 偏置

bias = 0.1

# 神经元处理

output = simple_neuron(input_data, weights, bias)

print("Neuron output:", output)

```

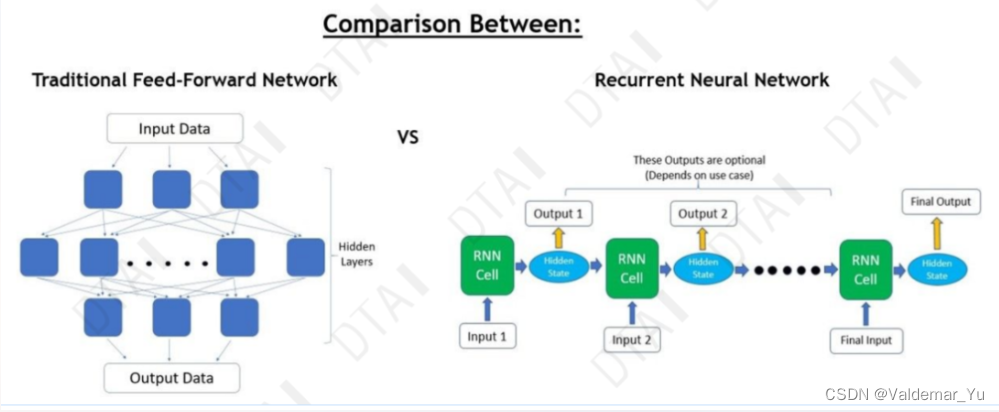

### 2.1.2 神经网络的类型与架构

神经网络架构是指网络的拓扑结构,包括神经元的数量、层次以及它们之间的连接方式。根据层次的不同,常见的网络类型有:

- 单层感知器:单层神经元网络,只能处理线性可分问题。

- 多层感知器(MLP):包含一个输入层、一个输出层和至少一个隐藏层的全连接网络。

- 卷积神经网络(CNN):特别适合处理图像数据,能够从数据中学习到空间层级结构。

- 循环神经网络(RNN):处理序列数据,每一个输出与前面的输出都有关联。

多层网络架构通过非线性激活函数允许网络学习复杂模式和表示。随着层次的加深,网络可以学习越来越抽象的特征表示。

## 2.2 深度学习与神经网络的进化

### 2.2.1 从浅层学习到深度学习

浅层学习指的是使用单层或双层的神经网络来解决实际问题,例如感知器。然而,浅层网络的表达能力有限,无法处理复杂的抽象任务。深度学习的出现就是为了克服这一限制,通过构建深层网络结构来学习更高级的特征表示。

深度学习允许模型通过多个隐藏层自动地学习特征层级结构,每层学习从数据中提取越来越抽象的特征。这些深层结构使得深度学习模型在图像识别、语音识别、自然语言处理等任务上取得了突破性的进展。

### 2.2.2 深度神经网络的关键技术

深度神经网络的成功依赖于几个关键技术的发展:

- 权重初始化:合适的权重初始化方法可以加速模型训练并减少梯度消失或梯度爆炸问题。

- 反向传播算法:通过链式法则,它能够有效地计算梯度,并且是梯度下降优化技术的基础。

- 批量归一化(Batch Normalization):减少内部协变量偏移,加速网络训练,并允许使用较高的学习率。

- 损失函数和优化器:不同的任务需要不同的损失函数,而优化器如Adam、RMSprop等可以更智能地调整学习率。

代码示例(使用Adam优化器和交叉熵损失函数):

```python

from keras.models import Sequential

from keras.layers import Dense

from keras.optimizers import Adam

# 创建模型

model = Sequential([

Dense(64, activation='relu', input_shape=(input_size,)),

Dense(10, activation='softmax')

])

# 编译模型,设置优化器和损失函数

***pile(optimizer=Adam(), loss='categorical_crossentropy', metrics=['accuracy'])

# 训练模型

model.fit(train_data, train_labels, epochs=10, batch_size=32)

```

## 2.3 神经网络在机器翻译中的应用

### 2.3.1 神经机器翻译(NMT)简介

神经机器翻译(NMT)是机器翻译的一种方法,它使用深度学习模型来转换一种语言到另一种语言。NMT模型通常由编码器、解码器和注意力机制组成。编码器负责将源语言的句子编码成一个中间向量表示,解码器则负责从这个表示中生成目标语言的句子。

NMT系统可以是端到端的,即从原始输入直接到最终输出,无需复杂的预处理和后处理。这使得NMT更加灵活,容易集成新的数据和改进模型。

### 2.3.2 神经机器翻译的性能指标

在机器翻译领域中,评估翻译质量的标准主要是BLEU(Bilingual Evaluation Understudy)分数。BLEU分数是通过比较机器翻译的输出和一组或多组人工翻译参考来计算的,它通过n-gram重合度来衡量,取值范围从0到1。

BLEU分数越高,表示翻译质量越好。然而,BLEU分数并不完美,它不能评估语义的准确性,也不能捕捉到语法的正确性。因此,除了BLEU分数外,有时也会使用METEOR和TER等其他指标进行补充评估。

代码示例(计算BLEU分数):

```python

from nltk.translate.bleu_score import sentence_bleu

# 假设reference是参考翻译,hypothesis是机器翻译结果

reference = [['This', 'is', 'an', 'example']]

hypothesis = ['This', 'is', 'a', 'sample']

# 计算BLEU分数

score = sentence_bleu(reference, hypothesis)

print("BLEU score:", score)

```

这一章介绍了神经网络基础理论的关键概念,并且提供了代码示例以加深理解。理解了神经元、激活函数、网络类型、深度学习技术以及NMT的基本知识,对于后续章节深入探讨模型训练、优化和实践应用是非常重要的。

# 3. 神经网络模型训练与优化

神经网络模型训练与优化是机器翻译系统的核心环节,这个过程中模型通过学习大量的翻译数据集,不断调整自身参数以提升翻译的准确性和效率。本章节将深入探讨数据预处理、训练算法选择、模型评估及优化策略,使我们能够构建出性能优秀的神经机器翻译系统。

## 数据预处理与模型输入

在神经网络训练之前,我们需要准备和清洗训练语料库,确保数据质量,并通过向量化技术将文本数据转化为模型能够处理的形式。

### 语料库的构建与清洗

构建高质量的语料库是机器翻译的基础,通常包括收集大量的双语或多语对照文本,并对其进行清

0

0