长短期记忆网络(LSTM):文本生成的未来已来

发布时间: 2024-09-06 05:00:46 阅读量: 108 订阅数: 49

简单理解LSTM长短期记忆网络

# 1. 长短期记忆网络(LSTM)简介

在深入探讨长短期记忆网络(LSTM)之前,让我们先了解一下LSTM的前世今生。LSTM是一种特殊的循环神经网络(RNN),它有能力学习长期依赖信息,这在处理语言、时间序列数据等任务时尤为重要。简单地说,LSTM通过引入门控机制来解决传统RNN在学习过程中出现的梯度消失和梯度爆炸问题,从而在长期依赖问题上表现出色。本章我们将对LSTM进行初步的介绍,为后续章节的深入学习奠定基础。

## 1.1 LSTM的起源和重要性

LSTM最初由Sepp Hochreiter和Jürgen Schmidhuber于1997年提出,旨在解决传统RNN在处理长序列数据时面临的困难。由于其结构特点,LSTM能够捕捉序列数据中的时间关联性和上下文信息,使其在许多序列预测问题中成为主流方法,如语音识别、文本生成和机器翻译等领域。

## 1.2 LSTM的基本概念

与传统的RNN不同,LSTM通过其精心设计的单元结构,使得信息可以更有效地在时间步之间流动。LSTM的这些单元结构包括输入门、遗忘门和输出门,它们共同作用,决定了哪些信息应该保留、遗忘或者输出。这种设计使得LSTM能够学习到数据中的长期依赖关系,即使序列很长也不会失去关键信息。

# 2. LSTM的理论基础和工作机制

### 2.1 循环神经网络(RNN)的原理

#### 2.1.1 RNN的基本概念和结构

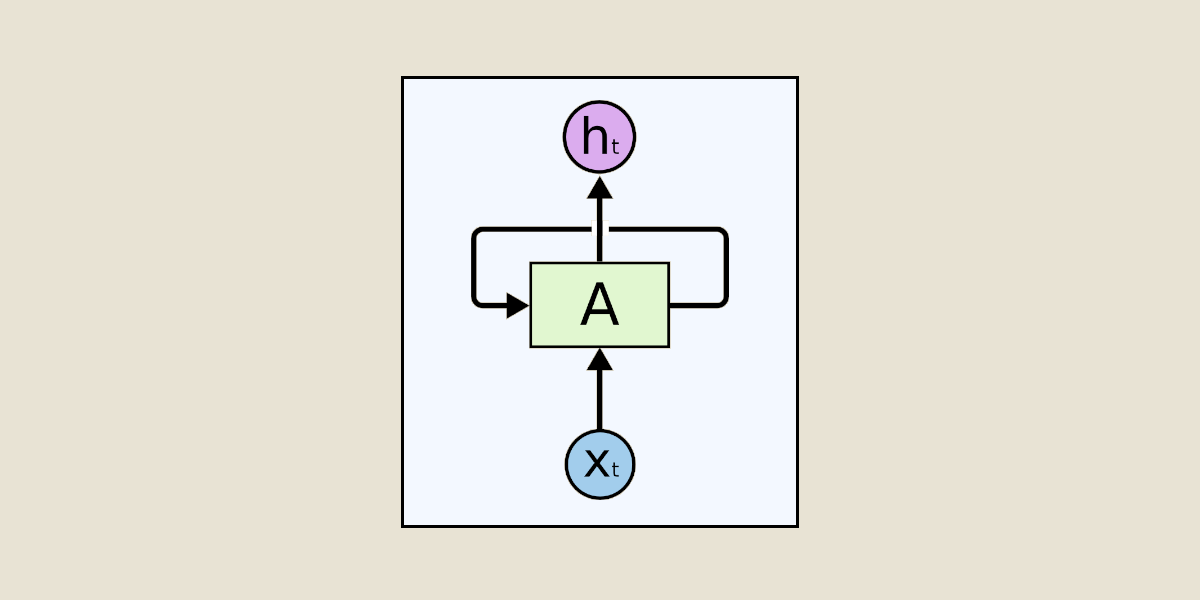

循环神经网络(Recurrent Neural Network, RNN)是一种用于处理序列数据的神经网络。它能够利用自身的信息处理当前的信息,并在序列的任意时刻存储和访问信息。这使得RNN非常适合处理时间序列数据、语音识别、语言建模等任务。

RNN的核心是一个循环单元,该循环单元包含神经网络的层。在时间步`t`中,循环单元接收输入`x_t`和上一时间步的隐藏状态`h_t-1`作为输入。它的输出既可以是当前时间步的输出`y_t`,也可以是下个时间步的隐藏状态`h_t`。

RNN由于其结构的特殊性,能够处理不同长度的序列数据,这是因为它包含了一个循环连接,允许信息在网络中持续流动。

#### 2.1.2 RNN的时间序列处理能力

RNN能够通过其隐藏状态捕捉序列中的时间动态信息。例如,在语言建模中,当前单词的预测依赖于前文的内容。通过隐藏状态,RNN能够在某种程度上记住之前的输入信息,并将其用于后续的计算。

然而,RNN也存在一些局限性,尤其是在捕捉长距离依赖时,这与梯度消失和梯度爆炸问题有关,这将在后续的章节中详细讨论。

### 2.2 LSTM核心概念解析

#### 2.2.1 LSTM单元的结构和设计

为了解决传统RNN在处理长序列时的梯度问题,LSTM(Long Short-Term Memory)被引入。LSTM单元由以下几个关键部分组成:

- **细胞状态(Cell State)**:可以想象成一条传送带,信息可以在上面进行传递,而不会受到其他层次的影响。

- **遗忘门(Forget Gate)**:决定哪些信息应该从细胞状态中被丢弃。

- **输入门(Input Gate)**:决定哪些新信息将被存储在细胞状态中。

- **输出门(Output Gate)**:决定哪些信息将被输出到隐藏状态。

LSTM通过这些专门设计的门来调节信息的流动,从而有效地解决了传统RNN长期依赖问题。

#### 2.2.2 LSTM的关键组件:遗忘门、输入门、输出门

- **遗忘门(Forget Gate)**:一个Sigmoid层,它会查看`h_t-1`和`x_t`,并输出一个在0到1之间的数字,这些数字对应于每一个细胞状态`C_t-1`中的值,1表示保留,0表示忘记。

- **输入门(Input Gate)**:同样由一个Sigmoid层和一个tanh层组成,Sigmoid层决定哪些信息将要更新,tanh层创建一个新的候选值向量`~C_t`,它们将被结合起来更新细胞状态。

- **输出门(Output Gate)**:基于细胞状态,决定下一个隐藏状态。首先,我们运行一个Sigmoid层来确定哪些信息将输出,然后将细胞状态经过tanh层进行规范化,并且将它们与Sigmoid门输出的信息相乘,最终得到输出。

### 2.3 LSTM与传统RNN的对比

#### 2.3.1 长期依赖问题的解决

在传统RNN中,随着时间步的增加,信息会逐渐丢失,导致模型难以捕捉长距离的时间依赖关系。LSTM通过其门控制机制,有效地解决了这一问题,使得模型能够学习跨越较长时间步的数据依赖。

#### 2.3.2 梯度消失和梯度爆炸问题

梯度消失和梯度爆炸是训练深度神经网络时遇到的挑战。在RNN中,由于参数是共享的,这些问题会随着时间步的增加而被放大。

LSTM通过引入遗忘门和其特殊的结构设计,可以维持长期的梯度,从而减轻梯度消失的问题。同时,由于其结构的稳定性,LSTM也减少了梯度爆炸的可能性。

# 3. LSTM在文本生成中的应用

在这一章中,我们深入探讨LSTM在文本生成任务中的应用。文本生成作为自然语言处理(NLP)的重要应用领域,对生成连贯、有意义的文本内容提出了严格要求。LSTM由于其结构特点和工作机制,已经成为文本生成任务的首选技术之一。

## 3.1 文本生成任务的挑战和策略

### 3.1.1 语言模型的基本概念

文本生成任务往往依赖于语言模型的构建。语言模型是一种统计模型,能够对序列数据(如文字、音素、字母等)进行建模,以评估一个句子或一段文字出现的可能性。在文本生成中,语言模型需要能够理解语言的结构、语义和上下文,以便生成流畅、合理的文本内容。

### 3.1.2 评价文本生成质量的标准

文本生成质量的评价是一个复杂的问题,不仅需要考虑生成文本的语法准确性,更要注重语义连贯性和创造性。通常,评价标准包括但不限于以下几个方面:

- **准确性**:生成的文本是否与给定的上下文或主题相关。

- **流畅性**:文本是否通顺,是否符合语言习惯。

- **多样性**:生成的文本是否具有多样性,避免重复。

- **创新性**:文本是否能够提供新的信息或观点。

## 3.2 LSTM文本生成的实现

### 3.2.1 LSTM网络的设计和训练

为了实现文本生成,首先需要设计一个LSTM网络。这个网络通常包含一个或多个LSTM层,用于处理输入的文本序列。设计网络时,需要确定LSTM层的数量、隐藏单元的数量、以及输出层的设计等参数。以下是一个简单的LSTM网络设计和训练的代码示例:

```python

import tensorflow as tf

from tensorflow.keras.layers import LSTM, Dense, Embedding

from tensorflow.keras.models import Sequential

from tensorflow.keras.optimizers import Adam

# 设定模型参数

vocab_size = 10000 # 词汇表大小

embedding_dim = 256 # 嵌入层维度

lstm_units = 512 # LSTM层单元数

sequence_length = 100 # 输入序列长度

# 构建模型

model = Sequential([

Embedding(vocab_size, embedding_dim, input_length=sequence_length),

LSTM(lstm_units, return_sequences=True),

Dense(vocab_size, activation='softmax')

])

# 编译模型

***pile(loss='categorical_crossentropy', optimizer=Adam(), metrics=['accuracy'])

# 模型摘要

model.summary()

# 假设以下为训练数据和标签

# X_train, y_train = ...

# 训练模型

# model.fit(X_train, y_train, epochs=10, batch_size=64)

```

在上述代码中,我们首先导入了TensorFlow和Keras相关模块,然后定义了模型的参数。接着使用`Sequential`模型堆叠了嵌入层(`Embedding`)、LSTM层和全连接层(`Dense`)。编译模型时使用了分类交叉熵(`categorical_crossentropy`)作为损失函数,`Adam`优化器来调整学习率,以及准确率作为评估指标。最后,我们通过`fit`方法对模型进行训练,这里假设`X_train`和`y_train`数据已经准备好。

### 3.2.2 文本生成的样本案例分析

为了展示LSTM在文本生成中的应用,我们可以通过一个简单的例子来分析。假设我们使用上面构建的模型进行文本生成,我们首先需要为模型提供一个起始的文本序列,模型则基于这个序列继续生成后续的文本。

文本生成的一个关键步骤是采样。采样策略决定了如何从模型输出的词概率分布中选取下一个词。常见的采样方法包括:

- **贪婪采样**:总是选择概率最高的词作为下一个词。

- **随机采样**:从概率分布中随机选取一个词。

- **束搜索(Beam Search)**:维护一个候选词序列集合,并选择最有希望的序列进行扩展。

例如,通过以下代码实现贪婪采样来生成文本:

```python

import numpy as np

def generate_text(model, start_sequence, generation_length=50):

generated_sequence = start_sequence

for i in range(generation_length):

# 对当前序列进行编码

encoded_sequence = np.expand_dims(np.array(tokenizer.texts_to_sequences([generated_sequence])[0]), axis=0)

# 预测下一个词

predictions = model.predict(encoded_sequence, verbose=0)

# 贪婪采样下一个词

next_word_index = np.argmax(predictions)

next_word = tokenizer.index_word[next_word_index]

# 将预测的词添加到序列中

generated_sequence += ' ' + next_word

return generated_sequence

# 假设使用以下文本序列作为起始

start_sequence = 'The moon is bright tonight'

# 生成文本

generated_text = generate_text(model, start_sequence)

print(generated_text)

```

在这段代码中,`generate_text`函数接受一个训练好的模型、一个起始文本序列`start_sequence`,并定义生成文本的长度`generation_length`。函数内部通过循环调用模型预测下一个词,并通过贪婪采样方法选取,最终返回生成的文本。

## 3.3 LSTM文本生成的优化技巧

### 3.3.1 超参数调整和正则化策略

在训练LSTM模型时,超参数的选择对模型性能有很大影响。合理的超参数调整可以提高模型的训练效率和文本生成质量。关键的超参数包括:

- **学习率**:控制模型更新的速度。

- **批次大小**(batch size):每次训

0

0