Python数据处理加速器:用pandas和uuid库处理大规模数据

发布时间: 2024-10-11 02:02:30 阅读量: 119 订阅数: 31

# 1. 数据处理的现代方法与工具

在数字化时代,数据处理已成为企业和研究者分析、理解和利用数据的关键环节。为了有效地从大量信息中提取有价值的见解,现代数据处理方法与工具的发展变得至关重要。本章将探讨当前数据处理领域的一些主流方法与工具,以及它们在实际应用中的优势和局限性。

## 1.1 传统数据处理方法的局限性

在讨论现代方法之前,我们需要理解传统数据处理方法的局限性。传统的数据处理主要依赖于电子表格软件,例如Microsoft Excel,但随着数据量的增长和分析需求的复杂化,这种方法在数据处理速度、规模和复杂性处理能力上逐渐显示出其局限性。

## 1.2 现代数据处理工具的崛起

为解决传统工具无法克服的问题,现代数据处理工具如Python的pandas库和R语言等应运而生。它们提供了更为强大和灵活的数据处理能力,支持大规模数据集的处理,并且集成了丰富的数据处理函数,这些工具已经成为数据科学家和分析师的重要武器。

## 1.3 数据处理工具的选择标准

在众多现代数据处理工具中,选择合适的一个需要基于特定的项目需求和背景。核心考量因素包括但不限于性能效率、易用性、社区支持、文档质量以及与其它数据科学工具的兼容性。正确评估这些因素将帮助我们做出明智的决策,从而提高数据处理工作的整体效率和质量。

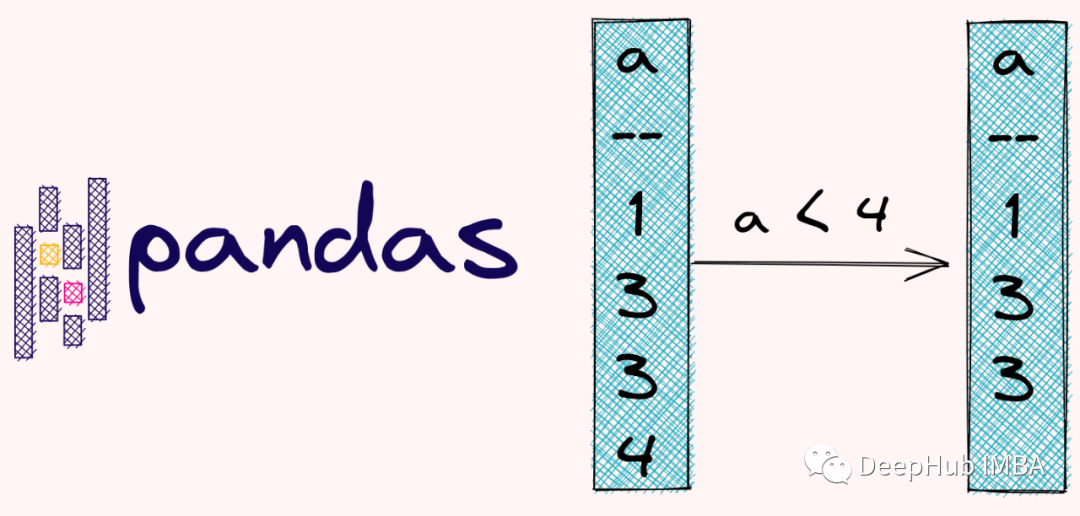

# 2. pandas库的深度解析

## 2.1 pandas基础功能介绍

### 2.1.1 数据结构:Series和DataFrame

pandas库的核心数据结构为`Series`和`DataFrame`。`Series`是一维数组,可以存储任意数据类型,其索引标签可以是任意类型。`DataFrame`则是二维的表格型数据结构,我们可以将其视为一个表格,具有行和列的概念。

```python

import pandas as pd

# 创建一个简单的Series

data = {'a': 1, 'b': 2, 'c': 3}

series = pd.Series(data)

print(series)

```

上述代码创建了一个以`data`字典为基础的Series对象。字典的键作为Series的索引,值则是数据。

```python

# 创建一个简单的DataFrame

df = pd.DataFrame({'Column1': [1, 2, 3], 'Column2': ['a', 'b', 'c']})

print(df)

```

上述代码创建了一个DataFrame对象,其数据结构类似于Excel表格。

### 2.1.2 数据导入与导出

pandas库提供了强大的数据导入导出功能,支持多种格式,包括CSV、Excel、JSON、HTML和数据库等。我们可以使用`read_csv`、`read_excel`、`to_csv`和`to_excel`等方法进行数据的导入和导出。

```python

# 导出数据到CSV

df.to_csv('output.csv', index=False)

# 从CSV导入数据

df_imported = pd.read_csv('output.csv')

print(df_imported)

```

该段代码展示了如何将DataFrame对象导出到CSV文件,然后再次从该CSV文件导入数据。参数`index=False`表示不导出行索引。

## 2.2 pandas高级数据操作

### 2.2.1 数据清洗技巧

在数据科学领域中,数据清洗是重要的一环。pandas提供了多种数据清洗的方法,包括缺失数据处理、重复数据删除和异常值处理。

```python

# 填充缺失值

df_filled = df.fillna(0)

# 删除重复行

df_unique = df.drop_duplicates()

# 删除含有缺失值的行

df_cleaned = df.dropna()

```

上述代码演示了使用pandas进行基本的数据清洗操作。`fillna`方法用于填充缺失值,`drop_duplicates`方法用于删除重复行,而`dropna`方法则用于删除含有缺失值的行。

### 2.2.2 数据转换与融合

pandas中的数据转换可以通过`apply`、`map`和`applymap`等方法完成。数据融合则多使用`merge`和`concat`函数。

```python

# 将列名转换为小写

df.columns = df.columns.str.lower()

# 按列合并两个DataFrame对象

df_merged = pd.merge(df1, df2, on='key_column')

```

这里我们首先将DataFrame的列名转换为小写,接着通过`merge`函数按照某个键值合并两个DataFrame。

### 2.2.3 数据聚合与分组

数据聚合和分组是数据分析中常见的操作。使用`groupby`可以对数据进行分组,然后应用聚合函数如`sum()`、`mean()`、`count()`等。

```python

# 按照某列分组并计算每组的平均值

grouped = df.groupby('group_column').mean()

```

上述代码展示了按照某个列进行分组,并计算每个分组的平均值。

## 2.3 pandas性能优化

### 2.3.1 向量化操作与性能提升

pandas在内部优化了向量化操作,允许进行快速、高效的数组操作,而无需显式地使用Python循环。

```python

# 向量化乘法操作

df['new_column'] = df['existing_column'] * 2

```

在这段代码中,我们创建了一个新列`new_column`,其值是`existing_column`列值的两倍。由于使用了向量化操作,这一操作相比循环具有更高的性能。

### 2.3.2 使用Categorical类型优化

Categorical数据类型允许对分类数据进行高效操作。在pandas中,使用Categorical类型可以节省内存,并提高性能。

```python

# 将某一列转换为Categorical类型

df['category_column'] = df['category_column'].astype('category')

```

代码将`category_column`列转换为Categorical类型,这样可以在某些情况下提高性能和减少内存使用。

### 2.3.3 并行处理与多线程应用

pandas虽然在单核性能上有很好的优化,但在处理大数据集时,可能需要利用并行计算来提升效率。在新版本的pandas中,部分操作已经可以利用多线程来加速处理。

```python

# 需要pandas版本支持多线程的设置方法

pd.set_option('num_threads', 4)

```

这里,我们通过设置选项`num_threads`来启用多线程处理。需要注意的是,这可能依赖于pandas的版本和安装的配置。

通过本章节的介绍,我们可以看到pandas库不仅提供了基础数据处理的功能,还通过高级数据操作、性能优化等手段,极大地提升了数据处理的效率和能力。这使***s成为了数据科学领域不可或缺的工具之一。在后续章节中,我们将深入了解如何结合uuid库以及在大规模数据处理场景下使用pandas。

# 3. 使用uuid库生成唯一标识

UUID(Universally Unique Identifier,通用唯一识别码)是一种用于计算机系统中的标识方式,它确保了在所有时间和空间中的唯一性。尽管它不常被提及,但在数据处理中,特别是当需要区分相同数据的不同实例时,UUID变得格外重要。

## 3.1 uuid库基本使用指南

### 3.1.1 uuid库概述

Python的`uuid`模块提供了生成和处理UUID的功能。这个库允许用户生成特定版本的UUID,并且可以将其格式化为多种字符串表示形式。`uuid`模块主要提供以下几种生成UUID的方法:

- 基于时间的UUID

- 基于名称的UUID(散列算法)

- 随机生成的UUID

### 3.1.2 生成不同类型UUID的方法

在实际应用中,根据不同的需求,我们可以生成不同类型的UUID。以下是一些示例代码,演示如何使用Python的`uuid`模块生成不同类型的UUID。

```python

import uuid

# 基于时间的UUID

time_based_uuid = uuid.uuid1()

print(f"Time-based UUID: {time_based_uuid}")

# 基于随机数的UUID

random_based_uuid = uuid.uuid4()

print(f"Random-based UUID: {random_based_uuid}")

# 基于命名空间和名称的UUID

name_based_uuid = uuid.uuid3(uuid.NAMESPACE_DNS, '***')

print(f"Name-based UUID (MD5): {name_based_uuid}")

# 基于命名空间和名称的UUID(SHA-1)

name_based_uuid_sha1 = uuid.uuid5(uuid.NAMESPACE_DNS, '***')

print(f"Name-based UUID (SHA-1): {name_based_uuid_sha1}")

```

在上述代码中,我们生成了一个基于时间的UUID,一个随

0

0