生成对抗网络在数据增强中的应用

发布时间: 2024-09-02 21:17:44 阅读量: 81 订阅数: 38

# 1. 生成对抗网络简介

## 1.1 什么是生成对抗网络(GAN)

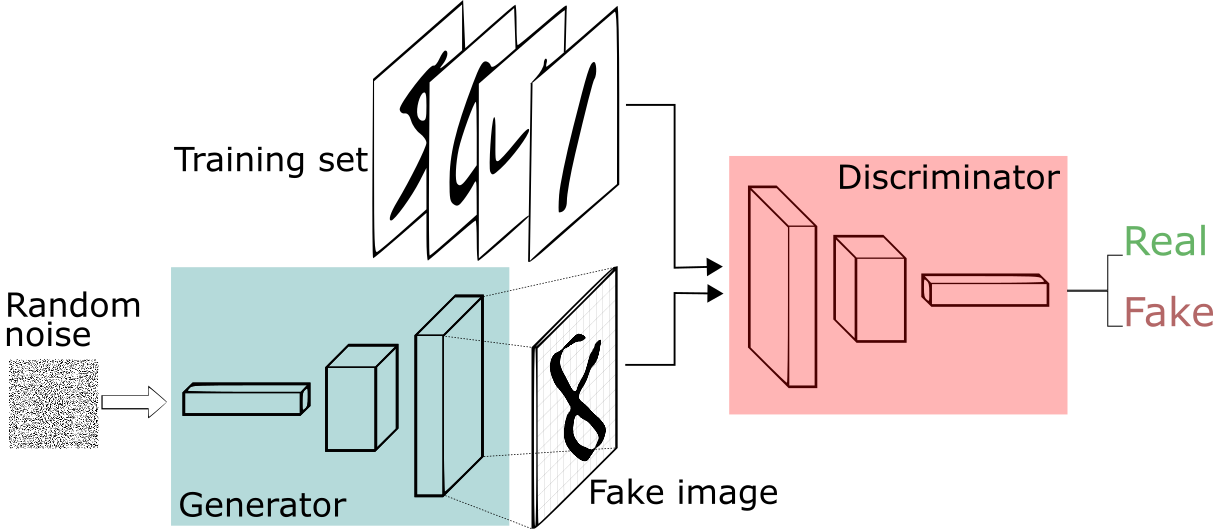

生成对抗网络(Generative Adversarial Network,简称GAN)是一种由Ian Goodfellow在2014年提出的人工智能模型,属于深度学习的一个分支。它由两个部分组成:生成器(Generator)和判别器(Discriminator),这两部分在训练过程中不断相互竞争和学习。生成器的目标是生成逼真的数据,而判别器的目标是准确地判断出数据是真实还是由生成器伪造的。通过这种对抗性的训练,GAN能够学习到数据的分布,进而生成新的、与真实数据难以区分的样本。

## 1.2 GAN的用途与重要性

GAN自从提出以来,在图像合成、风格转换、数据增强、医学影像分析等多个领域展现出了其强大的应用潜力。它能够创造出逼真的图像、视频甚至音乐,是目前人工智能研究中的热门话题之一。GAN的模型结构相对简单,但通过不断优化和扩展,其在解决实际问题中的价值和作用日益凸显,对推动AI技术进步具有深远的影响。

## 1.3 本章小结

本章介绍了生成对抗网络的基本概念及其在人工智能领域的重要性。随后的章节将会深入探讨GAN的理论基础、关键技术、数据增强的应用,以及在医学和自动驾驶等领域的实际案例,最终展望GAN未来的发展趋势与挑战。通过本文,读者能够全面了解GAN的工作机制及其应用前景,为后续的学习和研究打下坚实的基础。

# 2. 生成对抗网络的理论基础

### 2.1 生成对抗网络的组成与工作原理

#### 2.1.1 生成器(Generator)的机制

生成器是生成对抗网络(GAN)的核心组件之一,它的主要功能是学习数据分布,并生成与真实数据尽可能接近的合成数据。生成器通常由一个深度神经网络构成,如全连接网络、卷积神经网络(CNN)或循环神经网络(RNN)等。在学习过程中,生成器尝试通过随机噪声(通常是多维高斯分布的样本)生成数据,并不断优化网络权重,以期所生成的数据能够欺骗判别器,使判别器不能准确区分真假数据。

```python

import torch

import torch.nn as nn

class Generator(nn.Module):

def __init__(self, input_dim, output_dim):

super(Generator, self).__init__()

self.main = nn.Sequential(

# 输入层到隐藏层

nn.Linear(input_dim, 256),

nn.ReLU(),

nn.Linear(256, 512),

nn.ReLU(),

nn.Linear(512, 1024),

nn.ReLU(),

# 隐藏层到输出层

nn.Linear(1024, output_dim),

nn.Tanh()

)

def forward(self, x):

return self.main(x)

# 创建生成器实例

z_dim = 100 # 噪声维度

g = Generator(input_dim=z_dim, output_dim=784) # 以MNIST数据集为例,输出维度为784(28x28像素)

```

在上述代码中,我们定义了一个生成器类`Generator`,它包含一个线性层和ReLU激活函数的顺序模块,最后一个线性层输出到数据的实际维度,并使用Tanh激活函数,以确保输出值在-1到1之间。

#### 2.1.2 判别器(Discriminator)的作用

判别器是GAN的另一个关键组件,它的职责是区分输入数据是真实数据还是由生成器生成的假数据。判别器通常也是一个深度神经网络,经过训练后能够输出一个概率值,表示输入数据为真实的概率。在训练过程中,判别器的目标是尽可能准确地区分真实与合成数据,从而为生成器提供反馈。

```python

class Discriminator(nn.Module):

def __init__(self, input_dim):

super(Discriminator, self).__init__()

self.main = nn.Sequential(

# 输入层到隐藏层

nn.Linear(input_dim, 1024),

nn.LeakyReLU(0.2),

nn.Dropout(0.3),

nn.Linear(1024, 512),

nn.LeakyReLU(0.2),

nn.Dropout(0.3),

nn.Linear(512, 256),

nn.LeakyReLU(0.2),

nn.Dropout(0.3),

# 隐藏层到输出层

nn.Linear(256, 1),

nn.Sigmoid()

)

def forward(self, x):

return self.main(x)

# 创建判别器实例,以MNIST数据集为例

d = Discriminator(input_dim=784)

```

在这段代码中,`Discriminator` 类定义了一个判别器,其中包含多个线性层和LeakyReLU激活函数,最后输出一个概率值,通过Sigmoid函数归一化到0到1之间。

#### 2.1.3 GAN的优化目标与损失函数

生成对抗网络的训练过程是一个迭代优化的过程,其目标是使生成器产生的数据尽可能接近真实数据,同时使判别器能够准确区分真实数据和合成数据。在优化过程中,生成器和判别器交替进行优化,通常使用的是交叉熵损失函数。

生成器的目标函数是最大化判别器分类错误的概率,其损失函数可以表示为:

\[ \mathcal{L}_{G} = - \log(1 - D(G(z))) \]

其中 \( D(G(z)) \) 是判别器对生成器生成数据 \( G(z) \) 判断为真的概率。

判别器的目标函数是最大化判别正确率,其损失函数可以表示为:

\[ \mathcal{L}_{D} = - (\log(D(x)) + \log(1 - D(G(z)))) \]

其中 \( D(x) \) 是判别器对真实数据 \( x \) 判断为真的概率,而 \( D(G(z)) \) 已经如上所述。

### 2.2 生成对抗网络的关键技术

#### 2.2.1 深度卷积生成对抗网络(DCGAN)

深度卷积生成对抗网络(DCGAN)是GAN的一种扩展,通过引入卷积神经网络(CNN)的结构来提高GAN生成图像的质量和稳定性。DCGAN的关键创新包括使用转置卷积(反卷积)层来构建生成器,使用批量归一化来稳定训练过程,以及使用泄漏的ReLU和Strided卷积(即不使用填充的卷积)来构建判别器。

DCGAN在训练过程中使用了批量归一化,这有助于生成器学习到更加多样化的数据分布,并且稳定了生成器的训练过程。此外,DCGAN还引入了池化层的替代方案,如使用步长卷积和反卷积层来实现图像特征图的下采样和上采样。

```python

# 伪代码,展示DCGAN中使用的批量归一化在生成器中的应用

class Generator(nn.Module):

def __init__(self, ...):

super(Generator, self).__init__()

...

self.batch_norm = nn.BatchNorm2d(...)

def forward(self, x):

...

x = self.batch_norm(x)

...

```

在这个伪代码中,`batch_norm` 是应用批量归一化的层,它能够帮助生成器生成更高质量和稳定性的图像。

#### 2.2.2 条件生成对抗网络(cGAN)

条件生成对抗网络(cGAN)是GAN的另一个变体,它允许给定一个条件变量,生成器根据这个条件来生成数据。条件可以是任何与数据相关的信息,例如类标签、其他模态数据或特定的属性。条件信息被编码成一个向量,然后与生成器的输入噪声向量结合,以便生成器在生成数据时考虑到这个条件信息。

```python

class ConditionalGenerator(nn.Module):

def __init__(self, input_dim, output_dim, condition_dim):

super(ConditionalGenerator, self).__init__()

self.condition_dim = condition_dim

self.main = nn.Sequential(

...

nn.Linear(input_dim + condition_dim, 1024),

...

)

def forward(self, x, condition):

x = torch.cat([x, condition], dim=1)

return self.main(x)

# 创建一个带有条件输入的生成器实例

c_dim = 10 # 假设条件向量的维度是10

cg = ConditionalGenerator(input_dim=z_dim, output_dim=784, condition_dim=c_dim)

```

在上述代码中,我们创建了一个条件生成器`ConditionalGenerator`,它的`forward`方法接受一个额外的条件向量作为输入。这个条件向量与随机噪声向量拼接后输入到生成器网络中。

#### 2.2.3 水平和垂直GAN架构

水平和垂直GAN架构是两种不同的GAN架构设计方法。水平GAN通过增加生成器和判别器的深度和宽度来提升性能,而垂直GAN则通过改变生成器和判别器之间的连接方式,例如使用跳跃连接来改善梯度流。水平GAN的优点在于可以提高网络模型的复杂性,而垂直GAN的优点是能够缓解训练过程中的梯度消失或爆炸问题。

这两种架构的实现方式和设计思路为GAN的发展提供了更多的可能性,不同的架构设计根据具体应用的不同有着不同的效果。水平和垂直GAN架构的设计使得网络能够更好地拟合数据的复杂性,同时也提升了模型的泛化能力。

接下来章节将会继续介绍生成对抗网络的理论基础,包括更多关于其组成部分的深入分析,以及它的关键技术在不同领域中的应用和发展。

[本章结束]

# 3. 数据增强的理论与实践

数据增强是深度学习中的一个关键步骤,尤其在训练数据有限的情况下,它能够显著地提高模型的泛化能力。本章我们将深入探讨数据增强的理论基础,以及一些在实践中的具体应用方法。

## 3.1 数据增强的概念与重要性

### 3.1.1 什么是数据增强

数据增强是一种技术,它通过对训练数据集进行一系列的变换来人为地扩展数据集。这些变换可以是简单的几何变换(如旋转、翻转),也可以是颜色空间的变换,或是更为复杂的数据插值和合成。数据增强的目的在于创造多样的数据版本,使模型能够学习到数据的不变特征,增加模型对新、未见数据的适应性。

##

0

0