深入分析:生成对抗网络中的判别器与生成器

发布时间: 2024-09-02 21:13:37 阅读量: 185 订阅数: 38

# 1. 生成对抗网络的基础概念

## 1.1 生成对抗网络的起源与发展

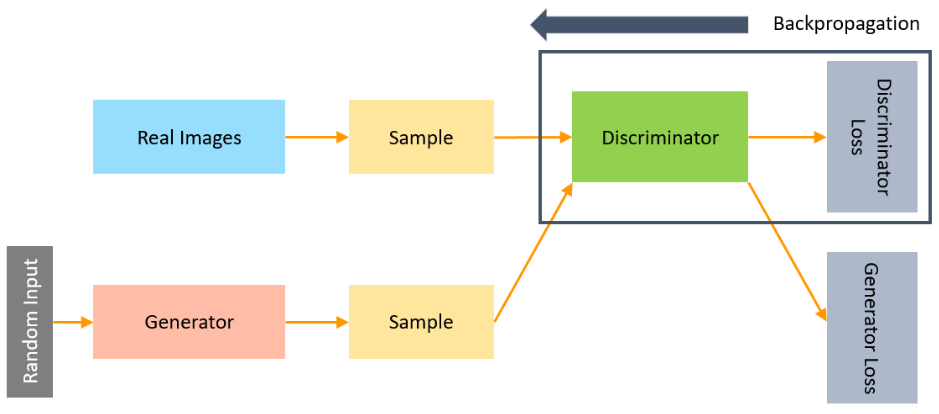

生成对抗网络(GAN)由Ian Goodfellow等人于2014年提出,它由两个神经网络构成:生成器(Generator)和判别器(Discriminator)。生成器负责生成新的数据实例,而判别器则评估这些实例的真实性。这两个网络在训练过程中相互竞争,通过这种对抗过程,生成器学习产生越来越真实的数据,判别器则不断提高识别真伪的能力。

## 1.2 GAN的基本原理

GAN的基本原理是通过最小化两个网络之间的差异来训练。具体来说,生成器尝试产生看起来像是真实数据的假数据,而判别器尝试区分真实数据与生成器产生的假数据。随着训练的深入,生成器越来越擅长模仿真实数据的分布,而判别器越来越难以区分真假数据。

## 1.3 GAN的应用场景

GAN在图像生成、风格迁移、超分辨率、数据增强等多个领域有着广泛的应用。在图像生成中,GAN可以创造出真实感十足的图像;在风格迁移中,它可以将一种艺术风格迁移到另一张图像上;在数据增强中,GAN可以用来生成新的训练样本,以提高机器学习模型的泛化能力。

通过了解GAN的基本概念,我们可以为进一步深入学习判别器与生成器的理论框架打下坚实的基础。

# 2. 判别器与生成器的理论框架

## 2.1 判别器的工作原理和优化目标

### 2.1.1 判别器的任务和策略

判别器作为生成对抗网络(GAN)中的一部分,其主要任务是区分真实样本和由生成器产生的假样本。在训练过程中,判别器需要通过不断学习,提高对两类样本的鉴别能力。为了实现这一点,判别器采取了一种二分类策略,即对于输入的样本,判别器需要输出一个概率值,该值表示样本为真实数据的概率。

判别器通常采用卷积神经网络(CNN)等深度学习模型,通过多层非线性变换,提取输入样本的特征。判别器在每个训练批次中,会接收到真实样本和生成器产生的假样本,通过最小化其损失函数来进行优化。损失函数通常采用交叉熵损失,鼓励判别器对真实样本给出高概率,对假样本给出低概率。

### 2.1.2 损失函数和优化算法

为了实现判别器的优化目标,损失函数的选择至关重要。最常用的损失函数是二元交叉熵损失函数,它可以衡量判别器对于样本真伪判断的准确性。具体的损失函数形式如下:

```math

L(D) = -\mathbb{E}_{x \sim p_{data}(x)}[\log D(x)] - \mathbb{E}_{z \sim p_{z}(z)}[\log(1 - D(G(z)))]

```

在上述公式中,$D(x)$表示判别器对真实样本$x$的判断概率,$G(z)$是生成器输出的假样本,其中$z$是从先验分布$p_{z}(z)$中采样的噪声。$D(G(z))$则是判别器对假样本的判断概率。优化目标是最大化真实样本概率和最小化假样本概率。

对于优化算法,通常使用随机梯度下降(SGD)或其变种,如Adam等自适应学习率算法,来进行判别器的参数更新。在GAN的训练过程中,判别器和生成器需要交替进行优化,以达到动态平衡。

## 2.2 生成器的设计和作用机制

### 2.2.1 生成器的架构和激活函数

生成器是GAN中负责生成假样本的组件,其结构通常设计为深层的神经网络,如全连接网络或卷积生成网络(CGAN)。生成器的核心目的是通过从一个简单分布(如高斯分布)中采样的噪声向量,生成与真实数据分布尽可能相似的数据样本。

在生成器的网络架构设计中,激活函数的选择对生成样本的质量有重要影响。常用的激活函数包括ReLU(Rectified Linear Unit)、tanh(双曲正切函数)以及Leaky ReLU等。ReLU能够有效地加速网络训练并缓解梯度消失问题,但容易导致输出值为零的问题,而tanh可以输出更均一的数据分布,适合于图像等数据生成任务。

### 2.2.2 数据生成过程和质量评估

生成器的数据生成过程是一个从噪声到复杂样本结构的逐步映射。在开始训练时,生成器的输出通常是非常粗糙的假样本。随着训练的进行,生成器通过学习判别器提供的反馈信息(即判别器的输出),逐渐优化其参数,生成的样本质量也随之提高。

生成器生成的数据质量评估是一个复杂的问题,因为“质量”很难有一个明确的量化标准。一般通过视觉检查、Inception Score(IS)、Fréchet Inception Distance(FID)等指标进行评估。IS衡量生成样本的多样性,而FID则衡量样本的多样性和真实性的结合。

## 2.3 判别器与生成器的博弈关系

### 2.3.1 理想状态下的平衡点分析

在理想状态下,判别器和生成器在GAN的训练过程中会达到一个纳什均衡状态,即在一个点上,无论哪一个网络进一步优化,都不会给整个模型带来收益的提高。在这一点上,生成器能够产生几乎与真实数据无法区分的假样本,而判别器无法有效区分样本的真伪。

这种均衡状态是通过生成器和判别器之间的持续博弈达成的。生成器不断学习如何欺骗判别器,而判别器不断学习如何更准确地鉴别样本。然而,达到并维持这种均衡状态是非常困难的,因为模型训练的非凸特性,往往会导致模型在局部最优解之间振荡,而不是稳定在全局最优解。

### 2.3.2 实际应用中的挑战与对策

在实际应用中,GAN模型很难达到上述理想的平衡点,通常会面临诸如模式崩溃、训练不稳定、梯度消失等问题。模式崩溃是指生成器只学习到真实数据中的少数几种模式,导致生成样本多样性不足。

为了解决这些问题,研究人员提出了多种策略。例如,使用Wasserstein损失函数来稳定训练,或者通过引入正则化项来提高模型的泛化能力。此外,对模型结构进行改进,例如使用条件生成对抗网络(cGAN),在一定程度上也能缓解模式崩溃问题。

### 2.3.3 实际案例分析

在实际应用中,通过精心设计的损失函数和模型架构,可以有效地解决上述问题。例如,使用Wasserstein损失函数的WGAN,在很多数据生成任务中都取得了较为理想的性能。通过引入额外的正则项,如梯度惩罚,可以使训练更加稳定,避免模式崩溃。

在一些复杂的生成任务中,如高质量图像的生成,GAN模型往往需要更深入的网络结构设计和更精细的超参数调整。例如,深度卷积生成对抗网络(DCGAN)通过引入批归一化(Batch Normalization)和全卷积结构,成功地生成了高质量的图像样本。

# 3. 生成对抗网络的训练技巧

在这一章节中,我们将深入了解生成对抗网络(GAN)的训练技巧。这些技巧有助于缓解训练过程中的不稳定性和收敛性问题,进而提高模型性能。我们会讨论如何有效地进行数据预处理和增强,以及如何在训练过程中监控和调整网络的稳定性。最后,我们将通过实例分析,展示最佳实践,并对模型超参数调优方法和性能评估进行深入讨论。

0

0