生成对抗网络在艺术创作中的应用:AI的艺术化

发布时间: 2024-09-02 21:32:44 阅读量: 110 订阅数: 38

# 1. 生成对抗网络(GAN)概述

## 1.1 GAN的起源和发展

生成对抗网络(GAN)是由Ian Goodfellow等人在2014年提出的一种深度学习架构。其核心思想是通过两个神经网络——生成器(Generator)和判别器(Discriminator)的对抗训练来生成高质量的数据样本。自提出以来,GAN迅速成为人工智能领域研究的热点,不仅在学术界引起广泛讨论,同时也吸引了工业界的高度关注。

## 1.2 GAN的应用前景

GAN的应用领域广泛,从图像和视频的生成,到音乐的创作,甚至三维模型的构建,GAN都展现出了强大的能力。但GAN的发展不仅仅局限于技术层面,它还引发了关于人工智能与艺术创作关系的深入思考。如何让机器学会人类的艺术创造力,是GAN所要面对的一个长远挑战。

## 1.3 GAN的挑战与机遇

尽管GAN带来了革命性的创新,但同时也面临着一系列挑战,包括模型训练的难度、生成样本的质量和多样性、以及伦理和法律问题等。本文将对GAN进行深入探讨,解析其工作原理、技术演进,以及在艺术创作中的应用实例,旨在为读者提供一个全面而深入的理解。

# 2. 生成对抗网络的基础理论

## 2.1 GAN的基本概念和组成

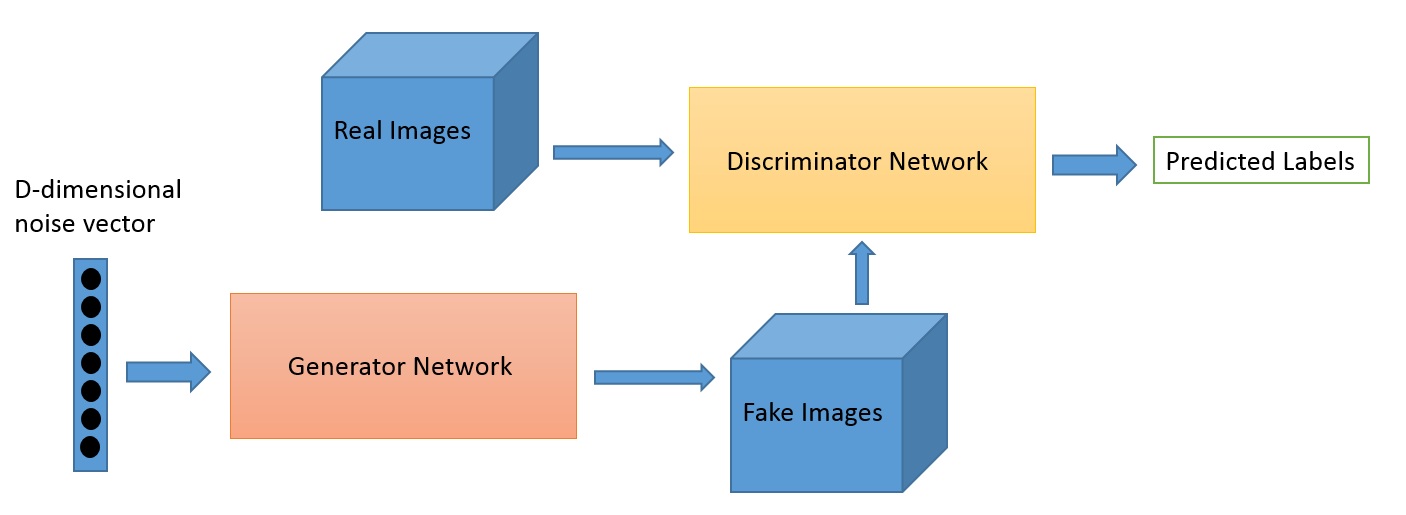

### 2.1.1 生成器(Generator)的原理

生成器是GAN中的一个关键组成部分,其核心目标是生成尽可能接近真实数据分布的假数据。具体来说,生成器通过接收一个随机噪声向量作为输入,并将其映射到数据空间中,以生成具有与真实数据相似统计特性的输出。在学习过程中,生成器试图欺骗判别器,让判别器无法区分其生成的假数据与真实数据。

**数学表述**:

假设随机噪声向量为 \( z \),生成器 \( G \) 将 \( z \) 映射到数据空间 \( X \),即 \( G(z) \)。随着训练的进行,\( G \) 不断学习,以最小化假数据和真实数据之间的差异。

**代码逻辑**:

```python

import torch

import torch.nn as nn

class Generator(nn.Module):

def __init__(self):

super(Generator, self).__init__()

# 定义生成器的神经网络结构

self.main = nn.Sequential(

# ...层结构...

)

def forward(self, z):

# 将噪声向量通过生成器网络,生成假数据

return self.main(z)

# 创建生成器实例

G = Generator()

```

### 2.1.2 判别器(Discriminator)的作用

判别器是GAN的另一个组成部分,它的任务是区分生成器产生的假数据和真实数据。判别器通过接收一个数据样本作为输入,并输出该样本为真实数据的概率。在训练过程中,判别器努力提高其对真假数据的区分能力。

**数学表述**:

假设真实数据样本为 \( x \),判别器 \( D \) 输出 \( x \) 为真实的概率 \( D(x) \)。同样,对于生成器 \( G \) 生成的假数据样本 \( G(z) \),判别器输出假数据的概率 \( D(G(z)) \)。判别器的目标是最大化 \( D(x) \) 和最小化 \( D(G(z)) \)。

**代码逻辑**:

```python

class Discriminator(nn.Module):

def __init__(self):

super(Discriminator, self).__init__()

# 定义判别器的神经网络结构

self.main = nn.Sequential(

# ...层结构...

)

def forward(self, x):

# 计算数据样本为真实数据的概率

return self.main(x)

# 创建判别器实例

D = Discriminator()

```

## 2.2 GAN的数学原理和优化算法

### 2.2.1 GAN的损失函数

GAN的核心在于找到一个对抗的过程,即生成器和判别器之间的最小最大游戏(minimax game)。生成器 \( G \) 和判别器 \( D \) 的损失函数分别为:

对于生成器 \( G \),其损失函数为:

\[ \mathcal{L}_G = -\mathbb{E}_{z \sim p_z(z)}[\log D(G(z))] \]

对于判别器 \( D \),其损失函数为:

\[ \mathcal{L}_D = -\mathbb{E}_{x \sim p_{data}(x)}[\log D(x)] - \mathbb{E}_{z \sim p_z(z)}[\log(1 - D(G(z)))] \]

这两个损失函数相互依赖,并共同构成GAN的优化目标。

### 2.2.2 优化算法和训练技巧

在GAN的训练过程中,需要仔细设计和选择优化算法,以确保生成器和判别器的平衡发展。常用的优化方法包括:

- **Adam优化器**:广泛用于GAN训练中,因为其结合了动量(Momentum)和自适应学习率调整。

- **学习率衰减**:随着训练过程的进行逐渐降低学习率,可以减少振荡并提高模型的稳定性和质量。

- **梯度惩罚**:为了解决训练过程中的梯度消失或爆炸问题,通常会在判别器的损失函数中添加梯度惩罚项。

**代码逻辑**:

```python

# GAN的训练过程示例

# 训练判别器

optimizerD = torch.optim.Adam(D.parameters(), lr=0.0002, betas=(0.5, 0.999))

for epoch in range(num_epochs):

for i, data in enumerate(dataloader, 0):

# 训练判别器,包括真实数据和生成器生成的假数据

# 训练生成器

optimizerG = torch.optim.Adam(G.parameters(), lr=0.0002, betas=(0.5, 0.999))

for epoch in range(num_epochs):

for i, data in enumerate(dataloader, 0):

# 训练生成器以欺骗判别器

```

## 2.3 GAN的变体和扩展模型

### 2.3.1 CGAN、DCGAN和StyleGAN简介

**CGAN(条件生成对抗网络)**:在基本GAN的基础上引入了条件变量,使得生成器可以根据特定的标签或条件生成与之相关联的数据。

**DCGAN(深度卷积生成对抗网络)**:利用卷积神经网络(CNN)改进GAN的结构,提高了模型的稳定性,并促进了图像生成技术的发展。

**StyleGAN**:通过引入“风格”概念,在生成过程中赋予模型更高的控制力,使得生成的图片具有更精细和可控的风格变化。

### 2.3.2 多模型融合和混合GAN

多模型融合是指将多个GAN模型的生成结果结合起来,以获得更丰富的特征和更好的生成效果。混合GAN则是将不同GAN模型的结构和原理结合起来,形成新的生成对抗网络模型,以克服单一模型的局限性。

**代码逻辑**:

```python

# 这里展示混合GAN的一个简化的融合机制

class HybridGAN(nn.Module):

def __init__(self):

super(HybridGAN, self).__init__()

# 定义混合模型的结构

def forward(self, z):

# 融合不同GAN模型的输出

# ...

return output

# 创建混合GAN实例

HG = HybridGAN()

```

通过这样的结构融合,混合GAN可以吸收各个子模型的优点,提高整体生成效果的多样性与质量。

# 3. GAN在艺术创作中的实践

随着深度学习的不断发展,生成对抗网络(GAN)已经成为艺术创作领域中一个重要的研究方向。本章将探讨GAN在艺术创作中的实践应用,从图像生成到视频和音乐创作,再到三维建模和动画,将详细介绍GAN如何在不同艺术领域展现其独特的魅力。

## 3.1 GAN在图像生成中的应用

### 3.1.1 人脸生成的案例分析

GAN在图像生成领域的一个显著应用是人脸生成。通过训练,GAN能够生成高分辨率的人脸图片,不仅具有真实感,还能创造出不存在的人脸形象。一个典型的案例是DeepFake技术,它通过GAN生成逼真的换脸视频。以下是使用GAN进行人脸生成的几个关键步骤:

1. **数据集准备**:收集大量人脸图片作为训练数据。

2. **模型搭建**:设计生成器和判别器的神经网络结构。

3. **训练过程**:利用对抗损失,训练生成器和判别器。

4. **生成和优化**:使用训练好的模型生成新的人脸图片,并进行优化。

```python

# 一个简单的人脸生成代码示例(使用keras框架)

from keras.models import Sequential

from keras.layers import Dense, Flatten, Conv2D, BatchNormalization, LeakyReLU

# 生成器网络结构

def build_generator(z_dim):

model = Sequential()

model.add(Dense(128 * 8 * 8, input_dim=z_dim))

model.add(LeakyReLU(alpha=0.01))

```

0

0