AlexNet的网络结构详解与逐层分析

发布时间: 2024-04-15 03:32:56 阅读量: 202 订阅数: 47

数据结构-栈与队列详解

# 1. 诞生背景与发展历程

人工智能与深度学习的兴起,为卷积神经网络的发展提供了坚实基础。随着大数据的到来,以及计算机硬件性能的提升,卷积神经网络得以快速发展。在此过程中,LeNet、AlexNet等经典模型不断涌现,推动着卷积神经网络领域的进步。卷积神经网络的诞生离不开科学家们对生物神经系统的深入研究,以及对图像处理、模式识别等领域需求的不断拓展。逐步透过卷积、池化等操作,网络学习到抽取特征的方法,进而实现图像识别、语音识别等复杂任务。卷积神经网络的发展历程展现了人工智能不断突破的过程,为未来的智能科技发展奠定了坚实基础。

# 2. 卷积神经网络基础知识

卷积神经网络(Convolutional Neural Network, CNN)是一种类似生物神经网络结构的人工神经网络,主要应用于图像识别、语音识别等领域。本章节将介绍卷积神经网络的基础知识,包括神经元和权重以及卷积层的工作原理。

### 神经元和权重

神经元是神经网络的基本组成单元,每个神经元会接收输入并产生输出。在卷积神经网络中,神经元与前一层的神经元通过权重连接,权重表示了不同神经元之间连接的强度及方向。神经元会将输入信号与对应的权重相乘,经过激活函数后输出结果。

### 卷积层的工作原理

卷积层是卷积神经网络的核心组件,能够有效提取输入数据的特征。通过卷积操作,卷积核在输入数据上滑动进行特征提取,实现对图像的局部感知。卷积操作不仅能减少参数数量,还能保留空间结构信息。

#### 卷积核与滤波器的概念

卷积核是卷积操作中的参数矩阵,通过卷积核对输入数据进行滤波,提取特定的特征。滤波器则是由多个卷积核组成,每个卷积核负责提取不同的特征,通过滤波器可以得到更加丰富的特征表示。

#### 感受野和步幅的作用

感受野是指卷积层中每个神经元对输入数据的局部感知范围,感受野越大,神经元所包含的信息就越广泛。步幅则是卷积核在输入数据上移动的跨度,步幅较大可以减少特征图的大小,加快计算速度。

以上是关于卷积神经网络基础知识的介绍,神经元和权重的作用以及卷积层的工作原理是理解卷积神经网络的重要基础。

# 3. 卷积神经网络的经典结构

卷积神经网络(Convolutional Neural Networks, CNN)作为一种深度学习模型,在计算机视觉领域有着极其广泛的应用。在CNN结构中,经典的模型有许多,其中包括LeNet-5和VGG。这些经典结构在不同层面上都有各自的特点和优势,下面我们将详细介绍它们的结构及原理。

### 3.1 LeNet-5模型

LeNet-5模型是由Yann LeCun等人于1998年提出的,可以说是CNN的鼻祖之一。LeNet-5主要包含卷积层、池化层和全连接层。下面将详细介绍LeNet-5模型中池化层和激活函数的作用及类型。

#### 3.1.1 池化层的作用及类型

池化层是CNN中重要的一部分,它的作用在于逐步减小特征图的空间尺寸,从而减少参数数量、控制过拟合。池化层的主要类型有最大池化(Max Pooling)和平均池化(Average Pooling)。其中,最大池化保留特征图中的最大值,而平均池化则取平均值作为输出。

#### 3.1.2 激活函数的选择与影响

在LeNet-5模型中,激活函数的选择对于网络的表达能力有着重要影响。常用的激活函数有Sigmoid、ReLU、Tanh等。其中,Sigmoid激活函数存在梯度消失问题,ReLU函数通过解决了这一问题而被广泛使用。激活函数的选择直接影响了CNN的非线性拟合能力。

### 3.2 VGG模型

VGG模型是由牛津大学的研究团队提出的,它以其简单而有效的结构而闻名。VGG模型的特点在于使用了较小的卷积核,多次堆叠卷积层和池化层,从而构建了深度的网络结构。

#### 3.2.1 深度网络的挑战与优势

VGG模型的深度结构给网络的训练带来了挑战,如梯度消失、梯度爆炸等问题。然而,深度网络能够更好地拟合复杂的数据,提高了网络的表达能力和泛化能力。

#### 3.2.2 池化层与卷积核大小的关系

在VGG模型中,池化层和卷积核大小的选择直接影响了网络的感受野大小和特征提取能力。合适的池化层和卷积核大小可以帮助网络更好地捕捉特征信息,并且减少参数数量,提高计算效率。

# 4. AlexNet的创新与贡献

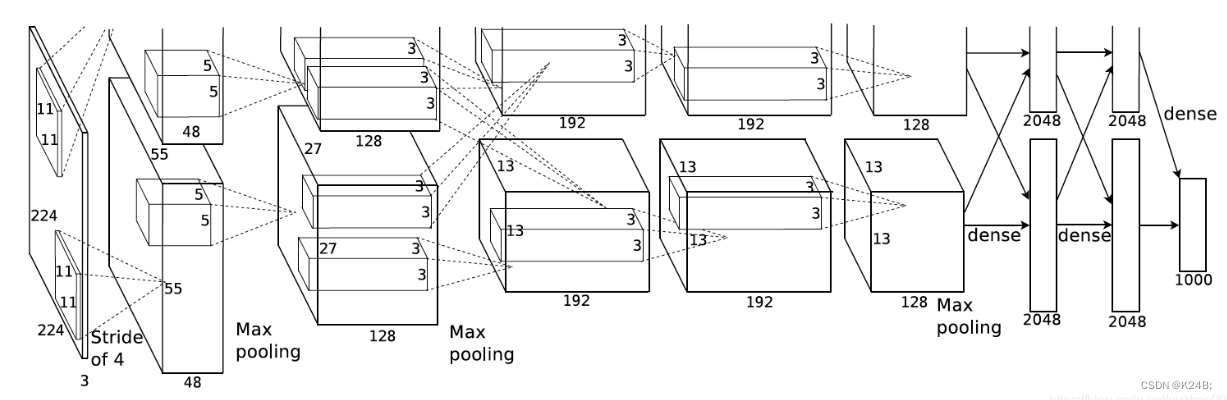

#### 4.1 双GPU并行计算下的训练加速

在卷积神经网络领域,计算速度一直是一个关键问题。AlexNet 在这方面做出了一项重要的贡献,即利用双 GPU 并行计算来加速训练过程。双 GPU 的使用是为了使得神经网络的训练速度得到显著提升。通过将网络的一半放在一个 GPU 上,另一半放在另一个 GPU 上,可以同时进行运算,极大地减少了整体训练时间。

##### 4.1.1 数据并行与模型并行的区别

数据并行和模型并行是两种不同的并行计算方式。数据并行是指将不同的数据分别送至多个 GPU 上进行处理,然后将结果进行汇总;而模型并行是指将模型拆分成不同部分,分别在不同的 GPU 上计算。在 AlexNet 中,采用了数据并行的方式来进行双 GPU 计算,从而提高了训练效率。

##### 4.1.2 实验结果与效果评估

经过实验验证,使用双 GPU 计算的 AlexNet 相比传统单 GPU 计算,在训练速度上有了明显的提升,同时在准确率上也有更好的表现。这一创新为后续深度学习模型的训练加速提供了有益的借鉴,提高了模型的效率和性能。

#### 4.2 数据增强与Dropout技术的应用

除了双 GPU 计算的创新,AlexNet 还引入了数据增强和 Dropout 技术,进一步提升了模型的泛化能力和鲁棒性。

##### 4.2.1 为什么需要数据增强

数据增强通过对原始数据进行随机变换和扩充,可以增加数据的多样性,防止模型出现过拟合的情况。在训练过程中引入数据增强,可以有效提高模型的泛化能力,使其更好地适应各种场景和数据。

##### 4.2.2 Dropout对于过拟合问题的缓解作用

Dropout 是一种随机丢弃神经网络中部分单元的技术,通过随机失活一部分神经元,在每次迭代时减少神经元之间的依赖关系,从而减少过拟合的风险。AlexNet 中引入 Dropout 技术,有效地提高了模型的泛化能力,在 ImageNet 比赛等实验中也取得了显著的效果。

通过这些创新技术的引入,AlexNet 在深度学习领域取得了重要突破,并为后续深度学习模型的发展奠定了坚实的基础。

# 5. 实验结果与后续发展展望

卷积神经网络在过去的几年里取得了巨大的成功,特别是在图像识别领域。其中,AlexNet作为一个具有里程碑意义的模型,其在ImageNet竞赛中的表现引起了广泛关注。除了在竞赛中取得显著成绩外,AlexNet的设计和创新也对深度学习领域产生了深远的影响。

### 5.1 ImageNet竞赛中的突破表现

在2012年的ImageNet竞赛中,AlexNet以惊人的优势获得了冠军,将Top-5错误率从之前的约26%降低到了约16%,这一巨大的改善程度震惊了整个AI领域。AlexNet的成功不仅彰显了卷积神经网络的巨大潜力,也为深度学习未来的发展指明了方向。

#### 5.1.1 Top-5错误率的改善程度

在ImageNet竞赛中,Top-5错误率是指模型在对一张图片进行预测时,其正确结果在模型预测的前5个结果中的概率。AlexNet将这一错误率降低了约10个百分点,这个巨大的改进不仅是技术上的突破,更是对深度学习新时代的开启。

#### 5.1.2 AlexNet的影响与启示

AlexNet的成功表明了深度学习在图像识别领域具有巨大的潜力,也为之后更为复杂的模型奠定了基础。AlexNet采用了大规模的数据集和深度卷积神经网络,这种模型结构被后续的更多模型所借鉴和发展,如VGG、ResNet等,对整个深度学习研究产生了深远的影响。

### 5.2 深度学习在不同领域的应用前景

除了在图像识别领域取得成功外,深度学习在其他领域也展现出巨大的应用潜力,未来的发展前景十分广阔。

#### 5.2.1 自然语言处理中的迁移学习

深度学习在自然语言处理领域的应用日益广泛,特别是在机器翻译、文本生成、情感分析等任务中取得了显著成就。通过迁移学习,可以将在图像识别领域的优秀模型经验应用到自然语言处理任务中,取得更好的效果。

#### 5.2.2 医学影像识别的发展趋势

在医学影像识别领域,深度学习的应用也逐渐增多,包括肿瘤检测、病灶分割、疾病诊断等方面。深度学习在医学影像识别中的发展趋势是将更深层次的网络结构应用到医学图像处理中,提高诊断的准确性和效率。

综上所述,深度学习技术在不同领域的应用前景广阔,随着硬件计算能力的提升和算法的不断创新,相信深度学习将在未来取得更加显著的成就。

0

0