深入探索AlexNet中的卷积层原理与作用

发布时间: 2024-04-15 03:34:14 阅读量: 76 订阅数: 37

# 1. 深入探讨卷积神经网络(CNN)的基本原理与发展

## 1. 卷积神经网络(CNN)简介

卷积神经网络(Convolutional Neural Network,CNN)是一种强大的深度学习模型,主要用于图像识别、物体检测等任务。它的设计灵感来源于生物学中的视觉感知机制,并通过卷积层、池化层和全连接层等组件来实现特征提取和分类。在CNN中,人工神经元通过卷积操作和激活函数的作用,逐层提取并组合特征,最终实现高准确度的分类任务。

卷积操作是CNN的核心,通过卷积核对输入数据进行特征提取,减少参数数量并增加模型的共享性。卷积层的工作原理类似于滤波器在图像上滑动计算,从而捕捉局部信息并构建全局特征表示。这种局部连接和权值共享的特性使得CNN在处理大规模数据集时具有明显优势。

# 2. 卷积神经网络的发展历程

### 2.1 LeNet-5:CNN的先驱

1998年,著名的计算机科学家Yann LeCun提出了LeNet-5,这是第一个成功应用于手写数字识别的卷积神经网络模型。LeNet-5由卷积层、池化层和全连接层构成,使用梯度下降算法进行训练,其结构简洁高效,深度相比于现代CNN较浅。LeNet-5的提出开创了CNN在图像识别领域的先河,成为后续研究的重要基石。

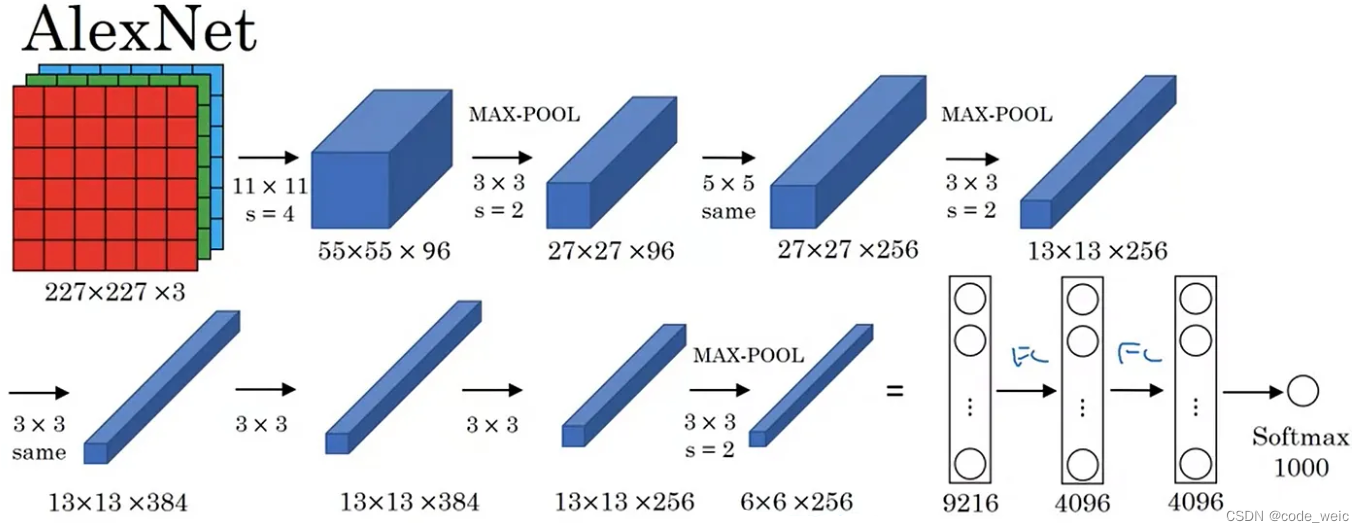

### 2.2 AlexNet:CNN的重要突破

2012年,Alex Krizhevsky等人提出了AlexNet模型,标志着CNN在图像识别任务中取得重要突破。AlexNet利用了更深的网络结构和大规模的数据集进行训练,在ImageNet比赛中取得压倒性优势,引领了深度学习研究的新浪潮。AlexNet的成功证明了深度卷积神经网络在图像识别中的巨大潜力,为后续的研究奠定了基础。

### 2.3 VGG-16:卷积网络的深度探索

2014年,牛津大学的VGG团队提出了VGG-16模型,通过堆叠多个卷积层和池化层来构建非常深的神经网络。VGG-16的结构简单而优雅,所有卷积层都采用3x3的小型卷积核,使得网络具有较小的参数量和较强的非线性表达能力。VGG-16在ImageNet比赛中取得优异成绩,证明了深度卷积神经网络的有效性和可扩展性。

### 2.4 GoogLeNet:Inception模块的引入

2014年,Google团队提出了GoogLeNet,引入了Inception模块的概念。Inception模块使用不同大小的卷积核和池化层并行处理输入,然后将它们串联起来,增加了网络的宽度和非线性表达能力。GoogLeNet在深度和性能之间取得了平衡,成为了后续深度网络结构设计的重要范本。

### 2.5 残差网络(ResNet):解决深度网络退化问题

2015年,微软亚洲研究院提出了残差网络(ResNet),通过引入残差块的设计思想,成功解决了深度神经网络退化问题。残差块中的跳跃连接可以让信息直接传递到后续层,缓解了梯度消失和梯度爆炸问题,使得可以训练更深的网络。ResNet在ImageNet比赛中夺冠,证明了其对于训练极深网络的有效性。

### 2.6 密集连接网络(DenseNet):最大程度利用特征

2016年,密歇根大学的团队提出了密集连接网络(DenseNet),在ResNet的基础上进一步增强了特征传递的效果。在DenseNet中,每个层都直接与其他层相连,使得网络可以最大程度地利用各层的特征。DenseNet在一些图像分类和目标检测任务中取得了优秀表现,证明了其在特征重用方面的优势。

### 2.7 MobileNet:轻量级卷积神经网络设计

2017年,Google提出了MobileNet,旨在解决在移动设备上部署深度学习模型时的性能和存储限制。MobileNet采用深度可分离卷积等轻量级设计策略,在保持较高准确率的情况下大幅减小模型大小和计算量。MobileN

0

0