Python解释器从零到一:构建过程中的token模块实现

发布时间: 2024-10-11 03:28:16 阅读量: 84 订阅数: 38

# 1. Python解释器概览与token模块的重要性

Python作为一种广泛使用的编程语言,其解释器背后的机制对于理解和优化代码至关重要。在这一章节中,我们将简单地浏览Python解释器的全貌,然后重点讨论token模块在解释器中的核心角色。

首先,让我们探讨Python解释器的基本组成部分。解释器可以被想象成一系列步骤的集合,它接受Python代码作为输入,并通过词法分析、语法分析、语义分析等多个阶段,最终执行代码。在这些步骤中,token模块扮演着至关重要的角色。

Token是代码分析过程中的基本单元,代表了编程语言中的关键字、操作符、标识符等。token模块就是专门用来处理这些token的,它将源代码文本分解成一个个可识别的token,为后续的编译或解释过程做好准备。理解token模块的重要性,不仅有助于开发者深入理解Python的工作原理,还能指导他们在编写解释器或编译器时,如何更好地处理和优化token的生成和管理。

接下来的章节我们将详细探讨token模块是如何与Python解释器的其他部分协同工作的,并且实际操作如何实现和应用token模块。

# 2. 理解Python解释器构建过程中的理论基础

### 2.1 Python语言的词法分析简介

#### 2.1.1 词法分析的作用和目的

词法分析是编译过程中的第一阶段,其作用是将源代码字符串转换为一个个有意义的词素(token),为后续的语法分析提供基础。在Python解释器构建过程中,词法分析的目的主要有以下几点:

- **提供基本语法单元**:将连续的字符序列分解为一个个独立的语法单元,如关键字、标识符、常量等。

- **简化语法分析**:通过词法分析,可以减少语法分析的复杂度,因为语法分析只需要处理有限的、明确的token类型。

- **记录位置信息**:每个token通常会包含位置信息,这对于错误定位和调试十分关键。

```python

# 示例代码,展示一个简单的词法分析器的伪代码:

def lexical_analyzer(source_code):

tokens = []

while source_code:

# 分析下一个token并移除源代码中的空格和注释

token, source_code = analyze_next_token(source_code)

tokens.append(token)

return tokens

```

在这个例子中,`lexical_analyzer`函数接收源代码字符串,通过`analyze_next_token`函数逐步识别并提取出token,最终返回token列表。

#### 2.1.2 词法单元(token)的定义和分类

在Python语言中,token可以定义为最小的语法单元,每个token代表了源代码中的一个特定部分。它们可以被分类为以下几种主要类型:

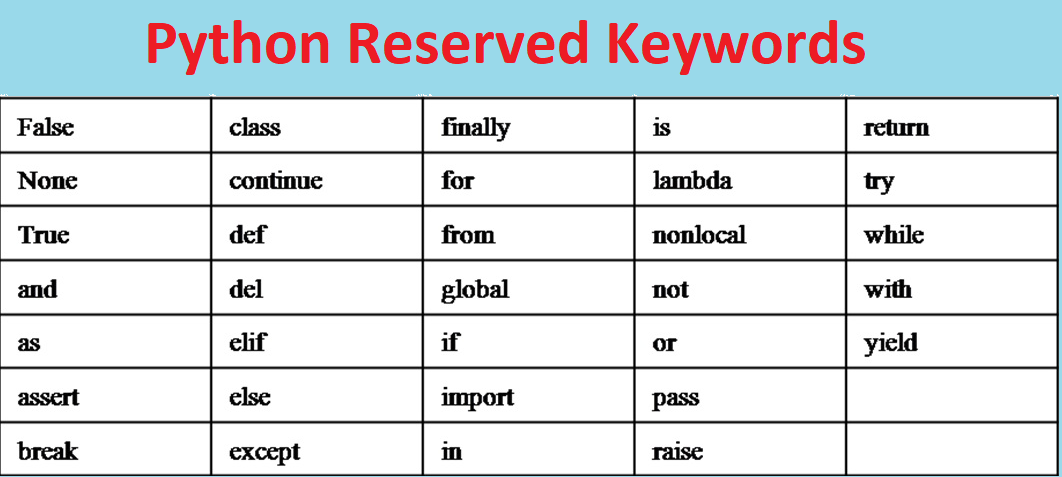

- **关键字**:如`if`, `else`, `while`等,这些词汇在Python中有特定的语义。

- **标识符**:变量名、函数名等,用于命名用户定义的实体。

- **操作符**:如`+`, `-`, `*`, `/`等,用于执行运算。

- **字面量**:整数、浮点数、字符串、布尔值等表示数据的符号。

- **特殊符号**:用于标记代码结构的符号,如括号、逗号等。

```python

# 示例,构建一个简单的token分类:

token_categories = {

'KEYWORD': ['if', 'else', 'while'],

'IDENTIFIER': [],

'OPERATOR': ['+', '-', '*', '/'],

'LITERAL': [],

'SPECIAL_SYMBOL': ['(', ')', ',']

}

def classify_token(token):

for category, tokens in token_categories.items():

if token in tokens:

return category

return 'UNKNOWN'

```

在上面的Python代码段中,我们定义了一个简单的token分类,并提供了一个函数`classify_token`用于根据token的值将其归类。

### 2.2 解释器的工作原理

#### 2.2.1 解释器的基本概念

解释器是一种程序,它读取源代码,并立即执行其中的指令。解释器不会生成中间代码,而是直接在运行时对每行代码进行解析和执行。Python解释器遵循这一定义,提供了交互式执行代码的能力,允许用户边写代码边看到执行结果。

#### 2.2.2 词法分析在解释器中的位置和作用

在Python解释器中,词法分析是整个执行过程的初始阶段。一旦源代码被输入到解释器,首先进行的就是词法分析。词法分析器将源代码分解成一系列的token,这些token随后被送入到语法分析器中。语法分析器会对这些token进行语法结构的检查和处理,然后生成对应的抽象语法树(AST),AST再被进一步解释执行。

```mermaid

graph LR

A[源代码] --> B[词法分析器]

B --> C[Token序列]

C --> D[语法分析器]

D --> E[抽象语法树 AST]

E --> F[解释执行]

```

通过mermaid格式的流程图,我们能清晰看到Python解释器的执行流程,其中词法分析器是源代码和AST之间的桥梁。

### 2.3 token模块的理论模型

#### 2.3.1 token模块的架构设计

token模块是Python解释器中处理词法分析的核心组件。它主要负责将源代码文本转换为token列表。这个模块通常需要能够处理各种不同的字符和编码,并且能够准确地识别不同类型的token。

在架构设计上,token模块需要考虑到性能,因此它通常会使用高效的数据结构来存储token,比如使用链表、数组或者更高级的数据结构来保存token序列。

```python

class Token:

def __init__(self, type, value, line):

self.type = type

self.value = value

self.line = line

class TokenList(list):

def append(self, token):

if not isinstance(token, Token):

raise TypeError("Token expected")

super().append(token)

```

在上述代码示例中,我们定义了`Token`类用于表示单个token,`TokenList`类用于管理token序列,这是token模块架构设计中的一种可能实现方式。

#### 2.3.2 token模块与词法分析的关系

token模块与词法分析紧密相关。在Python解释器的构建过程中,token模块扮演着词法分析器的角色。它不仅需要能够准确地从源代码中提取token,还需要能够管理这些token的生命周期,包括它们的生成、识别、存储和在需要时的访问。

```python

# 伪代码,展示token模块与词法分析的交互

def tokenize(source_code):

# token模块提供的接口,将源代码转换为token列表

token_list = token_module.process(source_code)

return token_list

```

在上述示例中,`tokenize`函数展示了token模块如何被词法分析过程使用。`token_module.process`是该模块

0

0