Python开发者必读:掌握token解析器编写技巧与实战案例

发布时间: 2024-10-11 02:27:54 阅读量: 49 订阅数: 34

# 1. Token解析器基础概念

## 1.1 Token解析器的角色与功能

Token解析器是编译器或解释器中的一个核心组件,负责将输入的源代码文本转换成Token序列。Token可以视为源代码中最小的有意义的符号单元。解析器的主要作用在于为后续的编译或解释步骤准备结构化的数据表示。

## 1.2 Token和解析过程的重要性

理解Token和解析过程对于整个软件开发周期至关重要,因为它们是许多自动化工具,如语法高亮、代码静态分析和自动化测试的基础。解析器确保了源代码被正确地分解并以一种计算机可理解的方式来处理。

## 1.3 解析器的输入与输出

解析器接收字符序列作为输入,输出为一个Token序列,可能还会包含语法分析树,这是后续处理步骤的输入。这个过程对保持代码的原始意图和结构至关重要,使得进一步的代码分析和处理成为可能。

在下一章中,我们将深入探讨解析器的理论基础,包括解析器的工作原理、主要类型以及设计原则。理解这些将帮助你建立起对Token解析器更深层次的认识。

# 2. Token解析器的理论基础

### 2.1 解析器的工作原理

解析器是编译器和解释器中的核心组件,其工作原理涉及两个主要步骤:词法分析与语法分析。这两个步骤共同作用,将源代码转化为更抽象的结构,如抽象语法树(AST)。

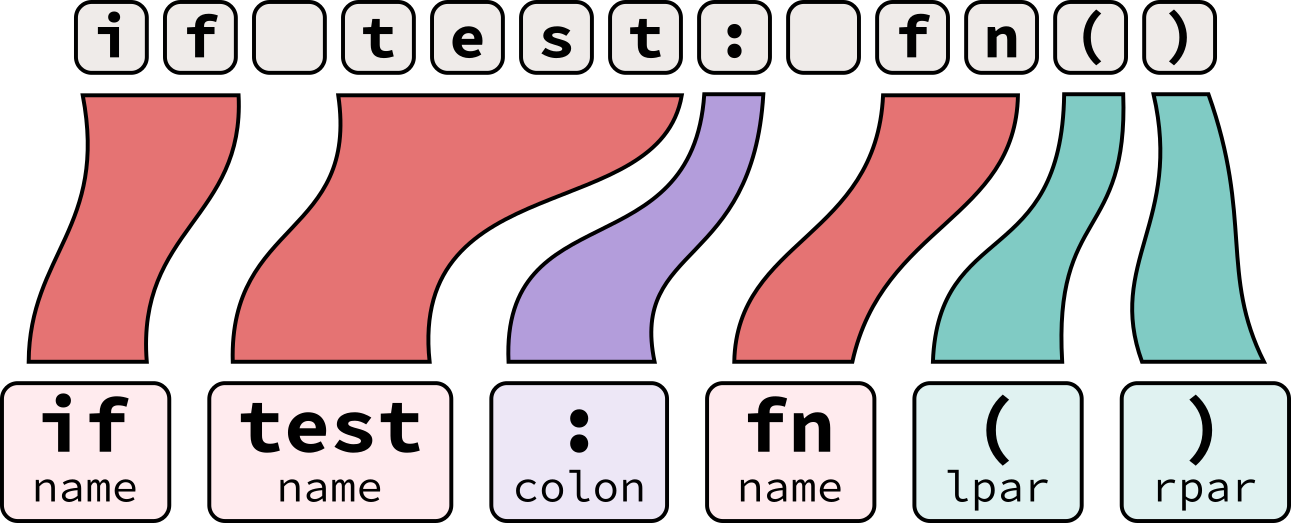

#### 2.1.1 词法分析与语法分析

- **词法分析**:源代码首先经过词法分析,将字符序列分解为一系列的标记(Tokens)。例如,代码`int x = 0;`会被分解为`int`、`x`、`=`、`0`和`;`这些标记。词法分析器的输出通常是一个标记序列。

- **语法分析**:这些标记随后由语法分析器处理,将它们组合成层次化的结构,如AST。AST保留了源代码的语法结构,便于后续处理。

例如,语法分析器会识别出`int x = 0;`中的赋值操作,并构建出相应的节点。而`AST`的结构可能如下所示:

```mermaid

graph TD

A[CompilationUnit] --> B[GlobalDeclaration]

B --> C[Type]

C --> D[int]

B --> E[VariableDeclarator]

E --> F[VariableName]

F --> G[x]

B --> H[AssignmentExpression]

H --> I[VariableName]

I --> J[x]

H --> K[NumberLiteral]

K --> L[0]

A --> M[TerminalSemicolon]

```

### 2.2 解析器的主要类型

解析器有不同的类型,它们各有优劣,适用于不同的场景。

#### 2.2.1 递归下降解析器

递归下降解析器是最简单的解析器类型之一。它由一组相互递归的函数组成,每个函数负责一个非终结符。这种解析器易于理解且易于实现,适合小型语言。

#### 2.2.2 表驱动解析器

表驱动解析器使用解析表来控制解析过程。它与递归下降解析器不同,将解析决策逻辑与代码分离,使得解析表可以独立于源代码进行修改。这种解析器更适合复杂的语言,如编译器中的语法分析。

#### 2.2.3 算法解析器

算法解析器使用特定的算法,例如LL、LR、LALR等,来构造解析表。它们能够处理包括嵌套结构在内的复杂语法。例如,LR解析器能够处理更广泛的语法结构,并且具有较好的预测性能。

### 2.3 解析器的设计原则

设计一个好的解析器需要考虑可扩展性和健壮性,以便于后续的维护和改进。

#### 2.3.1 解析器的可扩展性

可扩展性允许开发者在未来能够轻松添加新的语法结构,而不需要彻底重写解析器。面向对象的设计和模块化是实现可扩展性的关键技术。

#### 2.3.2 解析器的健壮性

健壮性指的是解析器能够优雅地处理错误,不论是语法错误还是其他异常情况。它需要提供清晰的错误信息,快速恢复并继续处理输入流。良好的错误处理机制是保证用户友好体验的关键。

# 3. Token解析器的实现

## 3.1 Python中的解析器库

解析器在编程中扮演着重要角色,Python作为一种广泛使用的高级编程语言,有着丰富的第三方库来支持解析器的实现。Python中的解析器库不仅有助于简化开发流程,还能提升解析器的性能和可靠性。

### 3.1.1 选择合适的解析器库

在Python中实现Token解析器,首先需要选择一个合适的库。这个选择取决于项目的具体需求,以及解析器将要处理的语言或数据格式。以下是一些流行的解析器库:

- **PLY (Python Lex-Yacc)**: 这个库基于著名的lex和yacc工具,它允许开发者通过定义词法规则和语法规则来创建解析器。PLY非常适合于复杂语言的解析任务。

- **Parsley**: 这是一个基于解析表达式语法(PEG)的解析库,它提供了一种更简洁的方式来定义解析器。PEG语言支持回溯,使其更适合于实现递归下降解析器。

- **TatSu**: 又称为语法工具,这个库是用Python编写的,它允许开发者使用类似于BNF(巴科斯-诺尔范式)的语法描述来定义解析器。

选择合适的库时,需要考虑以下因素:

- **社区支持和文档**: 一个活跃的社区和详尽的文档可以帮助解决开发中遇到的问题。

- **性能**: 根据项目的规模和性能要求,选择性能最优的解析器库。

- **易用性**: 开发者熟悉的语法和库的API设计也是选择时的重要考量因素。

- **维护**: 确认库是否还在积极维护,这对于长期项目的稳定运行至关重要。

### 3.1.2 使用解析器库的基本步骤

使用Python解析器库的基本步骤可以分为以下几个阶段:

1. **安装解析器库**: 通常,可以使用pip包管理器来安装所需的库。例如,安装PLY可以通过以下命令:

```bash

pip install ply

```

2. **定义词法规则**: 根据输入的语言或数据格式,定义相关的词法规则。这些规则描述了源代码中的原子符号或Token。

3. **定义语法规则**: 语法规则定义了Token组合成语句和表达式的方式。这些规则通常以一种类似于BNF或EBNF(扩展巴科斯-诺尔范式)的形式来描述。

4. **构建解析器**: 使用解析器库提供的工具根据定义的规则来构建解析器。

5. **编写解析逻辑**: 解析器库通常提供一种回调机制或特定的代码段,用于在解析过程中执行具体的操作。

6. **测试解析器**: 解析器构建完成后,需要进行测试以确保其正确性。测试包括对各种合法和非法输入的测试。

以下是一个简单的PLY使用示例,展示了如何定义词法规则和语法规则:

```python

import ply.lex as lex

import ply.yacc as yacc

# 定义词法规则

tokens = ('NUMBER', 'PLUS', 'MINUS', 'LPAREN', 'RPAREN')

t_PLUS = r'\+'

t_MINUS = r'-'

t_LPAREN = r'\('

t_RPAREN = r'\)'

def t_NUMBER(t):

r'\d+'

t.value = int(t.value)

return t

# 定义语法规则

def p_expression_plus(t):

'expression : expression PLUS term'

t[0] = t[1] + t[3]

def p_expression_minus(t):

'expression : expression MINUS term'

t[0] = t[1] - t[3]

def p_expression_term(t):

'expression : term'

t[0] = t[1]

def p_term(t):

'term : term TIMES factor'

t[0] = t[1] * t[3]

# ...

# 错误处理规则

def p_error(t):

print("Syntax error at '%s'" % t.value)

# 构建解析器

parser = yacc.yacc()

# 解析输入

result = parser.parse('3 + 4')

print(result) # 输出: 7

```

在这个示例中,我们定义了一个简单的算术表达式解析器,能够处理加法和乘法。

## 3.2 构建自定义解析器

尽管使用现成的解析器库可以加快开发速度,但在某些情况下,我们可能需要构建自定义解析器来满足特定的需求。

### 3.2.1 词法分析器的编写

词法分析器(Lexer)是解析器的第一部分,它的任务是从输入的字符流中识别出一个个独立的Token。编写词法分析器需要遵循以下步骤:

1. **定义Token**: 明确Token的类型和格式。例如,一个整数Token可能表示为数字序列,一个标识符可能是一个字母或数字序列。

2. **实现Token识别**: 编写代码来匹配输入字符流中的Token模式。

3. **忽略空白和注释**: 在词法分析阶段,通常会忽略空白符和注释。

4. **返回Token**: 当识别到一个Token时,需要将其返回给语法分析器。

在Python中,可以使用正则表达式来帮助识别Token。下面是使用`re`模块来实现一个简单的词法分析器的示例:

```python

import re

# 正则表达式定义Token

number_regex = ***pile(r'[0-9]+')

plus_regex = ***pile(r'\+')

minus_regex = ***pile(r'-')

multiply_regex = ***pile(r'\*')

divide_regex = ***pile(r'/')

# 词法分析函数

def lexical_analysis(input_string):

tokens = []

cursor = 0

while cursor < len(input_string):

match = None

if (match := number_regex.match(input_string, cursor)):

token = ('NUMBER', match.group(0))

elif (match := plus_regex.match(input_string, cursor)):

token = ('PLUS', '+')

elif (match := minus_regex.match(input_string, cursor)):

token = ('MINUS', '-')

elif (match := multiply_regex.match(input_string, cursor)):

token = ('MULTIPLY', '*')

elif (match := divide_regex.match(input_string, cursor)):

token = ('DIVIDE', '/')

else:

raise ValueError(f"Unrecognized token at position {cursor}")

tokens.append(token)

cursor += match.end()

return tokens

```

### 3.2.2 语法分析器的编写

语法分析器(Parser)是解析器的第二部分,它的任务是将词法分析器识别出的Token序列按照语法规则组织成抽象语法树(AST)。编写语法分析器的步骤包括:

1. **定义语法规则**: 描述Token如何组合成语句或表达式。

2. **构建解析表**: 根据语法规则,构建一个状态机或解析表,用于指导解析过程。

3. **实现解析逻辑**: 根据解析表进行递归下降解析或表驱动解析。

4. **生成AST**: 在解析的过程中,构建AST节点。

5. **错误处理**: 当遇到语法错误时,提供适当的错误信息和处理机制。

下面是一个基于递归下降的简单解析器框架,用于解析加减乘除表达式:

```python

class ExpressionParser:

def __init__(self, lexer):

self.lexer = lexer

self.tokens = iter(lexer.lexemes)

self.next_token()

def next_token(self):

try:

self.current_token = next(self.tokens)

except StopIteration:

self.current_token = None # End of input

def parse(self):

result = self.expression()

if self.current_token is not None:

raise SyntaxError('Unexpected token found')

return result

def expression(self):

result = self.term()

while self.current_token in ('+', '-'):

if self.current_token == '+':

self.next_token()

result = ('+', result, self.term())

elif self.current_token == '-':

self.next_token()

result = ('-', result, self.term())

return result

def term(self):

result = self.factor()

while self.current_token in ('*', '/'):

if self.current_token == '*':

self.next_token()

result = ('*', result, self.factor())

elif self.current_token == '/':

self.next_token()

result = ('/', result, self.factor())

return result

def factor(self):

token = self.current_token

if token is None:

raise SyntaxError('Unexpected end of input')

elif token.isdigit():

self.next_token()

return ('NUMBER', int(token))

elif token == '(':

self.next_token()

result = self.expression()

if self.current_token != ')':

raise SyntaxError('Expected closing parenthesis')

self.next_token() # Consume ')'

return result

else:

raise SyntaxError(f'Invalid token: {token}')

```

### 3.2.3 错误处理与调试

在构建解析器的过程中,错误处理和调试是不可或缺的环节。良好的错误处理机制可以在解析过程中快速定位问题所在,同时提供清晰的错误信息以协助调试。以下是几个错误处理与调试的关键点:

- **记录错误位置**: 当解析器遇到错误时,应该记录并报告Token的位置信息,这样便于开发者定位问题。

- **生成有意义的错误消息**: 错误消息应该能够反映出错误的类型以及可能的解决方向。

- **使用断言**: 在解析器中使用断言来确保在关键节点的逻辑正确性。

- **日志记录**: 记录解析过程中的关键事件,有助于分析解析器的工作状态。

- **调试信息**: 在开发阶段,提供足够的调试信息可以大大加快调试速度。可以通过调整日志级别来控制输出的详细程度。

构建解析器的过程可能充满了挑战,但是通过上述方法可以有效地应对开发中的问题,确保解析器的正确性和鲁棒性。

## 3.3 实战案例分析

通过实际案例来分析解析器的构建和使用,不仅可以加深理解,而且能够从中获得实践经验。

### 3.3.1 简单表达式解析器

假设我们需要构建一个简单的表达式解析器,它能够处理包含加减乘除的算术表达式。以下是一个基于PLY库构建的简单表达式解析器的示例:

```python

import ply.lex as lex

import ply.yacc as yacc

# Token定义

tokens = ('NUMBER', 'PLUS', 'MINUS', 'TIMES', 'DIVIDE')

# 正则表达式

t_PLUS = r'\+'

t_MINUS = r'-'

t_TIMES = r'\*'

t_DIVIDE = r'/'

t_NUMBER = r'\d+'

# 忽略空白

t_ignore = ' \t'

# 错误处理函数

def t_error(t):

print(f"Illegal character '{t.value[0]}'")

t.lexer.skip(1)

# 构建词法分析器

lexer = lex.lex()

# 语法规则

def p_expression(p):

'''expression : expression PLUS term

| expression MINUS term'''

if p[2] == '+':

p[0] = ('+', p[1], p[3])

else:

p[0] = ('-', p[1], p[3])

def p_expression_term(p):

'expression : term'

p[0] = p[1]

def p_term(p):

'''term : term TIMES factor

| term DIVIDE factor'''

if p[2] == '*':

p[0] = ('*', p[1], p[3])

else:

p[0] = ('/', p[1], p[3])

def p_term_factor(p):

'term : factor'

p[0] = p[1]

def p_factor_number(p):

'factor : NUMBER'

p[0] = ('NUMBER', p[1])

def p_factor_group(p):

'factor : LPAREN expression RPAREN'

p[0] = p[2]

# 错误处理规则

def p_error(p):

print("Syntax error at '%s'" % p.value)

# 构建语法分析器

parser = yacc.yacc()

# 测试解析器

while True:

try:

s = input('calc > ') # 从用户获取输入

except EOFError:

break

if s:

result = parser.parse(s)

print(result)

```

在这个实战案例中,我们使用PLY库定义了简单的算术表达式的词法规则和语法规则,并构建了一个解析器。用户输入一个表达式后,解析器会生成并返回相应的AST。

### 3.3.2 配置文件解析器

解析器还可以用于解析配置文件,例如INI文件。以下是一个解析INI文件的解析器的示例:

```python

import re

# 定义Token

key_value_regex = ***pile(r'^(\w+)=(.*)$')

section_regex = ***pile(r'^\[(.+)\]$')

# 词法分析器

def lexer(config_string):

sections = []

key_value_pairs = {}

section = None

for line in config_string.strip().splitlines():

section_match = section_regex.match(line)

if section_match:

sections.append(section_match.group(1))

section = section_match.group(1)

key_value_pairs = {}

continue

key_value_match = key_value_regex.match(line)

if key_value_match:

key = key_value_match.group(1)

value = key_value_match.group(2).strip()

key_value_pairs[key] = value

return sections, key_value_pairs

# 语法分析器

def parse_ini(config_string):

sections, key_value_pairs = lexer(config_string)

config_dict = {}

for section in sections:

config_dict[section] = {}

for key, value in key_value_pairs.items():

config_dict[section][key] = value

return config_dict

# 使用解析器

config_string = """

[database]

host=localhost

port=3306

[server]

ip=***.***.*.*

port=8080

parsed_config = parse_ini(config_string)

print(parsed_config)

```

在这个例子中,我们定义了一个简单的词法分析器和语法分析器,它们共同工作来解析INI配置文件,并将其转换成Python字典。这样,我们就可以用标准的字典访问方式来获取配置值了。

在构建解析器的过程中,我们学习了如何选择和使用解析器库,如何从零开始构建词法分析器和语法分析器,以及如何进行错误处理与调试。通过实战案例的分析,我们加深了对解析器构建和应用的理解,这有助于我们解决实际编程中遇到的解析问题。

# 4. Token解析器的应用与优化

## 4.1 解析器在编译器中的应用

### 4.1.1 编译器的前端和后端

在现代编译器设计中,解析器通常位于编译器的前端。它负责读取源代码,生成中间表示(Intermediate Representation,IR),然后将这些中间表示传递给后端进行优化和目标代码生成。编译器前端的任务可以被看作是将源代码转换成一个更易于分析和优化的格式。

编译器前端包括:

- **词法分析器(Lexer)**:将源代码文本分割成一个个有意义的单元,称为Token。

- **语法分析器(Parser)**:根据语法规则,将Token序列构造成抽象语法树(Abstract Syntax Tree,AST)。

- **语义分析器**:在AST的基础上进行类型检查、作用域解析等,以确保源代码符合编程语言规范。

- **中间代码生成器**:将AST转换成中间代码,这是一系列平台无关的低级代码。

编译器后端的任务则主要集中在:

- **优化**:对中间代码进行优化处理,提高代码执行效率。

- **目标代码生成**:根据特定的硬件平台和操作系统,生成可执行代码。

- **链接**:将目标代码与库文件链接起来,生成最终的可执行文件。

### 4.1.2 解析器在编译过程中的角色

解析器在编译过程中扮演着核心角色,它决定了编译器能否正确地理解和处理源代码。编译器通过解析器获取的AST结构,能够进行:

- **代码优化**:AST提供了代码结构的高级视图,允许编译器在不影响程序逻辑的前提下进行优化。

- **错误检测**:解析过程中,解析器可以检测源代码中的语法错误,并提供错误信息。

- **代码转换**:AST可以用来转换代码,例如从高级语言转换为LLVM IR,这是一种广泛支持的中间表示。

## 4.2 解析器性能的优化策略

### 4.2.1 优化词法分析

词法分析阶段负责将源代码文本分解为Token。性能优化策略包括:

- **使用优化的算法**:如DFA(Deterministic Finite Automata)算法来处理词法分析,因为DFA可以实现线性时间复杂度的匹配。

- **预编译正则表达式**:避免在每次词法分析时重新编译正则表达式,以减少开销。

- **最小化状态机**:通过优化状态机的大小,可以减少词法分析时的内存占用和处理时间。

### 4.2.2 优化语法分析

语法分析器在解析Token时构建AST。性能优化措施可以是:

- **使用高效的解析算法**:递归下降解析器易于实现,但性能较差,可以采用LL、LR或LALR算法来提高性能。

- **避免重复工作**:通过缓存已经解析过的子树,以避免重复解析相同的代码片段。

- **并行处理**:将AST的构建过程分散到多个处理单元上,从而加速构建过程。

## 4.3 解析器的测试与维护

### 4.3.* 单元测试

编写单元测试是确保解析器各部分按预期工作的重要手段。单元测试需要:

- **覆盖所有可能的语法结构**:确保AST覆盖了所有可能的语法结构。

- **测试边界条件**:测试解析器在极限条件下的表现,如最大长度的输入、包含所有Token类型的输入等。

- **持续集成**:在代码变更后运行测试,确保新更改没有破坏现有功能。

### 4.3.2 代码审查与重构

代码审查和重构是维护解析器性能和可读性的关键。

- **定期代码审查**:团队成员之间定期审查代码,可以发现并修复潜在的问题,提高代码质量。

- **重构低效代码**:对于性能瓶颈,考虑重构低效代码,改善其性能和可维护性。

- **维护文档**:保持解析器的文档更新,包括使用说明、设计决策和维护记录,可以帮助开发者更好地理解和使用解析器。

## 结语

本章节深入探讨了Token解析器在编译器中的应用,包括其在编译器前端和后端的不同角色,以及如何通过优化策略提升解析器性能。同时,我们还讨论了解析器的测试和维护方法,以确保其稳定性和准确性。接下来,我们将进一步探索解析器未来的发展趋势,以及它们如何适应快速发展的编程语言和编译技术。

# 5. 未来解析器的发展趋势

## 5.1 解析器与人工智能的结合

解析器与人工智能技术的结合是近年来的一个热门研究方向。AI技术能够帮助解析器更好地理解和处理复杂的编程语言和数据格式,提高解析的准确性和效率。

### 5.1.1 机器学习在解析中的应用

机器学习,尤其是深度学习技术,已经被应用于提高解析器的性能。例如,神经网络可以训练来识别代码中的模式和结构,使得解析器在处理新的或不规范的代码时具有更好的容错性和适应性。此外,利用机器学习对解析器进行训练,可以使它对特定的编程语言或框架有更深层次的理解。

### 5.1.2 解析器的自适应学习

自适应学习解析器是能够根据已解析的数据和反馈进行调整的解析器。这意味着解析器不仅能够从错误中学习,还能够适应新的编程语言特性和编程范式。在实践中,这可以通过在线学习算法来实现,让解析器在持续的使用过程中不断改进其性能。

## 5.2 解析器的跨平台与模块化

随着软件开发的全球化和跨平台化,解析器也在向着更高的灵活性和模块化方向发展。模块化设计不仅使得解析器易于维护和升级,也为跨平台部署提供了可能。

### 5.2.1 跨语言解析器的可行性

跨语言解析器是一个能够处理多种编程语言的解析器。在这样的解析器中,可以共享解析逻辑和工具,而不同编程语言特有的解析规则则可以单独定义。这种设计大大减少了维护多种解析器的开销,同时也为创建统一的开发工具链提供了基础。

### 5.2.2 解析器的模块化设计

模块化设计是指将解析器分解成独立的组件,每个组件负责解析过程中的一个特定方面。通过这样的设计,开发者可以根据需要选择和组合不同的模块,甚至可以为特定的应用场景定制解析器。模块化还有助于并行处理和分布式解析,提高大规模数据解析的效率。

在讨论解析器的未来趋势时,我们不应忘记其对于新兴技术如量子计算、边缘计算等的适用性和可能带来的变革。解析器需要不断适应新的计算环境和技术要求,以保持其在软件开发和数据分析领域的核心地位。

0

0