【HDFS NameNode高可用性与负载均衡】:如何实现资源的最优分配

发布时间: 2024-10-28 16:45:35 阅读量: 53 订阅数: 21

Maheshwara Rao G:HDFS NameNode的高可用性研究

# 1. HDFS NameNode概述及其重要性

Hadoop分布式文件系统(HDFS)是大数据生态系统中核心组件之一,而NameNode作为HDFS的核心,负责存储和管理文件系统的元数据。了解NameNode的工作原理对于维护一个高效、稳定的大数据集群至关重要。

## NameNode的角色和职责

NameNode在HDFS中承担着“大脑”的角色。它记录了文件系统中所有文件的元数据信息,包括文件名、权限、块信息以及块存储的位置等。没有了NameNode,HDFS就无法进行文件定位和数据管理。

## NameNode的单点故障问题

尽管NameNode是集群中的核心组件,但它也存在单点故障的问题。一旦NameNode出现故障,整个HDFS集群将变得不可用。这就凸显了NameNode高可用性架构的重要性,它确保了元数据服务的连续性和可靠性。

## NameNode高可用性的重要性

为了克服单点故障问题,HDFS引入了高可用性(High Availability, HA)机制。通过设置多个NameNode,即使一个NameNode宕机,另一个NameNode可以立即接管服务,从而提高了系统的可用性和可靠性。高可用性架构是企业级HDFS部署的必备条件。

# 2. NameNode高可用性原理

### 主备NameNode的工作机制

HDFS的高可用性是通过主备NameNode的架构来实现的,这种架构允许系统在NameNode发生故障时,快速切换到备用的NameNode上,从而保证了整个集群服务的持续可用性。在这种模式下,有两个NameNode在同时运行,一个是活跃的(Active),另一个是待命的(Standby)。集群中只有一个NameNode处于活跃状态,所有的写操作都由它处理。待命的NameNode则同步活跃NameNode的状态,以准备在必要时接管服务。

活跃NameNode和待命NameNode通过内部的数据同步机制来保持数据状态的一致性。这种同步主要是通过编辑日志(EditLog)来实现的。活跃的NameNode会将所有的命名空间更改(如文件创建、删除、重命名等操作)记录在编辑日志中,并将这些变更实时地复制到待命的NameNode上。此外,HDFS还使用了称为"快照"的概念,定期在待命的NameNode上创建命名空间的快照,以此来保证数据的一致性。

当活跃NameNode发生故障时,集群会自动触发故障转移(Failover)过程。故障转移是一个自动化的过程,其目标是将待命的NameNode提升为新的活跃状态,并把它的地址通告给集群中的所有DataNode。这样,客户端就可以继续对HDFS进行读写操作,而不会受到NameNode故障的影响。

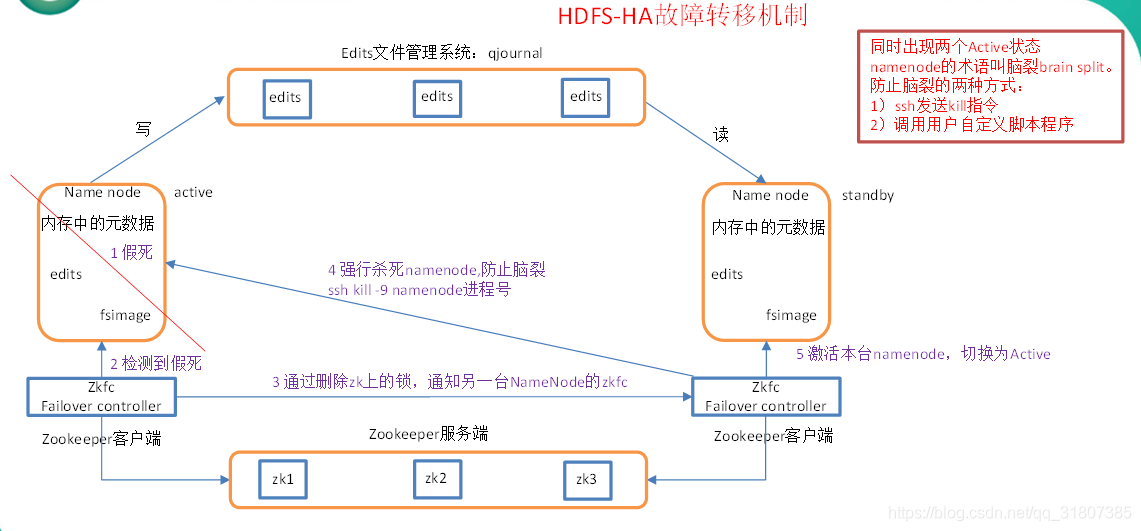

### 故障转移过程详解

故障转移过程对于HDFS的高可用性至关重要。故障转移通常由ZooKeeper提供的故障转移控制器(Failover Controller)来管理,它是HDFS高可用性解决方案中的关键组件。故障转移控制器会监控活跃NameNode的状态,并在检测到失败时触发故障转移。整个过程可以细分为以下几个步骤:

1. **检测故障**:首先,故障转移控制器会定期检查活跃NameNode的健康状态。这通常通过心跳信号来实现,如果一段时间内没有收到心跳信号,则认为活跃NameNode发生了故障。

2. **决定提升**:故障转移控制器会决定将哪个待命的NameNode提升为新的活跃节点。这个决策过程可能会考虑到各种因素,如NameNode的负载、网络状况等。

3. **确保一致性**:在将待命的NameNode提升为活跃节点之前,需要确保它具备所有必要的命名空间状态。为此,待命的NameNode会同步完所有从上次快照以来的编辑日志变更。

4. **切换服务**:一旦待命的NameNode准备就绪,故障转移控制器会切换服务,更新集群中的NameNode地址。这意味着客户端和DataNode现在需要与新的活跃NameNode通信。

5. **通知集群**:最后,新的活跃NameNode会向集群中的所有DataNode发送指令,让它们切换到新的NameNode,并重新注册到新的NameNode上。

故障转移过程中,为了确保数据的一致性和完整性,HDFS还会进行检查点(Checkpoint)操作。这通常是在故障转移完成后进行的,目的是将待命NameNode上的状态与DataNode上的文件系统状态同步,确保数据的一致性。

### 实现NameNode高可用性的关键组件

#### JournalNode的作用与配置

JournalNode是Hadoop 2.0引入的一个组件,它用于在主备NameNode之间同步编辑日志。每个编辑操作都会被写入JournalNode集群,而这些日志会被待命的NameNode读取以保持状态同步。通过这种方式,即使活跃NameNode发生故障,待命的NameNode也能够继续处理新的写操作,并保持与活跃NameNode几乎同步的状态。

在配置JournalNode时,需要在集群中部署多个JournalNode实例,并在hdfs-site.xml文件中指定JournalNode的地址列表。这样,主备NameNode都能够与JournalNode通信,保证编辑日志的同步。

#### ZooKeeper在高可用性中的角色

ZooKeeper在HDFS的高可用性架构中扮演着关键角色。它不仅负责监控NameNode的健康状态,还管理着故障转移的整个过程。ZooKeeper通过维护一个有序的状态机来跟踪集群中的各种事件,并提供了一个集中式协调机制。

在HDFS高可用配置中,需要设置ZooKeeper集群,并在hdfs-site.xml中配置ZooKeeper的连接信息。故障转移控制器会使用ZooKeeper的事件监听机制来检测活跃NameNode的故障,并在需要时触发故障转移。

#### 观察者节点的介绍与作用

观察者节点(Observer Node)是HDFS高可用性解决方案中的一个可选组件。它不是主备架构的一部分,但可以提高集群的读取性能和扩展性。观察者节点类似于待命的NameNode,但不会参与故障转移过程。它可以接收来自客户端的读请求,并允许客户端读取数据。但是,观察者节点不处理任何写操作,也不参与任何数据命名空间状态的变更。

观察者节点的优点在于它可以分散读取负载,减少对单一活跃NameNode的依赖。通过配置多个观察者节点,可以进一步提升读取性能。观察者节点的配置相对简单,只需要在hdfs-site.xml文件中设置相关参数即可。

### 高可用性实践中的常见问题及解决方案

#### 网络分区问题

网络分区(Network Partition)是指网络中的节点无法与其他节点通信的情况。在网络分区发生时,集群可能无法确定哪个NameNode是真正的活跃节点。这种情况下,为了避免数据丢失和状态不一致,HDFS会采取安全模式,停止所有的写操作,直到网络分区问题得到解决。

为了解决网络分区问题,HDFS使用了ZooKeeper投票机制。每个NameNode会在ZooKeeper中注册一个临时节点,并在心跳信号中更新这个节点的存在。如果ZooKeeper发现某一个NameNode的临时节点被删除了,那么它就被认为是不可达的,并将不会参与到故障转移过程中。

#### 数据一致性挑战

在高可用性架构中,数据一致性是一个重要挑战。由于待命NameNode需要与活跃NameNode保持同步,如果同步过程中出现延迟,就可能造成数据不一致。为了解决这个问题,H

0

0