队列在电商系统中的订单处理流程

发布时间: 2024-05-02 05:16:06 阅读量: 72 订阅数: 46

# 1. 队列的基本概念和原理

队列是一种先进先出(FIFO)的数据结构,它允许在不丢失数据的情况下,以特定的顺序添加和删除元素。队列在计算机科学中有着广泛的应用,尤其是在需要处理大量数据流或异步操作的场景中。

队列的基本原理是:

* **添加元素(入队):**将新元素添加到队列的末尾。

* **删除元素(出队):**从队列的头部移除并返回第一个元素。

* **队列长度:**队列中元素的总数。

* **队列空:**当队列中没有元素时,队列为空。

* **队列满:**当队列达到其最大容量时,队列已满。

# 2. 队列在电商系统中的应用

队列在电商系统中扮演着至关重要的角色,它可以显著提高系统的吞吐量、降低耦合度并应对突发流量。

### 2.1 订单处理流程中的队列应用

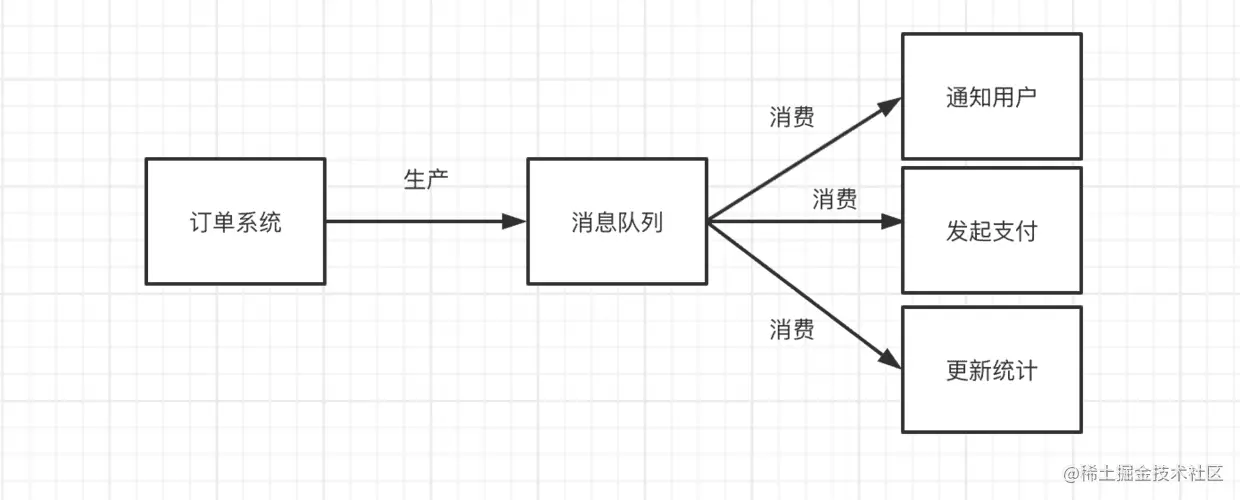

在电商系统中,订单处理是一个关键流程,涉及多个步骤和系统。队列可以有效地管理订单处理流程,确保订单的及时和准确处理。

#### 2.1.1 订单创建队列

订单创建队列用于存储新创建的订单信息。当用户提交订单时,系统会将订单信息放入队列中。队列中的订单信息将被订单处理系统消费,并触发后续的处理步骤,如库存检查、支付处理和发货准备。

#### 2.1.2 订单支付队列

订单支付队列用于存储已创建但尚未支付的订单信息。当用户完成支付时,系统会将订单信息放入队列中。队列中的订单信息将被支付处理系统消费,并触发后续的处理步骤,如订单确认和发货安排。

#### 2.1.3 订单发货队列

订单发货队列用于存储已支付且准备发货的订单信息。当订单准备发货时,系统会将订单信息放入队列中。队列中的订单信息将被发货系统消费,并触发后续的处理步骤,如物流安排和发货通知。

### 2.2 队列的优势和挑战

队列在电商系统中带来了诸多优势,但也存在一些挑战。

#### 2.2.1 提高系统吞吐量和响应时间

队列可以有效地提高系统吞吐量,因为它允许系统并行处理任务。通过将任务放入队列中,系统可以避免因等待资源而造成的延迟。队列还可以降低响应时间,因为系统可以立即将任务放入队列中,而无需等待资源释放。

#### 2.2.2 降低系统耦合度和复杂性

队列可以降低系统耦合度,因为它允许系统组件独立运行。通过将任务放入队列中,组件可以异步处理任务,而无需直接与其他组件交互。这降低了系统复杂性,并使系统更容易维护和扩展。

#### 2.2.3 应对突发流量和峰值负载

队列可以帮助系统应对突发流量和峰值负载。当系统遇到大量请求时,队列可以缓冲请求,防止系统过载。队列中的请求将被系统逐渐处理,确保系统不会崩溃。

**挑战:**

* **队列管理:**队列需要仔细管理,以确保队列长度不会过大或过小。过大的队列会导致延迟,而过小的队列会导致系统资源浪费。

* **故障处理:**队列系统可能发生故障,导致任务丢失或处理失败。因此,需要有适当的故障处理机制来确保任务的可靠处理。

* **数据一致性:**在分布式系统中,队列可能导致数据一致性问题。需要有机制来确保队列中的数据与其他系统中的数据保持一致。

# 3.1 消息队列中间件

### 3.1.1 Kafka

#### 简介

Apache Kafka 是一个分布式流处理平台,它提供了高吞吐量、低延迟的消息传递服务。Kafka 使用分区和副本机制来保证数据的可靠性和可用性。

#### 特点

* **高吞吐量:** Kafka 可以处理每秒数百万条消息,非常适合处理大数据量。

* **低延迟:** Kafka 的消息处理延迟通常在毫秒级,这使其适用于实时数据处理。

* **可靠性:** Kafka 使用分区和副本机制来保证消息的可靠性,即使发生节点故障,消息也不会丢失。

* **可扩展性:** Kafka 可以轻松地通过添加或删除节点来扩展,以满足不断增长的需求。

#### 架构

Kafka 集群由以下组件组成:

* **Broker:** 存储和管理消息的服务器。

* **Topic:** 消息的逻辑分组。

* **Partition:** Topic 的物理分区,用于提高吞吐量和可用性。

* **Producer:** 向 Topic 发送消息的客户端。

* **Consumer:** 从 Topic 消费消息的客户端。

#### 代码示例

```java

import org.apache.kafka.clients.producer.KafkaProducer;

import org.apache.kafka.clients.producer.ProducerConfig;

import org.apache.kafka.clients.producer.ProducerRecord;

import java.util.Properties;

public class KafkaProducerExample {

public static void main(String[] args) {

// 设置生产者配置

Properties properties = new Properties();

properties.put(ProducerConfig.BOOTSTRAP_SERVERS_CONFIG, "localhost:9092");

properties.put(ProducerConfig.KEY_SERIALIZER_CLASS_CONFIG, "org.apache.kafka.common.serialization.StringSerializer");

properties.put(ProducerConfig.VALUE_SERIALIZER_CLASS_CONFIG, "org.apache.kafka.common.serialization.StringSerializer");

// 创建生产者

KafkaProducer<String, String> producer = new KafkaProducer<>(properties);

// 创建消息记录

ProducerRecord<String, String> record = new ProducerRecord<>("tes

```

0

0