【奇异值分解:高维数据降维利器揭秘】:从原理到实战应用,掌握数据降维核心技术

发布时间: 2024-07-06 18:12:45 阅读量: 107 订阅数: 44

SVD.zip_SVD 融合_SVD图像降维_奇异值分解_奇异值降维_降维

# 1. 奇异值分解(SVD)概述**

奇异值分解(SVD)是一种强大的线性代数技术,用于分解矩阵为三个矩阵的乘积:一个左奇异矩阵 U,一个对角奇异值矩阵 Σ 和一个右奇异矩阵 V。SVD 在数据分析、机器学习和图像处理等领域有着广泛的应用。

SVD 的核心思想是将矩阵分解为一组正交基向量,这些基向量表示矩阵的特征方向。奇异值是对角矩阵 Σ 中的对角元素,它们表示基向量的长度,并按降序排列。

# 2.1 线性代数基础

### 2.1.1 矩阵的秩和奇异值

**矩阵的秩**

矩阵的秩表示矩阵线性无关的行或列的个数。秩为 r 的矩阵可以表示为 r 个线性无关向量的和。

**奇异值**

奇异值是矩阵特征值的推广。对于一个 m x n 矩阵 A,其奇异值 σ1, σ2, ..., σn 是矩阵 AAT 和 ATA 的特征值的平方根。

奇异值可以度量矩阵的“奇异性”,即矩阵偏离奇异矩阵的程度。奇异值较大的矩阵更接近于奇异矩阵,而奇异值较小的矩阵更接近于满秩矩阵。

### 2.1.2 奇异值分解定理

奇异值分解定理指出,任何 m x n 矩阵 A 都可以分解为以下形式:

```

A = UΣV^T

```

其中:

* U 是 m x m 正交矩阵,其列向量是 AAT 的特征向量。

* Σ 是 m x n 对角矩阵,其对角线元素是 A 的奇异值。

* V 是 n x n 正交矩阵,其列向量是 ATA 的特征向量。

奇异值分解定理将矩阵分解为三个正交矩阵和一个对角矩阵。这使得我们可以通过分析奇异值和正交矩阵来理解矩阵的性质和行为。

**代码块:**

```python

import numpy as np

# 定义一个矩阵 A

A = np.array([[1, 2, 3], [4, 5, 6], [7, 8, 9]])

# 计算矩阵 A 的奇异值分解

U, Sigma, Vh = np.linalg.svd(A, full_matrices=False)

# 打印奇异值

print("奇异值:", Sigma)

```

**代码逻辑分析:**

* `np.linalg.svd()` 函数执行矩阵 A 的奇异值分解,返回三个矩阵:U、Sigma 和 Vh。

* `full_matrices=False` 参数指定不返回完整的 U 和 Vh 矩阵,这对于大型矩阵可以节省内存。

* Sigma 是一个对角矩阵,其对角线元素是矩阵 A 的奇异值。

# 3. SVD实践应用

### 3.1 数据降维

#### 3.1.1 PCA降维原理

主成分分析(PCA)是一种经典的降维技术,其基本思想是将原始数据投影到一个新的正交基上,使得投影后的数据方差最大化。

**原理:**

1. **中心化:**将原始数据减去其均值,使其均值为0。

2. **计算协方差矩阵:**计算中心化后的数据协方差矩阵。

3. **求解协方差矩阵的特征值和特征向量:**协方差矩阵的特征值表示数据方差,特征向量表示数据投影后的方向。

4. **选择主成分:**根据特征值的大小,选择前k个特征向量作为主成分,k为降维后的维度。

5. **投影:**将原始数据投影到主成分上,得到降维后的数据。

#### 3.1.2 SVD降维算法

奇异值分解(SVD)是一种比PCA更通用的降维算法,它可以处理非方阵和奇异矩阵。

**原理:**

1. **计算SVD:**将原始数据矩阵A分解为U、Σ、V三个矩阵的乘积,其中U和V为正交矩阵,Σ为对角矩阵,对角线上的元素即为奇异值。

2. **选择奇异值:**根据奇异值的大小,选择前k个奇异值,k为降维后的维度。

3. **投影:**将原始数据矩阵A投影到前k个奇异向量组成的子空间上,得到降维后的数据。

**代码示例:**

```python

import numpy as np

from sklearn.decomposition import TruncatedSVD

# 原始数据

data = np.array([[1, 2, 3], [4, 5, 6], [7, 8, 9]])

# SVD降维

svd = TruncatedSVD(n_components=2)

data_reduced = svd.fit_transform(data)

print(data_reduced)

```

**逻辑分析:**

* `TruncatedSVD`类用于执行SVD降维。

* `n_components`参数指定降维后的维度。

* `fit_transform`方法将原始数据投影到前k个奇异向量组成的子空间上。

### 3.2 图像处理

#### 3.2.1 图像去噪

SVD可以用于去除图像中的噪声。

**原理:**

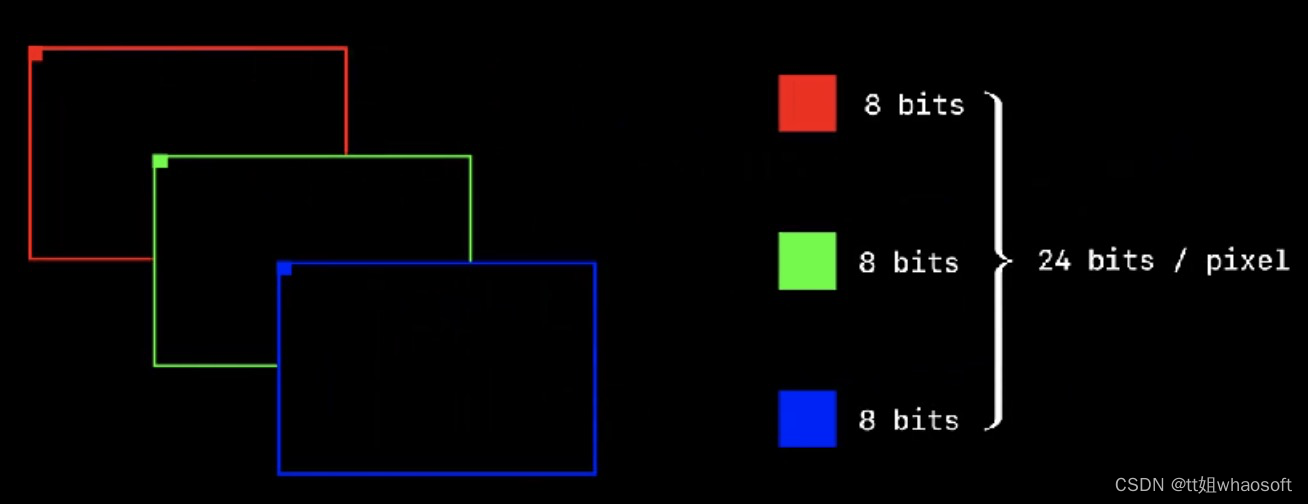

1. **将图像转换为矩阵:**将图像转换为一个矩阵,其中每个元素表示图像中一个像素的灰度值。

2. **计算SVD:**对图像矩阵进行SVD分解。

3. **截断奇异值:**将较小的奇异值截断为0,保留较大的奇异值。

4. **重建图像:**使用截断后的奇异值重建图像矩阵,从而去除噪声。

#### 3.2.2 图像压缩

SVD还可以用于压缩图像。

**原理:**

1. **计算SVD:**对图像矩阵进行SVD分解。

2. **截断奇异值:**截断较小的奇异值,保留较大的奇异值。

3. **重建图像:**使用截断后的奇异值重建图像矩阵,从而压缩图像。

**代码示例:**

```python

import numpy as np

from PIL import Image

# 原始图像

image = Image.open("image.jpg")

data = np.array(image)

# SVD图像压缩

svd = TruncatedSVD(n_components=100)

data_compressed = svd.fit_transform(data)

data_reconstructed = svd.inverse_transform(data_compressed)

# 保存压缩后的图像

Image.fromarray(data_reconstructed).save("image_compressed.jpg")

```

**逻辑分析:**

* `TruncatedSVD`类用于执行SVD压缩。

* `n_components`参数指定压缩后的图像质量,值越小压缩率越高。

* `fit_transform`方法将图像矩阵投影到前k个奇异向量组成的子空间上。

* `inverse_transform`方法将压缩后的矩阵重建为图像矩阵。

# 4. SVD进阶应用**

### 4.1 推荐系统

#### 4.1.1 SVD在协同过滤中的应用

协同过滤是一种推荐系统技术,它通过分析用户的历史行为数据来预测他们对新物品的偏好。SVD在协同过滤中扮演着重要角色,因为它可以将用户-物品评分矩阵分解为三个矩阵:用户特征矩阵、奇异值矩阵和物品特征矩阵。

```python

import numpy as np

from sklearn.decomposition import TruncatedSVD

# 用户-物品评分矩阵

ratings = np.array([[5, 3, 0, 1],

[4, 0, 0, 1],

[1, 1, 0, 5],

[1, 0, 0, 4]])

# 使用SVD分解评分矩阵

svd = TruncatedSVD(n_components=2)

svd.fit(ratings)

# 获取用户特征矩阵和物品特征矩阵

user_features = svd.components_

item_features = svd.components_.T

# 计算用户和物品之间的相似度

user_similarity = np.dot(user_features, user_features.T)

item_similarity = np.dot(item_features, item_features.T)

```

#### 4.1.2 SVD++算法

SVD++算法是协同过滤的一种改进算法,它在SVD的基础上加入了隐式反馈数据(如点击、浏览等)。SVD++算法通过将隐式反馈数据转换为显式评分数据,从而提高推荐系统的准确性。

```python

import numpy as np

from sklearn.decomposition import TruncatedSVD

# 用户-物品评分矩阵

ratings = np.array([[5, 3, 0, 1],

[4, 0, 0, 1],

[1, 1, 0, 5],

[1, 0, 0, 4]])

# 用户-物品隐式反馈矩阵

implicit_feedback = np.array([[1, 1, 0, 0],

[1, 0, 0, 1],

[0, 1, 0, 1],

[0, 0, 1, 1]])

# 使用SVD++算法分解评分矩阵和隐式反馈矩阵

svd = TruncatedSVD(n_components=2)

svd.fit([ratings, implicit_feedback])

# 获取用户特征矩阵和物品特征矩阵

user_features = svd.components_[0]

item_features = svd.components_[1].T

# 计算用户和物品之间的相似度

user_similarity = np.dot(user_features, user_features.T)

item_similarity = np.dot(item_features, item_features.T)

```

### 4.2 计算机视觉

#### 4.2.1 图像识别

SVD在图像识别中用于提取图像中的特征。通过对图像进行SVD分解,可以得到图像的奇异值,这些奇异值反映了图像中不同频率的成分。

```python

import numpy as np

from skimage import io

# 读取图像

image = io.imread('image.jpg')

# 将图像转换为灰度图

gray_image = np.mean(image, axis=2)

# 使用SVD分解图像

svd = np.linalg.svd(gray_image, full_matrices=False)

# 获取奇异值

singular_values = svd[1]

```

#### 4.2.2 目标检测

SVD还可以用于目标检测。通过对图像进行SVD分解,可以提取图像中的目标区域。

```python

import numpy as np

from skimage import io

# 读取图像

image = io.imread('image.jpg')

# 将图像转换为灰度图

gray_image = np.mean(image, axis=2)

# 使用SVD分解图像

svd = np.linalg.svd(gray_image, full_matrices=False)

# 获取奇异值

singular_values = svd[1]

# 阈值化奇异值以提取目标区域

threshold = np.mean(singular_values)

binary_image = (singular_values > threshold).astype(np.uint8)

# 标记目标区域

contours, _ = cv2.findContours(binary_image, cv2.RETR_EXTERNAL, cv2.CHAIN_APPROX_SIMPLE)

for contour in contours:

cv2.drawContours(image, [contour], -1, (0, 255, 0), 2)

```

# 5. SVD工具和库

### 5.1 Python中的SVD库

#### 5.1.1 NumPy

NumPy是Python中用于科学计算的强大库。它提供了用于SVD计算的`linalg.svd()`函数。该函数采用一个矩阵作为输入,并返回三个矩阵:U、S和Vh。

```python

import numpy as np

# 创建一个矩阵

A = np.array([[1, 2], [3, 4]])

# 计算SVD

U, S, Vh = np.linalg.svd(A)

# 输出结果

print("U:")

print(U)

print("S:")

print(S)

print("Vh:")

print(Vh)

```

#### 5.1.2 Scikit-learn

Scikit-learn是Python中用于机器学习的另一个流行库。它提供了`decomposition.TruncatedSVD`类,用于降维和SVD计算。

```python

from sklearn.decomposition import TruncatedSVD

# 创建一个矩阵

A = np.array([[1, 2], [3, 4]])

# 创建一个TruncatedSVD对象

svd = TruncatedSVD(n_components=1)

# 拟合和转换数据

svd.fit(A)

A_reduced = svd.transform(A)

# 输出结果

print("A_reduced:")

print(A_reduced)

```

### 5.2 其他语言中的SVD库

#### 5.2.1 MATLAB

MATLAB是一种用于技术计算的专有语言。它提供了`svd()`函数来计算SVD。

```matlab

% 创建一个矩阵

A = [1, 2; 3, 4];

% 计算SVD

[U, S, V] = svd(A);

% 输出结果

disp("U:");

disp(U);

disp("S:");

disp(S);

disp("V:");

disp(V);

```

#### 5.2.2 R

R是一种用于统计计算和图形的开源语言。它提供了`svd()`函数来计算SVD。

```r

# 创建一个矩阵

A <- matrix(c(1, 2, 3, 4), ncol=2)

# 计算SVD

svd_result <- svd(A)

# 输出结果

print("U:")

print(svd_result$u)

print("S:")

print(svd_result$d)

print("Vh:")

print(svd_result$v)

```

0

0