:神经网络中的运算次数:大数据和深度学习的挑战

发布时间: 2024-08-18 01:19:34 阅读量: 23 订阅数: 25

# 1. 神经网络中的运算次数:理论基础

神经网络的运算次数是指训练或推理过程中执行的浮点运算的总和。它是一个至关重要的指标,因为它直接影响模型的训练时间、推理速度和能耗。

在神经网络中,运算次数主要取决于以下几个因素:

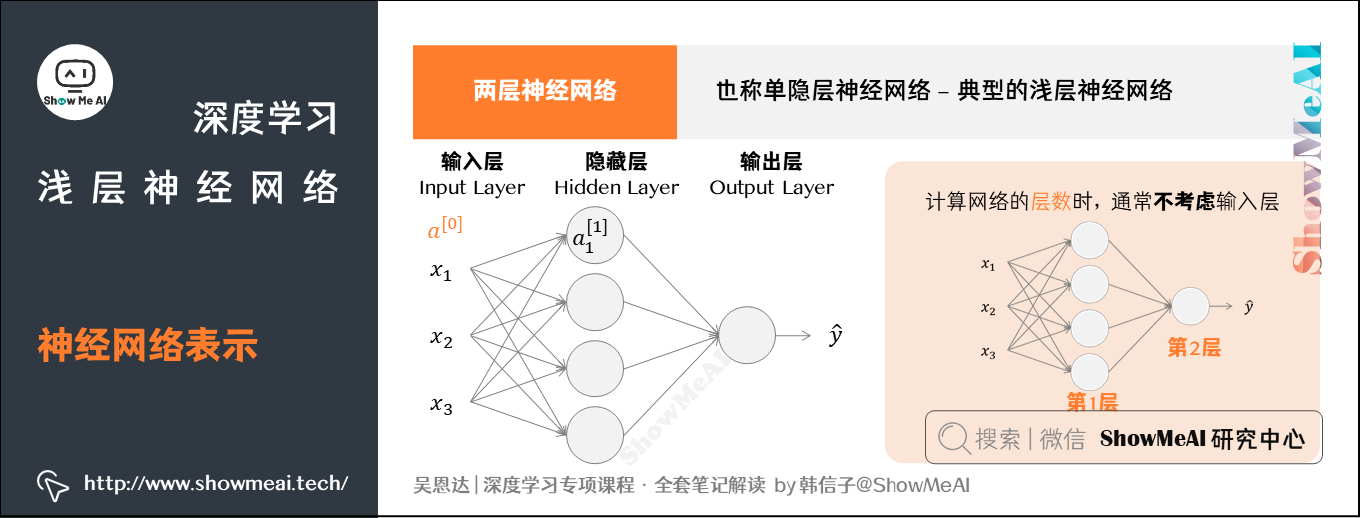

* **网络结构:**网络的层数、神经元数量和连接方式都会影响运算次数。更深的网络和更多的神经元需要更多的运算。

* **激活函数:**激活函数的计算复杂度也会影响运算次数。例如,ReLU激活函数比sigmoid或tanh激活函数更简单,因此需要更少的运算。

* **优化算法:**优化算法(如梯度下降)用于更新网络权重。不同的优化算法具有不同的计算复杂度,从而影响运算次数。

# 2. 大数据对运算次数的影响

### 2.1 数据规模与运算次数的正相关关系

**2.1.1 数据集大小的指数级增长**

随着数据量的不断增长,训练神经网络所需的运算次数也呈指数级增长。这是因为神经网络的训练过程本质上是通过反复迭代来更新模型参数,而每一次迭代都需要对整个数据集进行前向和反向传播。因此,数据集越大,迭代次数越多,所需的运算次数也就越多。

**代码块:**

```python

# 假设数据集大小为 N,神经网络有 L 层,每层有 M 个神经元

num_iterations = 1000 # 迭代次数

num_operations_per_iteration = N * L * M # 每一次迭代的运算次数

total_num_operations = num_iterations * num_operations_per_iteration

```

**逻辑分析:**

这段代码计算了训练神经网络所需的总运算次数。它将数据集大小、神经网络层数、每层神经元数量和迭代次数相乘,得到每一步迭代的运算次数,再乘以迭代次数得到总运算次数。

### 2.1.2 数据预处理和特征工程的运算开销

在训练神经网络之前,通常需要对原始数据进行预处理和特征工程,以提高模型的性能。这些操作也需要大量的运算,特别是对于大型数据集。例如,数据归一化、缺失值填充和特征选择等操作都需要遍历整个数据集,这会增加训练过程的运算开销。

**表格:**

| 数据预处理操作 | 运算复杂度 |

|---|---|

| 数据归一化 | O(N) |

| 缺失值填充 | O(N) |

| 特征选择 | O(N^2) |

**说明:**

表格中给出了常见数据预处理操作的运算复杂度。N 表示数据集的大小。

### 2.2 数据分布与运算次数的非线性关系

**2.2.1 稀疏数据和稠密数据的差异**

稀疏数据是指大多数元素为零的数据,而稠密数据是指大多数元素为非零的数据。对于稀疏数据,神经网络的训练过程可以优化,因为不需要对零元素进行计算。这

0

0