决策树剪枝的智慧:偏差-方差视角下的策略与技巧

发布时间: 2024-11-23 16:12:12 阅读量: 30 订阅数: 28

基于freeRTOS和STM32F103x的手机远程控制浴室温度系统设计源码

# 1. 决策树剪枝的理论基础

决策树作为一种流行的机器学习方法,因其直观性、易解释性而被广泛应用于数据分类与回归问题。然而,未经过优化的决策树往往容易出现过度拟合现象,这会降低模型在未见数据上的泛化能力。为了提升决策树的泛化性能,引入了剪枝技术。剪枝通过对决策树进行简化,去除那些对预测结果影响不大的分支,从而减少模型复杂度,降低过拟合的风险。

## 1.1 决策树的过度拟合问题

在训练决策树模型时,如果不加以控制,树可能会生长得非常复杂,以捕捉训练数据中的噪声和细节,这将导致模型过度拟合。过度拟合意味着模型在训练数据上表现很好,但在新的、未见过的数据上表现较差。为了缓解这一问题,决策树剪枝技术应运而生。

## 1.2 剪枝技术的引入

剪枝技术是通过对决策树中的某些部分进行削减,来降低模型的复杂度,从而提高模型的泛化能力。剪枝主要有两类:预剪枝(Pre-Pruning)和后剪枝(Post-Pruning)。预剪枝是在树构建过程中进行的,通过提前停止树的增长来避免过度拟合;而后剪枝是在树完全生长之后进行的,它评估已经构建好的树,并剪去那些对模型性能提升不大的分支。

预剪枝通过设置停止增长的阈值(如最小样本分割数、最大树深度等),限制了树的增长。后剪枝通常使用一些性能指标,如验证集的准确率,来确定哪些部分可以被剪掉。

总之,剪枝技术通过平衡模型的复杂度与性能,确保决策树在处理新数据时能够保持良好的预测能力,是机器学习中提高模型泛化能力的重要手段。在接下来的章节中,我们将深入探讨偏差-方差权衡视角下的剪枝策略,以及剪枝实践技巧等话题。

# 2. ```

# 第二章:偏差-方差权衡视角下的剪枝策略

在本章中,我们深入探讨决策树剪枝策略,基于偏差-方差权衡的理论框架。偏差-方差权衡是机器学习中一个重要概念,它帮助我们理解和平衡模型复杂度与泛化能力之间的关系。我们将从模型复杂度的影响、剪枝的必要性、以及剪枝算法的分类和比较来展开。

## 2.1 模型复杂度与泛化能力

### 2.1.1 模型复杂度对泛化误差的影响

模型复杂度通常指的是模型对训练数据的适应程度,包括其容量,即学习和概括新情况的能力。在决策树中,复杂度可以通过树的深度、分支数量和叶子节点的纯度来衡量。随着复杂度的增加,模型对训练数据的拟合会越来越好,但同时也可能导致对未知数据的预测性能下降,即泛化误差增加。这是因为一个复杂的模型可能过于拟合训练数据中的噪声和随机波动,从而丧失了泛化到新数据的能力。

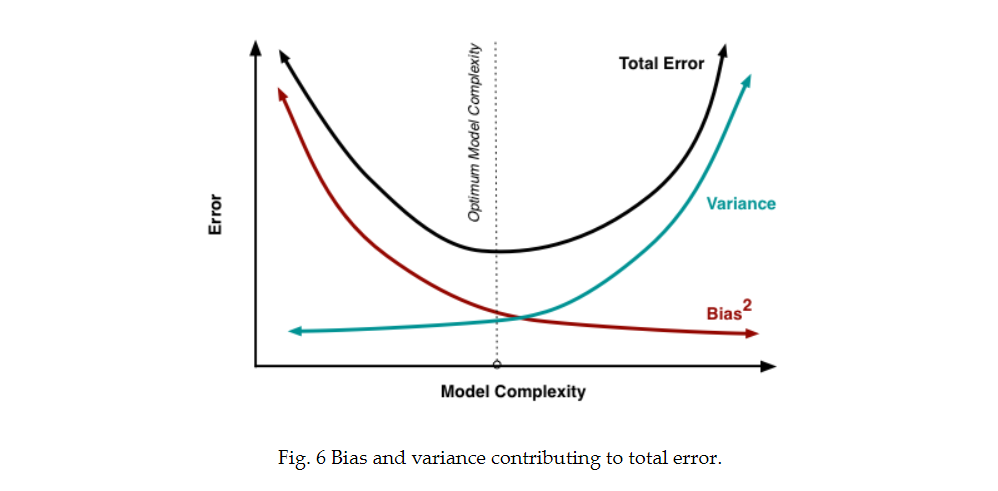

### 2.1.2 偏差与方差的概念及其相互关系

偏差和方差是衡量泛化误差的两个重要指标。偏差是指模型预测的平均值与真实值之间的差异,它度量了模型预测的准确性。方差则反映了模型在不同数据集上的预测值的变化程度,它是模型稳定性的量度。理想情况下,我们希望模型具有低偏差和低方差。然而,在实际操作中,这两者往往是相互冲突的。模型复杂度的增加会降低偏差,但同时会增加方差,反之亦然。因此,通过适当的剪枝来达到偏差和方差之间的平衡,是提高模型泛化能力的关键。

## 2.2 剪枝的必要性与目标

### 2.2.1 过度拟合与剪枝的作用

过度拟合是模型学习训练数据中的随机误差而非潜在数据分布的情况。它通常发生在模型过度复杂时,模型在训练集上表现良好,但在未见过的数据上表现差。剪枝是解决过度拟合的一个有效手段,通过简化模型结构,降低模型复杂度,从而提高其在新数据上的预测性能。

### 2.2.2 剪枝策略的目标与分类

剪枝策略的主要目标是在保持模型准确度的同时减少模型复杂度。剪枝可以分为预剪枝和后剪枝两大类。预剪枝是在训练过程中提前停止树的生长,而后剪枝则是在训练完成后对树进行简化。预剪枝通过提前设置停止条件(如节点的最小样本数、最大深度等)来防止过度生长,而后剪枝则通过评估剪枝前后的性能来决定哪些分支可以被去除。

## 2.3 剪枝算法的分类与比较

### 2.3.1 预剪枝与后剪枝的区别

预剪枝是决策树构建过程中的提前干预,而后剪枝则发生在决策树构建完成之后。预剪枝通过控制树的增长来避免过度拟合,例如限制树的最大深度或最小样本数。后剪枝则在完整的树上进行,通过优化剪枝成本函数来选择需要剪枝的节点,因此可能找到更优的剪枝策略,但计算成本也相对较高。

### 2.3.2 常见剪枝算法的优缺点分析

- **Reduced Error Pruning (REP) **:它通过递归地删除被错误分类样本最多的叶节点,并用其父节点替换来简化决策树,优点在于剪枝过程简单易懂,但缺点是可能剪枝过度,导致性能下降。

- **Error Complexity Pruning (ECP) **:它在REP的基础上引入了一个惩罚项,以防止剪枝过度。ECP在剪枝时考虑了子树与原树的错误率和复杂度,通过求解一个优化问题来选择剪枝点。其优点在于剪枝更加精细,缺点是计算复杂度较高。

- **Cost Complexity Pruning (CCP) **:也称为最小误差剪枝,它通过引入一个参数α来权衡树的错误率和复杂度,从而得到一个剪枝后的子树。该算法的优点是提供了明确的剪枝路径,缺点是需要对α进行优化选择。

通过对比这些算法,我们可以发现,选择合适的剪枝算法需要根据具体问题和数据集的特点来决定。例如,在数据集较小或者需要快速训练的情况下,可能会选择计算效率更高的REP;而在对模型性能要求较高时,可能会考虑引入更复杂的ECP或CCP。

为了进一步理解剪枝算法的效果,接下来,我们将通过具体的代码示例来展示如何在实践中应用这些剪枝技术。

```

# 3. 决策树剪枝实践技巧

在决策树模型中,剪枝技术是解决过度拟合问题、提高模型泛化能力的关键。本章将详细介绍如何在实际应用中通过不同技巧和算法实现决策树的剪枝,包括如何基于性能指标进行剪枝、应用高级剪枝算法以及在不同数据集上的剪枝效果分析。

## 3.1 基于性能指标的剪枝

在决策树的训练过程中,过拟合往往会导致模型在训练数据上表现优秀,但在未知数据上的表现却差强人意。剪枝通过删除多余的节点来简化模型,以期望提高模型在未知数据上的表现。这一过程中,性能指标起到关键作用。

### 3.1.1 使用交叉验证选择剪枝参数

交叉验证是模型选择中常用的方法,它能够减小模型对特定数据集的依赖。在剪枝策略中,我们可以使用交叉验证来选择最佳的剪枝参数,以达到最佳的泛化性能。以下是使用交叉验证选择剪枝参数的步骤:

1. 将数据集划分为k个大小相似的互斥子集。

2. 挑选一个子集作为验证集,其余的作为训练集。

3. 训练模型并在验证集上评估性能指标,记录下来。

4. 重复步骤2和3,每次挑选不同的子集作为验证集。

5. 将k次验证的结果进行平均,得到最终的性能指标。

6. 调整剪枝参数,重复步骤1到5,选取使性能指标最优的参数值。

```python

from sklearn.model_selection import cross_val_score

from sklearn.tree import DecisionTreeClassifier

# 初始化决策树模型,设置最大深度为默认值

tree = DecisionTreeClassifier(random_state=42)

# 10折交叉验证

k = 10

cv_scores = cross_val_score(tree, X_train, y_train, cv=k)

# 打印交叉验证结果

print("交叉验证结果:", cv_scores)

# 计算平均性能指标

mean_score = cv_scores.mean()

print("平均交叉验证结果:", mean_score)

# 根据平均结果调整剪枝参数,比如最大深度 max_depth

tree = DecisionTreeClassifier(max_depth=5, random_state=42) # 示例参数调整

```

在此代码中,我们首先导入了必要的库,并初始化了一个决策树分类器。然后,通过`cross_val_score`函数执行了10折交叉验证,并记录了每一次验证的性能指标。最后,计算出平均性能指标,并以此作为依据调整模型参数。

### 3.1.2 剪枝决策的性能评估方法

剪枝操作不仅要在训练集上评估,更要在验证集和测试集上进行

0

0