Java中机器学习库的自动特征选择:技术与实践的深度剖析

发布时间: 2024-08-30 02:08:11 阅读量: 96 订阅数: 50

NewBie-Plan::books:Java技术体系面试指南,预测锻炼学习方法论的技术指南:rocket:数学,算法,基础框架,原理剖析,职业感悟,技术面试

# 1. 机器学习与特征选择基础

在机器学习领域,数据是构建模型不可或缺的要素。特征选择则是在数据预处理阶段不可或缺的一步,它指的是从众多的特征中筛选出最能代表数据特征的子集的过程。良好的特征选择不仅能够提升模型的预测性能,还能提高模型的泛化能力,同时减少模型训练和预测所需的时间和资源。在接下来的章节中,我们将探讨Java机器学习库在特征选择中的应用、自动化特征选择技术以及实践中的应用案例。我们将从基础理论出发,逐步深入探讨各种特征选择方法,并通过实例和案例分析来展示如何在实际业务中应用这些知识。让我们开始一步步揭开特征选择这门艺术与科学的神秘面纱。

# 2. Java机器学习库概述

### 2.1 Java在机器学习中的应用

#### 2.1.1 Java机器学习库的生态和流行度

Java作为编程语言中的一大分支,其稳定的性能和跨平台的特性使得它在工业界有着广泛的应用。随着机器学习的兴起,Java也逐渐成为开发机器学习项目的一个重要选项。众多Java机器学习库的出现,极大地丰富了Java在机器学习领域的生态。

一个流行的Java机器学习库是Weka,它提供了包括聚类、分类、回归分析等在内的众多机器学习算法。此外,DeepLearning4j作为一个专注于深度学习的库,受到了广泛关注,尤其在处理大规模数据集方面表现出色。Apache Mahout则是另外一个支持多种机器学习算法的库,尽管它最近几年的更新放缓,但其在业界的使用依然广泛。

Java的机器学习库生态之所以流行,源于Java语言本身的特点,如运行速度快、跨平台以及成熟的社区支持。这些因素共同作用,使得Java机器学习库在企业级应用中具有较高的可信度和易用性。

#### 2.1.2 Java与机器学习库的兼容性分析

Java作为一种强类型的静态语言,在编写大型和复杂的应用程序时提供了极高的可靠性。这一点在机器学习项目的开发中尤为重要。Java的兼容性体现在能够与多种其他技术栈无缝衔接,包括但不限于Python机器学习库。

以Deeplearning4j为例,该库虽然主要使用Java编写,但同样提供了对Python接口的支持。这意味着开发者可以同时使用Java和Python两种语言进行模型的训练与部署,极大地提高了开发的灵活性。

兼容性的另一个方面是Java的JVM(Java虚拟机)机制。通过JVM,Java代码可以在不同平台间移植,而无需进行修改。这就使得Java机器学习库能够轻松部署到不同的操作系统和硬件环境中。同时,JVM对于垃圾回收的优化也让Java在处理长时间运行的机器学习任务时更加稳定。

### 2.2 特征选择的重要性

#### 2.2.1 减少模型复杂度和过拟合

特征选择是机器学习中一个关键的预处理步骤,它涉及从大量特征中选择最有预测性的特征子集。减少特征的数量能有效减少模型的复杂度,这不仅简化了模型,还可能帮助防止模型过拟合。

过拟合是一个普遍的问题,在这种情况下,模型学习到的数据中的噪声和无关特征,而不是底层数据分布的真实属性。通过特征选择,我们可以剔除掉那些对于预测目标无用或有害的特征,仅保留与目标变量强相关的特征。这有助于提高模型的泛化能力,即在未见过的数据上也能有较好的表现。

减少模型复杂度的另一个好处是降低计算成本。简单的模型通常需要更少的计算资源和更短的训练时间,这对于需要在大规模数据集上运行的机器学习任务来说尤为重要。

#### 2.2.2 提高模型的预测性能

特征选择不仅仅是减少过拟合和计算成本,它也是提高模型预测性能的一种有效手段。在很多情况下,数据集中包含一些噪声特征或者与目标变量相关性极低的特征,这些特征对于模型的预测能力没有贡献,甚至可能导致模型性能下降。

通过特征选择,我们能够剔除这些无用特征,保留那些对预测目标有实际贡献的特征。这样,模型可以更加聚焦于关键信息,从而提高预测的准确性。同时,选择的特征子集通常也会减少特征之间的多重共线性问题,这有助于改善模型的稳定性和可解释性。

### 2.3 特征选择的方法论

#### 2.3.1 过滤法(Filter Methods)

过滤法是一种简单直接的特征选择方法。这种方法通过计算特征和目标变量之间的统计指标(例如相关系数、卡方检验等)来评估特征的重要性,并根据这些指标对特征进行排序。

过滤法的优点是计算速度快,且不依赖于任何特定的机器学习算法,具有很好的通用性。但它的缺点是可能忽略特征之间的关联性,因为这种方法通常只考虑单个特征,不考虑特征之间的相互作用。

一个常见的过滤法示例是使用Pearson相关系数来评估特征与目标变量之间的线性关系强度。相关系数的绝对值越接近1,表明特征与目标变量之间的线性关系越强,从而可能是一个更好的选择。

```java

public double calculatePearsonCorrelation(double[] featureData, double[] targetData) {

// 代码逻辑省略,返回相关系数值

}

```

在上述代码中,`calculatePearsonCorrelation`函数负责计算给定特征数据和目标数据之间的Pearson相关系数。这个值可以用来评估特征的重要性,进而进行特征选择。

#### 2.3.2 包裹法(Wrapper Methods)

包裹法的核心思想是使用学习算法本身作为特征选择的评估器,通过训练和测试学习器来评估特征子集的好坏。与过滤法相比,包裹法更加注重特征之间的相互作用,并且往往能够得到更好的性能。

包裹法的一个缺点是计算开销大。因为它需要对每一种特征子集都训练一次学习器,当特征数量较多时,计算成本会非常高。常见的包裹法包括递归特征消除(RFE)和前向选择。

递归特征消除(RFE)是一种常用的包裹法特征选择技术,它通过逐步消除特征的方法来选择特征。在每一步中,都会训练模型并评估每个特征的重要性,然后删除掉最不重要的特征,重复这个过程直到达到预定的特征数量。

#### 2.3.3 嵌入法(Embedded Methods)

嵌入法是一种将特征选择过程与学习算法相结合的方法。它的思想是将特征选择作为学习算法的副产品,通过模型自身的正则化参数来进行特征选择。与包裹法不同,嵌入法不需要在特征子集上多次训练模型,从而节省了计算资源。

LASSO(Least Absolute Shrinkage and Selection Operator)是嵌入法的一个典型例子,它通过向损失函数中添加L1正则化项来实现特征选择。L1正则化会导致某些特征的权重缩减为零,实现特征的自动选择。

```java

// 示例代码展示如何在Java中使用LASSO进行特征选择

public void applyLassoPenalty(LassoRegression model, double[][] featureMatrix, double[] targetVector) {

// 代码逻辑省略,展示如何应用LASSO模型

}

```

在上述代码段中,`applyLassoPenalty`函数展示了如何应用带有LASSO正则化项的线性回归模型。通过这种方式,我们可以实现特征选择,同时进行模型训练。

# 3. 自动化特征选择技术

## 3.1 自动特征选择流程

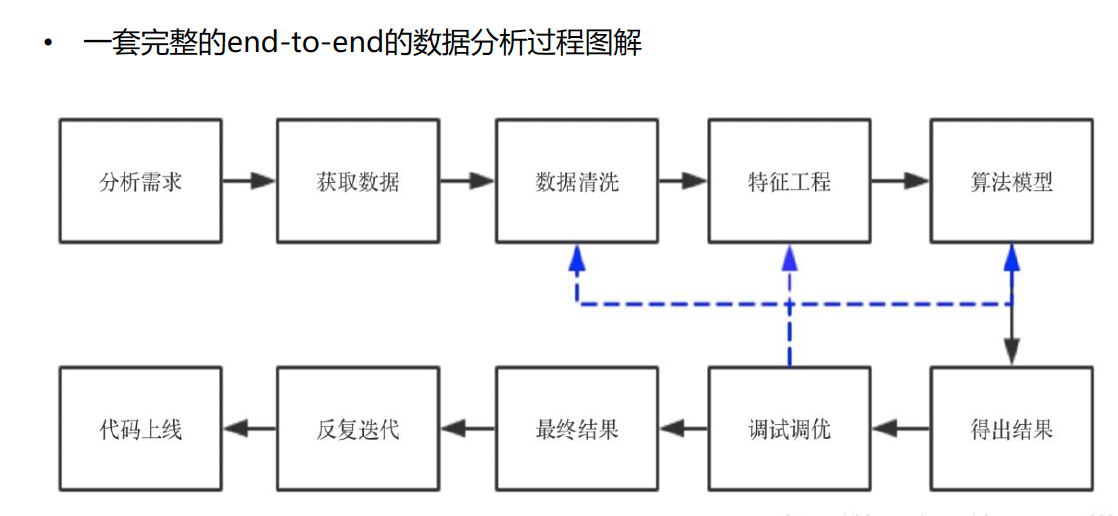

特征选择是数据预处理的一个关键步骤,旨在从原始数据集中挑选出最有信息量的特征,以便于提高后续机器学习模型的性能。自动化特征选择流程大体可以分为两个主要步骤:数据预处理和特征评估标准的选择。

### 3.1.1 数据预处理

在自动化特征选择之前,数据预处理是必不可少的步骤,其目的是为了清除数据中的噪声和异常值,并将数据转换成适合模型处理的格式。数据预处理通常包括以下几个方面:

- 数据清洗:移除数据集中的异常值,纠正错误,处理缺失值。

- 数据转换:对非数值型数据进行编码转换,如独热编码(One-Hot Encoding)。

- 特征缩放:将特征值缩放到一个标准范围,如[0, 1],常用方法包括最小-最大归一化和标准归一化。

- 特征构造:创建新特征或组合特征,以提高模型性能。

代码块示例:

```python

from sklearn.preprocessing import MinMaxScaler

from sklearn.impute import SimpleImputer

# 假设 X 为需要进行预处理的数据集

imputer = SimpleImputer(strategy='mean') # 缺失值用均值填充

X_imputed = imputer.fit_transform(X)

scaler = MinMaxScaler() # 最小-最大归一化

X_scaled = scaler.fit_transform(X_imputed)

```

逻辑分析和参数说明:

在上述代码中,`SimpleImputer` 用于处理缺失值,`strategy='mean'` 参数指定用每列的平均值填充缺失值。`MinMaxScaler` 实现了最小-最大归一化,将数据缩放到[0, 1]区间内。

### 3.1.2 特征评估标准

特征选择的核心是评估特征对于预测任务的重要性。不同的特征选择方法使用不同的评估标准,常见的有:

- 基于统计的方法:使用卡方检验、ANOVA等统计测试,评估特征与目标变量之间的关系强度。

- 基于模型的方法:使用模型的特征权重,如随机森林的特征重要性评分。

mermaid 流程图示例:

```mermaid

graph LR

A[开始特征选择]

A --> B[数据预处理]

B --> C[选择特征评估方法]

C --> D[过滤法]

C --> E[包裹法]

C --> F[嵌入法]

D --> G[计算特征统计分数]

E --> H[训练模型并选择特征]

F --> I[在模型训练过程中选择特征]

A --> J[结束特征选择]

```

## 3.2 自动化特征选择算法

自动化特征选择算法通过算法实现特征的自动选择过程,无需人工干预,从而大大节省了特征工程的时间。

### 3.2.1 单变量特征选择

单变量特征选择(Univariate Feature Selection)是一种基于统计测试的方法,用于评估特征与目标变量之间的关系。它通过计算每个特征与目标变量之间的统计关联度来选择特征。

代码块示例:

```python

from sklearn.feature_selection import SelectKBest, chi2

# 假设 X 为特征集, y 为目标变量

selector = SelectKBest(chi2, k=5) # 选择与目标变量相关性最高的5个特征

X_new = selector.fit_transform(X, y)

selected_features = X.columns[selector.get_support(indices=True)]

```

逻辑分析和参数说明:

在上述代码中,`SelectKBest` 类与 `chi2` 统计测试结合使用,选择与目标变量 `y` 相关性最高的 `k` 个特征。`k` 参数指定了我们想要保留的特征数量。

### 3.2.2 基于模型的特征选择

基于模型的特征选择方法通过训练一个包含所有特征的模型,然后根据特征的重要性进行排序和选择。这种方法通常更准确,但计算成本更高。

代码块示例:

```python

from sklearn.feature_selection imp

```

0

0