深度学习中的BatchNorm:优化加速之谜

需积分: 13 185 浏览量

更新于2024-07-17

收藏 1.12MB PDF 举报

"BatchNorm有效性原理探索.pdf"

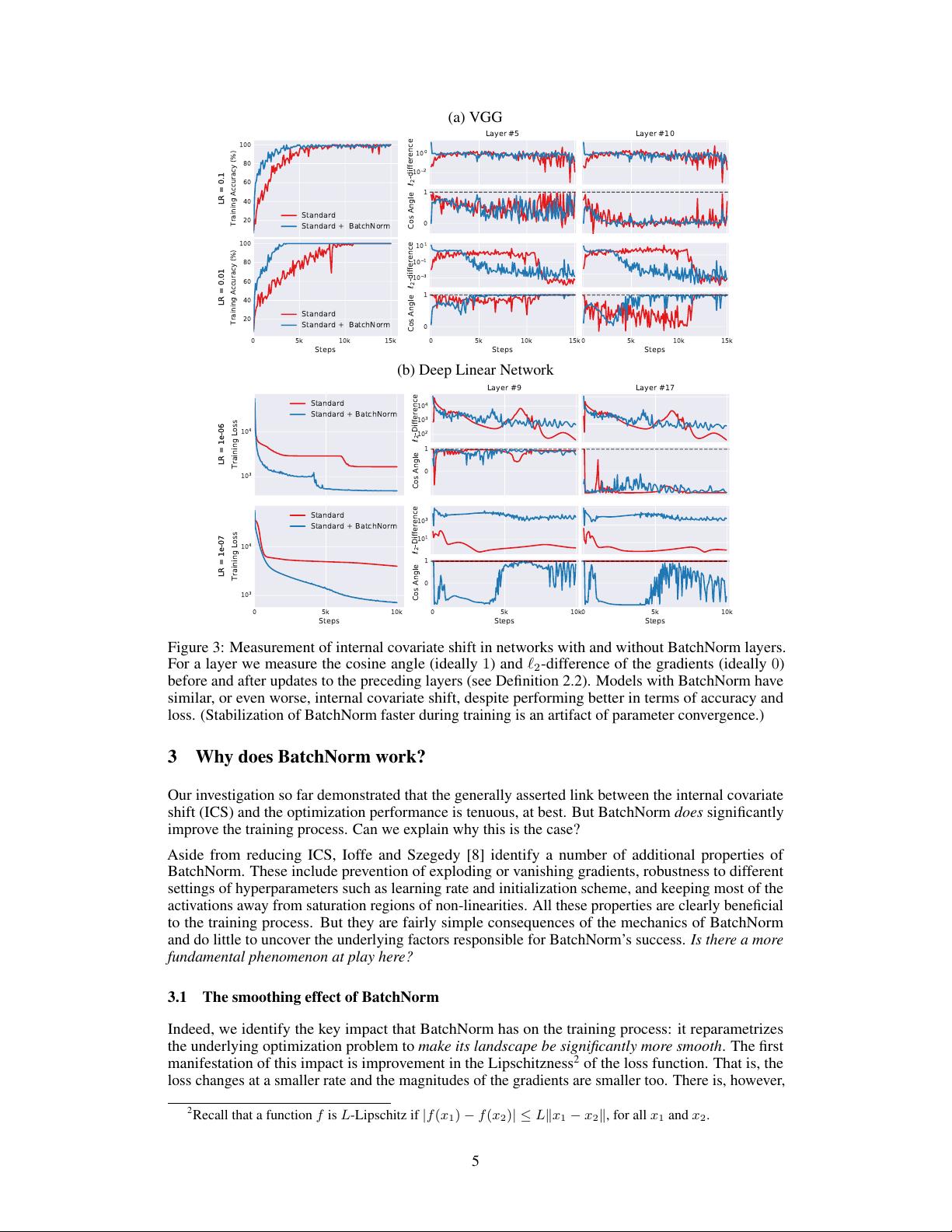

这篇论文深入探讨了Batch Normalization(BatchNorm)在深度神经网络(DNN)训练中的作用机理。BatchNorm是一种广泛使用的技巧,可以加速并稳定DNN的训练过程。尽管它被广泛应用,但对其效果背后的确切原因的理解仍然不足。传统的观点认为,BatchNorm的效果来自于控制训练过程中层输入分布的变化,以减少所谓的“内部协变量漂移”。然而,论文作者挑战了这一观点,并提出不同的见解。

作者通过研究发现,层输入分布的稳定性并不是BatchNorm成功的关键因素。相反,他们揭示了BatchNorm对训练过程的一个更基础的影响:它显著平滑了优化景观。这意味着BatchNorm使得梯度的行为更加可预测和稳定,从而允许更快的训练速度。

在深度学习领域,优化是训练模型的核心任务。通常,复杂的网络结构和大量参数会导致训练过程中的优化难题,如梯度消失或爆炸、局部最优等。BatchNorm通过调整每批数据的均值和方差,使得每一层的输入保持在相对稳定的范围内,但这并非其主要优点。真正重要的是,BatchNorm通过改变损失函数的地形,使得网络更容易进行梯度下降,减少了训练过程中的波动,使得模型能够更快地收敛到全局最优解。

此外,平滑的优化景观还意味着模型对于参数更新的敏感性降低,这有助于避免训练过程中的不稳定性。在实际应用中,这意味着模型可以使用更大的学习率进行训练,进一步提高了训练效率。同时,更稳定的梯度行为也有助于模型在不同初始化状态下达到一致的性能,增加了训练的鲁棒性。

这项工作深化了我们对BatchNorm的理解,表明其核心作用在于改善优化过程,而不是简单地控制输入分布的稳定性。这一发现对于优化理论和深度学习实践具有重要意义,有助于研究人员和工程师更好地设计和调优深度学习模型,提高训练效率和模型性能。

2024-03-22 上传

2024-03-22 上传

2023-07-10 上传

2023-07-13 上传

2023-07-10 上传

2023-05-11 上传

2023-07-23 上传

2023-06-07 上传

2023-08-30 上传

2023-04-19 上传

Jayxp

- 粉丝: 6

- 资源: 137

最新资源

- 十种常见电感线圈电感量计算公式详解

- 军用车辆:CAN总线的集成与优势

- CAN总线在汽车智能换档系统中的作用与实现

- CAN总线数据超载问题及解决策略

- 汽车车身系统CAN总线设计与应用

- SAP企业需求深度剖析:财务会计与供应链的关键流程与改进策略

- CAN总线在发动机电控系统中的通信设计实践

- Spring与iBATIS整合:快速开发与比较分析

- CAN总线驱动的整车管理系统硬件设计详解

- CAN总线通讯智能节点设计与实现

- DSP实现电动汽车CAN总线通讯技术

- CAN协议网关设计:自动位速率检测与互连

- Xcode免证书调试iPad程序开发指南

- 分布式数据库查询优化算法探讨

- Win7安装VC++6.0完全指南:解决兼容性与Office冲突

- MFC实现学生信息管理系统:登录与数据库操作