机器学习降维方法:PCA与非线性方法解析

需积分: 0 10 浏览量

更新于2024-08-05

收藏 13.68MB PDF 举报

本章节主要探讨了机器学习算法中的降维技术,特别是在高维空间下的数据分析问题。首先,通过背景介绍,我们了解到在处理大量数据时,可能会遇到过拟合问题,这可以通过正则化方法来解决,比如L2正则化,它通过在损失函数中引入权重的平方惩罚,限制模型复杂度,防止过度拟合。

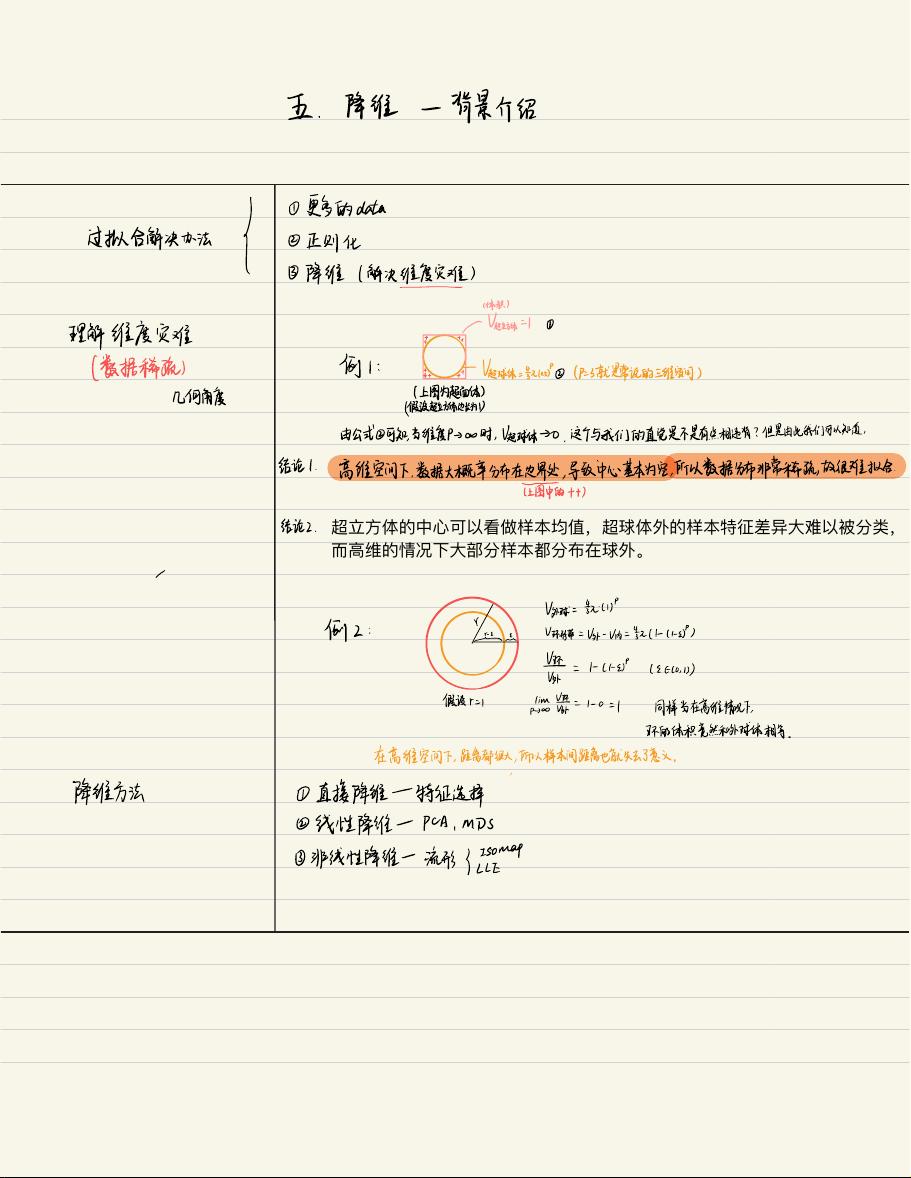

降维的核心目标是减少数据的维度,从而降低维度灾难,即随着维度的增加,数据集变得越来越稀疏,样本点更倾向于分布在高维空间的边界,中心区域变得非常空洞,使得数据拟合变得更加困难。例如,超立方体和超球体的概念,当维度增加时,超球体内的数据变得越来越少,而大部分样本位于球体之外,这是“维度灾难”的直观表现。

在几何角度上,高维空间中的距离概念变得模糊,样本间的相对距离可能失去实际意义。为了应对这种情况,出现了多种降维方法:

1. 直接降维:包括特征选择,即根据某些准则保留最重要的特征;线性降维方法,如主成分分析(PCA),它通过找到数据的线性组合,最大化方差,将原始数据转换到新的坐标系,使得新坐标轴的方向尽可能解释数据的方差。

2. 非线性降维:如流形学习,如局部线性嵌入(LLE)等,这些方法试图捕捉数据内在的低维结构,即使数据在高维空间中是非线性分布的。

在进行PCA前,通常需要对数据进行预处理,即中心化,即将每个数据点减去均值,使之转化为均值为零的数据分布,这样做的目的是为了简化计算,不会影响最终的降维结果。

降维是机器学习中重要的技术手段,它通过减少维度,揭示数据的本质结构,提高模型的效率和性能,尤其是在处理高维稀疏数据时,降维更是必不可少的步骤。通过理解降维背后的概率知识和几何原理,我们可以更好地应用这些方法在实际问题中。

2022-06-14 上传

点击了解资源详情

点击了解资源详情

2021-01-03 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

Msura

- 粉丝: 573

- 资源: 323

最新资源

- ES管理利器:ES Head工具详解

- Layui前端UI框架压缩包:轻量级的Web界面构建利器

- WPF 字体布局问题解决方法与应用案例

- 响应式网页布局教程:CSS实现全平台适配

- Windows平台Elasticsearch 8.10.2版发布

- ICEY开源小程序:定时显示极限值提醒

- MATLAB条形图绘制指南:从入门到进阶技巧全解析

- WPF实现任务管理器进程分组逻辑教程解析

- C#编程实现显卡硬件信息的获取方法

- 前端世界核心-HTML+CSS+JS团队服务网页模板开发

- 精选SQL面试题大汇总

- Nacos Server 1.2.1在Linux系统的安装包介绍

- 易语言MySQL支持库3.0#0版全新升级与使用指南

- 快乐足球响应式网页模板:前端开发全技能秘籍

- OpenEuler4.19内核发布:国产操作系统的里程碑

- Boyue Zheng的LeetCode Python解答集