掌握PCA降维算法的数学推导:深入理解降维本质

发布时间: 2024-07-20 12:19:20 阅读量: 72 订阅数: 41

PCA降维算法讲解和公式推导

# 1. PCA降维算法概述

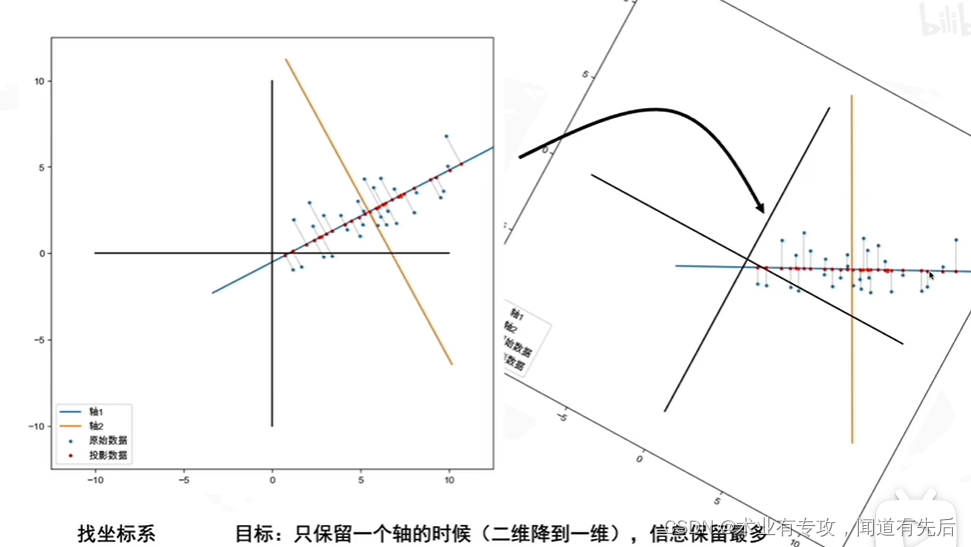

PCA(主成分分析)是一种经典的降维算法,广泛应用于数据分析和机器学习领域。其核心思想是将高维数据投影到低维空间,同时最大化投影后的数据方差。

PCA算法通过对数据协方差矩阵进行特征值分解,得到一组主成分。这些主成分是线性无关的,并且按照方差从大到小排列。通过选择前几个主成分,即可实现降维,保留原始数据中最重要的信息。

# 2. PCA降维算法的数学推导

### 2.1 协方差矩阵和特征值分解

#### 2.1.1 协方差矩阵的计算

协方差矩阵是一个对称矩阵,用于衡量不同特征之间的相关性。对于一个包含 $n$ 个样本和 $m$ 个特征的数据集,其协方差矩阵 $\Sigma$ 的计算公式为:

```python

import numpy as np

def compute_covariance_matrix(X):

"""计算协方差矩阵。

Args:

X: 数据集,形状为 (n, m),其中 n 是样本数,m 是特征数。

Returns:

协方差矩阵,形状为 (m, m)。

"""

# 计算样本均值

mean = np.mean(X, axis=0)

# 计算协方差矩阵

covariance_matrix = np.cov(X - mean)

return covariance_matrix

```

#### 2.1.2 特征值分解的原理

特征值分解是将一个对称矩阵分解为一个由特征值和特征向量组成的矩阵。对于一个协方差矩阵 $\Sigma$,其特征值分解公式为:

```

Σ = VΛV^T

```

其中:

* $V$ 是特征向量矩阵,其列向量为协方差矩阵的特征向量。

* $\Lambda$ 是特征值矩阵,其对角线元素为协方差矩阵的特征值。

特征值表示了协方差矩阵中不同特征的方差贡献,特征向量表示了这些特征在原始数据空间中的方向。

### 2.2 主成分分析

#### 2.2.1 主成分的定义

主成分是协方差矩阵的特征向量,它表示了数据集中方差最大的方向。前 $k$ 个主成分构成了 $k$ 维子空间,称为主成分子空间。

#### 2.2.2 主成分的计算

主成分的计算可以通过对协方差矩阵进行特征值分解来获得。协方差矩阵的特征向量就是主成分,特征值表示了主成分的方差贡献。

```python

import numpy as np

def compute_principal_components(covariance_matrix, num_components):

"""计算主成分。

Args:

covariance_matrix: 协方差矩阵,形状为 (m, m)。

num_components: 要计算的主成分数。

Returns:

主成分矩阵,形状为 (m, num_components)。

"""

# 计算特征值和特征向量

eigenvalues, eigenvectors = np.linalg.eig(covariance_matrix)

# 按特征值降序排列

sorted_indices = np.argsort(eigenvalues)[::-1]

# 获取前 num_components 个特征向量

principal_components = eigenvectors[:, sorted_indices[:num_components]]

return principal_components

```

### 2.3 降维过程

#### 2.3.1 降维的原理

降维是将原始数据投影到主成分子空间的过程。通过选择前 $k$ 个主成分,可以将原始数据从 $m$ 维降维到 $k$ 维。

#### 2.3.2 降维的实现

降维的实现可以通过将原始数据与主成分矩阵相乘来完成。

```python

import numpy as np

def reduce_dimension(data, principal_components, num_components):

"""降维。

Args:

data: 原始数据,形状为 (n, m)。

principal_components: 主成分矩阵,形状为 (m, num_components)。

num_components: 要降维到的维数。

Returns:

降维后的数据,形状为 (n, num_components)。

"""

# 将原始数据投影到主成分子空间

reduced_data = np.dot(data, principal_components[:, :num_components])

return reduced_data

```

# 3.1 数据预处理

在进行PCA降维之前,需要对数据进行预处理,以确保数据的质量和降维效果。数据预处理主要包括数据标准化和数据归一化。

#### 3.1.1 数据标准化

数据标准化是指将数据中的每个特征缩放到均值为0,标准差为1。其目的是消除不同特征之间量纲和单位的影响,使数据具有可比性。

**代码块:**

```python

import numpy as np

def standardize(data):

"""

数据标准化

参数:

data: 输入数据,形状为(n_samples, n_features)

返回:

标准化后的数据

"""

mean = np.mean(data, axis=0)

std = np.std(data, axis=0)

return (data - mean) / std

```

**逻辑分析:**

该代码块实现了数据标准化。首先,它计算每个特征的均值和标准差。然后,它将每个特征减去其均值并除以其标准差,从而将数据标准化到均值为0,标准差为1。

#### 3.1.2 数据归一化

数据归一化是指将数据中的每个特征缩放到[0, 1]的范围内。其目的是消除不同特征之间数值大小的差异,使数据具有可比性。

**代码块:**

```python

import numpy as np

def normalize(data):

"""

数据归一化

参数:

data: 输入数据,形状为(n_samples, n_features)

返回:

归一化后的数据

"""

min_val = np.min(data, axis=0)

max_val = np.max(data, axis=0)

return (data - min_val) / (max_val - min_val)

```

**逻辑分析:**

该代码块实现了数据归一化。首先,它计算每个特征的最小值和最大值。然后,它将每个特征减去其最小值并除以其最大值和最小值的差,从而将数据归一化到[0, 1]的范围内。

# 4. PCA降维算法的进阶应用

### 4.1 核PCA降维

**4.1.1 核函数的选取**

核函数在核PCA中起着至关重要的作用,它将原始数据映射到一个更高维度的特征空间,从而使数据在高维空间中线性可分。常用的核函数包括:

- 线性核:`K(x, y) = x^T y`

- 多项式核:`K(x, y) = (x^T y + c)^d`

- RBF核:`K(x, y) = exp(-γ ||x - y||^2)`

核函数的选择取决于数据的性质和降维的目标。对于线性可分的原始数据,线性核即可满足要求;对于非线性可分的原始数据,需要选择多项式核或RBF核。

### 4.1.2 核PCA的原理

核PCA的原理与标准PCA类似,但它通过核函数将原始数据映射到高维特征空间。具体步骤如下:

1. **计算核矩阵:**计算原始数据所有样本之间的核矩阵`K`,其中`K(i, j)`表示第`i`个样本和第`j`个样本之间的核函数值。

2. **特征值分解:**对核矩阵`K`进行特征值分解,得到特征值`λ`和特征向量`v`。

3. **投影:**将原始数据投影到特征空间,得到降维后的数据`Z`:`Z = Xv`,其中`X`是原始数据,`v`是特征向量。

### 4.2 流形学习降维

**4.2.1 流形学习的原理**

流形学习是一种非线性降维技术,它假设数据分布在低维流形上,而流形可以嵌入到高维空间中。流形学习算法的目标是找到这个低维流形,并将数据投影到流形上。

### 4.2.2 t-SNE算法

t-SNE(t分布随机邻域嵌入)是一种流行的流形学习算法,它通过最小化原始数据和降维后的数据之间的t分布相似性的差异来学习流形。t-SNE算法的步骤如下:

1. **计算相似度矩阵:**计算原始数据所有样本之间的相似度矩阵`S`,其中`S(i, j)`表示第`i`个样本和第`j`个样本之间的相似度。

2. **构造t分布:**对相似度矩阵`S`进行t分布转换,得到t分布相似度矩阵`P`。

3. **优化目标函数:**定义目标函数为`F(P, Q)`,其中`P`是t分布相似度矩阵,`Q`是降维后的数据之间的相似度矩阵。目标函数的目的是最小化`F(P, Q)`。

4. **梯度下降:**使用梯度下降算法优化目标函数`F(P, Q)`,得到降维后的数据`Z`。

### 4.3 降维算法的比较

**4.3.1 不同降维算法的优缺点**

| 降维算法 | 优点 | 缺点 |

|---|---|---|

| PCA | 线性降维,计算简单 | 对非线性数据效果不佳 |

| 核PCA | 可以处理非线性数据 | 计算复杂,参数选择困难 |

| 流形学习 | 可以学习非线性流形 | 计算复杂,对噪声敏感 |

**4.3.2 降维算法的选择策略**

降维算法的选择取决于数据的性质和降维的目标。对于线性可分的原始数据,PCA或核PCA是合适的选择。对于非线性可分的原始数据,流形学习算法是更好的选择。此外,还需要考虑计算复杂度和参数选择等因素。

# 5. PCA降维算法的局限性与展望

### 5.1 PCA降维算法的局限性

**5.1.1 线性降维的局限**

PCA是一种线性降维算法,这意味着它只能将数据投影到一个线性子空间中。然而,现实世界中的数据往往具有非线性的结构,因此PCA可能无法有效地捕获数据的内在结构。

**5.1.2 数据分布的影响**

PCA的降维效果受数据分布的影响。对于高斯分布的数据,PCA可以很好地工作。然而,对于非高斯分布的数据,PCA可能会产生不理想的结果。

### 5.2 PCA降维算法的展望

**5.2.1 非线性降维算法的发展**

为了克服PCA的线性降维局限,研究人员正在开发非线性降维算法。这些算法可以将数据投影到非线性子空间中,从而更好地捕获数据的内在结构。

**5.2.2 降维算法的可解释性研究**

PCA是一种黑盒算法,这意味着它的内部工作原理并不容易理解。为了提高降维算法的可解释性,研究人员正在探索新的方法来解释降维结果。

0

0