文本特征提取与降维:PCA降维算法在自然语言处理中的应用

发布时间: 2024-07-20 12:28:03 阅读量: 50 订阅数: 34

PCA实现特征降维.zip_PCA 特征_PCA 改进_改进PCA算法_特征 降维_降维

# 1. 文本特征提取与降维概述**

文本特征提取和降维是自然语言处理(NLP)中的关键技术。文本特征提取从文本数据中提取有意义的特征,而降维技术将高维特征空间映射到低维空间,以提高处理效率和模型性能。

文本特征提取方法包括分词、词干化和TF-IDF(词频-逆文档频率)特征提取。这些技术将文本转换为数值特征向量,便于计算机处理。

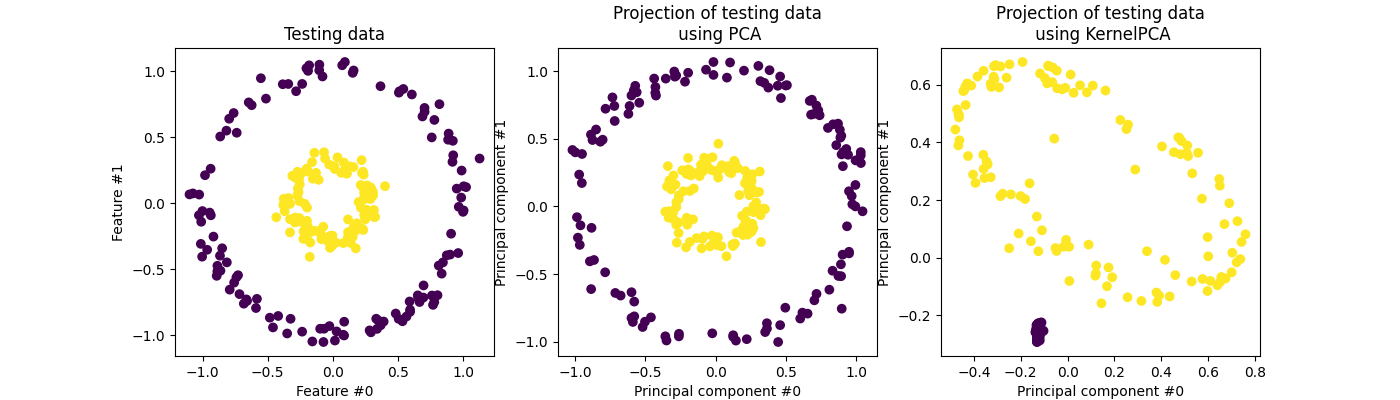

降维算法,如主成分分析(PCA),通过识别数据中的主要变异方向来将高维特征空间投影到低维空间。PCA算法将原始特征分解为线性组合,称为主成分,这些主成分包含了数据的大部分信息。

# 2.1 PCA降维算法的理论基础

### 2.1.1 协方差矩阵和特征值分解

协方差矩阵是衡量不同变量之间相关性的统计工具。对于一个包含n个样本和m个特征的数据集,其协方差矩阵C是一个m×m的对称矩阵,其中第i行第j列的元素表示第i个特征和第j个特征之间的协方差。

特征值分解是一种线性代数技术,可以将协方差矩阵分解为一组特征值和对应的特征向量。特征值表示协方差矩阵沿其特征向量方向的方差,而特征向量表示协方差矩阵沿这些方向的投影。

### 2.1.2 主成分分析的原理

主成分分析(PCA)是基于特征值分解的降维算法。其基本思想是将原始数据集投影到一个新的坐标系中,使得投影后的数据方差最大化。

具体来说,PCA将原始数据集投影到由协方差矩阵的特征向量组成的特征空间中。特征向量对应的特征值越大,则投影后的数据方差越大。通过选择前k个特征值对应的特征向量,可以将原始数据集降维到k维特征空间中,同时最大程度地保留原始数据的方差。

**代码块:**

```python

import numpy as np

from sklearn.decomposition import PCA

# 创建一个协方差矩阵

cov_matrix = np.array([[1, 0.5], [0.5, 1]])

# 进行特征值分解

eigenvalues, eigenvectors = np.linalg.eig(cov_matrix)

# 提取前2个特征向量

pca = PCA(n_components=2)

pca.fit(cov_matrix)

principal_components = pca.components_

```

**逻辑分析:**

该代码块展示了协方差矩阵的特征值分解和PCA降维的过程。首先,使用NumPy的`linalg.eig()`函数对协方差矩阵进行特征值分解,得到特征值和特征向量。然后,使用Scikit-Learn的`PCA`类进行PCA降维,指定`n_components=2`表示降维到2维特征空间。最后,`principal_components`变量存储了前2个特征向量,代表了投影后数据方差最大的两个方向。

# 3. PCA降维算法在自然语言处理中的应用

### 3.1 文本预处理与特征提取

在将PCA降维算法应用于自然语言处理任务之前,需要对文本数据进行预处理和特征提取。

#### 3.1.1 文本分词与词干化

文本分词是指将文本中的句子分解成单词或词组的过程。词干化是指将单词还原为其基本形式或词根的过程。这些步骤有助于去除文本中的停用词(如“the”、“and”、“of”)和变体词(如“running”、“ran”、“runs”),从而减少文本的维度并提高特征的区分度。

#### 3.1.2 TF-IDF特征提取

TF-IDF(词频-逆文档频率)是一种常用的特征提取技术,它考虑了单词在文本中出现的频率以及在整个文档集合中出现的频率。TF-IDF权重计算如下:

```python

tf_idf(t, d, D) = tf(t, d) * idf(t, D)

```

其中:

* `tf(t, d)`:单词`t`在文档`d`中出现的频率

* `idf(t, D)`:单词`t`在文档集合`D`中出现的逆文档频率,计算为:

```python

idf(t, D) =

```

0

0