在Hadoop框架中,MapReduce是一种用于大规模数据处理的编程模型,它将复杂的计算任务分解为一系列简单的操作,通过分布式执行来提高效率。本篇内容主要围绕MapReduce中的WordCount示例进行讲解,这是一个经典的MapReduce应用,用于统计文本文件中每个单词出现的次数。

标题“MapReduce之Wordcount实现”表明我们将深入理解如何在Hadoop上使用MapReduce API来执行单词计数任务。描述强调了代码的讲解性和易懂性,这意味着我们将看到实际的Java代码,并逐行剖析其工作原理。

首先,我们导入必要的Hadoop库,如`Configuration`, `Mapper`, `Reducer`, `FileInputFormat`, `TextInputFormat`, `TextOutputFormat`, `IntWritable`, `LongWritable`, 和 `Text`。这些库提供了与Hadoop集群交互的基础组件,如配置文件管理、输入/输出格式以及处理map和reduce阶段的数据结构。

在`WordCount`类中,我们定义了一个名为`Map`的子类,它继承自`Mapper<LongWritable, Text, Text, IntWritable>`。这里的泛型参数说明如下:

1. 输入key类型:`LongWritable`,通常在Hadoop MapReduce中,键(key)是小数据类型,这里表示行号或文件偏移量,用于定位输入数据。

2. 输入value类型:`Text`,代表文本数据,即文件中的每一行。

3. 输出key类型:`Text`,映射后的单词将成为键,用于后续的reduce操作。

4. 输出value类型:`IntWritable`,表示每个单词出现的次数,初始值为`IntWritable(1)`,因为每个单词出现一次就增加1。

`Map`类中的`@Override`注解标识该方法是`Mapper`接口的实现,`map()`方法是核心函数,它接收输入的行(`LongWritable`和`Text`),然后对每行进行处理。在这个方法中,通过`StringTokenizer`将输入行分割成单词,将每个单词赋值给`word`变量,同时将`one`作为value的计数器增加1。这样,对于每一行,都会生成一个键值对,键是单词,值是1。

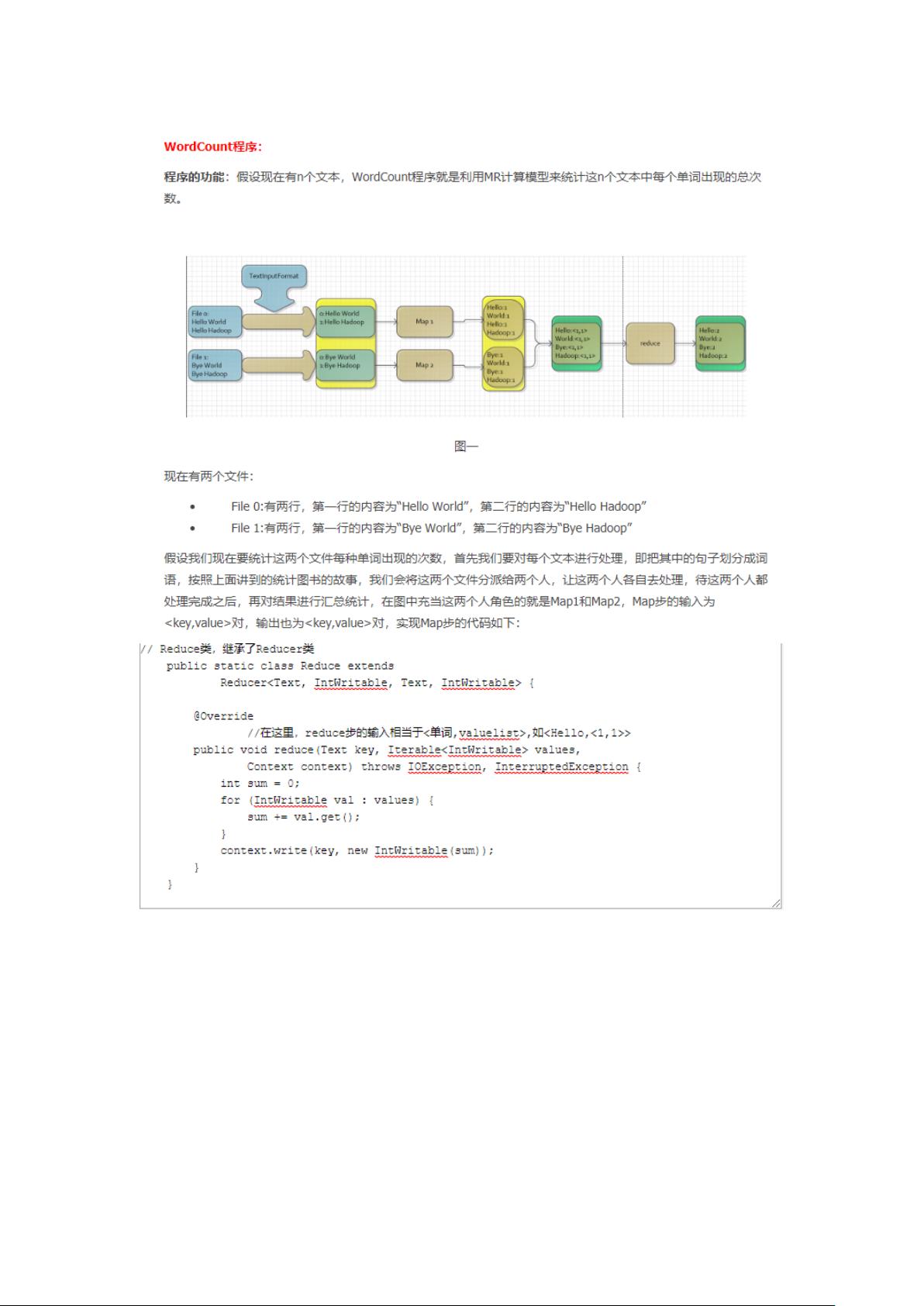

接下来是`Reducer`类,它继承自`Reducer<Text, IntWritable, Text, IntWritable>`。Reducer负责将mapper阶段产生的键值对按照键进行合并,从而得到每个单词的总计数。`Reducer`的`reduce()`方法接收相同的键(单词)和一组值(计数),将它们相加,然后输出最终的键(单词)和值(总次数)。

最后,`WordCount`类包含创建Job对象、设置输入和输出路径、配置Job、执行Job以及清理输出等步骤。`GenericOptionsParser`用于处理命令行参数,使得程序能够动态接受用户输入。

总结来说,这个WordCount实现展示了MapReduce的基本架构,包括数据的划分、map阶段的键值对生成、reduce阶段的计数聚合,以及如何在Hadoop环境中运行整个流程。通过这个实例,读者可以深入理解MapReduce的工作原理,并能在实际项目中应用这一强大的工具来处理大规模数据。