【BP神经网络预测秘籍】:从入门到精通,揭秘预测模型的奥秘

发布时间: 2024-07-21 15:18:51 阅读量: 36 订阅数: 30

# 1. BP神经网络基础理论

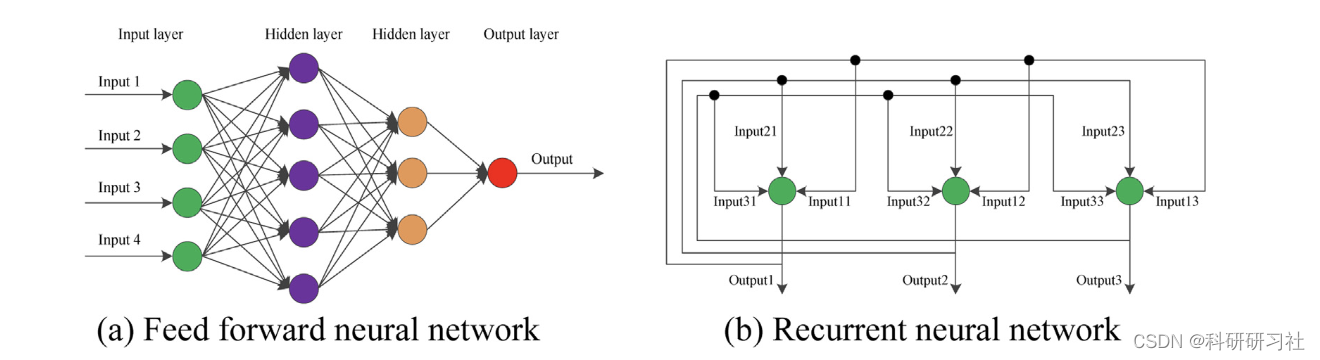

BP神经网络是一种前馈神经网络,它通过反向传播算法进行训练。BP神经网络由输入层、隐含层和输出层组成。输入层接收输入数据,隐含层处理数据并提取特征,输出层产生预测结果。

BP神经网络的训练过程包括以下步骤:

1. **前向传播:**输入数据通过网络,从输入层到输出层,计算输出结果。

2. **误差计算:**输出结果与期望输出之间的误差被计算出来。

3. **反向传播:**误差通过网络反向传播,计算每个权重的梯度。

4. **权重更新:**权重根据梯度下降法进行更新,以减少误差。

# 2. BP神经网络算法实践

### 2.1 BP神经网络的结构和原理

#### 2.1.1 神经元的结构和激活函数

神经元是BP神经网络的基本组成单元,它模拟了生物神经元的结构和功能。一个神经元由以下部分组成:

- **输入层:** 接收来自其他神经元或外部数据的输入信号。

- **权重:** 与每个输入信号关联的数值,用于调节输入信号对神经元输出的影响。

- **偏置:** 一个常数值,用于调节神经元的激活阈值。

- **激活函数:** 一个非线性函数,用于将神经元的加权和转换为输出信号。

常用的激活函数包括:

- **Sigmoid函数:** `f(x) = 1 / (1 + e^(-x))`

- **ReLU函数:** `f(x) = max(0, x)`

- **tanh函数:** `f(x) = (e^x - e^(-x)) / (e^x + e^(-x))`

#### 2.1.2 网络的拓扑结构和权重初始化

BP神经网络通常采用分层结构,其中神经元按层组织。最常见的是前馈网络,其中数据从输入层流向输出层,中间没有循环连接。

权重初始化对于神经网络的训练至关重要。常用的初始化方法包括:

- **随机初始化:** 随机生成权重,通常从正态分布或均匀分布中采样。

- **Xavier初始化:** 根据输入和输出神经元的数量计算权重,以避免梯度消失或爆炸。

- **He初始化:** 适用于ReLU激活函数,计算权重以保持网络层的方差一致。

### 2.2 BP神经网络的训练过程

#### 2.2.1 误差反向传播算法

误差反向传播(BP)算法是训练BP神经网络的关键步骤。它通过计算输出与目标之间的误差,然后将误差反向传播到网络中,调整权重和偏置以减少误差。

BP算法的步骤如下:

1. **前向传播:** 将输入数据通过网络,计算每个神经元的输出。

2. **误差计算:** 计算输出与目标之间的误差,通常使用均方误差(MSE)或交叉熵损失。

3. **反向传播:** 根据链式法则计算误差相对于权重和偏置的梯度。

4. **权重更新:** 使用梯度下降法或其他优化算法更新权重和偏置,以减少误差。

#### 2.2.2 梯度下降法和优化算法

梯度下降法是一种迭代优化算法,用于最小化目标函数(在本例中为误差函数)。它通过沿梯度负方向更新权重和偏置来逐步减少误差。

常用的优化算法包括:

- **随机梯度下降(SGD):** 在每个训练样本上更新权重和偏置。

- **小批量梯度下降(MBGD):** 在小批量训练样本上更新权重和偏置。

- **动量法:** 考虑梯度历史,以加速收敛并减少振荡。

- **RMSProp:** 自适应调整学习率,以提高收敛速度和稳定性。

#### 2.2.3 训练数据的准备和归一化

训练数据的准备和归一化对于BP神经网络的训练至关重要。

- **数据准备:** 清理数据,处理缺失值和异常值,并将其划分为训练集、验证集和测试集。

- **数据归一化:** 将数据缩放或中心化,以确保所有特征具有相似的范围,并防止某些特征对训练产生过大影响。

### 2.3 BP神经网络的评估和调优

#### 2.3.1 模型评估指标和过拟合问题

模型评估指标用于衡量BP神经网络的性能。常用的指标包括:

- **准确率:** 正确预测的样本数量与总样本数量的比率。

- **召回率:** 实际为正例且被预测为正例的样本数量与实际为正例的样本数量的比率。

- **F1分数:** 准确率和召回率的加权平均值。

过拟合是指模型在训练集上表现良好,但在新数据上表现不佳的情况。为了避免过拟合,可以采用以下技术:

- **正则化:** 向损失函数添加惩罚项,以防止权重过大。

- **Dropout:** 在训练过程中随机丢弃某些神经元,以减少模型对特定特征的依赖性。

- **早期停止:** 在验证集上的误差停止下降时停止训练,以防止过拟合。

#### 2.3.2 超参数优化和正则化方法

超参数优化是指调整BP神经网络的超参数(例如学习率、批次大小、网络架构)以提高性能。常用的超参数优化方法包括:

- **网格搜索:** 系统地尝试不同的超参数组合,并选择产生最佳结果的组合。

- **贝叶斯优化:** 使用贝叶斯统计来指导超参数搜索,以更有效地探索超参数空间。

正则化方法用于防止过拟合,包括:

- **L1正则化(Lasso):** 向损失函数添加权重绝对值的惩罚项。

- **L2正则化(Ridge):** 向损失函数添加权重平方和的惩罚项。

- **弹性网络正则化:** L1和L2正则化的组合。

# 3.1 时间序列预测

#### 3.1.1 时间序列数据的处理和预处理

时间序列数据是指随着时间推移而收集的一系列观测值,通常表现为有序序列。在使用BP神经网络进行时间序列预测之前,需要对数据进行适当的处理和预处理,以提高模型的准确性和鲁棒性。

**数据清洗和转换:**

* **缺失值处理:**对于缺失值,可以采用插值、删除或使用其他时间序列数据填充。

* **异常值处理:**异常值可能会对模型产生负面影响,需要将其识别并处理,例如通过Z分数或箱形图。

* **数据转换:**有时需要对数据进行转换以使其符合正态分布或其他特定分布,例如对数转换或平方根转换。

**特征工程:**

* **时滞特征:**通过将过去的时间步作为特征,可以捕捉时间序列中的依赖关系。

* **滑动窗口:**使用滑动窗口可以将时间序列数据分割成重叠或非重叠的子序列,作为模型的输入。

* **季节性分解:**如果时间序列数据具有季节性模式,可以将其分解为趋势、季节性和残差分量。

#### 3.1.2 BP神经网络在时间序列预测中的应用

BP神经网络可以有效地用于时间序列预测,其过程如下:

**网络结构:**

* 输入层:包含时滞特征或滑动窗口数据。

* 隐藏层:多个隐藏层可以捕捉时间序列中的复杂非线性关系。

* 输出层:预测未来时间步的值。

**训练过程:**

* 使用误差反向传播算法计算误差梯度。

* 使用梯度下降法或其他优化算法更新权重。

* 训练数据通常需要经过多次迭代才能收敛。

**评估和调优:**

* 使用交叉验证或留出法评估模型的预测性能。

* 调整网络结构、超参数(如学习率、隐藏层数量)和正则化方法以优化模型性能。

**代码示例:**

```python

import numpy as np

import pandas as pd

from sklearn.preprocessing import StandardScaler

from sklearn.model_selection import train_test_split

from keras.models import Sequential

from keras.layers import Dense, LSTM

# 加载数据

df = pd.read_csv('time_series_data.csv')

# 预处理

scaler = StandardScaler()

df['value'] = scaler.fit_transform(df['value'])

# 创建时滞特征

lags = 5

df['lag1'] = df['value'].shift(1)

df['lag2'] = df['value'].shift(2)

df['lag3'] = df['value'].shift(3)

df['lag4'] = df['value'].shift(4)

df['lag5'] = df['value'].shift(5)

# 分割数据集

X_train, X_test, y_train, y_test = train_test_split(df[['lag1', 'lag2', 'lag3', 'lag4', 'lag5']], df['value'], test_size=0.2)

# 创建模型

model = Sequential()

model.add(LSTM(units=100, return_sequences=True, input_shape=(lags, 1)))

model.add(LSTM(units=100))

model.add(Dense(units=1))

# 编译模型

model.compile(optimizer='adam', loss='mse')

# 训练模型

model.fit(X_train, y_train, epochs=100, batch_size=32, validation_data=(X_test, y_test))

# 评估模型

score = model.evaluate(X_test, y_test, verbose=0)

print('MSE:', score)

```

**逻辑分析:**

* `StandardScaler()`用于对数据进行标准化,确保特征具有相同的尺度。

* `train_test_split()`将数据集分割为训练集和测试集。

* LSTM层用于捕捉时间序列中的长期依赖关系。

* `return_sequences=True`允许LSTM层输出序列,以便将其馈送到下一个LSTM层。

* `Dense`层用于生成预测值。

* 模型使用`adam`优化器和`mse`损失函数进行训练。

* `evaluate()`方法用于评估模型在测试集上的性能。

# 4. BP神经网络高级技巧

### 4.1 卷积神经网络(CNN)

#### 4.1.1 CNN的结构和原理

卷积神经网络(CNN)是一种专门用于处理网格状数据的神经网络,如图像。与传统的神经网络不同,CNN具有以下特点:

- **卷积层:**卷积层是CNN的核心组件。它使用一组称为卷积核的小型滤波器在输入数据上滑动。卷积核提取输入数据的局部特征,生成一个称为特征图的新数据。

- **池化层:**池化层用于对特征图进行降采样,减少其尺寸和计算成本。池化操作包括最大池化和平均池化。

- **全连接层:**全连接层与传统神经网络中的层类似。它将特征图展平为一维向量,并使用全连接权重对其进行处理。

#### 4.1.2 CNN在图像处理和识别中的应用

CNN在图像处理和识别领域取得了巨大的成功。其应用包括:

- **图像分类:**CNN可以识别图像中的对象并将其分类到不同的类别中。

- **目标检测:**CNN可以检测图像中的对象并确定其边界框。

- **图像分割:**CNN可以将图像分割成不同的区域,每个区域对应于不同的对象或场景。

### 4.2 循环神经网络(RNN)

#### 4.2.1 RNN的结构和原理

循环神经网络(RNN)是一种专门用于处理序列数据的递归神经网络。RNN具有以下特点:

- **记忆单元:**RNN中的记忆单元存储着过去的信息,并将其传递到未来的时间步。

- **循环连接:**RNN中的神经元以循环方式连接,允许信息在时间步之间传递。

- **门机制:**门机制用于控制信息在记忆单元中流动的方式。

#### 4.2.2 RNN在自然语言处理和时间序列预测中的应用

RNN在自然语言处理和时间序列预测领域取得了广泛的应用。其应用包括:

- **自然语言处理:**RNN可以处理文本数据,用于自然语言理解、机器翻译和文本生成。

- **时间序列预测:**RNN可以预测时间序列数据的未来值,用于股票市场预测、天气预报和医疗诊断。

### 4.3 生成对抗网络(GAN)

#### 4.3.1 GAN的结构和原理

生成对抗网络(GAN)是一种生成式神经网络,可以从数据中生成新的样本。GAN由两个网络组成:

- **生成器:**生成器网络从随机噪声中生成数据样本。

- **判别器:**判别器网络区分生成的数据样本和真实数据样本。

#### 4.3.2 GAN在图像生成和风格迁移中的应用

GAN在图像生成和风格迁移领域取得了显著的进展。其应用包括:

- **图像生成:**GAN可以从随机噪声中生成逼真的图像,用于图像合成和艺术创作。

- **风格迁移:**GAN可以将一种图像的风格转移到另一种图像上,用于艺术效果和图像编辑。

# 5. BP神经网络工程实践

### 5.1 BP神经网络的部署和优化

#### 5.1.1 模型的部署和封装

在训练好BP神经网络模型后,需要将其部署到实际应用中。模型部署涉及将训练好的模型打包成可执行文件或库,以便在不同的环境中使用。

**模型封装**

模型封装是指将训练好的模型包装成一个易于使用的接口,以便其他应用程序或用户可以方便地调用。常见的模型封装方法包括:

- **TensorFlow Serving:**谷歌开发的模型部署框架,提供RESTful API和gRPC接口。

- **ONNX:**开放神经网络交换格式,允许将模型导出为标准化格式,以便在不同框架和平台上部署。

- **PMML:**可移植建模标记语言,用于将模型转换为XML格式,以便在不同的商业智能和分析工具中部署。

**模型部署**

模型部署的具体方式取决于实际应用场景和部署环境。常见的部署方式包括:

- **本地部署:**将模型部署在本地服务器或设备上,直接提供服务。

- **云部署:**将模型部署在云平台上,通过云服务提供接口。

- **边缘部署:**将模型部署在边缘设备上,如物联网设备或移动设备,实现低延迟和本地化服务。

#### 5.1.2 模型的优化和加速

在部署BP神经网络模型后,通常需要对其进行优化和加速,以提高推理效率和降低计算成本。常见的优化和加速技术包括:

**模型剪枝**

模型剪枝是指移除模型中不重要的权重和节点,从而减少模型大小和计算量。常见的剪枝算法包括:

- **权重剪枝:**移除绝对值较小的权重。

- **节点剪枝:**移除对模型输出影响较小的节点。

**量化**

量化是指将浮点权重和激活值转换为低精度格式,如int8或int16,从而减少内存占用和计算量。常见的量化算法包括:

- **均匀量化:**将浮点值映射到离散的低精度值。

- **自适应量化:**根据输入数据的分布动态调整量化参数。

**并行化**

并行化是指将模型的计算任务分配到多个计算单元,如CPU或GPU,从而提高推理速度。常见的并行化技术包括:

- **数据并行:**将不同的数据样本分配到不同的计算单元。

- **模型并行:**将模型的不同层或模块分配到不同的计算单元。

# 6.1 BP神经网络的理论发展

### 6.1.1 深度学习的理论基础

深度学习是机器学习的一个子领域,它使用多层神经网络来学习数据的复杂表示。BP神经网络是深度学习的基础,其理论基础包括:

- **多层神经网络的表示能力:**多层神经网络可以学习数据中的复杂模式,因为每一层都可以学习前一层的表示。

- **梯度下降的收敛性:**梯度下降是训练BP神经网络的常用算法,它保证了在一定条件下可以找到局部最优解。

- **正则化方法:**正则化方法可以防止过拟合,提高模型的泛化能力。

### 6.1.2 新型神经网络结构和算法

随着深度学习的发展,出现了许多新型的神经网络结构和算法,例如:

- **卷积神经网络(CNN):**CNN在图像处理和识别中表现出色,它利用卷积操作提取图像中的空间特征。

- **循环神经网络(RNN):**RNN适合处理时序数据,它可以学习序列中的依赖关系。

- **生成对抗网络(GAN):**GAN可以生成逼真的数据,它通过对抗性训练来学习数据分布。

这些新型的神经网络结构和算法极大地扩展了BP神经网络的应用范围,推动了深度学习的发展。

0

0