BERT文本分类与其他文本分类算法的对比:优势、劣势及适用场景

发布时间: 2024-08-20 03:09:35 阅读量: 81 订阅数: 24

bert文本分类 代码+数据

# 1. BERT文本分类概述

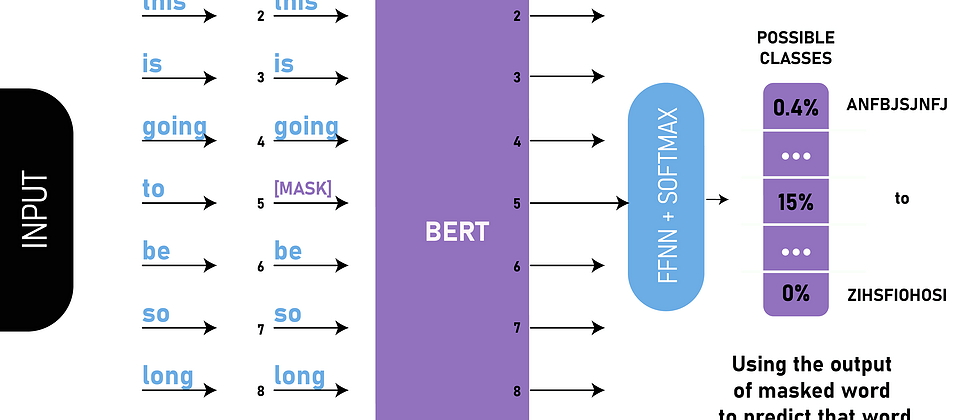

BERT(双向编码器表示模型)是一种强大的文本表示模型,在自然语言处理(NLP)领域取得了突破性的进展。BERT文本分类利用BERT模型强大的语义理解能力,可以有效地执行文本分类任务,例如情感分析、垃圾邮件检测和主题分类。

BERT文本分类的主要优点包括:

* **强大的语义理解能力:**BERT模型通过预训练在海量文本数据上,能够捕捉文本中的细微语义关系和上下文信息,从而提高文本分类的准确性。

* **跨语言和领域的可移植性:**BERT模型可以在多种语言和领域中进行微调,使其能够适应不同的文本类型和任务,具有较强的泛化能力。

# 2. BERT文本分类与其他算法的对比

BERT文本分类算法在自然语言处理领域取得了显著的成功,但它并非唯一的选择。为了全面了解BERT的优势和劣势,有必要将其与其他流行的文本分类算法进行对比。

### 2.1 优势对比

#### 2.1.1 强大的语义理解能力

BERT采用Transformer架构,具有强大的语义理解能力。它能够捕捉文本中的上下文关系和深层语义,从而对文本进行更准确的分类。与其他算法相比,BERT在以下方面表现出优势:

- **上下文建模:** BERT采用双向Transformer,可以同时考虑文本的前后语境,从而获得更全面的语义理解。

- **词嵌入:** BERT使用预训练的词嵌入,将单词映射到高维语义空间,增强了模型对单词含义的理解。

- **注意力机制:** BERT的注意力机制允许模型重点关注文本中与分类任务相关的部分,提高了模型对关键信息的提取能力。

#### 2.1.2 跨语言和领域的可移植性

BERT的预训练模型涵盖了大量语言和领域,使其具有跨语言和领域的可移植性。这意味着BERT模型可以在不同的语言和领域中进行微调,而无需进行大量的特定领域数据训练。这极大地降低了模型开发和部署的成本。

### 2.2 劣势对比

尽管BERT在文本分类方面表现出色,但它也存在一些劣势:

#### 2.2.1 训练和推理成本高

BERT模型的训练和推理成本都比较高。由于BERT模型庞大且复杂,训练需要大量的计算资源和时间。推理阶段,BERT模型也需要占用大量的内存和计算能力。

#### 2.2.2 模型复杂度和可解释性低

BERT模型的复杂度很高,导致其可解释性较低。模型内部的机制和参数难以理解,这给模型的调试和优化带来了困难。

### 2.2.3 算法对比表格

为了更直观地比较BERT文本分类算法与其他算法的优势和劣势,我们总结了以下表格:

| 算法 | 优势 | 劣势 |

|---|---|---|

| BERT | 强大的语义理解能力 | 训练和推理成本高 |

| TF-IDF | 简单易用,可解释性高 | 语义理解能力弱 |

| 词袋模型 | 简单易用,训练成本低 | 忽略词序和语义关系 |

| CNN | 能够捕捉局部特征 | 无法捕捉长距离依赖关系 |

| LSTM | 能够捕捉长距离依赖关系 | 训练成本高,容易过拟合 |

# 3. BERT 文本分类的实践应用

### 3.1 BERT 文本分类的预训练和微调

#### 3.1.1 预训练模型的选择

在进行文本分类任务时,选择合适的预训练 BERT 模型至关重要。不同的预训练模型在不同的数据集和任务上表现出不同的性能。

| 预训练模型 | 优点 | 缺点 |

|---|---|---|

| BERT-Base | 训练数据量小,推理速度快 | 语义理解能力较弱 |

| BERT-Larg

0

0