揭秘BERT文本分类的原理:Transformer架构及注意力机制

发布时间: 2024-08-20 02:42:49 阅读量: 24 订阅数: 46

# 1. BERT文本分类概述

BERT(双向编码器表示器变换器)是一种预训练语言模型,在自然语言处理(NLP)任务中取得了突破性进展。它通过利用Transformer架构,能够捕捉文本序列中的上下文信息,并学习到单词和短语的丰富语义表示。在文本分类任务中,BERT可以有效地识别文本的主题和情感,并将其归类到特定的类别中。

BERT模型的独特之处在于它采用了双向训练机制,这意味着它可以同时从文本的左侧和右侧获取信息。这使得BERT能够更全面地理解文本的含义,并学习到单词之间的长距离依赖关系。此外,BERT还使用了自注意力机制,它允许模型关注文本中最重要的部分,并赋予它们更高的权重。

# 2. Transformer架构的理论基础

Transformer架构是BERT模型的核心,它引入了一种称为自注意力的新机制,彻底改变了自然语言处理任务的处理方式。本节将深入探讨Transformer架构的理论基础,包括其编码器和解码器组件、自注意力机制、位置编码和层归一化。

### 2.1 Transformer的编码器和解码器

Transformer架构由两个主要组件组成:编码器和解码器。编码器负责将输入序列转换为一组固定长度的向量,而解码器则利用这些向量生成输出序列。

#### 编码器

编码器由一系列编码器层组成,每个层包含两个子层:

1. **自注意力子层:**计算输入序列中每个元素与其他所有元素之间的注意力权重,从而捕获序列中元素之间的长期依赖关系。

2. **前馈神经网络子层:**应用一个前馈神经网络,对每个元素进行非线性变换,增强其表征能力。

#### 解码器

解码器也由一系列解码器层组成,每个层包含三个子层:

1. **蒙版自注意力子层:**与编码器中的自注意力子层类似,但它使用一个蒙版来防止解码器访问未来的元素。

2. **编码器-解码器注意力子层:**计算解码器中的每个元素与编码器输出中的所有元素之间的注意力权重,从而将编码器中的信息整合到解码器中。

3. **前馈神经网络子层:**与编码器中的前馈神经网络子层类似,但它应用于解码器中的每个元素。

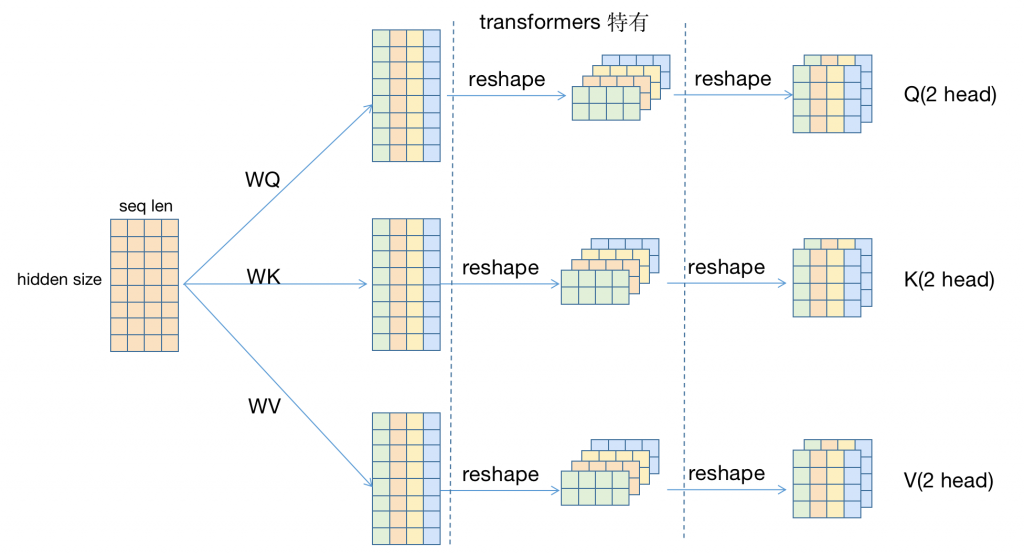

### 2.2 自注意力机制和多头注意力

自注意力机制是Transformer架构的关键创新。它允许模型在不使用递归或卷积操作的情况下捕获序列中元素之间的长期依赖关系。

自注意力机制计算一个查询向量与一组键值向量的注意力权重。然后,将这些权重与值向量相乘,得到一个加权和,作为输出。

多头注意力是一种自注意力机制的扩展,它将输入序列投影到多个不同的子空间,并对每个子空间计算自注意力。然后,将这些子空间的输出连接起来,形成最终的自注意力输出。

### 2.3 位置编码和层归一化

#### 位置编码

Transformer架构不使用递归或卷积操作,因此无法从输入序列中学习元素的位置信息。为了解决这个问题,在输入序列中添加了位置编码,以提供元素的相对位置信息。

#### 层归一化

层归一化是一种正则化技术,应用于每个编码器和解码器层。它通过将每个层的输出归一化为零均值和单位方差来稳定训练过程。

```python

import torch

from torch.nn import TransformerEncoderLayer, TransformerDecoderLayer

# 创建编码器层

encoder_layer = TransformerEncoderLayer(d_model=512, nhead=8)

# 创建解码器层

decoder_layer = TransformerDecoderLayer(d_model=512, nhead=8)

# 输入序列

input_seq = torch.randn(10, 512)

# 编码器输出

encoder_output = encoder_lay

```

0

0