BERT文本分类模型评估全解析:指标解读及优化策略

发布时间: 2024-08-20 02:29:32 阅读量: 50 订阅数: 24

DocumentUnderstanding-Steps:分类样本

# 1. BERT文本分类模型概述**

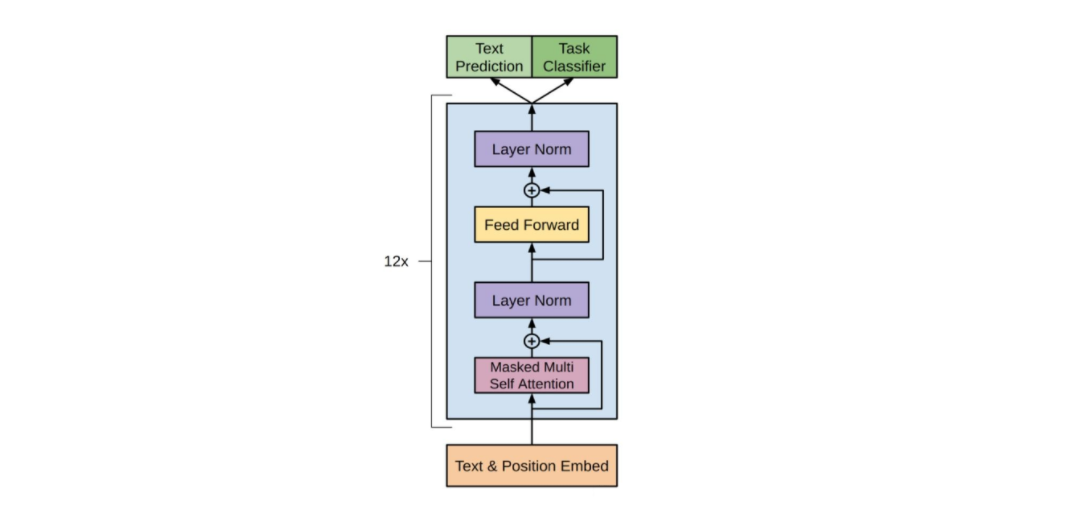

BERT(Bidirectional Encoder Representations from Transformers)是一种预训练的自然语言处理(NLP)模型,它通过双向Transformer编码器对大规模文本语料库进行训练。BERT模型在文本分类任务中表现出卓越的性能,因为它能够有效地捕捉文本中的语义信息和上下文关系。

BERT文本分类模型的架构通常包括一个BERT编码器和一个分类器。BERT编码器将输入文本转换为一个语义丰富的向量表示,该向量表示包含了文本中单词的上下文信息。分类器随后使用此向量表示来预测文本的类别。

BERT文本分类模型在各种文本分类任务中得到了广泛的应用,例如情感分析、垃圾邮件检测和语言识别。其强大的表示能力和可扩展性使其成为解决复杂文本分类问题的理想选择。

# 2. BERT文本分类模型评估指标

### 2.1 精度、召回率和F1值

#### 2.1.1 精度和召回率的定义和计算方法

**精度(Precision)**:表示模型预测为正例的样本中,实际为正例的比例。

```python

precision = TP / (TP + FP)

```

其中:

* TP:真正例(True Positive),模型预测为正例且实际为正例的样本数

* FP:假正例(False Positive),模型预测为正例但实际为负例的样本数

**召回率(Recall)**:表示实际为正例的样本中,被模型预测为正例的比例。

```python

recall = TP / (TP + FN)

```

其中:

* FN:假负例(False Negative),模型预测为负例但实际为正例的样本数

#### 2.1.2 F1值的定义和计算方法

**F1值**:是精度和召回率的调和平均值,综合考虑了模型的精度和召回率。

```python

F1 = 2 * (precision * recall) / (precision + recall)

```

F1值介于0和1之间,值越大,表示模型的分类性能越好。

### 2.2 ROC曲线和AUC值

#### 2.2.1 ROC曲线的绘制和意义

**ROC曲线(Receiver Operating Characteristic Curve)**:是绘制真阳性率(TPR)与假阳性率(FPR)之间的曲线。

* 真阳性率(TPR):表示实际为正例的样本中,被模型预测为正例的比例,即召回率。

* 假阳性率(FPR):表示实际为负例的样本中,被模型预测为正例的比例。

ROC曲线可以反映模型在不同阈值下的分类性能,阈值越低,TPR越高,FPR也越高;阈值越高,TPR越低,FPR也越低。

#### 2.2.2 AUC值的定义和计算方法

**AUC(Area Und

0

0