BERT文本分类中的损失函数:衡量模型预测与真实标签的差异

发布时间: 2024-08-20 02:57:41 阅读量: 90 订阅数: 24

bert文本分类 代码+数据

# 1. BERT文本分类概述

BERT文本分类是一种利用BERT语言模型进行文本分类的任务。BERT(Bidirectional Encoder Representations from Transformers)是一种预训练的语言模型,它能够学习文本中的上下文信息,并将其编码为向量表示。文本分类任务的目标是根据文本的向量表示将其分配到预定义的类别中。

BERT文本分类具有以下特点:

- **高效性:**BERT模型经过预训练,能够快速有效地学习文本中的特征。

- **准确性:**BERT模型的上下文编码能力使其能够准确地识别文本中的语义信息。

- **可扩展性:**BERT模型可以应用于各种文本分类任务,包括情感分析、主题分类和垃圾邮件检测。

# 2. 文本分类中的损失函数理论

损失函数在机器学习中扮演着至关重要的角色,它衡量模型预测与真实标签之间的差异,并指导模型的训练过程。在文本分类任务中,损失函数的选择对模型的性能有着显著的影响。本章将深入探讨文本分类中常用的两种损失函数:交叉熵损失函数和焦点损失函数。

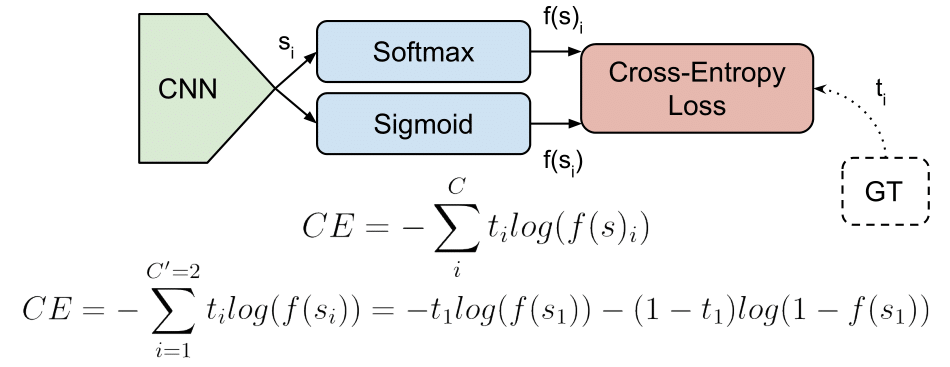

### 2.1 交叉熵损失函数

#### 2.1.1 交叉熵损失函数的定义和原理

交叉熵损失函数是一种用于衡量两个概率分布之间的差异的函数。在文本分类任务中,交叉熵损失函数计算模型预测的概率分布和真实标签分布之间的差异。

给定一个样本,其真实标签为 y,模型预测的概率分布为 p(y),则交叉熵损失函数定义为:

```

L(y, p(y)) = -log(p(y))

```

其中,log 表示自然对数。

#### 2.1.2 交叉熵损失函数的优点和缺点

**优点:**

* 简单易懂,易于实现。

* 适用于二分类和多分类任务。

* 在样本分布均匀的情况下,可以有效地惩罚模型的错误预测。

**缺点:**

* 当样本分布不均匀时,可能会导致模型对少数类别的预测不准确。

* 对异常值敏感,可能会导致模型的训练不稳定。

### 2.2 焦点损失函数

#### 2.2.1 焦点损失函数的定义和原理

焦点损失函数是一种改进的交叉熵损失函数,旨在解决交叉熵损失函数对异常值敏感的问题。焦点损失函数通过引入一个聚焦参数 α 来降低容易分类样本的权重,同时增加难以分类样本的权重。

焦点损失函数的定义如下:

```

FL(y, p(y)) = -(1 - p(y))<sup>α</sup> log(p(y))

```

其中,α 是聚焦参数,其值通常在 0 到 2 之间。

#### 2.2.2 焦点损失函数的优点和缺点

**优点:**

* 降低容易分类样本的权重,增加难以分类样本的权重,从而缓解样本分布不均匀的问题。

* 提高模型对异常值的鲁棒性,增强模型的稳定性。

**缺点:**

* 引入了一个额外的超参数 α,需要根据数据集和任务进行调整。

* 计算复杂度略高于交叉熵损失函数。

# 3. BERT文本分类中的损失函数实践

### 3.1 交叉熵损失函数在BERT文本分类中的应用

#### 3.1.1 交叉熵损失函数的实现方法

在PyTorch中,交叉熵损失函数可以通过`nn.CrossEntropyLoss`类实现。该类接收两个参数:`input`和`target`,其中`input`是模型输出的 logits,`target`是真实标签。

```python

import torch

import torch.nn as nn

# 定义模型输出的 logits

logits = torch.tensor([[0.2, 0.8], [0.3, 0.7]])

# 定义真实标签

target = torch.tensor([1, 0])

# 定义交叉熵损失函数

loss_fn = nn.CrossEntropyLoss()

# 计算损失

loss = loss_fn(logits, target)

```

#### 3.1.2 交叉熵损失函数的优化策略

优化交叉熵损失函数时,可以使用以下策略:

* **权重衰减:**通过向损失函数中添加正则化项来防止过拟合,例如L1或L2正则化。

* **学习率衰减:**随着训练的进行,逐渐降低学习率,以提高模型的稳定性。

* **动量:**使用动量优化器(例如SGD),它通过将当前梯度与前一个梯度相结合来加速收敛。

* **批量归一化:**在训练过程中对输入数据进行归一化,以减少内部协变量偏移。

### 3.2 焦点损失函数在BERT文本分类中的应用

#### 3.2.1 焦点损失函数的实现方法

在PyTorch中,焦点损失函数可以通过`FocalLoss`类实现。该类接收三个参数:`input`、`target`和`gamma`,其中`input`是模型输出的 logits,`target`是真实标签,`gamma`是焦点参数。

```python

import torch

import torch.nn as nn

from torch.nn.modules.loss import _WeightedLoss

# 定义模型输出的 logits

logits = torch.tensor([[0.2, 0.8], [0.3, 0.7]])

# 定义真实标签

target = torch.tensor([1, 0])

# 定义焦点损失函数

loss_fn = FocalLoss(gamma=2)

# 计算损失

loss = loss_fn(logits, target)

```

#### 3.2.2 焦点损失函数的优化策略

优化焦点损失函数时,可以使用以下策略

0

0