变分自编码器(VAE)的架构设计:从基础模型到高级变体,掌握生成式模型的架构设计精髓

发布时间: 2024-08-20 16:33:42 阅读量: 55 订阅数: 49

变分自编码器(VAE)及其条件模型介绍

# 1. 变分自编码器(VAE)概述

变分自编码器(VAE)是一种生成式神经网络模型,它通过学习数据中的潜在表示来生成新的数据样本。VAE 的核心思想是通过将数据编码为一个潜在的低维分布,然后从该分布中对新样本进行采样,从而捕获数据的变异性。这种方法使 VAE 能够生成多样化且逼真的样本,同时保留原始数据的关键特征。

# 2. VAE的基础模型架构

### 2.1 VAE的原理和数学基础

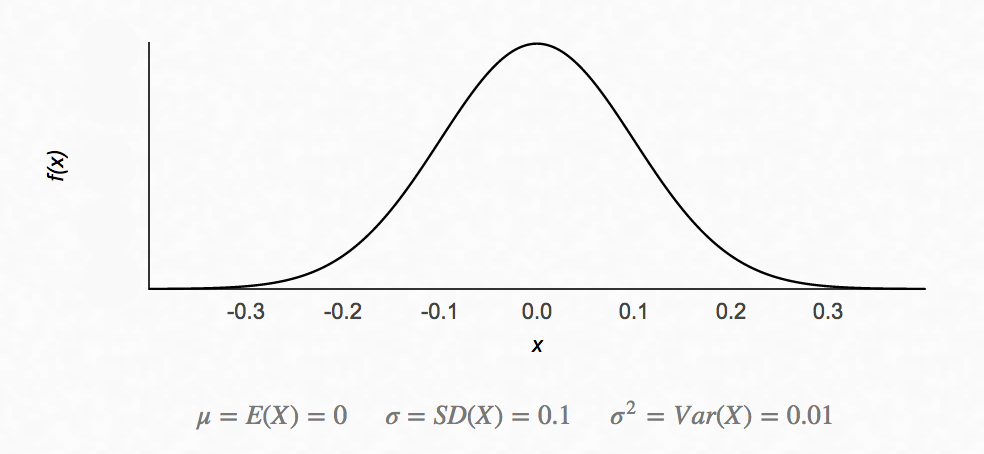

变分自编码器(VAE)是一种生成模型,它通过学习数据潜在表示来生成新的数据样本。VAE的原理基于变分推断,它将复杂的后验分布近似为一个更简单的分布,使得可以有效地进行采样。

**数学基础:**

VAE的数学基础建立在变分推断之上。给定一个观察数据 x,其后验分布 p(z|x) 难以直接计算。VAE引入一个近似分布 q(z|x),使得它与后验分布尽可能接近。

为了衡量 q(z|x) 和 p(z|x) 之间的差异,VAE使用 Kullback-Leibler (KL) 散度:

```

KL(q(z|x) || p(z|x)) = ∫ q(z|x) log q(z|x) / p(z|x) dz

```

VAE的目标是通过最小化 KL 散度来找到一个与后验分布最接近的近似分布。

### 2.2 VAE的生成和推理过程

**生成过程:**

给定一个潜在变量 z,VAE可以生成一个新的数据样本 x。生成过程如下:

1. 从先验分布 p(z) 中采样一个潜在变量 z。

2. 使用解码器网络 f(z) 生成数据样本 x。

**推理过程:**

给定一个观察数据 x,VAE可以推断其潜在表示 z。推理过程如下:

1. 使用编码器网络 g(x) 编码数据 x,得到潜在变量 z 的近似分布 q(z|x)。

2. 从 q(z|x) 中采样一个潜在变量 z。

### 代码示例

**解码器网络:**

```python

import tensorflow as tf

class Decoder(tf.keras.Model):

def __init__(self, latent_dim, output_dim):

super(Decoder, self).__init__()

self.latent_dim = latent_dim

self.output_dim = output_dim

self.dense1 = tf.keras.layers.Dense(units=512, activation='relu')

self.dense2 = tf.keras.layers.Dense(units=256, activation='relu')

self.dense3 = tf.keras.layers.Dense(units=output_dim, activation='sigmoid')

def call(self, z):

x = self.dense1(z)

x = self.dense2(x)

x = self.dense3(x)

return x

```

**编码器网络:**

```python

import tensorflow as tf

class Encoder(tf.keras.Model):

def __init__(self, latent_dim, input_dim):

super(Encoder, self).__init__()

self.latent_dim = latent_dim

self.input_dim = input_dim

self.dense1 = tf.keras.layers.Dense(units=512, activation='relu')

self.dense2 = tf.keras.layers.Dense(units=256, activation='relu')

self.dense3 = tf.keras.layers.Dense(units=latent_dim * 2, activation='linear')

```

0

0