图像生成中的变分自编码器(VAE):探索创造力的无限可能,释放你的想象力

发布时间: 2024-08-20 16:15:51 阅读量: 81 订阅数: 33

Pytorch实现VAE变分自动编码器生成MNIST手写数字图像

# 1. 图像生成概述

图像生成是计算机视觉领域的一项重要任务,旨在从数据中创建新的图像。近年来,变分自编码器(VAE)已成为图像生成领域的主流方法之一。VAE 是一种生成模型,它利用概率分布对数据进行编码和解码,从而生成新的图像。

VAE 的基本原理是将数据编码为一个潜在变量的概率分布,然后从该分布中对新数据进行采样。通过这种方法,VAE 能够生成具有与训练数据相似特征的新图像,同时还具有多样性和创造性。

# 2. 变分自编码器(VAE)理论基础

### 2.1 VAE的数学原理

#### 2.1.1 概率分布和贝叶斯定理

变分自编码器(VAE)是一种生成式模型,基于概率分布和贝叶斯定理的原理。概率分布描述了随机变量可能取值的可能性,而贝叶斯定理提供了将先验知识与观测数据相结合以更新概率分布的方法。

在VAE中,我们假设数据点x服从一个潜在分布p(x),而潜在变量z服从一个先验分布p(z)。通过贝叶斯定理,我们可以计算出后验分布p(z|x),即在观测到数据点x后潜在变量z的分布:

```

p(z|x) = p(x|z) * p(z) / p(x)

```

其中,p(x|z)是似然函数,描述了在给定潜在变量z的情况下观测到数据点x的概率。

#### 2.1.2 变分推断和KL散度

变分推断是一种近似后验分布p(z|x)的方法。由于后验分布通常难以直接计算,变分推断通过引入一个近似分布q(z|x)来近似后验分布。

KL散度衡量了近似分布q(z|x)与后验分布p(z|x)之间的差异:

```

KL(q(z|x) || p(z|x)) = ∫ q(z|x) * log(q(z|x) / p(z|x)) dz

```

变分推断的目标是找到一个近似分布q(z|x),使KL散度最小化。

### 2.2 VAE的模型结构

#### 2.2.1 编码器和解码器

VAE模型由两个神经网络组成:编码器和解码器。编码器将数据点x映射到潜在变量z,而解码器将潜在变量z映射回重建数据点x。

编码器网络通常由卷积层和全连接层组成,它将数据点x压缩成一个潜在表示z。解码器网络通常由反卷积层和全连接层组成,它将潜在表示z解压缩回重建数据点x。

#### 2.2.2 采样和重参数化技巧

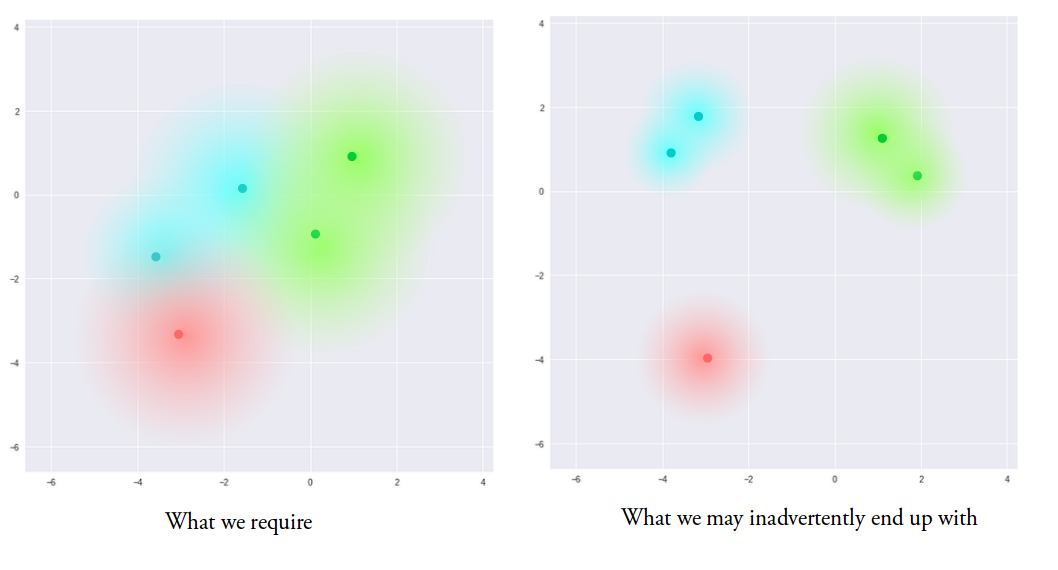

在VAE中,我们通过从近似分布q(z|x)中采样来生成潜在变量z。然而,直接从q(z|x)中采样可能导致梯度消失问题。

为了解决这个问题,VAE使用重参数化技巧。重参数化技巧将从q(z|x)中采样的随机变量ε转换为一个标准正态分布的随机变量。通过这种方式,梯度可以从重建误差反向传播到编码器和解码器网络。

# 3.1 VAE图像生成

#### 3.1.1 数据集准备和模型训练

**数据集准备**

VAE图像生成需要高质量且多样化的图像数据集。常见的数据集包括:

- CIFAR-10:包含 60,000 张 32x32 像素的彩色图像,分为 10 个类别。

- MNIST:包含 70,000 张 28x28 像素的灰度手写数字图像。

- ImageNet:包含超过 100 万张图像,涵盖广泛的类别。

**模型训练**

VAE模型的训练过程如下:

1. **初始化模型:**初始化编码器和解码器的权重和偏差。

2. **正向传播:**将图像输入编码器,生成隐变量 z。

3. **重参数化技巧:**对 z 进行重参数化,使其服从正态分布。

4. **反向传播:**将重参数化后的 z 输入解码器,生成重建图像。

5. **计算损失:**计算重建图像和输入图像之间的重建误差和 KL 散度。

6. **更新权重:**使用优化器更新编码器和解码器的权重和偏差,以最小化损失函数。

#### 3.1.2 生成图像的评估和可视化

**评估指标**

评估 VAE 生成图像的质量和多样性,可以使用以下指标:

- **重建误差:**衡量生成图像与输入图像之间的相似度。

- **FID(Fréchet Inception Distance):**衡量生成图像与真实图像之间的相似度和多样性。

- **IS(Inception Score):**衡量生成图像的质量和多样性。

**可视化技术**

为了可视化生成图像,可以使用以下技术:

- **网格可视化:**将生成图像排列成网格,以展示模型的生成能力。

- **动画可视化:**生成图像序列,以展示模型如何随着训练时间的推移而进化。

- **交互式可视化:**允许用户控制模型的超参数,并实时查看生成图像的变化。

# 4. VAE进阶探索

### 4.1 VAE的变体和扩展

#### 4.1.1 条件VAE和贝叶斯VAE

**条件VAE (CVAE)**通过引入一个条件变量来扩展VAE,该条件变量可以控制生成图像的特定属性。例如,在图像生成任务中,条件变量可以指定图像的类别或风格。

**贝叶斯VAE (BVAE)**将贝叶斯推理引入VAE中,允许对模型参数进行不确定性建模。BVAE通过对模型权重进行后验推断来提高模型的泛化能力和鲁棒性。

#### 4.1.2 循环VAE和变分RNN

**循环VAE (RVAE)**将循环神经网络 (RNN) 集成到VAE中,使其能够处理序列数据。RVAE可以生成动态图像或视频,其中每个帧都依赖于先前的帧。

**变分RNN (VRNN)**是RVAE的一种特殊情况,它使用变分推断来对RNN的隐藏状态进行建模。VRNN可以学习序列数据的潜在表示,并生成具有时间一致性的图像或视频。

### 4.2 VAE在其他领域的应用

#### 4.2.1 自然语言处理

VAE已被成功应用于自然语言处理 (NLP) 任务,例如文本生成、机器翻译和文本摘要。VAE可以学习文本数据的潜在表示,并生成连贯且有意义的文本。

#### 4.2.2 时间序列预测

VAE还用于时间序列预测任务,例如股票价格预测和天气预报。VAE可以学习时间序列数据的潜在动力学,并生成具有时间依赖性的预测。

**代码块:**

```python

import tensorflow as tf

# 定义条件VAE模型

class CVAE(tf.keras.Model):

def __init__(self, latent_dim, condition_dim):

super().__init__()

self.latent_dim = latent_dim

self.condition_dim = condition_dim

# 编码器

self.encoder = tf.keras.Sequential([

tf.keras.layers.Dense(256, activation='relu'),

tf.keras.layers.Dense(128, activation='relu'),

tf.keras.layers.Dense(latent_dim * 2)

])

# 解码器

self.decoder = tf.keras.Sequential([

tf.keras.layers.Dense(128, activation='relu'),

tf.keras.layers.Dense(256, activation='relu'),

tf.keras.layers.Dense(784, activation='sigmoid')

])

def encode(self, x, c):

# 将条件变量连接到输入

x_c = tf.concat([x, c], axis=1)

# 编码器

h = self.encoder(x_c)

# 分布参数

mean = h[:, :latent_dim]

log_var = h[:, latent_dim:]

return mean, log_var

def decode(self, z):

# 解码器

x = self.decoder(z)

return x

def sample(self, mean, log_var):

# 采样

epsilon = tf.random.normal(shape=mean.shape)

std = tf.exp(0.5 * log_var)

z = mean + std * epsilon

return z

def call(self, x, c):

# 编码

mean, log_var = self.encode(x, c)

# 采样

z = self.sample(mean, log_var)

# 解码

x_hat = self.decode(z)

return x_hat

```

**逻辑分析:**

该代码块定义了一个条件VAE模型,其中编码器将输入数据和条件变量连接起来,并输出分布参数。解码器使用分布参数生成图像。采样函数用于从分布中生成潜在变量。

**参数说明:**

* `latent_dim`:潜在空间的维度。

* `condition_dim`:条件变量的维度。

* `x`:输入数据。

* `c`:条件变量。

* `mean`:分布的均值。

* `log_var`:分布的对数方差。

* `z`:潜在变量。

* `x_hat`:生成的图像。

**表格:**

| VAE变体 | 描述 |

|---|---|

| 条件VAE | 引入条件变量控制生成图像的属性 |

| 贝叶斯VAE | 使用贝叶斯推理对模型参数进行不确定性建模 |

| 循环VAE | 集成RNN处理序列数据 |

| 变分RNN | 使用变分推断对RNN的隐藏状态进行建模 |

**mermaid流程图:**

```mermaid

graph LR

subgraph VAE变体

A[条件VAE] --> B[贝叶斯VAE]

A[条件VAE] --> C[循环VAE]

C[循环VAE] --> D[变分RNN]

end

```

# 5. VAE的局限性和未来发展

### 5.1 VAE的局限性

#### 5.1.1 生成图像的质量和多样性

尽管VAE在图像生成方面取得了显著的进展,但其生成的图像质量和多样性仍然存在一些局限性。

- **图像质量:** VAE生成的图像通常具有较低的保真度和清晰度,与真实图像相比存在明显的差异。这是因为VAE在学习图像分布时,会不可避免地引入噪声和模糊。

- **图像多样性:** VAE生成的图像往往缺乏多样性,特别是在训练数据集较小或图像类别较少的情况下。这是因为VAE倾向于学习图像分布的平均值,而忽略了分布中的差异。

#### 5.1.2 模型训练的稳定性和收敛性

VAE模型的训练过程可能存在稳定性和收敛性问题。

- **不稳定性:** VAE训练涉及优化复杂的变分下界,这可能导致训练不稳定。模型参数可能会发散或陷入局部极小值,从而影响图像生成质量。

- **收敛性:** VAE训练需要大量的迭代才能收敛,这可能需要大量的时间和计算资源。训练过程中的超参数设置,如学习率和正则化项,对收敛性有很大的影响。

### 5.2 VAE的未来发展

尽管存在局限性,VAE仍然是一个活跃的研究领域,不断有新的发展和应用涌现。

#### 5.2.1 新型VAE模型的探索

研究人员正在探索新的VAE模型变体,以解决其局限性。

- **条件VAE:** 条件VAE将附加信息(如图像类别或文本描述)作为输入,以生成更具针对性和多样性的图像。

- **贝叶斯VAE:** 贝叶斯VAE采用贝叶斯推理技术,为模型参数引入不确定性,从而提高图像生成的质量和多样性。

- **循环VAE:** 循环VAE将循环神经网络(RNN)与VAE相结合,以生成序列数据,如视频或文本。

#### 5.2.2 VAE在生成式AI中的应用

VAE在生成式AI领域具有广泛的应用潜力。

- **图像合成:** VAE可用于生成逼真的图像,用于电影、游戏和艺术创作。

- **图像编辑:** VAE可用于图像降噪、超分辨率、风格迁移和图像融合等图像编辑任务。

- **自然语言处理:** VAE可用于生成文本、翻译语言和回答问题等自然语言处理任务。

- **时间序列预测:** VAE可用于预测时间序列数据,如股票价格、天气预报和医疗诊断。

# 6. VAE在图像编辑中的应用

### 6.1 图像降噪和超分辨率

VAE在图像降噪方面表现出色。给定一张噪声图像,VAE可以学习噪声分布,并生成一张去除噪声的干净图像。

```python

import tensorflow as tf

# 加载噪声图像

noisy_image = tf.keras.preprocessing.image.load_img('noisy_image.jpg')

# 创建VAE模型

vae = tf.keras.models.load_model('vae_model.h5')

# 降噪

denoised_image = vae.predict(noisy_image)

# 保存降噪图像

tf.keras.preprocessing.image.save_img('denoised_image.jpg', denoised_image)

```

VAE还可用于图像超分辨率。给定一张低分辨率图像,VAE可以生成一张高分辨率图像。

```python

# 加载低分辨率图像

low_res_image = tf.keras.preprocessing.image.load_img('low_res_image.jpg')

# 创建VAE模型

vae = tf.keras.models.load_model('vae_model.h5')

# 超分辨率

super_res_image = vae.predict(low_res_image)

# 保存超分辨率图像

tf.keras.preprocessing.image.save_img('super_res_image.jpg', super_res_image)

```

### 6.2 图像风格迁移和图像融合

VAE还可用于图像风格迁移和图像融合。图像风格迁移是指将一种图像的风格转移到另一张图像上。图像融合是指将两张图像融合成一张新图像。

```python

# 加载内容图像和风格图像

content_image = tf.keras.preprocessing.image.load_img('content_image.jpg')

style_image = tf.keras.preprocessing.image.load_img('style_image.jpg')

# 创建VAE模型

vae = tf.keras.models.load_model('vae_model.h5')

# 图像风格迁移

stylized_image = vae.predict([content_image, style_image])

# 保存风格迁移图像

tf.keras.preprocessing.image.save_img('stylized_image.jpg', stylized_image)

# 加载两张图像进行融合

image1 = tf.keras.preprocessing.image.load_img('image1.jpg')

image2 = tf.keras.preprocessing.image.load_img('image2.jpg')

# 图像融合

fused_image = vae.predict([image1, image2])

# 保存融合图像

tf.keras.preprocessing.image.save_img('fused_image.jpg', fused_image)

```

0

0