Celery任务调度策略揭秘:如何实现周期性任务与定时任务

发布时间: 2024-10-16 03:41:51 阅读量: 50 订阅数: 23

python基于celery实现异步任务周期任务定时任务

# 1. Celery任务调度概述

Celery是一个强大的异步任务队列/作业队列,基于分布式消息传递。它的设计目的是让任务的执行可以异步、延迟或周期性地执行。Celery通过使用分布式系统,可以扩展到成千上万的机器,处理大量的任务。其工作流程涉及消息代理(Broker)和后端存储(Backend),Brokers负责接收任务并将其分发给Worker,而Backend则存储任务执行的结果。

Celery适用于处理长时间运行的异步任务、周期性任务以及需要并行处理的任务。它的出现大大提高了开发效率,尤其是在微服务架构和分布式系统中,Celery提供了一种简单而有效的方式来解耦和优化任务处理流程。

本章将概述Celery的任务调度概念,包括它的核心组件、安装配置以及如何启动和管理Celery worker和beat,为后续章节的深入探讨打下基础。

# 2. Celery基本概念与安装配置

## 2.1 Celery的核心组件

### 2.1.1 Broker与Backend的概念

Celery是一个分布式任务队列系统,它通过Broker组件来传递消息,而Backend组件则用于存储任务执行的结果。Broker可以理解为消息中间件,它负责接收任务,并将任务发送给Worker进行处理。Celery支持多种Broker,比如RabbitMQ、Redis等。每个Broker都有自己的特点,例如RabbitMQ以稳定的性能著称,而Redis则因其内存存储特性,提供了更快的响应速度。

在选择Broker时,需要考虑系统的可靠性、性能需求以及部署的复杂度。例如,对于需要高可靠性的场景,可以选择RabbitMQ,它支持消息的持久化和故障转移,即使Broker崩溃,任务也不会丢失。而对于需要快速反馈的场景,Redis可能是一个更好的选择,它的低延迟特性可以提供更快的任务处理速度。

Backend用于存储任务的结果,这样即使Worker重启,任务的结果也不会丢失。Celery支持多种Backend,比如数据库、RabbitMQ、Redis等。同样,不同的Backend也有各自的优势。例如,数据库可以提供丰富的查询功能,方便用户对任务结果进行统计和分析;而使用RabbitMQ或Redis作为Backend,则可以利用它们的高速处理能力,减少对数据库的依赖。

## 2.1.2 Worker与Task的概念

Worker是Celery中的工作单元,它从Broker中获取任务,执行任务,并将结果返回给Backend。Worker是Celery的核心,它负责处理所有的任务逻辑。一个Worker可以处理一个或多个任务,每个任务都可以指定不同的优先级和执行时间。

Task是Celery中的任务单元,它定义了要执行的具体逻辑。在Celery中,任务可以是简单的函数调用,也可以是复杂的类实例化操作。任务的定义是通过Python的装饰器来实现的,用户只需要定义一个Python函数,并使用`@app.task`装饰器来将其注册为Celery任务。

Celery的任务模型非常灵活,它支持同步和异步执行任务。同步执行是指任务会在当前线程中立即执行,而异步执行则是将任务发送到Broker,由Worker异步执行。异步执行的好处是主线程可以立即得到响应,而任务的执行可以在后台进行,这对于处理耗时的任务非常有用。

## 2.2 Celery的安装过程

### 2.2.1 从源码安装

从源码安装Celery需要先从Celery的官方网站下载源码包,然后解压并进入到源码目录,执行以下步骤:

```bash

# 解压下载的源码包

tar -xvzf celery-x.y.z.tar.gz

# 进入源码目录

cd celery-x.y.z

# 安装依赖

pip install -r requirements.txt

# 安装Celery

python setup.py install

```

在安装过程中,可能会遇到依赖问题,需要根据系统环境和错误信息进行相应的解决。此外,从源码安装可以确保你使用的是最新的Celery版本,同时也能够让你更好地了解Celery的工作原理。

### 2.2.2 使用包管理器安装

使用包管理器安装Celery比较简单,只需要一条命令即可完成安装。以下是使用pip进行安装的示例:

```bash

pip install celery

```

如果你使用的是Python 3,则可能需要使用pip3来安装:

```bash

pip3 install celery

```

使用包管理器安装Celery的好处是简单快捷,且通常会自动处理依赖关系。但是,这种方式可能无法获取到最新版本的Celery,因为包管理器中的版本更新可能有一定的延迟。

## 2.3 Celery的配置与启动

### 2.3.1 配置Celery的settings

Celery的配置是在一个Python模块中完成的,通常是一个名为`celery.py`的文件。在这个文件中,你可以配置Broker、Backend、Worker的数量等信息。以下是一个基本的配置示例:

```python

from celery import Celery

# 创建Celery应用实例

app = Celery('myproject',

broker='pyamqp://guest@localhost//',

backend='rpc://')

# 设置默认任务队列

app.conf.task_queue = 'default'

# 设置Worker的数量

app.conf.worker_concurrency = 4

# 其他配置...

```

在这个配置文件中,我们首先创建了一个Celery应用实例,并指定了Broker和Backend。然后设置了默认的任务队列和Worker的数量。这些配置项都是非常重要的,它们决定了Celery的行为和性能。

### 2.3.2 启动Celery worker与beat

在配置好Celery后,我们需要启动Worker来处理任务。启动Worker的命令如下:

```bash

celery -A myproject worker --loglevel=info

```

这里,`-A`参数指定了Celery应用的模块名,`--loglevel=info`设置了日志级别为INFO。

Celery beat是Celery的定时任务调度器,它可以用来执行周期性任务。启动Celery beat的命令如下:

```bash

celery -A myproject beat --loglevel=info

```

Celery beat需要定期检查任务调度表,并将需要执行的任务发送到Broker。通过启动Celery worker和beat,我们可以开始处理任务和调度周期性任务。

# 3. Celery任务调度实践

## 3.1 创建与管理Celery任务

### 3.1.1 定义任务

Celery任务的定义是调度系统的基础。在Celery中,任务通常是一个Python函数或类方法。我们定义一个简单的Celery任务,使其在被调度时执行一个打印操作。

```python

from celery import Celery

app = Celery('tasks', broker='pyamqp://guest@localhost//')

@app.task

def print_content(message):

print(message)

```

在上述代码中,我们首先导入了`Celery`类,并创建了一个Celery应用实例。`@app.task`装饰器用于定义一个任务。这里的`print_content`函数将作为任务执行,当它被调用时,会打印传入的`message`参数。

### 3.1.2 任务的参数传递

Celery支持任务的参数传递,这在实际应用中非常有用。参数可以是任意的数据类型,包括字符串、整数、列表、字典等。

```python

@app.task

def process_data(data):

# 假设这里是一些数据处理的逻辑

processed_data = data.upper() # 例如将字符串转换为大写

print(processed_data)

# 调用任务并传递参数

result = process_data.delay('hello, celery!')

```

在上面的代码中,`process_data`函数接受一个名为`data`的参数。我们使用`delay`方法来异步执行这个任务,并传递一个字符串参数`'hello, celery!'`。`delay`方法会返回一个`AsyncResult`对象,我们可以用它来检查任务的状态或等待任务的结果。

### 3.1.3 任务的链式调用

Celery还支持任务的链式调用,即一个任务完成后可以自动触发另一个任务。这在处理复杂的工作流时非常有用。

```python

from celery import chain

@app.task

def task1(data):

print(f"Processing {data} in task1")

return data

@app.task

def task2(result):

print(f"Processing {result} in task2")

# 创建一个任务链

chain_task = chain(task1.s('some data') | task2.s())

# 启动任务链

result = chain_task()

```

在这个例子中,我们定义了两个任务`task1`和`task2`。使用`chain`函数和签名装饰器`task1.s()`以及`task2.s()`来创建一个任务链,这个链首先执行`task1`,然后将结果传递给`task2`。任务链通过`chain_task()`函数启动。

## 3.2 设计周期性任务

### 3.2.1 使用celery beat定期调度任务

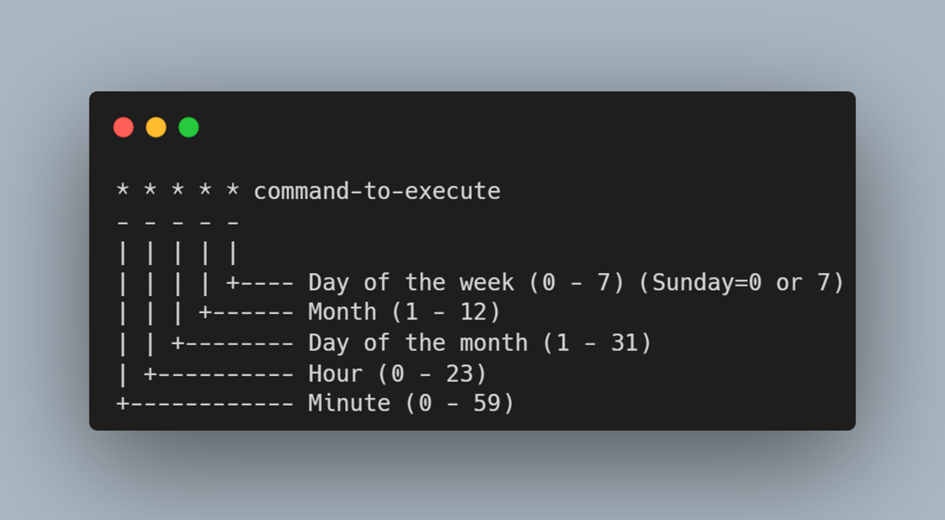

Celery beat是Celery的一个组件,它可以用来定期调度任务。要使用celery beat,你需要在Celery配置文件中指定定时任务的调度规则。

```python

from celery.schedules import crontab

app.conf.beat_schedule = {

'process-data-every-minute': {

'task': 'process_data',

'schedule': crontab(minute='*/1'), # 每分钟执行一次

'args': ('Hello, world!',)

},

}

app.control.add_periodic_task(

delay=5,

args=[],

kwargs={},

options={

'task': 'process_data',

'schedule': crontab(minute='*/5'), # 每5分钟执行一次

'args': ('Hello, periodic!',),

}

)

```

在上面的代码中,我们通过`app.conf.beat_schedule`字典定义了一个周期性任务`process_data`,它将每分钟执行一次,并打印出`'Hello, world!'`字符串。此外,我们还展示了如何使用`app.control.add_periodic_task`方法动态添加一个每5分钟执行一次的任务。

### 3.2.2 调整任务执行频率

任务的执行频率可以根据实际需求进行调整。Celery beat提供了多种调度选项,包括固定间隔、cron表达式等。

```python

from celery.schedules import crontab

import time

def adjust_schedule():

while True:

# 假设这里可以根据某些条件动态调整任务的执行频率

# 例如,根据系统的负载情况来决定

# 下面是一个简单的示例,每10秒检查一次

time.sleep(10)

app.control.add_periodic_task(

delay=5,

args=[],

kwargs={},

options={

'task': 'process_data',

```

0

0