Celery与Kubernetes集成实战:在容器化环境中运行Celery任务的7大步骤

发布时间: 2024-10-16 04:44:34 阅读量: 83 订阅数: 35

celery-kubernetes-示例:Small Flask应用程序,在Kubernetes上部署了可伸缩的异步后端工作程序

# 1. Celery与Kubernetes集成概述

在现代的IT架构中,将Celery任务队列与Kubernetes集成已成为一种常见的实践,以实现高效的任务管理和资源利用。本章节将概述Celery与Kubernetes集成的基本概念和集成的重要性。

## Celery与Kubernetes集成的基本概念

Celery是一个强大的分布式任务队列系统,广泛应用于处理后台任务和异步执行。Kubernetes则是一个开源的容器编排平台,用于自动化容器的部署、扩展和管理。将Celery与Kubernetes集成,意味着将任务队列管理与容器编排相结合,实现任务的分布式处理和弹性伸缩。

## 集成的重要性

集成Celery与Kubernetes不仅可以实现任务的高效处理,还可以提高系统的可伸缩性和可靠性。在容器化的环境中,我们可以通过Kubernetes实现Celery工作节点的动态伸缩,根据任务负载自动调整资源分配,从而优化成本和性能。

下一章将深入探讨Celery的架构与工作原理,以及Kubernetes的核心概念,为理解集成的细节打下坚实的基础。

# 2. Celery任务的理论基础

## 2.1 Celery的架构与工作原理

### 2.1.1 Celery架构组件解析

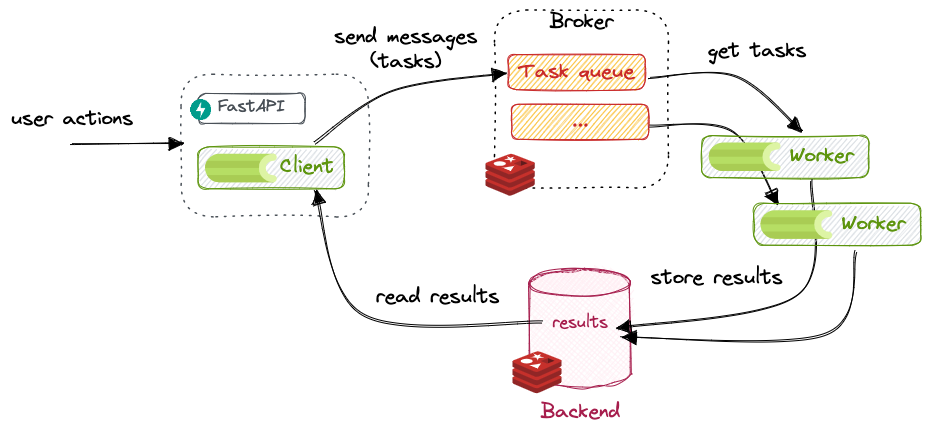

Celery是一个强大的异步任务队列/作业队列系统,基于分布式消息传递。它主要由以下几个核心组件构成:

- **Broker (消息代理)**:负责接收任务消息,并将它们存放在队列中。常见的Broker有RabbitMQ和Redis。

- **Worker (工作进程)**:从队列中取出任务并执行。可以有多个Worker来并行处理任务。

- **Task (任务)**:在代码中定义实际要执行的工作单元。这些任务被注册到Celery中,并且可以被异步执行。

- **Result Backend (结果后端)**:用于存储任务的执行结果。可以选择不同的存储方式,如数据库、缓存系统等。

- **Agent (监控进程)**:如`celery beat`,用于定时发送任务到队列。

### 2.1.2 任务队列和工作流程

任务队列的工作流程如下:

1. **任务提交**:用户或应用程序通过Celery API提交任务到Broker。

2. **任务调度**:Worker监听Broker,当有新任务到达时,Worker获取任务并开始执行。

3. **任务执行**:Worker执行任务,并将结果存储到Result Backend。

4. **结果查询**:用户可以查询任务执行的结果。

```mermaid

graph LR

A[用户或应用程序] -->|提交任务| B(任务队列 Broker)

B -->|发送任务| C[Worker]

C -->|执行任务| D(结果后端 Result Backend)

D -->|查询结果| A

```

## 2.2 Kubernetes核心概念

### 2.2.1 Kubernetes集群组件介绍

Kubernetes集群主要由以下几个核心组件构成:

- **Master节点**:集群的控制平面,包括API Server、Scheduler、Controller Manager和etcd等组件。

- **Worker节点**:执行应用负载的节点,包括Kubelet、Kube-Proxy和容器运行时(如Docker)。

- **Pod**:Kubernetes中的基本部署单元,通常包含一个或多个容器。

- **Service**:定义一组Pod的访问规则,可以认为是微服务的抽象。

- **Deployment**:用于声明应用的期望状态,管理Pod和ReplicaSet。

### 2.2.2 Pod、Service和Deployment的概念及作用

- **Pod**:是最小的部署单元,一个Pod可以包含一个或多个容器。Pod提供了容器的运行环境,以及存储、网络和一些管理容器的API对象。

- **Service**:定义一组Pod的访问规则,通常通过标签选择器来选择一组Pod,并对外提供一个固定的IP地址和端口。

- **Deployment**:声明期望的Pod状态,并能够通过滚动更新来升级应用。

```mermaid

graph LR

A[Pod] -->|属于| B(Service)

B -->|由管理| C[Deployment]

```

## 2.3 Celery与Kubernetes集成的必要性

### 2.3.1 分布式任务处理的优势

分布式任务处理的优势包括:

- **可扩展性**:可以轻松增加更多的Worker来处理更多任务。

- **弹性**:系统可以根据负载自动调整Worker数量。

- **解耦**:任务生产者和消费者之间不需要直接通信。

### 2.3.2 容器化环境带来的挑战与机遇

容器化环境如Kubernetes提供了更高的资源利用率和灵活性,但也带来了以下挑战:

- **资源调度**:如何在Kubernetes集群中高效调度Celery Worker?

- **服务发现**:Kubernetes提供了内置的服务发现机制,如何与Celery集成?

- **持久化存储**:Celery任务结果存储在Kubernetes集群内需要考虑数据持久化。

在本章节中,我们深入探讨了Celery的架构和工作原理,以及Kubernetes的核心概念。通过理解这些基础概念,我们为后续章节中将Celery集成到Kubernetes集群中打下了坚实的理论基础。接下来,我们将进行Kubernetes集群的搭建准备,包括环境要求、安装Docker和kubeadm工具等内容。

# 3. 搭建Kubernetes集群环境

在本章节中,我们将深入探讨如何搭建一个Kubernetes集群环境,这是Celery与Kubernetes集成的基础。我们将从环境准备开始,逐步介绍集群的搭建、部署、配置、监控与维护。

## 3.1 Kubernetes集群搭建准备

### 3.1.1 环境要求与规划

在搭建Kubernetes集群之前,首先要对环境进行充分的规划。这包括确定集群的规模、选择合适的硬件配置、规划网络结构等。为了确保集群的稳定性和性能,建议使用至少三台物理或虚拟机作为集群的节点。每台节点应满足以下基本要求:

- 至少2核CPU

- 至少2GB RAM

- 至少10GB磁盘空间

- 支持虚拟化技术(如Intel VT-x)

- 支持网络通信和数据持久化

### 3.1.2 安装Docker和kubeadm工具

接下来,我们需要在所有节点上安装Docker和kubeadm工具。Docker是Kubernetes的容器运行时环境,而kubeadm是一个用于快速安装和配置Kubernetes集群的命令行工具。

```bash

# 安装Docker

sudo apt-get update

sudo apt-get install -y docker.io

# 安装kubeadm、kubelet和kubectl

sudo apt-get update

sudo apt-get install -y apt-transport-https curl

curl -s ***

*** "deb ***" | sudo tee -a /etc/apt/sources.list.d/kubernetes.list

sudo apt-get update

sudo apt-get install -y kubelet kubeadm kubectl

```

在安装完成后,我们需要初始化主节点,并在工作节点上加入集群。以下是使用kubeadm初始化集群的示例命令:

```bash

# 在主节点初始化集群

sudo kubeadm init --pod-network-cidr=**.***.*.*/16

# 在每个工作节点上加入集群

sudo kubeadm join <master-ip>:<master-port> --token <token> --discovery-token-ca-cert-hash sha256:<hash>

```

## 3.2 集群部署与配置

### 3.2.1 使用kubeadm初始化集群

在所有节点安装完毕后,我们将在主节点上运行`kubeadm init`命令来初始化集群。这个命令会生成一个token,用于在工作节点加入集群时的身份验证。

```bash

sudo kubeadm init --pod-network-cidr=**.***.*.*/16

```

执行完毕后,会提供一些指令,用于设置kubectl配置文件和赋予当前用户管理员权限。

### 3.2.2 配置网络插件和集群安全

为了使集群中的Pods能够相互通信,我们需要配置网络插件。常用的网络插件有Flannel、Calico等。以下是一个配置Flannel网络插件的示例:

```bash

kubectl apply -f ***

```

此外,我们还需要配置集群的安全策略,包括Pod的安全策略、网络策略等,以确保集群的安全性。

## 3.3 集群监控与维护

### 3.3.1 集群状态监控工具介绍

为了监控集群的状态,我们可以使用多种工具,如Kubernetes Dashboard、Prometheus、Grafana等。Kubernetes Dashboard提供了图形化的界面,可以直观地查看集群的状态。

```bash

# 安装Kubernetes Dashboard

kubectl apply -f ***

```

### 3.3.2 常见问题排查与解决

在集群运行过程中,可能会遇到各种问题。我们需要掌握一些基本的故障排查工具和方法,如kubectl describe、logs等,以便快速定位和解决问题。

```bash

# 查看节点状态

kubectl get nodes

# 查看Pod事件

kubectl describe pod <pod-name>

# 查看Pod日志

kubectl logs <pod-name>

```

通过本章节的介绍,我们已经了解了如何搭建和维护一个Kubernetes集群环境。这是Celery与Kubernetes集成的基础,为后续章节的内容打下了坚实的基础。在下一章节中,我们将讨论如何创建Celery应用程序,并将其部署到Kubernetes集群中。

# 4. 部署Celery任务到Kubernetes

## 4.1 创建Celery应用程序

### 4.1.1 Celery应用程序的基本结构

在部署Celery任务到Kubernetes之前,我们需要创建一个基本的Celery应用程序。Celery应用程序的结构通常包括以下几个核心部分:

- **Celery实例**: Celery应用程序的核心,负责管理任务队列和工作流程。

- **任务定义**: 任务是Celery可以执行的操作,通常定义在单独的模块或文件中。

- **工作节点**: 这些是运行Celery worker的进程,它们从队列中取出任务并执行。

- **配置**: 包括队列的配置、消息代理的连接信息、任务的执行细节等。

### 4.1.2 编写Celery任务代码

Celery任务通常定义在Python模块中,以下是一个简单的Celery任务定义示例:

```python

# tasks.py

from celery import Celery

app = Celery('my_project.tasks',

broker='pyamqp://guest@localhost//',

backend='rpc://')

@app.task

def add(x, y):

return x + y

```

在本章节中,我们将深入探讨如何创建一个Celery应用程序,包括定义任务和配置Celery实例。我们将看到如何编写任务代码,并了解任务如何被Celery实例管理和执行。

0

0