Celery监控与日志分析:实时跟踪任务执行情况的5个关键点

发布时间: 2024-10-16 04:09:13 阅读量: 33 订阅数: 42

# 1. Celery简介与安装

Celery是一个强大的异步任务队列/作业队列,基于分布式消息传递。它主要用于在处理大量任务时,能够解耦系统组件,提供灵活且可靠的工作流。Celery主要由Python编写,也可以用于Ruby、PHP等其他语言。它广泛应用于处理后台任务、定时任务、异步处理等场景。

## Celery简介

Celery拥有高度可扩展的架构,支持多种消息代理(Broker),例如RabbitMQ、Redis等。它支持多种结果后端存储,如数据库、Redis、甚至REST API。Celery可以轻松集成到任何Python项目中,无论是小型项目还是大型分布式系统。

## 安装Celery

安装Celery相对简单,通过Python包管理工具pip即可完成安装:

```bash

pip install celery

```

安装完成后,需要配置Celery与消息代理之间的连接。以RabbitMQ为例,可以在Celery配置文件中指定broker的URL:

```python

broker_url = 'amqp://user:password@localhost:5672//'

```

这里使用的是RabbitMQ的默认端口5672,用户密码为"guest"。

以上步骤即可完成Celery的初步安装与配置,接下来可以开始定义任务,并启动Celery Worker来执行这些任务。

# 2. Celery任务监控

在本章节中,我们将深入探讨Celery任务监控的各个方面,从任务状态的基础知识到实时任务追踪技术,再到任务调度与优化的策略。通过本章节的介绍,读者将能够掌握如何有效地监控和优化Celery任务,以提高系统的稳定性和效率。

## 2.1 任务状态与监控基础

### 2.1.1 Celery任务的状态分类

Celery任务的状态是指任务在执行过程中的不同阶段。了解这些状态对于监控任务执行过程和诊断可能出现的问题至关重要。Celery任务的状态主要包括以下几种:

- `PENDING`:任务已经被调度,但还没有开始执行。

- `STARTED`:任务已经开始执行。

- `RECEIVED`:任务已经被工作节点接收,但还没有开始执行。

- `SUCCESS`:任务执行成功并返回了结果。

- `FAILURE`:任务执行失败并记录了错误信息。

- `RETRY`:任务执行失败,但因为设置了重试机制,正在准备重试。

- `IGNORED`:任务被忽略,通常是由于设置了`acks_late`或`reject_on_worker_loss`选项。

这些状态为任务监控提供了基础。例如,如果你发现很多任务长时间处于`RECEIVED`状态,可能意味着工作节点负载过高或存在其他瓶颈。

### 2.1.2 监控工具的选择与集成

为了有效地监控Celery任务,我们需要选择合适的工具,并将其集成到我们的监控系统中。一些常用的Celery监控工具包括:

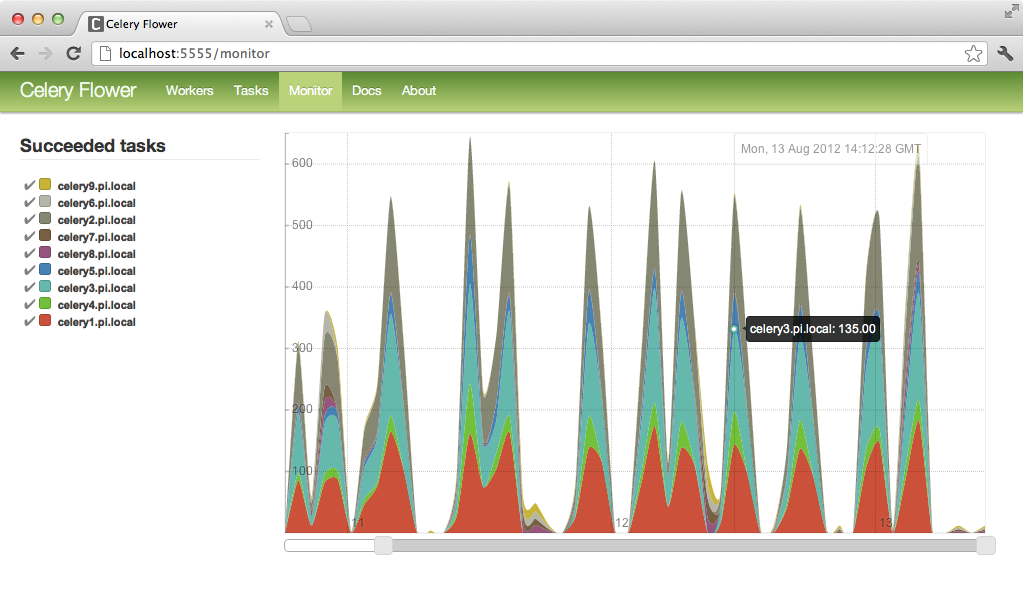

- Celeryflower:一个基于Flask的Web应用,提供了任务追踪和实时监控的功能。

- Flower:支持Celery任务的监控,提供图形界面展示任务状态。

- Grafana:可以与Prometheus结合使用,通过Grafana dashboards进行Celery任务监控。

集成这些工具通常涉及配置Celery应用以发送监控信息到相应的服务。例如,使用Grafana进行监控时,你需要配置Prometheus来采集Celery的任务统计信息,并在Grafana中创建仪表板来展示这些数据。

## 2.2 实时任务追踪技术

### 2.2.1 实时任务追踪的原理与方法

实时任务追踪是指在任务执行过程中,实时获取任务的状态和进度信息,并将其展示给用户或系统管理员。其基本原理是通过监听任务状态的变化事件,并将这些事件实时推送到前端展示界面。

实现实时任务追踪的方法有多种,最常见的是使用WebSocket或轮询技术。WebSocket提供了全双工通信渠道,能够实时推送更新到客户端,而不需要客户端不断地向服务器请求。轮询则是客户端定期向服务器请求最新信息的方法。

### 2.2.2 实践案例:搭建实时任务追踪系统

下面是一个简单的实践案例,展示如何使用Flower来搭建一个实时任务追踪系统。

首先,你需要安装Flower:

```bash

pip install flower

```

然后,启动Flower服务:

```bash

celery flower --broker=amqp://guest:guest@localhost:5672//

```

最后,在浏览器中打开`***`即可看到Flower的Web界面,它提供了任务列表、实时监控和任务统计等功能。

Flower的源代码也是很好的学习资源,你可以查看其如何使用Celery提供的API来获取任务信息,并将其展示在前端。

## 2.3 任务调度与优化

### 2.3.1 Celery的任务调度机制

Celery的任务调度是指如何安排任务在特定的时间或周期性地执行。Celery提供了两种主要的任务调度方式:周期性任务和预定任务。

周期性任务(Periodic Tasks)是通过`celery beat`调度进程来实现的,它可以调度任务按照设定的时间间隔重复执行。例如:

```python

from celery import Celery

app = Celery('tasks', broker='pyamqp://guest@localhost//')

@app.on_after_configure.connect

def setup_periodic_tasks(sender, **kwargs):

# 每天执行一次任务

sender.add_periodic_task(10.0, some_task.s(), name='add-every-10-seconds')

@app.task

def some_task(x):

print(x)

```

预定任务(Scheduled Tasks)则是通过设置任务的`countdown`或`eta`参数来指定任务执行的具体时间。

### 2.3.2 任务优化策略与最佳实践

任务优化是指通过调整任务执行的方式或参数来提高效率和性能。以下是一些常见的任务优化策略:

- **任务分割**:将大任务分割成多个小任务并行处理,可以显著提高任务的执行效率。

- **结果后处理**:在任务执行完毕后,进行必要的后处理操作,而不是在任务执行过程中进行复杂计算。

- **资源限制**:通过设置资源限制,避免任务占用过多系统资源。

- **优先级队列**:为任务设置不同的优先级,确保紧急任务能够快速执行。

最佳实践包括:

- 使用异步任务处理I/O密集型操作,以便不阻塞主程序的执行。

- 合理配置工作节点的数量,避免资源浪费或过载。

- 定期清理任务结果,避免存储空间的无谓消耗。

在本章节中,我们介绍了Celery任务监控的基础知识,实时任务追踪技术和任务调度与优化的策略。通过这些知识,读者可以更好地管理和优化Celery任务,确保任务执行的高效和稳定。接下来,我们将深入探讨Celery日志管理,帮助读者更好地理解和分析任务执行过程中的日志信息。

# 3. Celery日志管理

Celery作为一个强大的异步任务队列/作业队列,其日志管理是系统稳定运行的关键。日志不仅帮助我们了解任务执行的细节,还能在出现问题时快速定位故障。本章节将深入探讨Celery的日志级别与配置、日志分析的基础知识以及日志分析工具与实践案例。

## 3.1 日志级别与配置

### 3.1.1 Celery的日志级别概述

Celery的日志级别继承自Python的`logging`模块,主要包括DEBUG、INFO、WARNING、ERROR和CRITICAL五个级别。不同的日志级别对应不同的日志详细程度和严重性,通常情况下,我们可以通过配置日志级别来控制日志的输出量。

- **DEBUG**:详细信息,通常仅在调试时使用。

- **INFO**:确认一切按预期进行。

- **WARNING**:表明出现了某个非关键问题,但任务可以继续执行。

- **ERROR**:出现了错误,任务可能无法完成。

- **CRITICAL**:严重错误,系统可能已经无法继续运行。

在Celery中,可以通过以下方式设置日志级别:

```python

impo

```

0

0