Celery中间件扩展与自定义:打造个性化任务处理流程

发布时间: 2024-10-04 10:33:16 阅读量: 32 订阅数: 40

# 1. Celery中间件基础

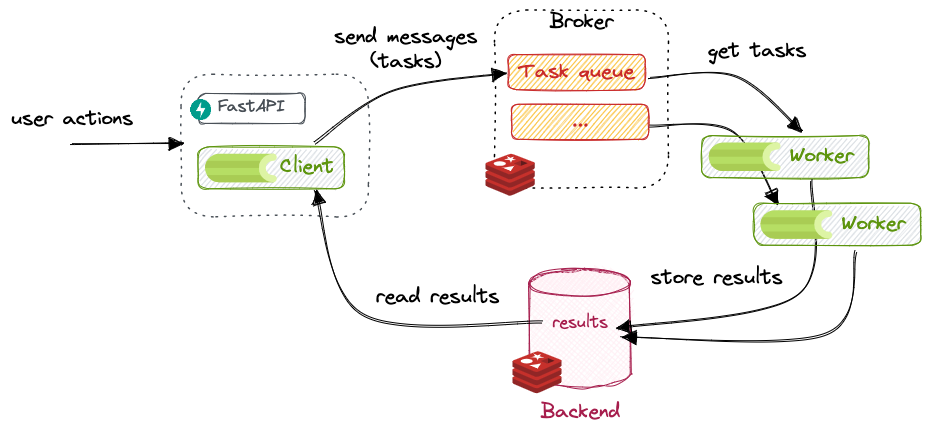

## 1.1 Celery简介

Celery是一个强大的异步任务队列中间件,广泛应用于Python开发的生产环境中。它的主要功能是将耗时的任务如文件处理、邮件发送等异步化,从而提高Web应用的响应速度和处理能力。Celery通过消息代理来协调分布式工作流,并支持多种消息传输协议如RabbitMQ和Redis。

## 1.2 安装与配置

安装Celery非常简单,可以通过pip包管理器安装其核心包:

```bash

pip install celery

```

安装后,需要一个消息代理服务器。这里以RabbitMQ为例,安装并启动RabbitMQ服务。之后,在项目中配置Celery,指定消息代理的URL,以及应用的名字:

```python

from celery import Celery

app = Celery('my celery app', broker='pyamqp://guest@localhost//')

@app.task

def add(x, y):

return x + y

```

## 1.3 基本概念

在继续深入了解Celery之前,先了解一些基本概念非常重要。例如:

- **任务**:一个可以异步执行的函数。

- **工作单元(Worker)**:执行任务的进程。

- **消息代理(Broker)**:任务在工作单元之间传递的中间件。

- **结果后端(Result Backend)**:存储任务执行结果的地方。

以上是Celery中间件的基础内容。在下一章节中,我们将深入探讨Celery的任务处理机制,包括任务队列模型和工作流与路由的高级特性。

# 2. 深入理解Celery任务处理机制

## 2.1 Celery任务队列模型

### 2.1.1 基本概念与组件

在了解Celery任务处理机制之前,我们先要对它的基本概念与组件有清晰的认识。Celery是一个异步任务队列/作业队列,基于分布式消息传递。它专注于实时操作,同时也支持任务调度。

- **Broker(消息代理)**:负责接收和传递消息,例如RabbitMQ或Redis。

- **Worker(工作进程)**:监听任务队列并执行任务的进程。

- **Task(任务)**:需要异步执行的函数。

- **Queue(队列)**:任务等待执行的队列。

- **Result Backend(结果后端)**:存储任务执行结果的存储系统。

### 2.1.2 任务队列的工作流程

任务队列的工作流程可以分为以下几个步骤:

1. **任务提交**:使用Celery API提交任务到消息代理的特定队列。

2. **任务调度**:消息代理将任务传递给一个或者多个等待的任务工作进程。

3. **任务执行**:工作者获取任务并执行,执行结果可以存储到结果后端供以后查询。

4. **结果检索**:如果任务设置了结果存储,客户端可以检索任务执行的结果。

下面是一个任务提交和执行的简单示例代码:

```python

from celery import Celery

app = Celery('tasks', broker='pyamqp://guest@localhost//')

@app.task

def add(x, y):

return x + y

# 调用任务

result = add.delay(4, 4)

print(result.get(timeout=1)) # 输出结果

```

在这段代码中,我们首先创建了一个Celery应用实例,并指定消息代理为本地的RabbitMQ。然后定义了一个简单的任务`add`,它接受两个参数并返回它们的和。通过`delay`方法提交了一个异步任务,并通过`get`方法检索了结果。

## 2.2 Celery工作流与路由

### 2.2.1 工作流的定义和实现

工作流是任务执行的流程控制方式,它定义了任务执行的先后顺序和依赖关系。在Celery中,可以通过链式调用(`chain`)或组(`group`)来实现工作流。

- **链式调用(Chain)**:定义一个任务队列,其中的每个任务都在前一个任务完成后才开始执行。

- **组(Group)**:同时启动多个任务,但它们彼此之间没有依赖关系。

```python

from celery import chain

@app.task

def task1(x):

return x + 1

@app.task

def task2(x):

return x * 2

@app.task

def task3(x):

return x - 3

# 定义链式工作流

chain_task = chain(task1.s(1), task2.s(), task3.s())()

print(chain_task.get()) # 执行整个链并获取最终结果

```

### 2.2.2 高级路由策略

Celery允许通过路由来指定任务由哪个队列执行,这对于资源管理和优先级控制非常有用。

- **直接指定队列**:在定义任务时指定队列名。

- **使用装饰器**:在任务函数上添加装饰器来指定路由。

- **通过配置文件**:在Celery配置中设置任务的默认队列。

```python

@app.task(queue='high_priority')

def process_high_priority_task():

# 优先处理高优先级任务

pass

```

### 2.2.3 配置与应用实例

对于配置和应用实例,我们要明白如何在实际项目中应用这些策略。通常会涉及到项目启动时的初始化配置以及根据运行环境(开发、测试、生产)不同设置不同的参数。

```python

# settings.py

CELERY_QUEUES = {

'default': {

'binding_key': 'default',

},

'high_priority': {

'binding_key': 'high_priority',

},

}

CELERY_DEFAULT_QUEUE = 'default'

CELERY_DEFAULT_EXCHANGE = 'default'

CELERY_DEFAULT_ROUTING_KEY = 'default'

```

在代码中引用配置文件:

```python

from celery import Celery

app = Celery('tasks')

app.config_from_object('settings', namespace='CELERY')

@app.task

def process_task():

# 任务逻辑

pass

```

以上展示了如何通过配置文件来设置队列,并在任务定义时指定路由,从而实现任务的高级路由策略。

## 2.3 Celery工作流与路由

### 2.3.1 工作流定义

工作流定义是关于如何规划、安排以及执行任务的过程。在Celery中,定义工作流主要通过任务的依赖关系和执行顺序来实现。这有助于实现复杂任务的逻辑控制。在实际业务中,我们可能需要一个任务依赖于另一个任务的成功执行,工作流提供了一种机制来处理这种依赖关系。

### 2.3.2 实现工作流的高级应用

在实际的项目中,工作流的高级应用可以极大地提升业务流程的效率和灵活性。例如,可以将任务分解为多个子任务,并通过工作流来定义它们之间的执行逻辑。这样可以并行处理任务,也可以在某些任务失败时进行回滚或补偿机制。

### 2.3.3 工作流与业务逻辑的结合

将工作流与业务逻辑相结合是提升系统整体性能的关键。在业务逻辑中合理地划分任务,并通过工作流来控制它们,可以实现更细粒度的任务管理,并允许更复杂的业务逻辑在分布式系统中得以实现。

通过本章节的介绍,我们深入了解了Celery任务处理机制的核心组件,包括任务队列模型和工作流与路由策略,并通过实例展示了如何在项目中进行应用和配置。这些知识对于理解和优化Celery任务执行有着极其重要的作用。

# 3. ```

# 第三章:Celery中间件扩展实践

本章节将会深入探讨如何扩展Celery内置中间件以及常见的中间件扩展场景,使得读者能够根据自己的业务需求定制化Celery的功能。

## 3.1 扩展Celery内置中间件

### 3.1.1 中间件的架构和工作原理

Celery中间件是一种特殊类型的任务处理器,它可以在任务执行前后插入自定义的处理逻辑,如日志记录、监控、异常捕获等。中间件通常包含一系列钩子函数,这些函数在任务执行的各个阶段被调用。

为了理解中间件的工作原理,可以将其类比为一种拦截器模式,在这种模式下,中间件可以拦截Celery任务执行的生命周期中的事件,并执行自定义的逻辑。中间件的执行顺序遵循预定义的链表结构,新添加的中间件会被添加到链表的末尾,并依次向前执行。

下面是一个简单的中间件架构示例:

```python

class MyMiddleware:

def __init__(self, app):

self.app = app

def __call__(self, task):

def on_failure(exception, task_id, args, kwargs, einfo):

# 在这里记录错误信息到日志

pass

def on_success(result, task_id, args, kwargs):

# 在这里记录任务成功的信息到日志

pass

# 添加钩子函数,以便在任务成功或失败时执行自定义逻辑

task.on_failur

0

0