Celery与Django整合:构建高效Web应用的秘诀

发布时间: 2024-10-04 10:37:13 阅读量: 18 订阅数: 36

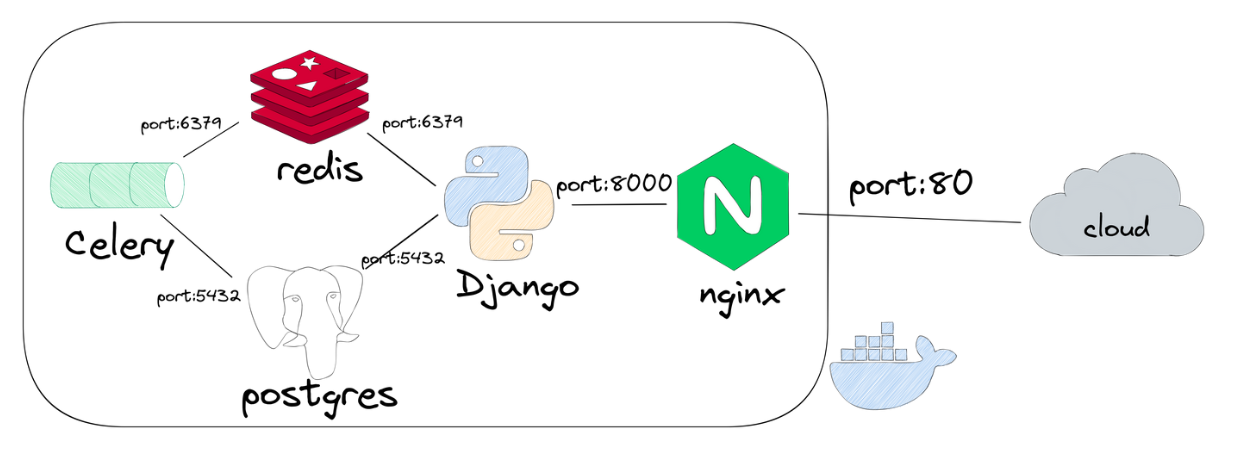

# 1. Celery与Django整合概述

在构建现代化的Web应用时,保证后台任务处理的效率与可靠性至关重要。Celery作为一款强大的分布式任务队列系统,它与Django的整合提供了一个优秀的解决方案,以应对高并发和大数据处理场景。本章将概述Celery与Django整合的基础知识,以及如何通过这种方式提高应用性能和可维护性。

Celery与Django整合后,可以将耗时的任务,如邮件发送、数据处理、图像渲染等,异步地执行,从而释放Web服务器资源,改善用户体验。这一章节将介绍为什么选择Celery作为任务队列工具,以及它如何与Django框架协同工作。

我们将详细讲解Celery与Django整合的基本步骤,从安装和配置Celery环境开始,逐步引导读者深入理解如何创建自定义的Celery任务,并将其集成到Django项目中去。最终,这将为读者构建一个高效的任务处理系统打下坚实的基础。

# 2. Celery任务队列基础

## 2.1 Celery的基本概念

### 2.1.1 什么是Celery

Celery是一个强大的异步任务队列系统,它被广泛用于生产环境中处理时间消耗长、延迟执行或者后台任务。其主要目的是允许开发者将耗时的操作与Web应用解耦,从而提升应用的响应时间,提高用户体验。Celery使用Python编写,易于使用且灵活,可以在不同的环境下运行,包括单台机器、大型服务器集群,甚至跨多个数据中心。

Celery依赖于消息代理(Broker)来接收和发送消息,并将任务异步地分发给一个或多个工作节点(Worker),这些工作节点负责执行实际的任务。此外,Celery的任务结果可以存储在不同的结果后端(Result Backend)中,以便后续查询任务执行状态。

### 2.1.2 Celery的架构和组件

为了理解Celery的工作机制,我们需要熟悉其核心组件和它们之间的交互:

- **Broker(消息代理)**:负责在任务生产者(Producer)和任务消费者(Consumer)之间传递消息。它通常是一个消息队列服务,如RabbitMQ或Redis。

- **Worker(工作节点)**:从Broker接收任务并执行。每一个Worker实例就是一个Python进程,它们独立运行并监听消息队列中的任务。

- **Task(任务)**:实际要执行的工作单元,通常是一个Python函数。任务被定义在一个或多个任务模块中,并由Celery加载和执行。

- **Result Backend(结果后端)**:用于存储任务执行的结果,这样可以在任务执行完成后查询结果。结果后端可以是数据库、缓存系统,或者简单的键值存储。

- **Beat(定时器)**:它是一个计划器,可以调度定时任务,与Worker配合,可以周期性地执行任务。

以上组件的集合构成了Celery的基础架构,使得任务能够被高效地分发和执行。

## 2.2 Django中的Celery集成

### 2.2.1 安装和配置Celery与Django

要在Django项目中集成Celery,首先需要安装Celery库以及一个消息代理服务。以下是一些基本步骤来设置Celery:

1. **安装Celery**:

```bash

pip install celery

```

2. **安装消息代理(以RabbitMQ为例)**:

```bash

# 安装RabbitMQ服务器

```

3. **配置Celery**:

创建一个`celery.py`文件在Django项目的根目录下,配置Celery和Django之间的集成:

```python

from __future__ import absolute_import

import os

from celery import Celery

# 设置基础目录,找到Django设置模块

BASE_DIR = os.path.dirname(os.path.dirname(os.path.abspath(__file__)))

os.environ.setdefault('DJANGO_SETTINGS_MODULE', 'your_project.settings')

app = Celery('your_project')

app.config_from_object('django.conf:settings', namespace='CELERY')

# 自动加载任务模块

app.autodiscover_tasks()

```

4. **将Celery与Django同步**:

在Django的`settings.py`文件中,添加以下配置:

```python

# settings.py

# 添加Celery配置到INSTALLED_APPS中

INSTALLED_APPS = (

...

'your_project.celery',

)

# 设置Celery的Broker URL

CELERY_BROKER_URL = 'amqp://guest:guest@localhost:5672/'

# 设置结果后端

CELERY_RESULT_BACKEND = 'redis://localhost:6379/0'

```

完成以上步骤后,Django项目就已经集成了Celery。接下来,可以通过Celery执行异步任务了。

### 2.2.2 创建和运行Celery任务

创建Celery任务是通过定义一个普通Python函数来完成的,并且使用装饰器`@app.task`来标记为一个任务。这里是一个简单的任务创建和运行的例子:

1. **定义一个任务**:

```python

# 在一个新文件中,例如 tasks.py

from celery import shared_task

from .celery import app

@shared_task

def add(x, y):

return x + y

@shared_task

def mul(x, y):

return x * y

```

2. **从Django视图中调用任务**:

```python

# views.py

from django.http import HttpResponse

from .tasks import add, mul

def task_view(request):

# 启动异步任务

result_add = add.delay(2, 3)

result_mul = mul.delay(2, 3)

# 返回任务的ID

return HttpResponse(f"Add Result: {result_add.id} | Mul Result: {result_mul.id}")

```

在上面的视图函数`task_view`中,我们启动了两个异步任务,并返回了任务的结果ID。这些任务会被Celery的Worker节点异步执行,用户不需要等待任务完成即可获得响应。

## 2.3 Celery的中间件选择

### 2.3.1 了解不同消息代理(Broker)的选择

在Celery中,消息代理扮演着非常重要的角色。它负责传递任务消息给Worker节点,并在任务执行期间存储这些消息。因此,选择合适的Broker对于Celery系统的稳定性和性能至关重要。常见的Broker有RabbitMQ和Redis,每种都有其特定的优点:

- **RabbitMQ**:基于高级消息队列协议(AMQP),是一个成熟的解决方案,适用于大规模的分布式系统。它提供可靠性、保证消息传递的安全性,并且有着较好的伸缩性和高可用性。

- **Redis**:作为一个内存中的数据结构存储系统,用于实现消息队列,它的读写操作非常快。但是,Redis不是为消息队列设计的,因此在复杂的消息传递场景中可能不如RabbitMQ可靠。另外,Redis会将数据存储在内存中,如果系统崩溃,未持久化的数据将会丢失。

根据应用程序的具体需求,比如消息处理速度、系统复杂性、可靠性和成本等因素,开发者需要决定使用哪一个Broker。

### 2.3.2 配置和优化中间件性能

为了优化Celery系统的性能,开发者需要对Broker和Worker进行适当配置。以下是一些基本的配置优化步骤:

- **调整消息队列大小**:调整Broker的消息队列缓冲区大小可以提高消息吞吐量。例如,在RabbitMQ中,可以增加队列的最大长度或使用内存限制。

- **调整并发工作者数量**:根据系统的处理能力,增加或减少Worker的数量。对于CPU密集型任务,可以减少并发Worker的数量以避免资源竞争;对于I/O密集型任务,可以增加并发Worker数量以充分利用I/O等待时间。

- **优化任务执行策略**:可以设置任务执行的最大超时时间,以避免任务卡在某个地方导致资源浪费。此外,合理配置任务优先级,确保关键任务能及时执行。

- **使用持久化队列**:在Redis中,可以选择使用持久化队列以防止数据丢失。RabbitMQ的持久化机制允许消息在服务器重启后依然可用。

通过这些配置和优化步骤,可以大大提升Celery任务队列的性能,从而支撑起更高效、更可靠的后台任务处理系统。

在下一章节中,我们将进一步深入讨论Celery与Django的结合实践,包括后台任务的异步处理、任务结果的持久化存储以及任务失败的处理和重试机制。

# 3. Celery与Django的深入实践

深入到Celery与Django的整合实践,需要理解如何利用Celery实现异步任务处理,如何进行任务结果的持久化,以及如何处理可能出现的错误并执行重试机制。这三方面是进一步提升Web应用性能和用户体验的关键。

## 3.1 异步任务处理与时间调度

### 3.1.1 实现后台任务的异步处理

在Django中使用Celery进行异步任务处理,可以使应用的响应速度更快,用户体验更佳。异步任务通常用于不需要即时返回结果的操作,例如发送邮件、处理图片等。

要创建一个异步任务,首先需要定义一个Celery任务函数。使用`@celery.task`装饰器,可以让一个函数变成可被Celery调度的异步任务。

```python

from celery import Celery

app = Celery('my_project')

@app.task

def send_email_task(to_email, subject, message):

# 在这里执行发送邮件的操作

pass

```

在Django视图中,当你需要发送邮件时,不再直接调用发送邮件的函数,而是调用`send_email_task.delay(to_email, subject, message)`。这里的`delay`方法会将任务发送到消息队列中,由Celery工作进程异步处理。

异步任务的好处在于主进程不需要等待任务的完成,可以直接返回响应给

0

0