Celery与Kubernetes集成:容器化任务队列的实践之路

发布时间: 2024-10-04 10:54:58 阅读量: 34 订阅数: 22

# 1. Celery与Kubernetes集成概述

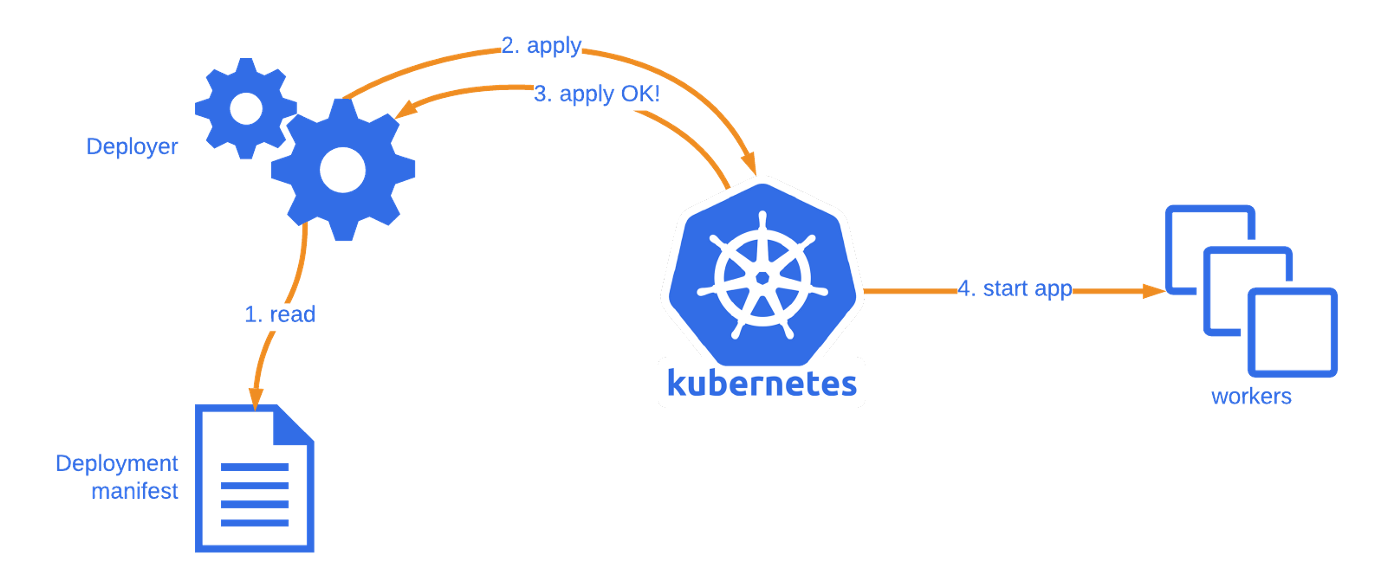

在当今高度动态的IT环境中,应用需要具备迅速扩展和回收资源的能力,以应对业务负载的波动。使用任务队列来处理后台任务是常见的做法,而Celery作为一个异步任务队列/作业队列,以其简单、可靠和灵活的特点,在IT领域广受欢迎。然而,传统的部署方式在资源管理和扩展性方面有所局限。容器化技术的兴起,尤其是Kubernetes的广泛应用,为Celery带来了新的集成可能性。

Kubernetes作为一个开源的容器编排平台,它管理容器化应用的部署、扩展和操作。通过将Celery集成进Kubernetes,我们能够利用Kubernetes强大的调度和自愈功能,提高任务处理的可靠性和效率。这章我们将探讨Celery与Kubernetes集成的基础概念,为接下来的详细集成实践和高级应用打下基础。

# 2. 容器化任务队列的理论基础

## 2.1 Celery分布式任务队列简介

Celery是一个流行的、分布式的任务队列系统,它的设计目标是支持异步任务处理,从而提高应用的响应性和吞吐量。本小节将深入探讨Celery的工作原理以及在它内部如何使用消息代理和后端存储。

### 2.1.1 Celery的工作原理

Celery的工作流程基于生产者-消费者模型,其中生产者发出任务,消费者执行这些任务。在Celery中,生产者被称为客户端(Client),它使用Celery的API来发送任务到消息代理(Broker)。消费者则是在后台运行的Celery Worker,它们从代理中获取任务并执行。

当客户端提交一个任务时,Celery会将任务序列化并发送给消息代理。消息代理维护一个任务队列,Worker轮询代理,获取任务,并将结果存回代理或直接返回给客户端,如果配置了结果后端(Result Backend)的话。

#### 工作流程图示

以下是Celery工作流程的简化图示:

```mermaid

graph LR

A[客户端] -->|发送任务| B(消息代理)

B -->|轮询获取任务| C[Worker]

C -->|执行任务| D[任务执行结果]

D -->|存储结果| E(结果后端)

```

### 2.1.2 Celery中的消息代理和后端

Celery支持多种消息代理,比如RabbitMQ、Redis、Amazon SQS等。消息代理是任务队列系统的核心组件,它负责接收、保存和转发任务。选择合适的代理可以决定任务队列的性能和可靠性。

此外,Celery还支持不同的后端存储来保存任务执行的结果。这可以是数据库(如MySQL、PostgreSQL)或者是简单存储系统(如Redis、Memcached)。

下表列出了一些常见的代理和后端配置组合,并描述了它们的特性:

| 代理类型 | 后端类型 | 特性 |

| :-------: | :------: | :----: |

| RabbitMQ | Redis | 快速、轻量级,适用于小型到中型应用 |

| Redis | PostgreSQL | 简单、易于配置,适用于需要持久化结果的应用 |

| Amazon SQS | MySQL | 扩展性好,适用于云环境和大型分布式应用 |

使用消息代理和后端可以实现任务的持久化、故障转移和负载均衡等功能。这样即使在系统崩溃的情况下,任务也不会丢失,并且可以自动地在其他节点上重试。

## 2.2 Kubernetes容器编排概述

Kubernetes已经成为容器编排的事实标准,提供了自动化部署、扩展和管理容器化应用的强大能力。本小节将介绍Kubernetes的基本架构和组件,以及如何通过基本操作使用它。

### 2.2.1 Kubernetes架构和组件

Kubernetes架构主要由Master节点和Worker节点组成。Master节点负责集群的管理,而Worker节点则运行实际的容器应用。

#### 核心组件

- **API Server**: 负责处理集群的各种操作请求。

- **Scheduler**: 根据资源需求和约束,调度Pod到合适的Worker节点。

- **Controller Manager**: 运行集群的后台进程,如副本控制器等。

- **etcd**: 一个轻量级、分布式的键值存储系统,用于存储集群状态信息。

#### 节点组件

- **Kubelet**: 确保容器运行在Pod中。

- **Kube-Proxy**: 维护节点网络规则,实现服务抽象。

- **Container Runtime**: 如Docker或rkt,负责运行容器。

#### 对象模型

Kubernetes对象如Pod、Service、Deployment等都是集群状态的一部分,API Server通过这些对象维护集群的状态。

### 2.2.2 Kubernetes的基本操作和概念

使用Kubernetes需要理解其核心概念,如Pods、Services、Deployments、Namespaces等。每个Pod可以包含一个或多个容器,而Service为这些Pod提供一个固定的网络接口。Deployment帮助管理Pod和ReplicaSet,确保应用的正确副本数和自我修复。Namespaces用于隔离资源和用户的访问权限。

下面是创建一个简单的Deployment的基本YAML配置示例:

```yaml

apiVersion: apps/v1

kind: Deployment

metadata:

name: my-nginx-deployment

spec:

replicas: 3

selector:

matchLabels:

app: nginx

template:

metadata:

labels:

app: nginx

spec:

containers:

- name: nginx

image: nginx:latest

ports:

- containerPort: 80

```

此配置定义了一个名为`my-nginx-deployment`的Deployment,它创建3个副本,每个副本运行一个使用最新镜像的Nginx容器。

Kubernetes的基本操作还包括了如何管理这些对象,如扩展、更新和回滚等。

## 2.3 集成Celery与Kubernetes的必要性

在动态任务队列和容器编排的世界中,集成Celery与Kubernetes能够提供高可用性和可扩展性,满足现代应用的需求。

### 2.3.1 容器化对于动态任务队列的益处

容器化技术,特别是与Kubernetes集成后,可以为Celery带来以下优势:

- **动态扩展**: 根据任务负载动态地创建或销毁Celery Worker。

- **资源优化**: 灵活地为任务分配合适的资源,避免资源浪费。

- **故障转移**: 在Worker节点或容器出现问题时,自动调度到其他节点。

### 2.3.2 实现可扩展性和高可用性的需求

通过将Celery任务队列部署在Kubernetes之上,可以实现以下目标:

- **水平扩展**: 通过增加Pod数量来处理更多的任务。

- **高可用**: Kubernetes的自我修复机制确保应用永远在线。

- **负载均衡**: Kubernetes的调度器将任务均衡地分配给各个Worker。

这种集成保证了即使在高负载或部分故障的情况下,任务处理的连续性和效率。

[接下来将会是第三章的内容,详细介绍了如何将Celery Worker部署到Kubernetes集群。]

# 3. Celery与Kubernetes集成实践

## 3.1 部署Celery Worker到Kubernetes集群

部署Celery Worker到Kubernetes集群涉及将任务处理器容器化并利用Kubernetes的强大功能来管理这些任务。下面将详细介绍如何创建Docker镜像以及配置和部署Kubernetes Pod和Service。

### 3.1.1 创建Docker镜像

为了在Kubernetes集群中运行Celery Worker,我们首先需要创建一个包含所有Celery依赖项的Docker镜像。以下是一个基本的Dockerfile,用于构建Celery Worker镜像:

```Dockerfile

FROM python:3.8-slim

# 安装依赖包

RUN pip install --upgrade pip

ADD ./requirements.txt /tmp/requirements.txt

RUN pip install --no-cache-dir -r /tmp/requirements.txt

# 添加源代码到镜像中

ADD . /app

# 工

```

0

0