Celery任务调度与定时执行:时间管理的自动化秘籍

发布时间: 2024-10-04 10:12:53 阅读量: 29 订阅数: 32

# 1. Celery任务调度基础

## 简介

Celery是一个强大的异步任务队列/作业队列,基于分布式消息传递。它主要用于处理实时操作和任务调度,被广泛应用于Web应用、系统任务队列和定时任务等领域。了解Celery基础是实现高效任务处理和优化的关键。

## 核心组件

Celery主要包含以下几个核心组件:

- **Broker(消息代理)**:负责接收、存储和传递消息。常见的broker有RabbitMQ和Redis。

- **Worker(工作进程)**:接收任务并执行。可以启动多个worker来处理任务。

- **Task(任务)**:需要被执行的函数或者作业,是Celery应用的最小单位。

## 基本使用

使用Celery进行任务调度涉及以下步骤:

1. **安装Celery**:

```bash

pip install celery

```

2. **定义任务**:创建一个Python文件作为Celery应用,并定义任务函数。

```python

from celery import Celery

app = Celery('tasks', broker='pyamqp://guest@localhost//')

@app.task

def add(x, y):

return x + y

```

3. **启动Worker**:

```bash

celery -A tasks worker --loglevel=info

```

4. **调用任务**:

```python

from tasks import add

result = add.delay(4, 4)

print(result.get(timeout=1)) # 输出: 8

```

以上步骤展示了如何安装Celery、定义任务、启动worker以及如何调用任务。了解这些基础概念对于深入学习Celery是非常重要的。接下来,我们将深入探讨定时任务的理论与实践,以及如何在实际应用中部署和优化Celery。

# 2. Celery定时任务的理论与实践

## 2.1 Celery定时任务的工作机制

### 2.1.1 时间表达式与cron的使用

Celery定时任务依赖于时间表达式,这允许开发者以可读的方式定义任务何时执行。Celery使用cron格式的时间表达式,它是一个更为复杂的时间描述符,允许用户按照分钟、小时、日、月、周几来安排任务。

举例来说,`0 9 *** Mon` 表示每周一早上9点执行任务。这样的表达式可以单独使用,也可以结合特定的时间周期性执行。

```python

from celery.schedules import crontab

app.conf.beat_schedule = {

'send-report': {

'task': 'send_report',

'schedule': crontab(minute=0, hour=9), # 每天早上9点执行

},

}

```

在这个示例中,`crontab` 对象用于设定一个每天早上9点执行的任务。任务由`send_report`函数处理,这是通过Celery Beat(定时任务调度器)安排的。

### 2.1.2 任务的调度与执行流程

Celery定时任务的调度和执行流程涉及几个关键组件:任务、消息代理(Broker)、工作节点(Worker)以及定时任务调度器(Beat)。整个过程如下:

1. 开发者将任务定义在Celery应用中,并设置定时执行的规则。

2. Celery Beat根据设定的规则周期性地将任务发送到消息代理。

3. 工作节点监听消息代理,当检测到有任务时,它会获取任务并执行。

4. 执行结果会被返回到消息代理,并最终由应用存储或进一步处理。

整个流程的关键是任务的可靠性与可预测性。如果某个工作节点失败,任务会在其他节点上重新调度。

## 2.2 Celery定时任务的高级特性

### 2.2.1 优先级与队列

在复杂的系统中,任务可能有不同的优先级。Celery允许通过设置不同的队列来处理这些优先级。任务可以被分配到特定的队列中,高优先级的任务会被优先执行。

```python

from celery import Celery

app = Celery('tasks', broker='pyamqp://guest@localhost//')

@app.task(queue='high_priority')

def send_email():

pass

@app.task(queue='low_priority')

def process_data():

pass

```

在这个例子中,`send_email` 将被分配到高优先级队列,而 `process_data` 则被分配到低优先级队列。

### 2.2.2 错误处理与重试策略

错误处理是任何任务调度系统中至关重要的一环。Celery提供了强大的错误处理机制和重试策略,可以帮助开发者应对任务执行中的各种问题。

```python

from celery import Celery

app = Celery('tasks', broker='pyamqp://guest@localhost//')

@app.task(bind=True)

def add(self, x, y):

try:

return x + y

except Exception as exc:

self.request.retries += 1

if self.request.retries <= 5:

return self.retry(exc=exc) # 重试任务

raise

```

在这个例子中,如果`add`任务执行时发生异常,它会根据重试策略重试直到达到最大重试次数。

## 2.3 Celery定时任务的实际案例分析

### 2.3.1 日常任务调度场景

Celery在日常任务调度场景中的应用广泛,例如定时生成报表、发送邮件通知、数据备份等。

举个例子,一个电商网站可能需要每天凌晨执行数据备份任务:

```python

from celery import Celery

from datetime import timedelta

app = Celery('tasks', broker='pyamqp://guest@localhost//')

@app.task

def backup_data():

# 执行数据备份逻辑

pass

app.conf.beat_schedule = {

'backup-data': {

'task': 'backup_data',

'schedule': timedelta(days=1), # 每天执行一次

},

}

```

### 2.3.2 异常情况下的任务调度

在发生异常时,任务调度需要能够处理好异常情况。例如,一个定时任务在执行过程中失败了,需要有机制保证它能在合适的时候重试,而不是无限制地重试或者直接放弃。

```python

from celery import Celery

app = Celery('tasks', broker='pyamqp://guest@localhost//')

@app.task(bind=True, max_retries=3)

def process_file(self, file_path):

try:

# 处理文件逻辑

pass

except Exception as exc:

raise self.retry(exc=exc) # 如果出现异常,则重试

```

在这个例子中,`process_file`任务最多尝试3次处理指定的文件。重试策略在`max_retries`参数中设置,并在任务执行过程中通过`self.retry`进行控制。

# 3. Celery与时间管理的自动化实践

在信息技术领域,任务调度是一个至关重要的功能,尤其在处理周期性或定时任务时。Celery,作为一个强大的异步任务队列/作业队列,被广泛应用于各种时间管理自动化实践中。接下来,我们将深入探讨Celery在自动化任务规划、性能优化以及不同环境中的部署策略。

## 3.1 自动化任务的规划与设计

自动化任务是现代IT运维中的关键组成部分,它可以显著提高效率,减少人力成本,同时确保任务执行的准确性和一致性。自动化任务的规划与设计是整个流程的起点,它涉及到识别可自动化任务以及设计执行逻辑。

### 3.1.1 识别和定义可自动化任务

在任何组织中,总有一些重复性的任务,这些任务往往适合于自动化。例如,数据备份、报表生成、定时更新缓存等。识别这些任务的关键是理解业务流程,找出其中的规律性和重复性。

#### 任务识别的策略

1. **流程分析**:审视业务流程,记录每个环节可能存在的周期性任务。

2. **资源消耗**:评估任务的资源消耗,优先自动化资源消耗高的任务。

3. **手动操作**:监控日常操作,将频繁手动执行的任务自动化。

4. **风险评估**:确定哪些任务自动化后可以减少出错概率。

#### 定义任务的步骤

- **任务文档化**:详细描述任务的流程和依赖关系。

- **优先级设置**:根据任务的重要性和紧急性给任务排序。

- **资源评估**:估算每个任务所需的资源和可能产生的成本。

### 3.1.2 设计任务的执行逻辑与流程

定义好自动化任务后,接下来便是设计执行逻辑。执行逻辑通常涉及任务的触发条件、执行过程中的依赖关系以及可能的异常处理。

#### 执行逻辑设计要点

- **触发机制**:设计任务的启动条件,如定时触发、事件触发或API调用。

- **依赖关系**:明确任务之间的依赖,合理安排任务执行顺序。

- **异常处理**:制定任务失败时的回滚策略和警告通知。

## 3.2 Celery的并发与性能优化

在自动化任务设计完成后,我们需要考虑如何高效地执行这些任务。Celery的并发和性能优化是确保任务能够快速、高效执行的关键。

### 3.2.1 工作进程与线程的管理

Celery通过工作进程和线程来处理任务,合理地管理这些资源,是优化性能的前提。

#### 工作进程管理

- **工作进程数量**:根据任务的类型和数量调整工作进程数。

- **工作进程类型**:根据任务特性选择prefork或eventlet工作模式。

- **内存管理**:监控进程内存使用,避免内存泄漏影响性能。

#### 线程管理

- **线程池大小**:合理配置线程池大小,防止线程数量过多导致的上下文切换开销。

- **线程优先级**:设置线程优先级,确保高优先级任务获得更快处理。

### 3.2.2 性能监控与调优技巧

性能监控是调优的基础,通过监控工具我们可以了解到任务执行的状态和瓶颈所在。

#### 性能监控指标

- **任务吞吐量**:每秒可处理任务的数量。

- **平均响应时间**:任务从提交到完成所需的平均时间。

- **排队延迟**:任务在队列中等待的时间。

#### 调优技巧

- **负载均衡**:使用策略如round-robin均衡任务到不同工作进程。

- **批处理**:适当合并小任务,减少任务调度的开销。

- **缓存使用**:利用内存缓存减少数据I/O,加速任务处理。

### 3.2.3 并发测试与分析

为了验证性能调优的有效性,进行并发测试是不可或缺的环节。通过模拟高并发场景,我们可以评估系统性能并作出相应的调整。

#### 并发测试方法

- **压力测试**:逐渐增加任务负载,观察系统的崩溃点。

- **基准测试**:在标准条件下运行任务,收集性能基线数据。

- **对比分析**:对比调整前后的性能指标,分析优化效果。

## 3.3 Celery在不同环境中的部署

Celery可以部署在多种环境中,从单服务器到分布式集群,甚至云环境中。不同环境下的部署策略会影响到任务调度的可扩展性和弹性。

### 3.3.1 单服务器部署

单服务器部署是最简单的场景,适合轻量级的任务调度需求。

#### 部署步骤

1. **安装Celery**:使用pip安装Celery及其依赖。

2. **配置Celery**:编辑配置文件,设置消息代理等参数。

3. **启动工作进程**:使用celery命令启动Celery工作进程。

### 3.3.2 分布式部署与云环境集成

分布式部署可以提供更好的可扩展性和容错能力,云环境集成则为Celery提供了更大的灵活性。

#### 分布式部署要点

- **集群配置**:设置多个Celery工作节点形成集群。

- **负载均衡**:配置负载均衡器,如Nginx或HAProxy,均匀分配工作负载。

- **高可用性**:使用如Keepalived等工具确保服务的高可用性。

#### 云环境集成

- **弹性伸缩**:利用云平台的自动伸缩功能,按需增加或减少工作节点。

- **服务发现**:集成服务发现机制,如Consul或etcd,管理分布式工作节点。

- **监控与日志**:与云平台提供的监控和日志服务对接,集中管理任务状态。

以上内容已经覆盖了Celery在自动化实践中的任务规划、并发优化和部署策略。通过这些实践,IT从业者可以有效地将Celery集成到他们的工作流程中,从而实现时间管理任务的自动化和高效执行。

# 4. Celery与其他工具的集成与扩展

Celery作为一款强大的异步任务队列系统,在实际应用中往往需要与其他工具进行集成与扩展,以便形成更为复杂而强大的工作流程。本章将深入探讨Celery与其他消息队列的集成策略、与其他系统的集成方案,以及如何进行自定义扩展和使用钩子与事件。

## 4.1 Celery与消息队列的集成

Celery本身就是一个基于分布式消息传递的异步任务队列。它支持多种消息代理作为后端,最常见的是RabbitMQ和Redis。在实际应用中,选择合适的后端消息代理对系统的稳定性和性能有着重要影响。

### 4.1.1 RabbitMQ与Redis作为后端的对比

RabbitMQ和Redis作为Celery的后端消息代理,各有其独特之处和适用场景。RabbitMQ基于AMQP协议,有着较高的可靠性和稳定性,特别适合需要高并发和消息持久化处理的场景。Redis则通常作为内存数据库使用,它对Celery而言,提供了极低的延迟和高速的性能,但不具备RabbitMQ的消息持久化能力,适用于对性能要求极高但对消息丢失容忍度较高的场景。

### 4.1.2 集成消息队列的策略与实践

集成消息队列时,需要考虑以下策略:

- **选择合适的后端**:根据任务处理的特点和业务需求,选择最合适的后端代理。

- **配置和优化**:根据业务负载和硬件资源对Celery进行参数配置和性能优化。

- **容错与扩展**:保证系统的容错能力,并考虑横向扩展的可能性。

- **监控与维护**:集成监控工具,及时发现和解决问题。

代码块示例:

```python

from celery import Celery

# 配置Celery使用RabbitMQ作为消息代理

app = Celery('tasks', broker='amqp://localhost//')

@app.task

def add(x, y):

return x + y

```

上述代码展示了如何通过Celery配置文件或代码设置使用RabbitMQ作为消息代理。这里的`broker='amqp://localhost//'`指定了RabbitMQ的连接字符串。

## 4.2 Celery与其他系统的集成

Celery的使用不仅限于独立应用,它还可以与其他系统进行集成,提供更为灵活和强大的解决方案。

### 4.2.1 Web应用中的集成方案

在Web应用中集成Celery,通常通过在Flask或Django等Web框架中嵌入Celery实例,并利用Celery提供的装饰器或异步任务执行接口,实现后端任务的异步处理。

代码块示例:

```python

from flask import Flask

from celery import Celery

app = Flask(__name__)

celery = Celery(app.name, broker='amqp://localhost//')

@celery.task

def index():

return "Hello, Celery!"

```

在上述示例中,通过Flask实例化一个Celery应用,`@celery.task`装饰器将指定的函数转换为Celery任务。

### 4.2.2 外部服务与API的集成

除了Web应用,Celery还可以与外部服务及API集成,例如集成第三方支付服务、社交媒体API等,通过Celery异步处理与这些服务的交互。

### 集成扩展操作步骤:

1. **定义任务接口**:创建Celery任务,封装外部服务API的调用逻辑。

2. **配置参数与队列**:设置任务的参数,如超时时间、优先级、路由等。

3. **调度与监控**:根据需求调度任务,并对任务执行进行监控和日志记录。

4. **错误处理**:制定错误处理机制,包括重试策略、异常捕获等。

## 4.3 Celery的扩展与自定义

在某些情况下,Celery的标准功能可能无法完全满足特定业务的需求。这时候,通过扩展和自定义Celery的相关组件就显得尤为重要。

### 4.3.1 自定义任务执行器

自定义任务执行器允许用户在任务执行过程中加入自定义逻辑,比如执行前的校验、执行后的清理工作等。

代码块示例:

```python

from celery import Task

class CustomTask(Task):

def __call__(self, *args, **kwargs):

# 自定义前的逻辑

result = super(CustomTask, self).__call__(*args, **kwargs)

# 自定义后的逻辑

return result

@app.task(base=CustomTask)

def my_task():

pass

```

在上述代码中,`CustomTask`继承自Celery的`Task`类,并在`__call__`方法中添加了自定义的逻辑。通过指定任务的`base`参数为`CustomTask`,使得`my_task`成为了一个带有自定义逻辑的任务。

### 4.3.2 钩子与事件的扩展使用

Celery提供了丰富的钩子(hooks)和事件(events)系统,允许用户在任务的生命周期中插入自定义行为,例如任务开始、成功、失败时进行特定的操作。

表格展示:

| 事件名称 | 描述 | 使用场景 |

|-------------------|-------------------------------------|----------------------------------|

| task_prerun | 任务执行前 | 安全验证、权限校验等 |

| task_success | 任务成功执行完成 | 清理临时数据、发送成功通知等 |

| task_failure | 任务执行失败 | 记录错误日志、发送失败通知等 |

| task_revoked | 任务被撤销 | 清除相关资源、防止任务重试等 |

通过上述扩展使用,可以实现更为复杂的任务管理逻辑,提高系统的灵活性和可维护性。同时,这也有利于系统监控和故障排查,因为这些事件可以触发监控系统中的特定动作。

## 小结

Celery的强大不仅在于它本身提供的异步任务处理能力,还包括其与各种消息队列、外部系统和服务API的集成能力,以及支持丰富的自定义扩展。掌握这些集成与扩展技巧,可以极大地提高开发效率和系统的可靠性。在接下来的章节中,我们将深入探讨Celery的监控与日志管理,以确保系统运行的透明度和稳定性。

# 5. Celery的监控与日志管理

在现代软件开发中,监控与日志管理是确保系统稳定性与性能的关键部分。对于使用Celery这样的任务队列系统,这一点尤为重要。由于Celery的异步性质,以及可能在分布式环境中运行,监控和日志管理变得更加复杂,但同时又是必不可少的。本章我们将深入探讨Celery的监控与日志管理策略,以及如何通过实时监控和数据可视化来管理Celery。

## 5.1 日志管理的重要性与策略

日志在软件开发和维护过程中扮演着至关重要的角色。它们提供了系统运行情况的实时记录,有助于开发人员和系统管理员监控应用状态、调试问题、记录用户行为以及追踪安全事件。

### 5.1.1 日志级别与格式设置

Celery允许配置不同级别的日志输出,常用的级别包括DEBUG、INFO、WARNING、ERROR和CRITICAL。正确设置日志级别对于调试和监控至关重要。例如,生产环境中通常设置为WARNING级别以上,以减少日志文件的大小和提高性能,而开发环境可能会设置为DEBUG以收集更多的调试信息。

此外,日志格式也很重要。Celery的日志格式可以通过配置文件来设置,支持包括时间戳、日志级别、消息内容等多种信息的格式化输出。一个常见的配置示例如下:

```python

from celery import app

app.conf.update(

log_level='INFO',

log_format='%(asctime)s - %(levelname)s - %(message)s',

)

```

在上述代码中,我们设置了Celery的日志级别为INFO,并定义了日志的格式,其中包含时间戳、日志级别和消息内容。这样配置可以帮助我们快速定位问题并获得重要信息。

### 5.1.2 日志的收集与分析

收集和分析日志是管理Celery任务的关键组成部分。有效的日志策略不仅可以帮助我们快速定位问题,还可以优化任务执行流程。使用工具如ELK(Elasticsearch, Logstash, Kibana)堆栈可以帮助我们收集、存储和分析Celery产生的日志。

- **Elasticsearch**:是一个搜索引擎,用于存储、搜索和分析大量日志数据。

- **Logstash**:用于收集、处理和转发日志到不同的目的地,比如Elasticsearch。

- **Kibana**:是一个数据可视化工具,可以让我们在Web界面上探索、分析和展示日志数据。

例如,可以使用Logstash来监听Celery日志文件,并将日志数据发送到Elasticsearch中:

```conf

input {

file {

path => "/path/to/celery/log/*"

start_position => "beginning"

}

}

filter {

# 日志解析器和过滤器配置

}

output {

elasticsearch {

hosts => ["elasticsearch_host:port"]

}

}

```

通过这样的配置,Celery产生的日志会被Logstash处理并存放到Elasticsearch中,而Kibana可以用来创建仪表盘和进行日志分析。

## 5.2 Celery的监控工具与方法

监控是确保Celery任务队列持续稳定运行的关键。没有适当的监控,问题可能在用户注意到之前长时间存在,导致服务不可用或性能下降。

### 5.2.1 实时监控与报警

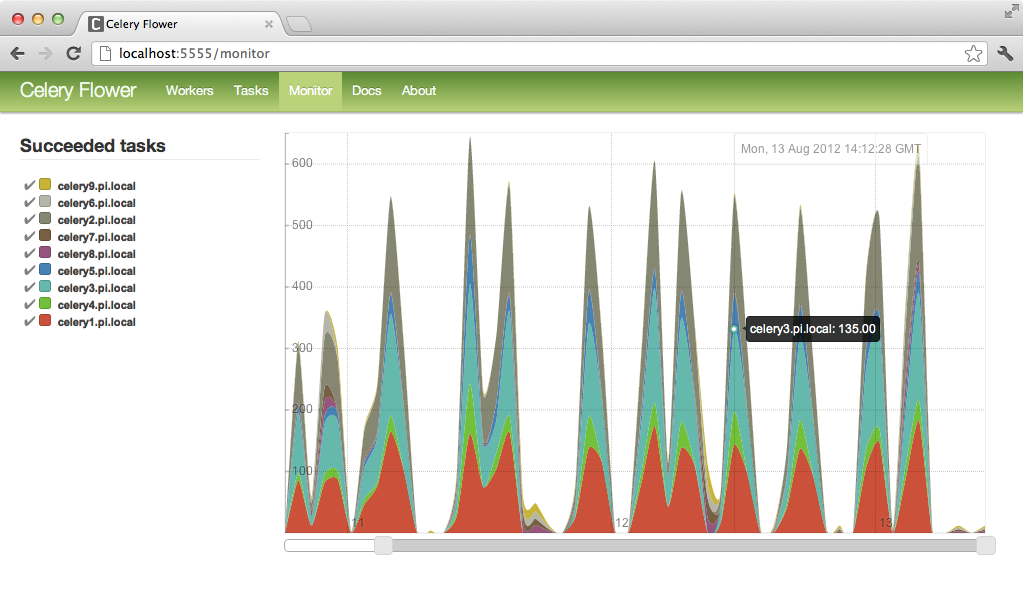

实时监控是指持续追踪Celery任务的状态、性能指标等,以便快速响应潜在的问题。Celery提供了一些内建的监控工具,比如flower,它是一个Web监控工具,可用于实时跟踪任务执行情况。

使用flower,我们可以监控任务的执行情况、查看任务的统计数据、重新调度失败的任务等。例如,通过启动flower的命令行接口:

```shell

flower --broker=amqp://guest:guest@localhost:5672//

```

上述命令启动flower监控服务,通过访问`***`即可在浏览器中查看监控界面。

### 5.2.2 性能监控与瓶颈定位

性能监控是指对Celery系统中的性能瓶颈进行跟踪和分析。Celery提供了一些性能指标,如任务执行速度、任务排队时间等。监控这些指标可以协助我们找出性能瓶颈,并采取相应的优化措施。

例如,可以使用Prometheus和Grafana来监控Celery的性能指标。首先,需要在Celery应用中集成Prometheus客户端库:

```python

from prometheus_client import Counter

task_total = Counter('celery_task_total', 'Total number of Celery tasks')

@app.task

def add(x, y):

task_total.inc()

return x + y

```

上述代码段展示了如何使用Prometheus的Counter来跟踪Celery任务的总数。接下来,Prometheus可以通过HTTP端点定期从Celery应用中抓取这些指标数据,并将其存储。然后Grafana可以用来创建仪表盘并展示这些数据:

```yaml

grafana:

dashboardProviders:

dashboardproviders.yml:

providers:

- name: 'default'

orgId: 1

folder: ''

type: file

disableDeletion: false

updateIntervalSeconds: 30

options:

path: /var/lib/grafana/dashboards

```

这个Grafana配置文件定义了如何加载和更新仪表盘。通过监控图表,我们能够快速识别出任务执行的高峰时段、任务延迟情况等重要信息。

## 5.3 基于数据可视化管理Celery

数据可视化是将复杂的数据集通过图表、图形等方式直观展示出来。在Celery的管理和监控中,数据可视化工具可以提供直观的性能和状态视图,便于团队成员理解并作出决策。

### 5.3.1 可视化监控仪表盘的创建

通过创建可视化的监控仪表盘,团队可以一目了然地看到Celery系统的当前状态和历史趋势。这包括任务的总体状态、执行速度、失败率、任务排队情况等。

为了创建这样的仪表盘,可以使用上面提到的Grafana。在Grafana中,可以定义多个图表和仪表板,每个图表可以用来展示不同指标的数据。例如,以下是一个Grafana仪表盘的示例:

```yaml

apiVersion: 1

providers:

- name: 'default'

orgId: 1

folder: ''

type: file

disableDeletion: false

updateIntervalSeconds: 30

options:

path: /var/lib/grafana/dashboards

```

在这个配置中,我们可以创建一个仪表盘来监控Celery中的任务状态。可以添加一个图表来显示任务执行的数量,以及另一个图表来显示任务失败的比例。通过图表,团队成员可以快速看到系统健康状态和潜在问题。

### 5.3.2 数据驱动的任务优化

数据可视化不仅仅是为了展示信息,更重要的是基于数据做出优化决策。通过分析仪表盘收集的数据,我们能够发现系统运行中的问题和瓶颈。

例如,如果一个任务在特定时间段内总是执行缓慢,这可能是由于资源竞争或内部处理问题。这时,可以调整任务的优先级、增加工作节点或优化任务的代码逻辑。

利用可视化工具,我们还可以进行趋势分析和预测。通过比较不同时间段的数据,可以预测系统的未来表现,并根据预测结果进行容量规划和资源分配。

举个例子,如果数据表明任务数量在每天的特定时间段内显著增加,我们可能需要在这些时段之前预热更多的工作节点,以避免性能下降。通过这种方式,我们能够基于数据驱动的方法,不断优化和改进Celery任务的执行情况。

以上所述,为第五章内容的详细部分,深入探讨了Celery的监控与日志管理,包括日志管理的重要性与策略、监控工具与方法,以及基于数据可视化进行任务的管理和优化。通过这些策略,能够确保Celery任务的稳定运行,并最大化其效能。

# 6. Celery的高级使用技巧与最佳实践

Celery是一个强大的异步任务队列/作业队列系统,被广泛应用于生产环境中,以处理大规模的异步任务。然而,随着应用场景的复杂化,如何更高效地使用Celery以及如何保障其安全性和稳定性成为开发者所关注的焦点。本章节将深入探讨一些高级使用技巧和最佳实践,以帮助读者更深入地理解和应用Celery。

## 6.1 任务依赖与动态调度

### 6.1.1 任务之间的依赖关系

在许多复杂的业务场景中,任务之间往往存在依赖关系,比如需要先完成用户验证后才能发送电子邮件。Celery允许开发者定义任务依赖,以确保任务执行的顺序。

使用`@task`装饰器的`apply_async`方法时,可以指定`Link`或`chord`来设置任务依赖:

```python

from celery import chain

def add(x, y):

return x + y

def multiply(x, y):

return x * y

# 定义任务依赖链

chain_task = chain(add.s(2, 2), multiply.s(4))()

# 执行链任务,确保add任务完成后才执行multiply任务

result = chain_task.apply_async()

```

在上面的例子中,`add`任务完成后,`multiply`任务会自动开始执行。

### 6.1.2 根据条件动态调度任务

有时候任务的调度需要根据运行时的条件动态决定。Celery允许在任务执行过程中进行动态决策,根据实际情况调度不同任务。

例如,可以根据任务执行的结果,决定是否需要执行额外的任务:

```python

from celery import task

@task

def process_data(data):

# 假设处理数据

processed = do_processing(data)

if need_another_task(processed):

another_task.delay(processed) # 如果需要,动态添加新任务

```

通过上述方法,可以根据运行时数据动态调整任务执行流程,提高应用的灵活性。

## 6.2 安全性考虑与防护措施

### 6.2.1 网络通信的安全性

Celery通过消息代理与工作节点之间进行通信,因此网络通信的安全性至关重要。要确保网络通信的安全,可以采取如下措施:

- 使用加密连接(如SSL/TLS)来保护消息代理和Celery节点之间的通信。

- 配置消息代理的访问控制列表(ACL),限制只能由授权的Celery实例访问。

- 在Celery配置中使用安全设置,如设置`task_serializer`、`result_serializer`、`accept_content`等参数。

### 6.2.2 任务数据的保护

除了保证通信安全,还需要考虑任务数据在传输和存储过程中的安全。

- 对敏感数据进行加密,确保任务数据的安全。

- 在存储结果数据时,使用安全的序列化格式,并控制对结果数据的访问。

- 对于存储在外部系统中的任务结果,采用合适的认证和授权措施,比如使用访问令牌。

## 6.3 Celery使用经验与社区最佳实践

### 6.3.1 常见问题与解决方案

在实际使用Celery过程中可能会遇到各种问题,如任务长时间不执行、任务执行结果丢失等。社区中通常有丰富的解决方案和经验分享。

- 当遇到任务长时间不执行的问题时,可以检查工作节点是否存活,以及任务是否被正确调度到工作节点。

- 对于任务执行结果丢失的问题,可能是因为结果后端配置不当或超时设置不合理。此时,可以适当调整`result_backend`配置或增加超时时间。

### 6.3.2 社区案例与资源分享

社区中有许多使用Celery的成功案例和资源分享,这些资源对于理解和学习Celery非常有帮助。

- 访问Celery的官方文档,可以找到各种使用场景的配置方法和最佳实践。

- 在GitHub上搜索Celery相关的项目,可以查看其他开发者的实现方式,从而获得灵感。

- 加入Celery社区,参与讨论,分享经验和解决方案,以加深对Celery的理解和应用。

在本章中,我们探索了Celery的高级技巧,包括任务依赖、动态调度、安全防护,以及社区最佳实践。这些技巧和实践对于深入使用Celery并优化其在生产环境中的应用至关重要。随着任务调度的复杂性增加,这些知识点将帮助开发者更加高效和安全地管理他们的Celery任务。

0

0